Hugging Face 模型下载

1. 国内镜像

网址:HF-Mirror

2. 安装步骤

huggingface-cli 是 Hugging Face 官方提供的命令行工具,自带完善的下载功能。

-

安装依赖

pip install -U huggingface_hub -

设置环境变量

# linux export HF_ENDPOINT=https://hf-mirror.com# Windows Powershell $env:HF_ENDPOINT = "https://hf-mirror.com" -

下载模型

huggingface-cli download --resume-download gpt2 --local-dir gpt2 -

Q&A

Q: 有些项目需要登录,如何下载?

A:部分 Gated Repo 需登录申请许可。为保障账号安全,本站不支持登录,需先前往 Hugging Face 官网登录、申请许可,在官网这里获取 Access Token 后回镜像站用命令行下载。

部分工具下载 Gated Repo 的方法:huggingface-cli: 添加

--token参数huggingface-cli download --token hf_*** --resume-download meta-llama/Llama-2-7b-hf --local-dir Llama-2-7b-hf

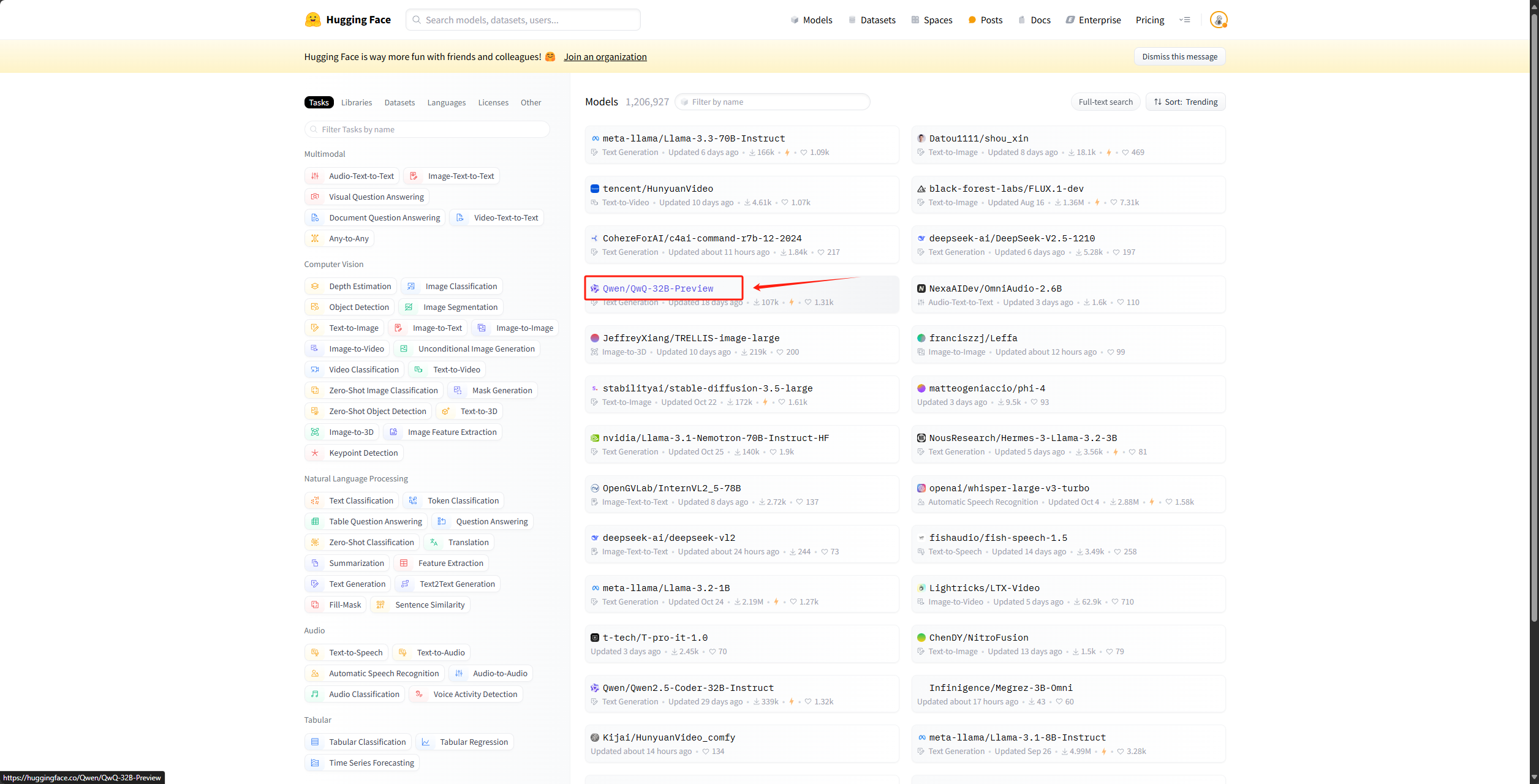

Q:下载时的模型名称是如何确定的

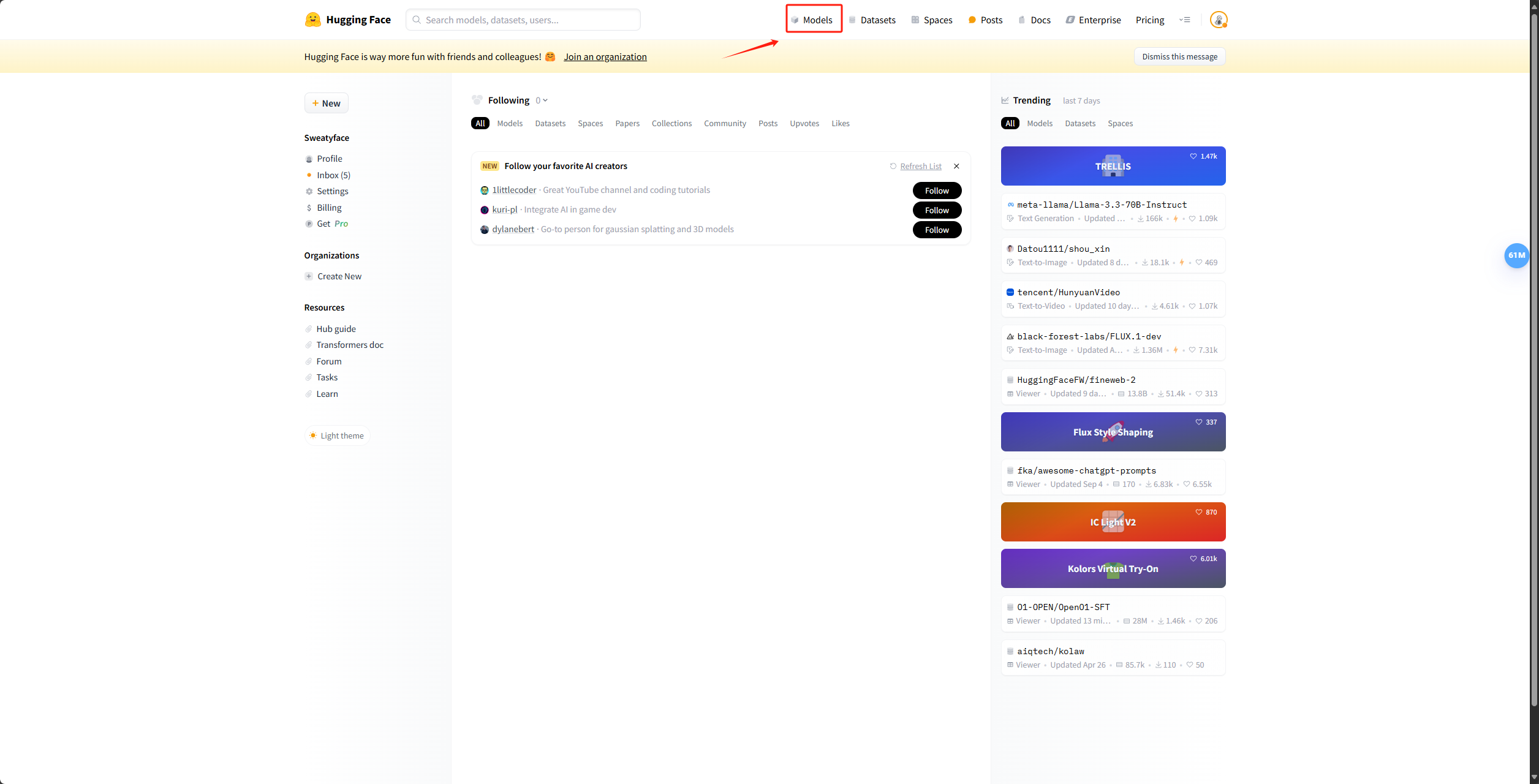

A:先进入Hugging Face官网,点击上面侧边栏的Models

例如要下载QwQ-32B-Preview模型,那下载时需要填的名字就是Qwen/QwQ-32B-Preview

3. 安装脚本

上述过程可以使用如下脚本

#!/bin/bash

# 检查是否传入必要的参数

if [ $# -lt 2 ]; then

echo "用法: $0 <模型名称> <本地保存目录> [<HuggingFace Token>]"

exit 1

fi

# 获取传入的参数

MODEL_NAME=$1

LOCAL_DIR=$2

HF_TOKEN=$3

# 设置镜像站点地址(包含在脚本中)

export HF_ENDPOINT="https://hf-mirror.com"

# 确保目标目录存在

mkdir -p $LOCAL_DIR

# 下载函数

download_with_huggingface_cli() {

echo "使用 huggingface-cli 下载模型 $MODEL_NAME 到目录 $LOCAL_DIR"

if [ -n "$HF_TOKEN" ]; then

# 如果传入了 Hugging Face Token,使用 --token 参数

huggingface-cli download --resume-download --token "$HF_TOKEN" $MODEL_NAME --local-dir $LOCAL_DIR

else

# 不使用 Token 的情况

huggingface-cli download --resume-download $MODEL_NAME --local-dir $LOCAL_DIR

fi

}

# 开始下载

download_with_huggingface_cli

使用方式

# 创建一个脚本

vim download_models.sh

# 将上述脚本复制进去

# 执行

# sh download_model.sh <模型名称> <本地保存目录> [<HuggingFace Token>]

sh download_model.sh Qwen/QwQ-32B-Preview ./QwQ-32B-Preview hf_*************

ModelScope 模型下载

1. 文档

2. 命令行下载

请先通过如下命令安装ModelScope

pip install modelscope

下载完整模型repo

modelscope download --model LLM-Research/Meta-Llama-3-8B-Instruct --local_dir ./Meta-Llama-3-8B-Instruct

下载单个文件到指定本地文件夹(以下载README.md到当前路径下“dir”目录为例)

modelscope download --model LLM-Research/Meta-Llama-3-8B-Instruct README.md --local_dir ./dir

9300

9300

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?