提示:文章写完后,目录可以自动生成,如何生成可参考右边的帮助文档

提出的方法

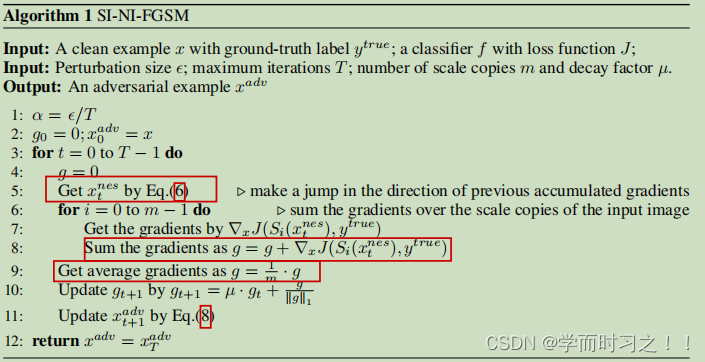

提出了两种新的方法来提高对抗实例的可移植性,即Nesterov Iterative Fast Gradient Sign Method (NI-FGSM)和尺度不变攻击法(SIM)。

NI-FGSM:利用Nesterov来跳出局部最优解,获得更好的优化。

SIM(在同一模型上的原始图像和缩放图像的损失值是相似的):通过优化输入图像尺度副本上的对抗性扰动来提高对抗性实例的可移植性。SIM可以避免白盒模型的“过拟合”,产生更多可转移的对抗性。

一、解决的问题

黑盒环境下,大多数现有的对抗攻击其他防御模型的可转移性较差。

本文将对抗样本生成视为一个优化过程,那么优化对抗样本可以视为一个训练过程,黑盒可以视为一个测试过程。

二、思路

- 提高深度学习的模型泛化性:更好的优化算法,如Adam。数据增广

- 提高对抗样本的迁移性:更好的优化算法,如MI-FGSM。模型增广

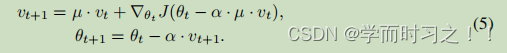

Nesterov Accelerated Gradient (NAG)是一种梯度下降法的变种,本质上是动量的改进:

整合进I-FGSM后:

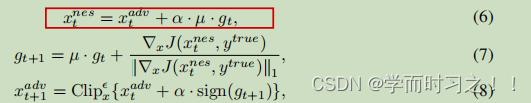

尺度不变攻击方法SIM

定义1:

保损失转换:输入x,x的标签ytrue,分类器发f(x),损失函数J(x,y).

如果存在输入转换函数T(.)满足J(T(X),yture)≈J(x,ytrue)

即,在同一模型上,原始图像和缩放图像的损失值是相似的(即经过一个变换之后,loss基本不变)

定义2:输入x,x的标签ytrue,分类器发f(x),损失函数J(x,y).

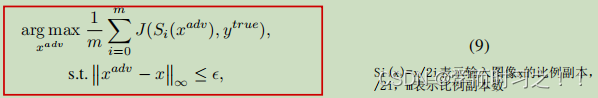

存在一个新模型f’(x),存在的关系f’(x)=f(T(x)).作者发现除了平移不变性,还存在缩放不变性,图像和缩放后的图像(像素值乘以一个系数),在同一个模型上的loss很接近。将这种特性视为一种模型增强的话,可以得到目标函数Si(x)=x/2i

三、算法

四、实验

略

五、结论

NI-FGSM的目标是将Nesterov加速梯度方法引入基于梯度的攻击,SIM的目标是利用模型的尺度不变特性实现模型增强。NI-FGSM和SIM可以自然地结合起来,构建一个强大的攻击,即SI-NI-FGSM。此外,通过将SI-NI-FGSM与基线攻击相结合,我们可以进一步提高对抗性样本的可转移性。大量实验表明,我们的方法不仅在对抗训练模型上获得了更高的成功率,而且还打破了其他强大的防御机制。

我们对NI-FGSM的研究表明,其他动量方法(如Adam)也可能有助于构建强攻击,这将是我们未来的工作,关键是如何将优化方法迁移到基于梯度的迭代攻击。我们的工作还表明,深度神经网络具有缩放不变性,我们将其用于设计SIM,以提高攻击的可转移性。然而,尚不清楚为什么尺度不变特性成立。可能是由于每个卷积层的批量标准化,这可能会减轻规模变化的影响。我们还将在今后的工作中更深入地探讨原因。

参考:

https://zhuanlan.zhihu.com/p/497026313

4307

4307

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?