【分享者】:华为无线CTO兼5G首席科学家童文博士。

本次报告聚焦在深度学习与无线通信两个大学科的交叉领域的问题及挑战。特别是在6G上可能成功的一些关键方向。

本次报告主要探讨AI+通信的十大问题:一个深度神经网络的计算问题,两个分布式集体学习的架构问题,三个基于神经机器学习的深度神经网络的语义通信问题,四个深度学习神经网络的共性问题。

【引子】AI的崛起

突破点是深度学习的神经网络,在1989年基本的神经网络算法就已经定型。加拿大是现代AI的发源地。当时只有3到5个神经元,2层网络,十几张图像作为训练。而现在算力提升了20万倍,学习的数据量提升了十万倍,神经网络每层的神经元已经接近1000万个,上亿级别的参数。未来十年的使命就是用,机器学习的思想去改造移动通信,改造互联网。

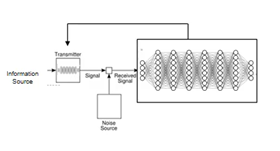

图1 AI 4 Net(左),Net 4 AI(右)

AI与无线通信的关系定义

AI 4 Net(改良)应用于5G、5.5G,这一类已经完成了定义。用AI的技术,AI的工具提升网络的性能。

Net 4 AI(原生)是6G主打的方向,暴力计算是AI发展的强心剂,新的创新将基于AI的算力。AI的成功和普及需要无穷无尽的大数据,是6G网络发力的地方,但是这是不可持续的。也就是这十个问题的动机,这里只聚焦于链路级的问题。

深度学习的计算危机

现在已经进入深度学习时代。AI计算已经远远超过摩尔定律的增长速度,因此下一个阶段的AI研究必须得考虑能耗,否则AI是不可持续的。

当错误概率降低到5%,计算代价是极其昂贵的,1000亿美金

解决方法:网络剪枝、压缩降维、降低量化精度、小型DNN。

- 网络剪枝

- 压缩降维

- 降低量化精度

- 小型DNN

建议:建立评估功耗的方法论、计算评估的方法,优化选择计算方法。

分布式集体学习的框架

在移动通信与AI的结合下,首要的问题是数据分离,模型分离。

数据用来计算,模型用来通信。传输的是模型而不是数据,模型更重要。

所以分布式集体学习的神经网络是如何切分的还没有解决,是深刻的理论问题。

2019年ICLA的frankal的论文:n个相同的网络进行关联学习,还是大网络切成n个小网络,还是网络的大小与网络的数量对神经网络学习的效率的优化问题。

基于无线的发布网络学习

通讯级的目标:网络的容量有很低的误码率

AI界的目标:识别的正确率、再生数据的质量。

深度学习的神经网络里,模型的系数误差在前几次迭代不重要,而模型的系数误差在后几次的迭代对识别的成功率非常重要,推理模型的系数误差也很重要,对推理的准确性和推理的精度影响很大。都是6G的研究点,深度学习的研究误差和无线传输的误差关系,需要研究清楚

后香农时代的通信数学模型的在商榷

信息传输到语义通信的问题。

通信模型的顶层架构的三个层次:数据信息(香农聚焦抽象的数学量比特)、逻辑语义(语义通信)、含义效果

通信的目标不仅仅是比特而是表达的意义。

什么是语义,什么是这个网络的极限。

极限:压缩的极限,传输速率的极限,如何确定这些。

深度学习对信息的压缩极限

科莫戈诺夫自同构不变问题:同构遍历问题及定理:两个平稳有限字符的过程是自同构的充分必要条件的他们具有同样的熵值。任何设计的极限都是相同的。用来鉴别是不是后香农理论的一个准则。

论文:Deep learning for joint source-channel coding of text

深度学习的近似语义结构(weaver问题)

英语语义的通信方法,从无序的随机的英文字母中构造出英语的句子。

Gan的理论开始解决香农70年留下的问题,语义通信中,对信息的复原是对比特的忠实的复原,还是在语义上的还原。也就是语义通信的语义的定义和架构问题。

通信用一个通用的深度学习神经网络进行训练、学习、通信,用一个巨大的DNN包打天下,来解决通信的问题;还是要进一步探讨通信的结构的层次,对这个结构有很好的通用性。

深度学习的梯度迭代算法问题

阿诺德-科莫哥诺夫近似函数及非SGD算法。

剔除梯度反向传播的算法(特别是端到端的)

- Sigmod会饱和导致梯度消失->ReLU

- ReLU的负半轴一般都是死区,导致梯度又为0->leaky ReLU、PReLUde

- 梯度和权值方面的稳定性EReLU和SEReLU

- 梯度太深,传不下去highway

- Highway的参数不要,用残差

- Batchnone

- 梯度中增加噪声dropout

- 门控

需要一步到位的算法,剔除梯度的问题。

深度学习神经网络容量

给定一个神经网络,究竟能记忆多少物体、事件。这是效率提升的基础

Hopfield网络

容量问题:香农的通信模型是没有记忆的,记忆的容量越大,效率越高。在通讯的接收方,推理计算的复杂度是指数增加还是线性增加,随着神经网络记忆容量的增加。

神经网络的记忆容量对解决6G原生AI通信来说是一个基本问题。

深度学习对大数据的依赖

神经网络的数据量需求:最小的数据量是多少?

动态的实时深度学习

现在假设世界是静态的

考虑:动态实时的通信问题(动态实时的神经网络训练问题)

348

348

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?