参考文章:PSRO2024最新综述

| 关键名词 | 解释 |

|---|---|

| Meta-Strategy Solver (MSS) | 元博弈求解器,从现有策略集合中提取meta-strategy(策略集合中每个策略对应一个权重)用于构造新策略的优化目标 |

| Response Objective(RO) | 基于MSS获得的meta-strategy构造新策略的优化目标 |

-

针对MSS角度进行改进的方法

1.1 在Normal-Form Empirical Game中使用纳什均衡及其变体作为MSS

以NE作为MSS目标在极限情况下会收敛到NE,但是该方法存在过拟合问题(1.由于empirical game中信息有限,对应的NE不一定有效 2.在一般和博弈中,NE往往不唯一,容易过拟合到其中的某个NE)

| 方法 | 简称 | 思路 |

|---|---|---|

| 《A Unified Game-Theoretic Approach to Multiagent Reinforcement Learning》 | PSRO | Projected Replicator Dynamics (PRD),为每个策略设置概率下界,确保不止NE支撑集中的策略可被选择,支撑集之外的策略也可以被选择 |

| 《Deep reinforcement learning for green security games with real-time information》 | 结合NE和一个均匀分布作为meta-strategy | |

| 《Iterated deep reinforcement learning in games: History-aware training for improved stability》 | 结合当前步的NE和历史的MSS作为meta-strategy | |

| 《Regularization for Strategy Exploration in Empirical Game-Theoretic Analysis》 | 基于Replicator Dynamics(RD)计算meta-strategy,并利用regret来判断终止条件 | |

| 《Online double oracle》 | Online Double Oracle | 基于no-regret算法来计算NE:在两人博弈中,当两方都采用no-regret算法时,最终可以收敛到NE策略,还可以确保最终NE的no-regret特性 |

1.2 在Normal-Form Empirical Game中使用纳什均衡以外的方法作为MSS

| 方法 | 简称 | 思路 |

|---|---|---|

| 《Open-ended learning in symmetric zero-sum games》 | Rectified PSRO | Rectified Nash,只保留当前策略能击败或打平的策略对应的纳什均衡权重,主要为了扩张gamescape。 |

| 《Anytime optimal psro for two-player zero-sum games》 | Anytime PSRO | 纳什均衡原本对应的payoff矩阵中,博弈双方的策略都受限制(payoff矩阵中只包含当前策略集合中的策略相互对抗得到的结果),为了确保Exploitability单调下降,提出了URR的概念,即只限制己方的策略,不限制对方的策略,基于这样的payoff矩阵计算纳什均衡。在求解对应的meta-strategy时,提出了minimum-regret constrained profiles(MRCP),该方法将己方方法设置为no-regret方法,将对方方法设置为best response。 |

| 《Self-play psro: Toward optimal populations in two-player zero-sum games》 | Self-play PSRO | Self-play PSRO在Anytime PSRO针对MRCP求BR的基础上,针对该所求BR,再求一个BR,即在迭代过程中,每次添加两个策略。 |

| 《Multi-agent training beyond zero-sum with correlated equilibrium meta-solvers》 | Joint PSRO | 在多人一般和博弈中,纳什均衡计算复杂度过高。针对该问题,提出了一种基于相关均衡(CE)和粗相关均衡(CCE)作为MSS的方法。由于在一般和博弈中存在多个(C)CE,所以该方法通过最大化基尼纯度来选择唯一的(C)CE |

| 《Team-PSRO for learning approximate TMECor in large team games via cooperative reinforcement learning》 | Team PSRO | 在两个队伍的零和博弈中,用TMECor均衡作为MSS |

| 《A game-theoretic framework for managing risk in multi-agent systems》 | RAE | 针对多智能体强化学习中的风险最小化场景,提出了一种Risk-Averse Equilibrium(RAE)方法作为MSS |

| 《Combining Tree-Search, Generative Models, and Nash Bargaining Concepts in GameTheoretic Reinforcement Learning》 | NBS | 针对砍价博弈场景,提出了一种Nash Bargaining Solution(NBS)方法作为MSS |

| 《Neural auto-curricula in two-player zero-sum games》 | NAC | 基于元学习的思想,提出一种自动学习MSS的方法 |

1.3 在其他类型Empirical Game中的MSS

| 方法 | 简称 | 思想 |

|---|---|---|

| 《XDO: A double oracle algorithm for extensive-form games》 | XDO | DO的变体,扩展形式元博弈树基于玩家的受限制的策略集合构造,通过CFR方法构造NE作为MSS |

| 《Regret-minimizing double oracle for extensive-form games》 | XDO的改进版,提升了MSS结束条件 |

2. 针对RO角度进行改进的方法

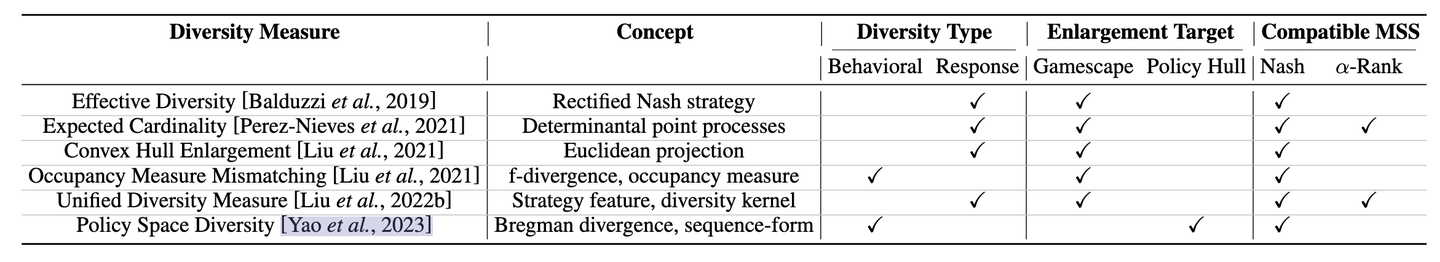

这类方法主要从提高策略集合的策略多样性方面进行优化目标函数,即在原目标函数的基础上增加多样性正则。多样化正则主要分为行为多样性(Behavior Diversity,BD)和回报多样性(Response Diversity, RD)两种,行为多样性是基于策略在同一个状态下表现的差异来定义的,主要衡量不同策略所作出行为的差异,回报多样性是基于不同策略对应的payoff向量(即当前策略与策略集合中其他策略对抗产生的结果)来定义的,主要衡量不同策略克制关系之间的差异。

添加图片注释,不超过 140 字(可选)

| 方法 | 简称 | 思想 |

|---|---|---|

| 《Modelling behavioural diversity for learning in open-ended games》 | Diverse PSRO(DPP) | 基于策略集合的payoff矩阵结合dpp方法构造expected cardinality并作为优化目标的正则,以增强策略集合的回报多样性。 |

| 《Towards unifying behavioral and response diversity for open-ended learning in zero-sum games》 | PSRO-BDRD | 在回报多样性的基础上,引入行为多样性。其中回报多样性基于新策略与策略集合中所有策略中与新策略距离最小的策略来构造的,行为多样性是基于新策略与策略集合的NE来构造的。 |

| 《A Unified Diversity Measure for Multiagent Reinforcement Learning》 | UDF-PSRO | 基于现有的回报多样性方法,总结出了一种统一的多样性度量策略 |

| 《Policy space diversity for non-transitive games》 | 现有的行为多样性方法主要以增大由策略集合的payoff向量所张成的gamescape为目标,而PSRO的整体目标是不断靠近NE,即不断减小Exploitability。但是增大gamescape并不一定能增大Exploitability。并提出了Population Exploitability(PE)的概念,类似与Exploitability,PE是与NE紧密相关的,且能更好的评估策略集合的能力。另外,还提出了policy hull(PH)的概念,并证明了增大PH可以确保一定能增大PE,进而能靠近NE。最后,基于行为多样性提出了一种可以增大PH的多样性正则。 |

3. 结合MSS-RO进行改进的方法

| 方法 | 简称 | 思想 |

|---|---|---|

| 《A Generalized Training Approach for Multiagent Learning》 | 考虑到α-Rank所具有计算复杂度和在多人一般和博弈中的唯一性的优势,使用α-Rank作为MSS,并提出了一种preference-based best-response oracle方法。 | |

| 《Generalized response objectives for strategy exploration in empirical game-theoretic analysis》 |

4. 提高训练效率的方法

4.1 并行方法

| 方法 | 简称 | 思想 |

|---|---|---|

| 《A Unified Game-Theoretic Approach to Multiagent Reinforcement Learning》 | DCH | 原PSRO在每个迭代过程中都是针对博弈每个参与者训练一个策略,效率较低。为提高训练效率,通过提前预设好整个策略集合中的策略数目(后面不在改变),后续再每个迭代过程中,并行训练策略集合中的所有策略。 |

| 《Pipeline PSRO: A scalable approach for finding approximate Nash equilibria in large games》 | Pipeline PSRO (P2SRO) | 提前预设好整个策略集合中的策略数目不灵活且训练代价大,针对该问题,通过引入固定策略(fixed policy)和动态策略(active policy),其中固定策略的数目是不断增加的,动态策略的数目是不变,在每次训练过程中只需要针对固定数目的动态策略进行并行训练即可。 |

4.2 采样效率

| 方法 | 简称 | 思想 |

|---|---|---|

| 《Efficient Policy Space Response Oracles》 | Efficient PSRO (EPSRO) | 采样主要来源于BR求解和经验矩阵(payofff matrix)的模拟,其中经验矩阵的模拟仅用于计算NE作为meta-strategy,该方法中的meta-strategy是类似与Anytime PSRO,通过引入URR来进行计算,故不需要计算NE,进而不需要进行经验矩阵的模拟 |

4.3 迁移学习

| 方法 | 简称 | 思想 |

|---|---|---|

| 《NeuPL: Neural population learning》 | NeuPL | 通过一个共享网络来代表策略集合中的所有策略,因此每次往策略集合中增加新策略时,都是在共享网络的基础上进行训练的,共享网络就起到了预训练的作用。 |

| 《Strategic knowledge transfer》 | Mix-Oracle | Mix-Oracle方法通过学习和维持对对手纯策略的BR(表示为Q值函数),然后根据元策略混合(Q值),构建新的最佳响应。 |

6991

6991

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?