VoxelMorph

Abstract(摘要)

传统的配准方法都是对每对图像独立的优化目标函数(optimize an objective function independently)。本文的配准方法是通过定义一个参数化的函数(parametric function),并在给定的数据集中优化该函数的参数(optimize parameters )。

一对新的待配准图像可以通过学习得到的参数直接计算函数来获取配准域(registration field)。

CNN结构用于学习参数化函数,空间变换层(spatial transform layer)用于将形变场运用到待配准图像上,并加入配准场的平滑约束( smoothness constraints on the registration field)。

1. Introduction(引言)

在非刚性配准中(deformable registration),在结构相似的一对n维图像体(n-D image volumes)之间建立密集(dense)、非线性(non-linear)对应关系。大多数配准方法利用的是最优化(optimization)的问题,非常耗时。

本文提出的是从体集合(a collection of volumes)参数化配准函数(parametrized registration function)。这个参数化函数使用卷积神经网络(CNN)来训练,输入是两个n维图像体(n-D input volumes),输出是从一个体到另一个体所以体素(voxel)的映射。这个网络的参数(parameters),也就是卷积核的权重(convolutional kernel weights),通过相关的数据集训练得到。通过该集合体(collection of volumes)相同参数的共享,可以对齐来自相同分布(same distribution)的任何新的体积对。本质上是使用一个全局的代价函数(global function)来替代每个测试图像对传统配准算法昂贵优化(costly optimization of traditional registration algorithms for each test image pair)。新的配准图像直接在学习函数(learned function)上进行配准。

特点:

- 基于无监督学习的解决方案(unsupervised learning-based solution)

- 跨群体参数共享的CNN函数来评估配准

- 代价函数的参数最优化方法

2. Background(背景)

传统的配准流程(typical volume registration formulation),就是一个moving or source卷(volume)通过扭曲对齐(warped to align)到第二个fixed or target卷。非刚性配准把用于全局对齐的初始仿射变换(initial affine transformation)和具有更高自由度但慢得多的非刚性变换分开。

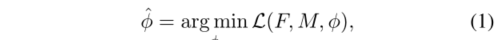

传统的配准算法(registration algorithm)都是通过迭代最优化能量函数(energy function)实现变换的。最优化的函数如下:

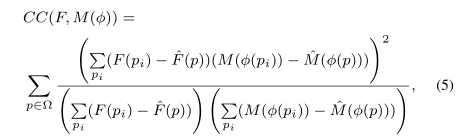

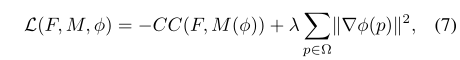

F是fixed image,M是moving image,Φ是配准域(registration field)。M(Φ)是M使用形变场Φ配准后的图像。Lsim(.,.)用来衡量F和M(Φ)的相似性(similarity),Lsmooth(.)是对形变场Φ进行正则化(regularization),λ是正则化参数(regularization parameter)。

Φ、Lsim、Lsmooth有几个共同的形式。一般Φ是移动向量场(displacement vector field),也就是从F图像到M图像每个voxel的矢量偏移量。微分同胚变换(diffeomorphic transforms)是将形变场Φ作为一个速度向量场的积分(integral of a vector field)一个较为常见的选择。因此他们可以保持拓扑结构(topology)并且执行可逆(invertibility)Φ。

Lsim的常用度量有均方体素差(mean squared voxel difference)、交互信息(mutual information)和互相关(cross-correlation)。 交互信息(mutual information)和互相关(cross-correlation)在强度分布和对比度不一致时十分有效。

Lsmooth增强了一个空间平滑形变(spatially smooth deformation),一般是采用Φ空间梯度的线性操作(linear operator on spatial gradients of Φ)。

3. Related Work(相关工作)

3.1 Medical Image Registration (Non-learning-based)

(基于非线性的医学图像配准)

在位移向量场的空间(the space of displacement vector fields)中的配准,主要有:

| 优化函数 |

|---|

| 弹性模型(elastic-type models) |

| 统计参数映射(statistical parametric mapping) |

| b采样的自由度形式形变(free-form deformations with b-splines) |

| Demons |

本文的模型也是假设在移动向量场(displacement vector fields)。微分同胚变换(diffeomorphic transforms),可以保证拓扑结构(topology-preserving),并且在各种计算解剖学上取得了显著效果。常用的公式包括:

| Diffeomorphic Transforms |

|---|

| Large Diffeomorphic Distance Metric Mapping(LDDMM) |

| DARTEL |

| Standard Symmetric Normalization(SyN)–标准对称归一化 |

3.2 Medical Image Registration(Learning-based)

(基于学习的医学图像配准)

已经有一些论文提出了利用神经网络学习一个用于医学图像配准的函数,这些大多数依赖于扭曲域(warp fields)或者分割(segmentations)。这些提出的方法都是由一个CNN网络和空间变换函数组成(spatial transformation function)。但是这些提出的论文只是在3D子区域或者2D切片上做少量形变。另外的一些是用插值方法隐式确定的正则化。相比而言,本文的方法适用于整个三维体,并且使用任意可微分的代价函数。

3.3 2D Image Alignment(2D图像对齐)

光流估计(optical flow estimation)是一个与三维体类似的二维配准。光流算法(optical flow algorithms)返回一个描述二维图像对之间小位移的密集位移向量场(a dense dispalcement vertor field)。传统的光流方法使用变分方法(variational methods)解决类似于(1)的优化问题。拓展的方法可以处理大位移或者外观显著变换包括基于特征匹配(feature-based matching)和最近邻域(nearest neighbor fields)的方法。

一些基于学习的二维图像配准方法被提出,一个是在自然图像中使用PCA学习低维基(low-dimensional basis)的方法。另一个通过卷积神经网络(CNN)学习光流(optical flow)参数函数(parametric function)的方法。这些方法在训练的时候都是需要分割信息的。空间变换层(spatial transform layer)使得神经网络(neural network)能够在不需要监督标签(supervised labels)的情况下实现全局参数化(global parametric)的二维图像对齐(alignment)。

4. Method(方法)

F、M是定义在n-D空间的两个图像体(image volumes)。本文是在三维空间(n=3)且为了简化,假设F、M是单通道(single-channel)、灰度数据(grayscale parameters)。假定F、M在预处理阶段就已经仿射对齐(affinely aligned)了,仅剩下非线性对齐操作。有许多软件包可用于快速仿射对齐。

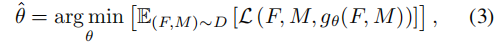

本文的模型函数使用卷积神经网络(CNN)求解,Φ是配准域(registration field),θ是函数g可学习到的参数(learnable parameters)。对于每个voxel p∈Ω,Φ( p)是形变场在位置p的位置,是F( p)和M(Φ( p))相似的解剖学位置(anatomical locations)。

M和F是输入,计算基于参数θ的形变场Φ,θ也是卷积层的核函数。将M( p)使用空间变换函数(spatial transformation function)扭曲到(warp to)M(Φ( p)),然后使用模型估计M(Φ)和图像F之间的相似性并更新参数θ。

通过最小化损失函数(loss function)L(.,.,.),利用随机梯度下降方法找到最优参数(optimal parameters)。

其中D是数据集分布(dataset distribution),通过在数据集D中的采样体对(volume pairs)对齐来学习最优参数,这里不需要一些监督信息(supervised information)例如真实的配准域(ground truth registration)或者解剖学标记(anatomical landmarks)。在测试期间给定一个没有见过的M、F,通过评估g来获得配准域(registration field)。

4.1 VoxelMorph CNN Architecture

g函数基于类似于UNet的卷积神经网络来实现参数化,网络由一些包含跳跃连接的编码器-解码器(encoder-decoder)组合而成,可以从给定的M和F中响应生成Φ。

图3描述了两种架构变体,一个是注重配准精度,另一个是注重配准时间。两个网络的输入都是将M和F组成一个2通道的3D图像,在本文实验中输入图像尺寸是160x192x224x2。在编码器和解码器阶段使用了三维卷积和Leaky ReLU激活函数,卷积核大小是3x3x3。在卷积层获取输入图像对的层次特征(hierarchical features)来评价相应的形变场Φ。

在编码层(encoder)使用卷积步长(strided convolutions)来将空间维度减半,直到达到最小层。在输入图像的粗糙表示上随后的编码操作与传统的图像配准工作的图像金字塔(image pyramid)类似。

最小卷积层的接收域(receptive fields)至少应该与M和F中相应体素之间最大期望位移相同(maximum expected displacement)。最小层的输入图像尺寸的(1/16)。解码层(decoding stage),我们交替使用上采样(upsampling),卷积层(convolutions)(Leaky ReLU激活层之后)并且连接跳跃(concatenating skip connections)。跳过连接(skip connections)将在编码阶段学到的特性直接传播到用于生成配准的层。编码器(decoder)的输出Φ,在文本的输出尺寸是160x192x224x3。解码器的连续层操作在更精细的空间尺度上,使精确的解剖对齐成为可能。

4.2 Spatial Transformation Function

该方法学习最优化参数的值一部分上是最小化M(Φ)和F之间的差异,为了使用标准的基于梯度方法(standard gradient-based methods),构建了基于空间变换网络(spatial transformer network)的可微分方法来计算M(Φ)。

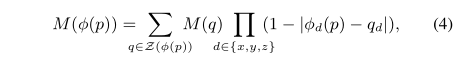

对于每个voxel p,我们计算出了M的一个亚像素体素位置(subpixel voxel location Φ( p)),但是由于图像位置必须是整数,我们在8个邻域体素(neighboring voxels)使用线性插值(linearly interpolate)方法,形式如下:

Z(Φ( p))是Φ( p)的邻域(voxel neighbors),因为操作在任意位置都是可微分的,因此我们可以在最优化期间反向传播(backpropagate)误差。

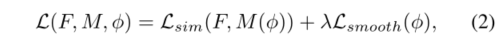

4.3 损失函数

提出的方法在可微的损失函数(differentiable loss)上。在本节中我们公式化表示形如公式(2)的损失函数L。它由两部分函数组成:Lsim惩罚外貌上的差异(penalizes difference in appearance),Lsmooth惩罚Φ局部空间变化。在本实验中Lsim是M(Φ)和F之间的负局部相关性(negative local cross-correlation)。这是一个常用的度量,对扫描和数据集之间经常发现强度变化具有鲁棒性。

让F( p)和M(Φ( p))表示减去局部均值的图像,我们计算局部均值n3体(volume),在本文的实验中n=9。F和M(Φ)的局部互相关为:

pi在p的n3体邻域上迭代。CC值越大表示对其效果越好,相对损失函数而言:

Lsim(F,M,Φ) = -CC(F,M(Φ)),仅使用M(Φ)和F上的卷积运算就可以有效的计算CC。

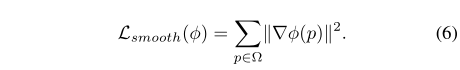

最小化的Lsim会让M(Φ)更加接近F,但是也许会生成一个不连续(discontinuous)的形变场Φ。因此使用在Φ空间梯度(spatial gradient)上一个扩散约束(diffusion regularizer)来平滑形变场Φ:

来近似空间梯度(spatial gradient)。

λ是正则化参数(regularization parameter)。

5. Experiments(实验)

5.1 Dataset(数据集)

标准的预处理包括仿射空间归一化(affine spatial normalization),提取(extraction)和裁剪(crop),最后进行解剖学分割。质量控制QC(quality control)是人工检测的分割误差。

Atlas-based代表一个参考,要么是平均体(average volume),要么是联合和反复对齐大脑数据集来构建并将它们平均起来的。

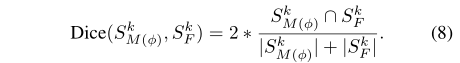

5.2 Dice Score

为这些数据获取密集的真实配准并不是很准确,因为很多的配准域也会有相同的结果。本文的评估手段使用解剖学分割。S分别表示M(Φ)和F的结构k。

5.3 Baseline Methods

5.4 Implementation

通过TensorFlow后端的Keras实施,我们使用学习率为1e-4 ADAM 优化器(optimizer)。为了减少内存的使用,每个训练批次(batch)由一对体(volumes)组成。使用不用的λ独立训练不同的网络。最优化Dice Score作为验证数据。

4039

4039

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?