提示:文章写完后,目录可以自动生成,如何生成可参考右边的帮助文档

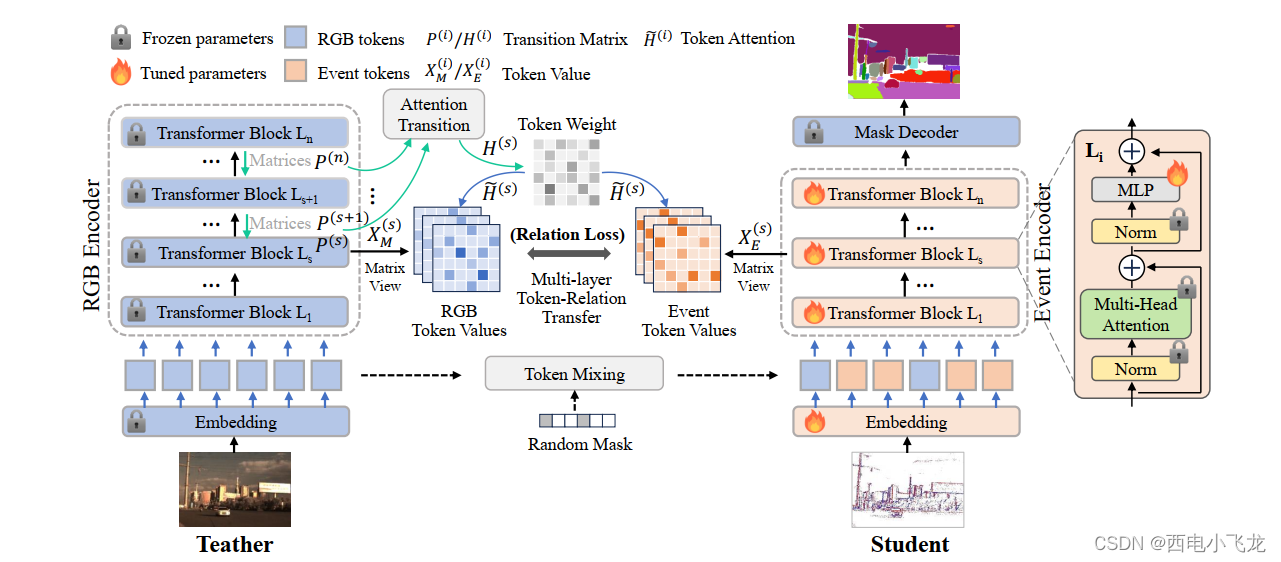

欢迎大家关注我们有关于SAM跨模态知识蒸馏的最新工作:Segment Any Events via Weighted Adaptation of Pivotal Tokens (Arxiv, Github)。我们都看到这几个月关于SAM,Large Pretrained Model等的工作层出不穷,但是他们大部分是基于常见模态的数据,比如图像,文本等。但是对于其他缺少大量标注数据的模态,这时如何有效的进行有效的pretrained知识迁移就变成了一个重要问题。在本文,为了解决这个问题,我们借助 transformer 易于解释的特点提出了基于token embedding 重要性的 weighted adaptation的方法。

方法

具体的来说,我们的方法首先建立在一个理性的假设上。虽然我们期望network尽量减小不同modalities的分布差异,但是由于不同模态的内在的差异,我们是无法完全对齐一个模态的输入到令一个模态。这时,我们自然而然的想到一个问题就是不同的token embedding 对于最终的任务是否有重要性的区别?网络可解释性的论文能够对不同区域的feature 重要性给出支持,但是大多数工作需要借助反向传播的梯度进行解释。本来蒸馏需要我们同时跑两个网络,如果还要求对两个网络进行反向传播将会让训练开销大大增加。如果我们能够以比较低的代价(无需对teacher 进行反向传播)进行token重要性的评价的话,我们相信将对训练效率较大的帮助。

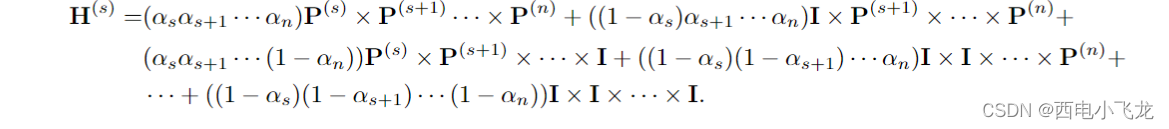

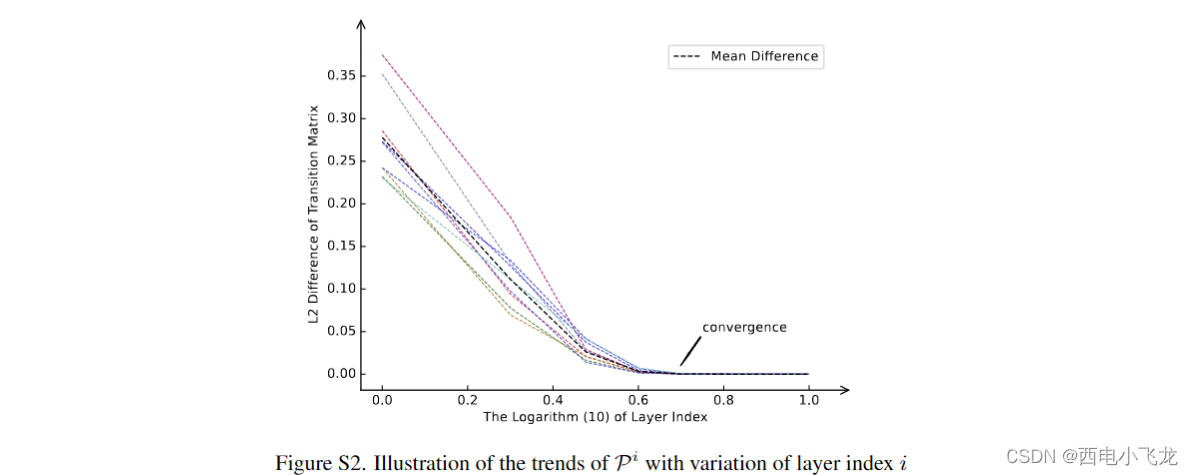

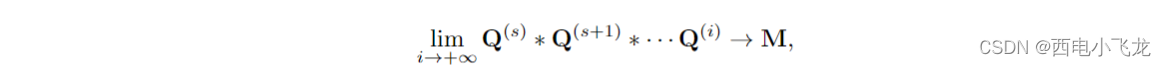

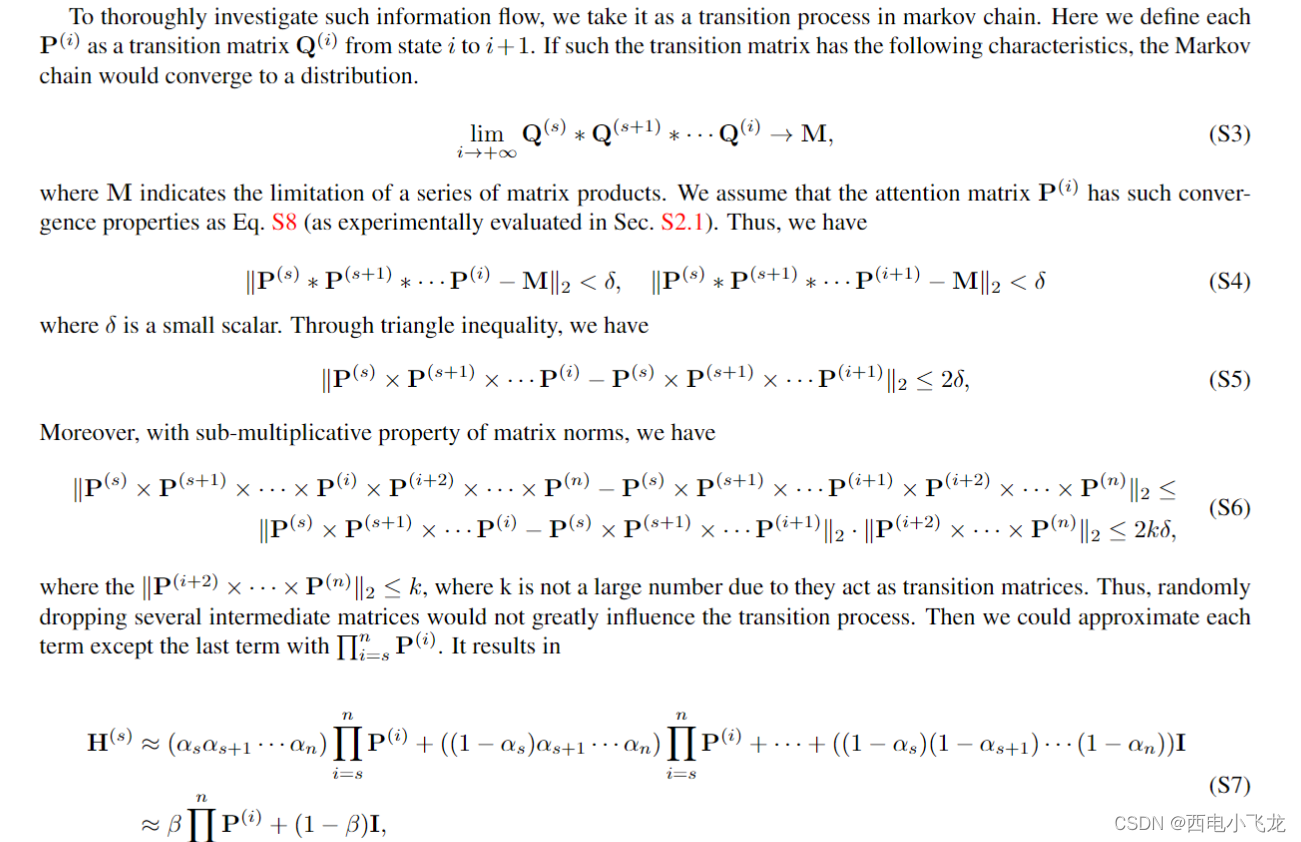

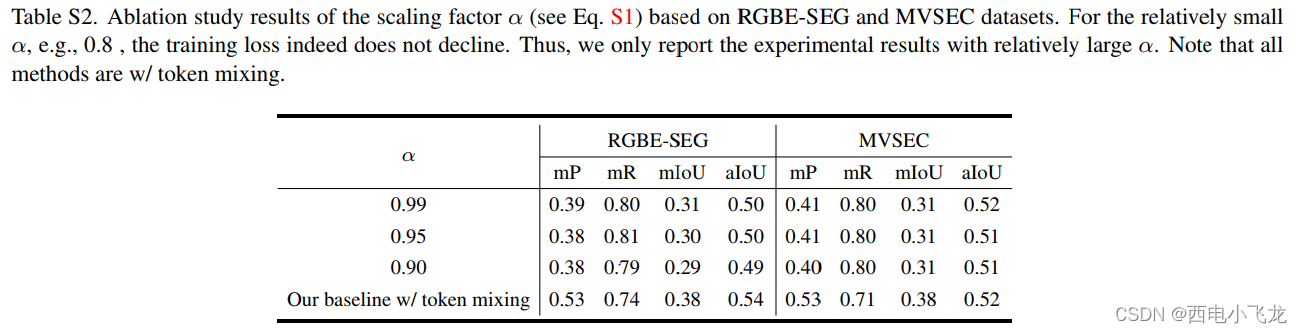

我们在此关注token-wise的重要性,因此将transformer的 forward 过程精简为一个Markov Chain, 其中的状态转移矩阵为 α i P ( i ) + ( 1 − α i ) I \alpha_i\mathbf{P}^{(i)} + (1-\alpha_i)\mathbf{I} αiP(i)+(1−αi)I,其中 P ( i ) \mathbf{P}^{(i)} P(i)代表self-attention matrix, I \mathbf{I} I代表residual connect, α i \alpha_i αi是一个layer-wise的scaler 代表经过mlp处理后 经过residual 和self-attention layer的信息含量比例的变化。那么一个 N layers的transformer 就可以用这么一个公式来代表:

那么问题随之而来,就是 α i \alpha_i αi是怎么计算?一种简单粗暴的方法就是统一设置为某个固定的数,但是经我们实验效果非常不好,甚至可能降低网络性能。为了解决这个问题,我们接下来对进行一个拆解:

我们可以看到

H

(

s

)

\mathbf{H}^{(s)}

H(s)中其实包含了大量

P

(

i

)

\mathbf{P}^{(i)}

P(i)的连乘,于是我们在想是否有某些性质可以帮助我们进行

H

(

s

)

\mathbf{H}^{(s)}

H(s)的化简。令人惊喜的是多层的attention matrix 连乘的结果都会收敛:

那么借助于这个假设有类似于下式的收敛性:

我们对 H ( s ) \mathbf{H}^{(s)} H(s)可按如下描述进行化简:

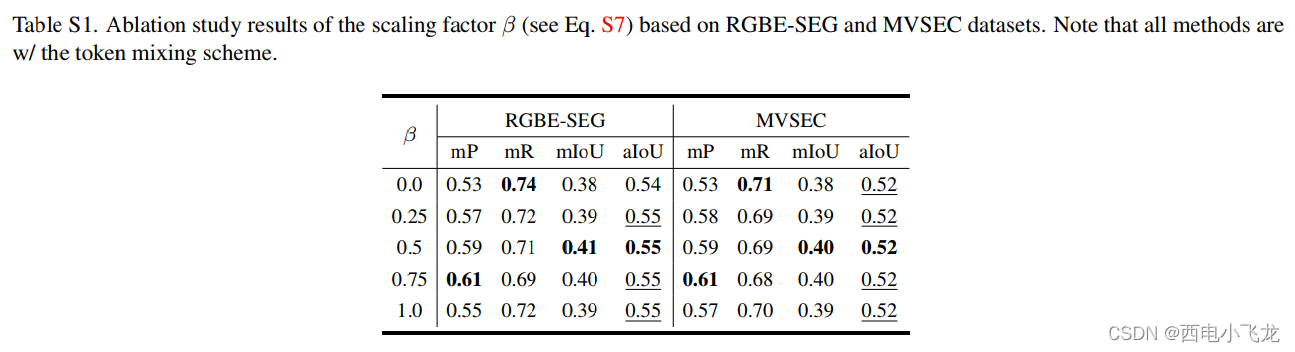

那么n-s个 α i \alpha_i αi的超参可以化简为一个 β \beta β。此时我们可以乘一个1向量到化简后的matrix上面来得到token-wise的重要性。

之后我们利用token-wise 的重要性对multi-layer 的feature map进行loss加权。下面的用来平衡不同深度之间的weight:

整体训练流程如下:

结果

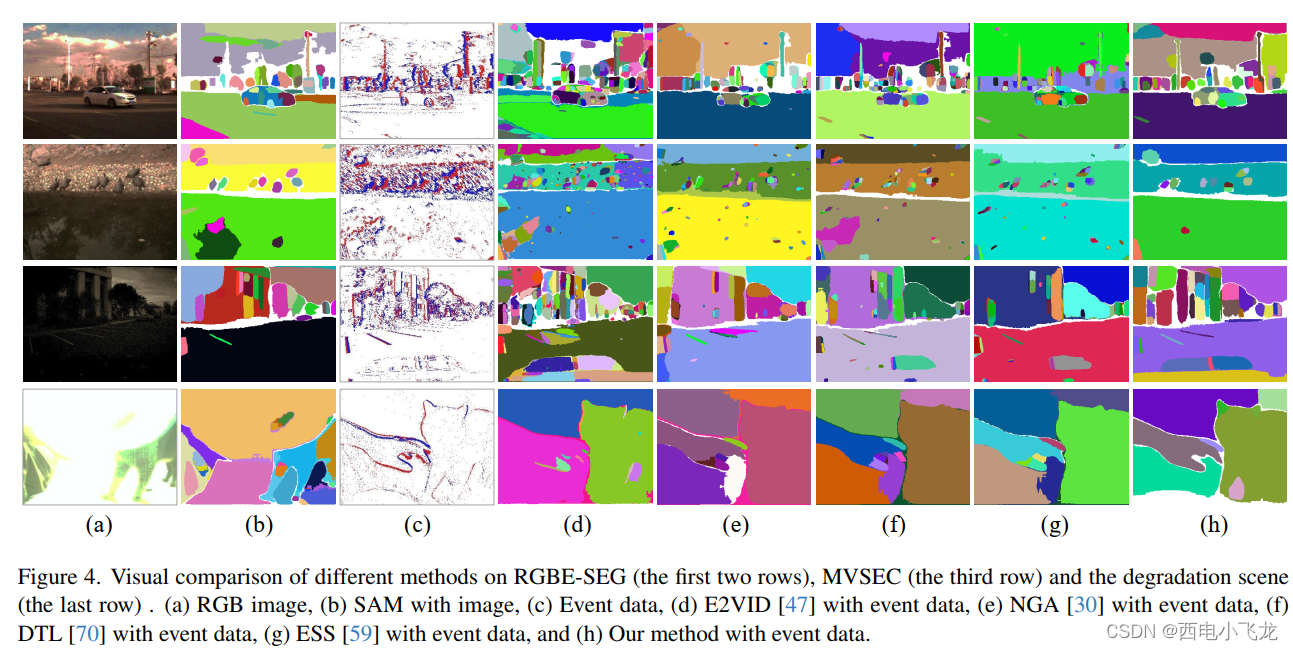

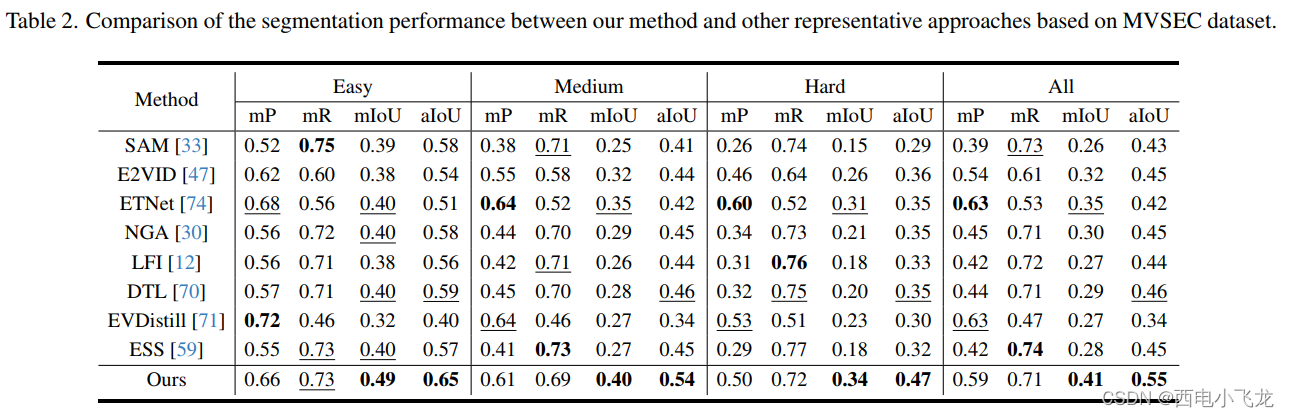

实验结果如下所示,可以清晰地分割Event Data中的细粒度目标, 同时取得了最好的性能:

我们同时嵌入adapted sam 到LLM-SAM 联合的方法,效果如下:

531

531

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?