张量(Tensors)

Tnesors与Numpy中的ndarrays类似,但pytorch中Tensors可以使用GPU进行计算。

from __future__ import print_function

import torchfrom __future__ import print_function 用法

这是为了在老版本的Python中兼顾新特性的一种方法。

从python2.1开始以后, 当一个新的语言特性首次出现在发行版中时候, 如果该新特性与以前旧版本python不兼容, 则该特性将会被默认禁用. 如果想启用这个新特性, 则必须使用 "from __future__import *" 语句进行导入.

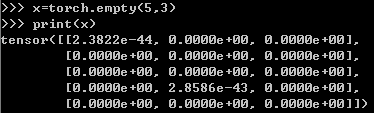

- 创建未初始化矩阵

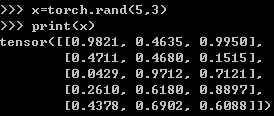

- 创建随机初始化矩阵

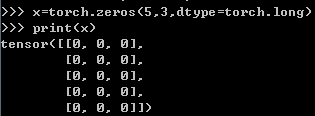

- 创建数据类型为long 0 填充的矩阵

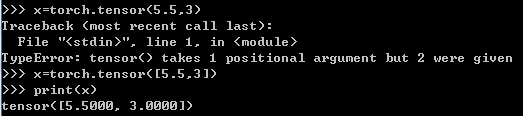

- 创建tensor并使用现有数据初始化

注意:x = torch.tensor([5.5, 3])的“[ ]”

- 根据现有张量创建张量。

x = x.new_ones(5, 3, dtype=torch.double) # new_* 方法来创建对象

print(x)

x = torch.randn_like(x, dtype=torch.float) # 覆盖 dtype!

print(x) # 对象的size 是相同的,只是值和类型发生了变化- 获取张量size

![]()

![]()

注:使用size方法与Numpy的shape属性返回的相同,张量也支持shape属性

``torch.Size`` 返回值是 tuple类型, 所以它支持tuple类型的所有操作.

- 操作语法

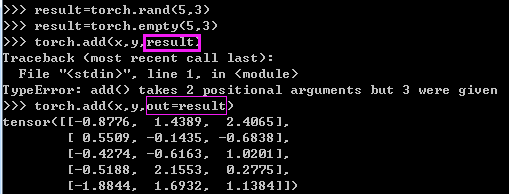

提供输出tensor作为参数

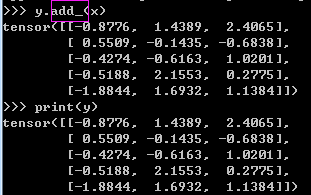

- 替换

Note

任何 以``_`` 结尾的操作都会用结果替换原变量. 例如: ``x.copy_(y)``, ``x.t_()``, 都会改变 ``x``.

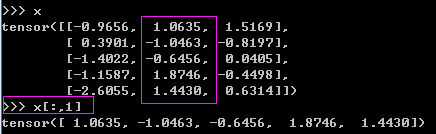

- 与NumPy索引方式相同的操作来进行对张量的操作

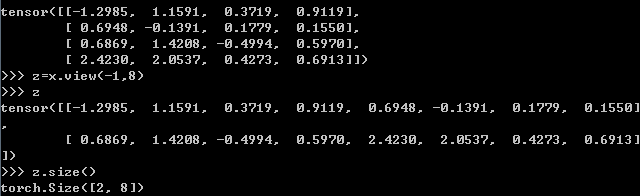

- torch.view与Numpy的reshape类似

x = torch.randn(4, 4)

y = x.view(16)

z = x.view(-1, 8) # size -1 从其他维度推断

print(x.size(), y.size(), z.size())

均匀分布

torch.rand(*sizes, out=None)

返回一个张量,包含了从区间[0, 1)的均匀分布中抽取的一组随机数。张量的形状由参数sizes定义。

参数:

- sizes (int...) - 整数序列,定义了输出张量的形状

- out (Tensor, optinal) - 结果张量

标准正态分布

torch.randn(*sizes, out=None) → Tensor

返回一个张量,包含了从标准正态分布(均值为0,方差为1,即高斯白噪声)中抽取的一组随机数。张量的形状由参数sizes定义。

参数:

- sizes (int...) - 整数序列,定义了输出张量的形状

- out (Tensor, optinal) - 结果张量

离散正态分布

torch.normal(means, std, out=None) → → Tensor

返回一个张量,包含了从指定均值means和标准差std的离散正态分布中抽取的一组随机数。

标准差std是一个张量,包含每个输出元素相关的正态分布标准差。

参数:

- means (float, optional) - 均值

- std (Tensor) - 标准差

- out (Tensor) - 输出张量

线性间距向量

torch.linspace(start, end, steps=100, out=None) → Tensor

返回一个1维张量,包含在区间start和end上均匀间隔的step个点。

输出张量的长度由steps决定。

参数:

- start (float) - 区间的起始点

- end (float) - 区间的终点

- steps (int) - 在start和end间生成的样本数

- out (Tensor, optional) - 结果张量

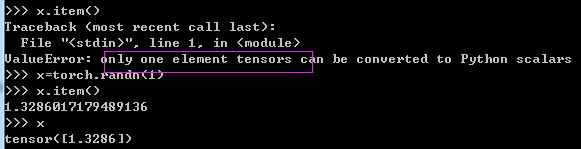

- 如果你有只有一个元素的张量,使用

.item()来得到Python数据类型的数值

-

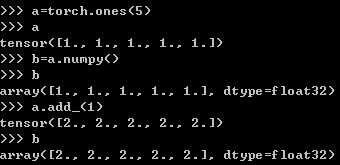

Numpy转换

Torch自称为神经网络界的Numpy,它能将torch产生的tensor放在GPU中加速运算,就想Numpy会把array放在CPU中加速运算。所以在神经网络中,用Torch的tensor形式更优。

为减少用户的学习成本,Torch对Numpy实现了很好的兼容。可以用如下形式在numpy array和torch tensor之间自由转换。

所有的 Tensor 类型默认都是基于CPU, CharTensor 类型不支持到 NumPy 的转换.

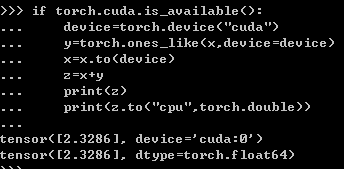

- CUDA张量

# is_available 函数判断是否有cuda可以使用

# ``torch.device``将张量移动到指定的设备中

if torch.cuda.is_available():

device = torch.device("cuda") # a CUDA 设备对象

y = torch.ones_like(x, device=device) # 直接从GPU创建张量

x = x.to(device) # 或者直接使用``.to("cuda")``将张量移动到cuda中

z = x + y

print(z)

print(z.to("cpu", torch.double)) # ``.to`` 也会对变量的类型做更改https://github.com/zergtant/pytorch-handbook/blob/master/chapter1/1_tensor_tutorial.ipynb

381

381

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?