点击上方“小白学视觉”,选择加"星标"或“置顶”

重磅干货,第一时间送达题目:将十四种事后归因方法统一为泰勒交互

作者:Huiqi Deng , Na Zou , Mengnan Du , Weifu Chen , Guocan Feng , Ziwei Yang , Zheyang Li , and Quanshi Zhang

摘要

在深度神经网络(DNNs)的多种实际应用中,尽管取得了广泛的成功,但它们通常被视为“黑箱”,因为很难解释DNN是如何做出决策的。缺乏可解释性限制了它们在高风险任务上的广泛应用,例如自动驾驶和AI医疗。因此,解释DNN已经引起了越来越多的关注。作为解释DNN的一个典型视角,归因方法旨在计算每个输入变量对网络输出的归因/重要性/贡献得分。尽管近年来提出了许多归因方法,但它们大多数都建立在不同的启发式基础上。本文中,我们采用泰勒交互作为新的统一视角,首次证明了十四种现有的基于完全不同启发式定义归因的方法实际上共享相同的核心机制。具体来说,我们证明了这十四种归因方法估计的输入变量的归因得分都可以数学上重新表述为两种典型效应的加权分配,即每个输入变量的独立效应和输入变量之间的交互效应。这些归因方法之间的基本区别在于分配不同效应的权重。受到这些见解的启发,我们提出了三个原则,用于公平地分配效应,作为评估归因方法忠实度的新标准。本研究提供了一个统一的视角,重新审视十四种归因方法,理论上阐明了它们之间的基本相似性和差异。

关键词

归因方法

泰勒交互

I. 引言

尽管在各种实际应用中取得了广泛的成功,深度神经网络(DNNs)通常被视为“黑箱”,因为很难解释DNN是如何做出决策的。解释性不足限制了它们在高风险任务上的广泛应用,例如自动驾驶[9]和AI医疗[26]。因此,解释DNN已经引起了越来越多的关注。

作为解释DNN的一个典型视角,归因方法旨在计算每个输入变量对网络输出的归因/重要性/贡献得分[10], [22], [29]。例如,对于一个预训练的用于图像分类的DNN和一个输入图像,每个输入变量的归因得分指的是每个像素对分类置信度的数值影响。

尽管近年来提出了许多归因方法[5], [10], [29],它们大多数都建立在不同的启发式基础上。例如,一些方法[33], [37]认为输出相对于输入的梯度可以反映输入变量的重要性。此外,一些方法[40], [41]使用输入变量xi被遮挡时输出的变化来衡量重要性。

缺乏统一的理论视角来检验这些归因方法的正确性,或者至少数学上阐明它们的核心机制,例如,解释它们的本质相似性和差异,以及比较它们的优缺点。一些研究者已经尝试统一不同的归因方法[2][29] [22],但这些研究只涵盖了少数方法(详见表I)。

在本文中,我们提出了泰勒交互作为一种新的统一视角,它首先使我们能够将多达十四种归因方法的机制数学公式化为同一系统。此外,这十四种归因方法涵盖了基于完全不同启发式设计的不同类型的归因方法,包括基于梯度的方法、反向传播方法和扰动基础方法。我们相信,一个能够统一各种方法的数学系统更有可能反映生成归因的基本因素,并能够公平地比较不同的归因方法。尽管在各种实际应用中取得了广泛的成功,深度神经网络(DNNs)通常被视为“黑箱”,因为很难解释DNN是如何做出决策的。解释性不足限制了它们在高风险任务上的广泛应用,例如自动驾驶[9]和AI医疗[26]。因此,解释DNN已经引起了越来越多的关注。

作为解释DNN的一个典型视角,归因方法旨在计算每个输入变量对网络输出的归因/重要性/贡献得分[10], [22], [29]。例如,对于一个预训练的用于图像分类的DNN和一个输入图像,每个输入变量的归因得分指的是每个像素对分类置信度的数值影响。

尽管近年来提出了许多归因方法[5], [10], [29],它们大多数都建立在不同的启发式基础上。例如,一些方法[33], [37]认为输出相对于输入的梯度可以反映输入变量的重要性。此外,一些方法[40], [41]使用输入变量xi被遮挡时输出的变化来衡量重要性。

缺乏统一的理论视角来检验这些归因方法的正确性,或者至少数学上阐明它们的核心机制,例如,解释它们的本质相似性和差异,以及比较它们的优缺点。一些研究者已经尝试统一不同的归因方法[2][29] [22],但这些研究只涵盖了少数方法(详见表I)。

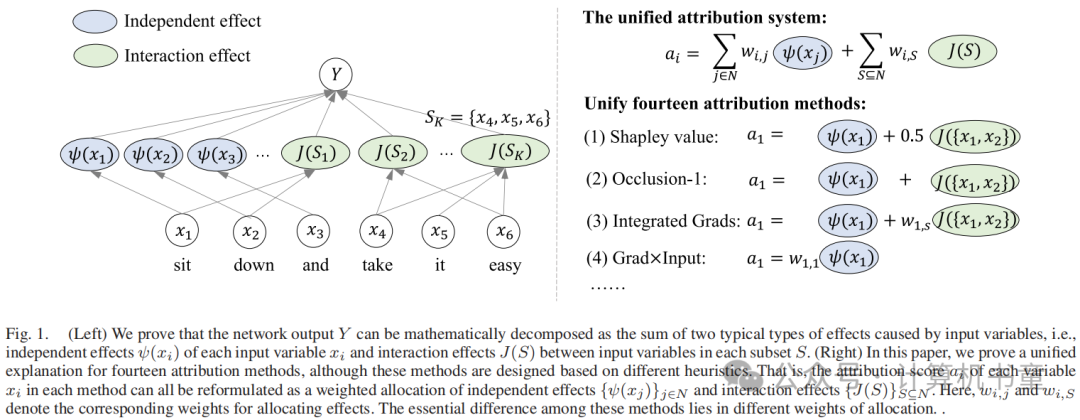

在本文中,我们提出了泰勒交互作为一种新的统一视角,它首先使我们能够将多达十四种归因方法的机制数学公式化为同一系统。此外,这十四种归因方法涵盖了基于完全不同启发式设计的不同类型的归因方法,包括基于梯度的方法、反向传播方法和扰动基础方法。我们相信,一个能够统一各种方法的数学系统更有可能反映生成归因的基本因素,并能够公平地比较不同的归因方法。图1提供了所提出的泰勒交互视角的概述。

所提出的泰勒交互是一个新的度量,用于表示输入变量对网络输出的两种类型效应。首先,一个输入变量可能对网络输出产生直接影响,不受其他输入变量的影响。这种效应被称为独立效应。其次,一个输入变量也可能与其他输入变量合作影响网络输出。这种效应被称为交互效应。这两种效应都可以量化为特定的泰勒交互。

作为玩具示例,让我们考虑一个DNN用于场景分类任务,该任务被训练以适应目标函数 。在这里,二进制输入变量 , , 表示这些对象在场景中的出现/缺席状态。book变量 对输出有独立效应 的影响。变量 , , 之间的协作对场景分类有交互效应 。

在本文中,我们证明了由十四种不同的归因方法生成的归因得分都可以用上述两种类型的效应来解释。每种归因方法的核心机制可以数学表示为将每个独立效应和每个交互效应的特定比例分配给输入变量 ,以计算 的归因得分。此外,这些归因方法之间的基本区别在于它们通过将独立效应和交互效应的不同比例分配给输入变量来计算归因得分。

为了理解上述统一视角,让我们考虑前面的例子 。有一个独立效应 和一个交互效应 。然后,十四种归因方法中变量 的归因得分都可以表示为 ,其中 分别是分配独立效应和交互效应的比例。这些归因方法在确定比例 和 的方式上有所不同。例如,Shapley值[22]将整个独立效应分配给变量 ,并分配 的交互效应给 。这样,归因被计算为 。相比之下,Occlusion-1[40]将整个独立效应和整个交互效应分配给变量 。也就是说,归因是 。

忠实归因的原则。上述统一视角使我们能够直接比较不同的归因方法。为此,我们提出了三条原则来检验一个归因方法是否公平地分配了这两种类型的效应给输入变量,这些原则作为评估归因方法忠实度的标准。让我们用前面的例子来解释这三条原则。

(i) 一个变量的独立效应 是由变量 直接引起的,不受其他变量的影响。因此,独立效应 应该完全分配给变量 。其他变量不应该被分配这样的效应。

(ii) 交互效应 是由其自身的一组变量 的协作引起的。因此,这样的效应应该被分配给参与的变量,而不是没有参与协作的变量。

(iii) 交互效应 应该完全分配给参与的变量。换句话说,当我们将分配给参与变量的数值效应加起来时,我们得到整体交互效应的确切值。

随后,我们应用这三种原则来评价这14种归因方法的可信度。我们发现,归属方法,如沙普利值[22],积分梯度[37],和DeepLIFT重尺度[32]满足所有的原则。

综上所述,本文有三个贡献:

我们提出泰勒交互作用作为一个新的统一视角,从理论上解释14种归因方法的核心机制。

对于每种特定的归因方法,统一的视角使我们能够阐明其计算属性的独特特性。

我们提出了三个原则来评价一种归因方法的忠实度,即评估该方法是否公平地将独立效应和交互效应分配给输入变量。

比我们之前的会议论文有了显著的改进。本文的初步版本已经发表在AAAI [6]上,在那里我们提出了一个统一的泰勒系统来解释和统一七种归因方法。相比之下,本文对[6]做了几个显著的改进:(i)我们在第III-A节中正式提供了泰勒相互作用的确切定义。在AAAI论文中,我们只使用二阶泰勒展开中一个特定的泰勒相互作用效应作为直观的例子来说明。(ii)我们在第三节-d节中证明了7个新的定理,以重新制定和统一另外7种归属方法到我们的系统中,包括预测差、大凸、夏普利值、LRP-αβ、深泰勒、深LIFT显示取消和深轴。(iii)我们在第三节-B节中证明了我们的泰勒相互作用与典型的博弈论相互作用之间的密切联系,这表明了泰勒相互作用的普遍性和牢固性。(iv)我们进行了新的实验来可视化更多的归因结果,验证了我们的理论的正确性,并检验了所提出的原则在评估归因方法中的保真度。

III. 统一归因方法

归因方法已经被开发出来,作为解释深度神经网络(DNNs)的典型视角[10] [22]。具体来说,给定一个预训练的DNN 和输入样本 ,一个归因方法估计一个归因向量 ,其中 表示输入变量 对DNN 标量输出的数值效应。例如,在分类任务中, 可以设置为目标类别的分类概率。我们在表II

尽管最近提出了各种归因方法,但它们大多数是建立在不同的启发式基础上的。目前仍然缺乏一个统一的视角来解释这些归因方法为何有效以及它们之间是如何关联的。因此,在本文中,我们提出了泰勒交互作为一种新的统一视角,它允许我们解释多达十四种归因方法的机制。

A. 通过泰勒交互效应解释DNN

在这一小节中,我们提出泰勒交互作为一种新视角,它数学上证明了DNN的输出可以分解为两种典型的效应:包括每个输入变量的泰勒独立效应和输入变量之间的泰勒交互效应。在以下的小节中,我们将使用这两种效应来解释和比较不同归因方法的核心机制。

预备知识:DNN的泰勒展开

给定一个预训练的DNN 和输入样本 ,考虑在基线点 处的DNN 的 阶泰勒展开。

其中 表示 阶展开的近似误差。每个展开项 定义为:

这里, 表示展开项 的度数向量, 表示变量 的非负整数度数。

此外,我们将公式(1)中的所有展开项分为不同的阶数。每个展开项 的阶数定义为其整体的度数,

这样,我们就可以使用度数向量集合 来表示第 阶的所有展开项。

泰勒交互效应

在上述公式(1)中,每个泰勒展开项 表示集合 中输入变量之间的交互作用。这里, 表示交互 的感受野,即参与交互的所有变量的集合。

我们以DNN面部识别的泰勒展开项 为例,其中 , 和 。这个展开项 表明变量在 之间的交互作用形成了一个AND模式。只有当 中的所有变量共同出现时,AND模式才形成,并对DNN的输出 产生交互效应 。相反,使用它们的基线值 遮蔽任何变量 , 和 将使AND模式失效,并从网络输出中移除数值效应,即使得 。因此, 量化了交互(AND模式)对网络输出的影响,这被称为泰勒交互效应。

泰勒独立效应

我们进一步定义一种特殊的泰勒交互效应 ,其中只涉及单个变量的交互(),作为泰勒独立效应。我们用新符号 来表示它,以区别于其他的泰勒交互效应。

泰勒独立效应表示单个变量的效应,而不依赖于(与其他变量交互)。例如,当度数向量 满足 时,泰勒独立效应计算为:

为了避免歧义,在以下手稿中,我们使用泰勒独立效应 来表示不依赖于其他变量的单个变量的效应(),并使用泰勒交互效应 来表示多个变量之间的交互效应()。

将网络输出分解为每个输入变量的独立效应和每组输入变量的交互效应

对于特定的输入变量集 (),让我们考虑由 中变量之间的交互引起的整体效应,记作 ,定义为与感受野 相关的所有泰勒交互效应的总和。我们将 称为 的通用交互效应。

其中 是与所有具有相同感受野 的泰勒交互效应 对应的度数向量 的集合。更具体地说,。

同样,我们定义变量 的通用独立效应 来测量变量 在不与其他变量交互的情况下的总体效应。

其中 是与变量 的所有泰勒独立效应 对应的度数向量 的集合。更具体地说,。我们在表III提供了一个玩具示例来说明泰勒(通用)独立效应和泰勒(通用)交互效应。

命题 1(证明见在线附录 A)

网络输出 可以分解为不同变量的通用独立效应 之和以及不同子集变量的通用交互效应 之和。

B. 泰勒交互效应与Harsanyi红利之间的联系

在这一部分,我们证明了泰勒交互效应(通用交互效应)与典型的Harsanyi红利交互度量之间的密切理论联系。

Harsanyi红利 是一种典型的博弈论交互度量,用于测量特定集合 的输入变量之间的交互效应,计算公式如下:

其中 表示在输入样本 中,集合 中的变量保持不变,而集合 中的变量被遮蔽到预定义的基线值时的网络输出。

定理 1(证明见在线附录 A)表明,Harsanyi红利 等同于我们在公式(6)中定义的集合 中变量的通用交互效应 。

该定理证明了典型的Harsanyi红利交互度量与我们的通用交互效应之间的等价性,表明了泰勒交互的通用性和稳健性。

C. 将归因重新表述为独立效应和交互效应的加权分配

在本节中,我们从泰勒交互的角度重新审视归因问题。如图 2 所示,我们发现由十四种不同的归因方法生成的所有归因都可以统一到同一个系统中,即表示为独立效应和交互效应的加权分配。

我们统一归因系统的基本思想是直观的。如命题 1 所证明,泰勒交互显示了量化每个输入变量的通用独立效应 以及由输入变量 与其他变量的协作引起的所有通用交互效应 的能力。因此,很自然地考虑每个归因方法为变量 的归因分数分配特定比例的每种效应。通过这种方式,我们使用效应分配的比率集来解释每种归因方法的特征。

具体来说,设 表示变量 的归因分数。在本文中,我们证明了尽管十四种现有的归因方法是在不同的启发式基础上设计的,但每种方法估计的 都可以重新表述为以下范式,即表示为通用独立效应和通用交互效应的特定重新分配:

其中 ( ) 表示将变量 的通用独立效应 (变量集合 中的通用交互效应 )分配给输入变量 的比率。相应地,我们可以使用 和 来表示分别从 和 分配的效应。

为了更精确,我们可以进一步将上述 (11) 扩展为泰勒独立效应和泰勒交互效应的重新分配:

其中 是对应于所有泰勒独立效应的度数向量 的集合, 是对应于所有泰勒交互效应的度数向量 的集合。此外, 表示分配给 的特定泰勒独立效应 (泰勒交互效应 )的比率。通过结合 (11) 和 (12),我们可以得到 , 和 之间的关系如下:

和

归因方法之间的基本差异在于,每种归因方法实际上使用不同的比率 , , 和 来重新分配不同的效应。

此外,在统一范式下,我们发现并非所有归因方法都能合理地为归因分数 分配每种效应的比例。例如,我们发现一些归因方法可能会将不属于交互作用的变量 (即 )的部分通用交互效应 分配给它。此外,一些归因方法可能无法完全分配通用交互效应 的所有数值给输入变量,例如 。因此,在第 IV 节中,我们提出了三条原则,以检验归因方法是否合理地分配独立效应和交互效应,以评估归因方法的忠实度。

D. 使用交互效应和独立效应统一十四种归因方法

在这一小节中,我们将十四种现有的归因方法重新表述为分配泰勒独立效应和交互效应的统一范式。我们在表 IV 中总结了所有的重新表述。

1. Gradient × Input

Gradient × Input [33] 通过将复杂的 DNN f 视为线性模型来估计归因,即 。这里, 表示输出相对于输入变量 i 的梯度。因此,Gradient × Input 认为梯度和输入的乘积反映了变量 i 的归因。

定理 2(在线附录 B 提供证明)在 Gradient × Input 方法中,归因 可以重新表述为:

其中 κκ 是一个单热向量,κ 且 κ。

定理2表明,梯度×输入遵循(12)中分配Taylor交互效应的范式。具体来说,该方法只将变量i的一个特定的泰勒独立效应φ(κ)分配给变量i的归因。

2. Occlusion-1

为了计算输入变量 i 的归因,Occlusion-1 [40] 通过基线值 遮蔽变量 i 并得到被遮蔽的输入 。然后,Occlusion-1 认为原始输入 x 和被遮蔽输入 之间的输出变化反映了变量 i 的归因。

其中 且 b 是一个常量标量。

定理 3(在线附录 B 提供证明)在 Occlusion-1 方法中,归因 可以重新表述为:

定理3表明,阻塞-1遵循了在(12)中分配Taylor交互作用效应的范式。该方法将变量i的泛型独立效应ψκφκ分配给其归因。此外,该方法将每个完整的通用交互效应κκ所涉及的变量()分配给归因。换句话说,ocict-1方法将通用交互效应反复分配给中的每个变量。

3. Occlusion-patch

Occlusion-patch [40] 首先将图像划分为 m 个补丁,即 。为了计算每个补丁 中像素的归因,Occlusion-patch 通过基线值 b 遮蔽所有在补丁中的像素并得到被遮蔽的输入 。然后,Occlusion-patch 认为原始输入和被遮蔽输入之间的输出变化反映了 中像素的归因。

定理 4(在线附录 B 提供证明)在 Occlusion-patch 方法中,补丁 中像素 i 的归因()可以重新表述为:

定理 4表明 Occlusion-patch 方法遵循了在公式(12)中分配泰勒交互效应的范式。对于像素 ,该方法将 中所有像素的通用独立效应分配给归因 ,即分配:

给 。此外,该方法还分配涉及 中一些像素()的所有通用交互效应:

给归因 。因此,Occlusion-patch 方法可能会错误地将不涉及变量 ()的通用交互效应 分配给变量 的归因。

4. Prediction Difference

Prediction Difference [41] 是 Occlusion-1 方法 [40] 的扩展。与 Occlusion-1 方法仅使用单个基线值来遮蔽 不同,Prediction Difference 方法从分布 中采样多个基线点。例如,分布可以设置为给定其他变量时 的条件分布,。然而,这种方法假设 。然后,通过在不同基线点上使用 Occlusion-1 方法生成的归因的平均值来计算归因 。

定理 5(在线附录 B 提供证明)在 Prediction Difference 方法中,归因 可以重新表述为:

其中 。

定理 5 表明 Prediction Difference 遵循在 (12) 中分配泰勒交互效应的范式。该方法采用与 Occlusion-1 方法在 (17) 中相同的分配策略,然后对不同基线点上的归因 取平均值以获得最终归因。

5. Grad-CAM

Grad-CAM [31] 估计每个卷积层中每个位置 (i, j) 的神经激活的归因,如下所示:

其中 。(22) 式中 表示第 k 个通道的 feature map 中位置 (i, j) 的神经元激活。请参阅在线附录 B 的详细说明。

为了简化分析,我们只解释 (22) 中 ReLU 操作之前的归因 ,满足 。

定理 6(在线附录 B 提供证明)在 Grad-CAM 方法中,每个神经元的归因可以重新表述为:

这里, 是 Grad-CAM 方法中 DNN 的解释模型,已在 [31] 中证明。此外,κκ 是一个单热向量,κ 且 κ。

定理 6 表明 Grad-CAM 遵循在 (12) 中分配泰勒交互效应的范式。它只为变量 的特定泰勒独立效应 分配给归因 。

通过比较定理2和定理6,我们发现GradCAM和梯度×输入实际上具有相似的泰勒相互作用效应分配机制。这两种方法的主要区别在于,Grad-CAM解释了卷积层中特征的归因,而梯度×输入则解释了输入层中变量的归因。

6. Integrated Gradients

Integrated Gradients 方法 [37] 估计归因 如下所示:

这里,积分是在从基线 到输入 的线性路径上沿多个点计算的。

定理 7(在线附录 B 提供证明)在 Integrated Gradients 方法中,归因 可以重新表述为:

定理7表明积分梯度遵循分配泰勒交互效应的范式积分梯度方法遵循了在公式(12)中分配泰勒交互效应的范式。该方法将变量的通用独立效应分配给归因。此外,该方法还分配了涉及变量的每个泰勒交互效应(其中)给归因。所分配的比率与变量的度数成比例。

期望梯度

期望梯度[13]是积分梯度[37]的一个扩展。为了估计归因,该方法从先验分布(例如,)中采样基线点,而不是在积分梯度方法中指定某个特定的基线。然后,归因通过在不同基线上积分由积分梯度方法估计的归因来计算。

定理8(见在线附录B的证明)在期望梯度方法中,归因可以重新表述为:

定理8表明期望梯度遵循在公式(12)中分配泰勒交互效应的范式。该方法采用与积分梯度方法中(26)相同的分配策略来获得归因,然后对不同基线上的归因进行平均,以获得最终归因。

Shapley值

Shapley值方法[19], [22]估计每个变量的归因为:

其中。Shapley值方法将变量的归因公式化为其在不同上下文子集上的平均边际贡献。这里,是在中的变量被遮蔽且中的变量保持不变时的网络输出。

定理9(见在线附录B的证明)在Shapley值方法中,归因可以重新表述为:

定理9表明Shapley值遵循在公式(12)中分配泰勒交互效应的范式。该方法将变量的通用独立效应分配给归因。此外,该方法还分配了涉及变量的每个泰勒交互效应(其中)给归因。效应均匀地分配给参与交互的所有个变量,即每个输入变量接收到。

反向传播归因方法

在众多归因方法中,有一种典型的方法旨在估计每个中间层特征维度的归因,然后这些归因被反向传播到前一层,直至输入层。即,,其中表示第层所有特征维度的归因。特别地,对应于输入层的归因。这种方法被称为反向传播归因方法,包括LRP-ϵ [3]、LRP-αβ [3]、Deep Taylor [23]、DeepLIFT Rescale [32]、Deep SHAP [22]、DeepLIFT RevealCancel [32]等。

各种反向传播方法之间的根本区别在于它们采用不同的递归规则来在两个相邻层之间反向传播归因,即。特别地,这些方法通常将各种DNN中的层级操作简化为一个典型模块,作为代表。这里,表示第层的特征。和分别表示权重和加性偏置。是激活函数。

LRP-ϵ

LRP-ϵ [3]是一种典型的反向传播归因方法。对于典型模块,LRP-ϵ从第层的神经元向第层的神经元传播以下归因:

其中。由于,LRP-ϵ认为在某种程度上可以反映对的贡献。为了避免除以0,LRP-ϵ在分母中引入了一个小量。然后,LRP-ϵ将归因公式化为从第层的所有特征维度传播过来的这些值的总和,即。

定理10(见在线附录B的证明)当ReLU用作激活函数时,LRP-ϵ方法估计的归因可以重新表述为:

其中是一个单热向量,其中且。

定理10表明LRP-ϵ遵循在公式(12)中分配泰勒交互效应的范式。具体来说,该方法仅将输入变量的特定泰勒独立效应分配给输入变量的归因。

通过比较定理2和10,我们可以很容易地发现LRP-和Gradient × Input在本质上是相同的,因为当ReLU被用作激活函数时,它们以相同的方式分配泰勒交互效应。此外,图3也验证了这两种方法产生的归因结果是相同的。

LRP-αβ方法

LRP-αβ [3]也是一种典型的反向传播归因方法。它对LRP-ϵ的递归传播规则进行了轻微修改,具体如下:

不同于LRP-ϵ,LRP-αβ将第 层的所有神经元分为两组,即 表示正贡献的神经元和 表示负贡献的神经元。然后,LRP-αβ使用权重 和 分别计算 和 组中的归因。最终归因 被计算为所有第 层特征维度传播值的总和,即 。

定理11

考虑 作为目标输出, 作为输入变量,分析归因在层与层之间的传播。然后,在LRP-αβ方法中,对于 中的变量 估计的归因 可以重新表述为:

对于 中的变量,归因 可以重新表述为:

其中 和 。对于 中的变量, 和 。

定理11表明LRP-αβ遵循在公式(12)中分配泰勒交互效应的范式。如公式(34)所示,对于 中的变量 ,该方法将部分泰勒独立效应 ()分配给归因 。此外,该方法还分配了涉及变量 的每个泰勒交互效应 ()的部分给归因 。然而,该方法错误地将部分泰勒交互效应 ()在 中的一些变量之间分配给 中的变量 的归因。 中变量的分配策略是类似的。

Deep Taylor方法

Deep Taylor [23]是一种典型的反向传播归因方法。对于典型的模块 ,Deep Taylor设计了如下的递归反向传播规则:

最终归因 被计算为所有第 层特征维度传播值的总和,即 。特别是,Deep Taylor可以被视为LRP-αβ [3]的一个特殊情况,其中 。

定理12

考虑 作为目标输出, 作为输入变量,分析归因在层与层之间的传播。然后,在Deep Taylor方法中,对于 中的变量 的归因 可以重新表述为:

其中 ,。对于 中的变量,。

定理12表明Deep Taylor遵循在公式(12)中分配泰勒交互效应的范式。分配的权重几乎与LRP-αβ中的权重相同,差异仅在于一个常数。

DeepLIFT Rescale方法

DeepLIFT Rescale [32]同样是一种典型的反向传播归因方法,它递归地传播归因,具体如下:

在典型的模块 中,DeepLIFT Rescale递归地传播归因 ,定义为:

其中,,,。这里, 是选定的基线值,用来表示 没有接收到任何信息的状态。因此, 反映了 在将 从基线值的状态改变为当前激活值的过程中的贡献。最终归因 被计算为所有第 层特征维度传播值的总和,即 。

定理13

考虑 作为目标输出, 作为输入变量,分析归因在层与层之间的传播。然后,在DeepLIFT Rescale方法中,估计的归因 可以重新表述为:

定理13表明DeepLIFT Rescale遵循在公式(12)中分配泰勒交互效应的范式。该方法将变量的通用独立效应 分配给归因 。此外,它还分配了涉及变量 的每个泰勒交互效应 (其中 )的特定比例给归因 。这个比例与变量 的度数 成正比。

DeepLIFT RevealCancel方法

DeepLIFT RevealCancel [32]是一种典型的反向传播归因方法,它修改了DeepLIFT Rescale方法的递归反向传播规则,具体如下:

其中,的定义与DeepLIFT Rescale方法中相同,即,,。DeepLIFT RevealCancel将所有贡献分为两组,表示正贡献的神经元,表示负贡献的神经元。然后,该方法使用权重 和 分别计算 和 中的归因。这里, 被设置为当所有 中的神经元存在时以及当所有 中的神经元不存在时, 中所有神经元的平均边际贡献。类似地, 被设置为当所有 中的神经元存在时以及当所有 中的神经元不存在时, 中所有神经元的平均边际贡献。有关 和 的计算,请参见在线附录B。

定理14

考虑 作为目标输出, 作为输入变量,分析归因在层与层之间的传播。然后,在DeepLIFT RevealCancel方法中,对于 中的变量 的归因 可以重新表述为:

对于 中的变量 ,归因 可以重新表述为:

其中 和 。

定理14表明DeepLIFT RevealCancel方法遵循在公式(12)中分配泰勒交互效应的范式。如公式(41)所示,对于 中的变量 ,该方法将变量 的通用独立效应 分配给归因 。此外,该方法还分配了涉及变量 的每个泰勒交互效应 (其中 )的部分给归因 。而且,该方法还分配了不同比例的泰勒交互效应 ()在 和 中的变量之间,给归因 。 中变量的分配策略是类似的。

Deep SHAP方法

Deep SHAP [22]是一种典型的反向传播归因方法,它将Shapley值[19], [22]结合到递归传播过程中。

其中, 表示当考虑 为输出, 作为输入变量时, 对 的Shapley值。最终,归因 被计算为从第 层所有特征维度传播得到的值的总和,即:

定理15

考虑 作为目标输出, 作为输入变量,分析归因在层与层之间的传播。然后,在Deep SHAP方法中,归因 可以重新表述为:

定理15表明Deep SHAP遵循在公式(12)中分配泰勒交互效应的范式。在每一层的传播中,该方法采用与Shapley值方法相同的分配策略,以获得归因。

E. 实验验证

在这一节中,我们进行实验以检查定理2-15的正确性,即理论上重新构建的归因值是否真的反映了不同方法估计的真实归因。

让我们使用特定的归因方法来解释DNN在给定输入样本上的表现。我们使用以下度量来衡量理论上重新构建的归因值与归因方法估计的真实归因值之间的平均拟合误差。

例如,根据(16)和定理3,

在Occlusion-1方法中,。

注意,我们不可能枚举所有泰勒交互效应。因此,我们难以精确计算理论上重新构建的归因值。相反,给定DNN和输入样本,我们只计算一阶和二阶泰勒交互效应,其中或。然后,我们通过忽略大于二阶的所有泰勒交互效应来估计。例如,在Occlusion-1方法中,。注意,我们不在输入样本处进行泰勒展开,而是在预定义的基线点处进行,这比我们之前的版本更为标准。基线是通过在输入样本上添加随机高斯扰动生成的。此外,我们注意到ReLU网络的门控状态没有连续梯度,这可能会引入大的测量误差。因此,我们训练的DNN仅使用sigmoid激活函数和softplus激活函数(ReLU的近似函数),而不是ReLU激活函数,用于测试。

我们在三种类型的模型上测试了和。第一种类型的模型是二阶多项式模型,即,其中和表示模型权重。我们将这种类型的模型称为多项式模型。第二和第三种类型的模型是三层多层感知器网络,分别应用sigmoid激活函数和softplus激活函数。我们分别称它们为MLP-Sigmoid和MLP-Softplus。我们在MNIST数据集[8]上训练这些模型,并根据(45)计算平均拟合误差。

我们评估了七种归因方法的拟合误差,包括梯度×输入、Occlusion-1、Occlusion-patch、Prediction Difference、Integrated Gradients、Expected Gradients和Shapley值方法。我们没有测试反向传播归因方法,因为这些方法的主要理论重新构建主要用于解释层间传播规则。

表V列出了七种归因方法的平均拟合误差。我们发现,在三种类型的模型上,不同归因方法的拟合误差都非常小。理论上,在多项式模型上测试时不应该有任何拟合误差,但是积分计算的不可避免误差导致了Integrated Gradients和Expected Gradients方法的微小误差。以上结果表明,对于这些归因方法,理论上推导出的归因值在实际应用中很好地拟合了它们的真实归因值。

IV. 评估归因方法

在最后一节中,我们证明了用14种归因方法估计的各种归因得分都可以重新表述为在(12)中分配泰勒独立效应φ(κ)和Taylor交互效应I(κ)的统一范式。

上述发现使我们能够在同一统一的范式下,直接、公平地评价不同的归因方法。因此,在本节中,我们提出了三个原则来评估这14种归因方法的忠实度。

A. 忠实归因方法的原则

如图4所示,我们提出的统一范式表明,每种归因方法都可以被视为一个两步流程图:

(i) 泰勒展开:首先将DNN表示为泰勒展开模型,然后重新分配:相应地重新分配泰勒独立效应和泰勒交互效应以计算归因。为此,我们发现归因方法的忠实度取决于两个关键因素:

(i) 在DNN的泰勒展开中,忠实的归因解释预期会涵盖几乎所有的展开项,并且只留下一个可以忽略不计的残差项未被解释。(ii) 在重新分配中,泰勒独立效应和泰勒交互效应是否以合理的方式分配给输入变量。

相应地,我们提出了三个忠实归因应该遵循的原则。第一原则: 低近似误差。在泰勒展开中,预期忠实的归因解释将涵盖DNN的几乎所有展开项,并且只留下一个可以忽略的残差项。第二原则: 避免无关分配。

(i) 在重新分配中,变量的每个泰勒独立效应()应该只分配给的归因。更准确地说,我们可以从归因中分解出一项,以表示从泰勒独立效应分配给变量的数值效应。然后,我们应该避免将的独立效应分配给其他无关的变量。

(ii) 在重新分配中,变量中的变量之间的每个泰勒交互效应()应该只分配给中的变量,而不应该分配给任何其他无关的变量。

第三原则: 完全分配。在重新分配中,每个泰勒独立效应,其中(即,)应该完全分配给输入变量。换句话说,如果我们累积从分配给不同变量的所有数值效应,我们可以获得的确切值。

同样,每个泰勒交互效应,其中(即,)也应该完全分配给不同的变量。

B. 评估归因方法

在本小节中,我们使用提出的原则来评估上述十四种归因方法,总结在表VI中。

Gradient × Input、LRP-ϵ 和 Grad-CAM 没有满足低近似误差原则。根据定理2、6和10,这些方法只考虑了DNN的一阶泰勒展开项来计算归因,忽略了更高阶的展开项。

Deep Taylor、LRP-αβ 和 Occlusion-patch 都违反了避免无关分配的原则。根据定理11和12,Deep Taylor 和 LRP-αβ 错误地将变量 ()之间的泰勒交互效应 分配给了与此交互无关的变量 。此外,根据定理4,Occlusion-patch 错误地将不涉及变量 的泰勒交互效应分配给了无关的变量 。

Occlusion-1、Occlusion-patch 和 Prediction Difference 都违反了完整分配原则。根据定理3、4和5,这三种方法将变量 ()之间的整个泰勒交互效应 重复分配给 中的每个变量。也就是说,对于 中的每个 ,有 。这样,从 分配给不同变量的数值效应之和是 的 倍,即 ,违反了完整分配原则。

根据定理7、8、9、13和14,Integrated Gradients、Expected Gradients、Shapley value、Deep SHAP、DeepLIFT Rescale 和 DeepLIFT RevealCancel 方法满足了所有原则。

为了清晰起见,让我们考虑一个特定的泰勒交互效应 作为一个多项式函数中的玩具示例来说明效应分配,其中度数 ,,。在这里, 量化了集合 中变量之间的交互效应。在这个示例中,上述方法都为变量 分配了交互效应 的特定权重,即 。它们之间的主要区别在于分配权重 。例如,Integrated Gradients 和 Expected Gradients 方法中的权重 是变量 的相对度数,即 。这样,两种归因方法分别为变量 、、 分配了 ,,。两种方法产生的不同归因是由它们使用不同的基线点这一事实造成的。此外,Shapley value 方法中的权重分配是 ,这意味着 。

归因方法的适用性取决于DNN的具体任务。例如,在图像分类任务中,Integrated Gradients 生成的每个像素的归因可能存在偏差。这是因为根据定理7,Integrated Gradients 通常将更大的泰勒交互效应分配给具有更高像素值的像素(例如白色像素)。相比之下,Shapley value 均匀地将泰勒交互效应分配给参与交互的不同像素,可能更适合图像分类任务。

我们的原则提供了一个新的视角,允许在相同的理论体系内公平地评估归因方法的忠实度。需要注意的是,这并不意味着满足这些原则的归因方法是理想的归因。已经提出了许多其他视角来评估归因方法[1], [2], [15], [21], [39]。

C. 与不忠度度量[39]的联系

我们发现,一些满足所提出的三条原则的归因方法,在通过不忠度度量[39]评估时也具有较高的排名。

具体来说,对于一种归因方法,不忠度度量被提出来评估由归因方法生成的归因解释 a 是否能够很好地反映输入扰动下的输出变化。具体来说,给定一个DNN f,一个输入样本 x ∈ R^n 和估计的归因得分 a ∈ R^n,不忠度度量定义为:

其中 px ∈ R^n 表示在样本 x 上添加的扰动。因此,不忠度度量量化了使用归因来预测相对于输入扰动的输出变化 f(x) − f(x − px) 的平均误差。具有低不忠度的归因方法表明具有优越的性能。在实现中,我们采用了[39]中的平方移除扰动进行评估。我们在MNIST数据集上训练的三层MLP网络和三层CNN网络上评估了不忠度,这些网络分别采用了sigmoid和softplus激活函数。

图5(a)显示了所提出的三条原则与不忠度度量之间的关系。x轴表示一个归因方法是否满足所提出的原则,y轴表示归因方法的相应不忠度度量。图5(a)表明,通常,满足所有提出原则的归因方法通常显示出较低的不忠度。

结果表明,所提出的原则与不忠度相对一致。然而,它们从不同的角度评估归因方法。具有低不忠度的归因方法并不总是满足所提出的原则,即以忠实的方式分配交互效应。

D. 与人类直觉的一致性

在本小节中,我们探讨了通过我们提出的三条原则判定为忠实的归因方法是否也与人类直觉一致。考虑到缺乏对人类直觉的既定公式,我们遵循[30]的做法,采用边界框的人类标注作为代理,大致代表人类直观的归因解释,并使用边界框重叠率度量来衡量归因方法与人类直觉之间的一致性。

具体来说,边界框重叠率度量定义如下:给定一个特定的归因方法和一张输入图像,人类用户已经使用边界框集合 对图像中目标对象的位置进行了标注。设 表示边界框中的像素数,即 。另一方面,我们也可以从未图像中所有像素选择具有最大绝对归因分数的 个像素子集,即 。重叠率度量衡量的是位于边界框内的最大绝对归因分数像素(最具代表性的像素)的比例。

重叠率 的计算公式为:

高边界框重叠率表明归因方法能够像人类一样很好地定位目标对象,即归因得分与人类直觉很好地一致。为了评估,我们只测试了ImageNet数据集[7]上边界框覆盖整个图像少于33%像素的图像,即 。我们在包括VGG16[34]、VGG19[34]、InceptionV3[38]和ResNet18[20]网络的四种不同网络设计上评估了每种归因方法的边界框准确性。

图5(b)显示了所提出原则与边界框重叠率之间的关系。x轴表示特定归因方法是否满足所有提出的原则,y轴表示归因方法相应的边界框重叠率。图5(b)表明,平均而言,满足所提出的三条原则的归因方法也与人类直觉很好地一致,因为它们具有相对较高的边界框重叠率。我们还观察到,一些很好地符合人类直觉的归因方法并不总是满足所有提出的原则。这并不奇怪,因为没有证据表明DNN以与人类直觉相同的方式编码推理逻辑。

V. 结论与讨论

在本研究中,我们提出了泰勒交互效应作为一种统一视角,用以解释十四种归因方法的共同机制。具体来说,我们证明了每种方法估计的归因分数都可以重新表述为泰勒独立效应和泰勒交互效应的特定重新分配。此外,从统一视角出发,我们提出了三个原则,用于评估忠实的归因,并使用它们来评估这十四种归因方法。

尽管提出的泰勒交互系统通常用于统一各种事后归因方法,但仍有一些归因方法不能统一到该系统中。

事后归因必须具有明确的解析公式。否则,事后方法很难统一到所提出的系统中。例如,引导特征反演方法[11],其归因结果是由优化非凸目标函数产生的,因此缺乏独特且明确的解析公式,不能统一到所提出的系统中。困难在于我们的核心理论证明旨在证明先前论文中提出的原始归因与本文中重新表述的归因之间的等价性。如果原始归因缺乏明确的解析公式,证明这种等价性变得不可行。

事后归因应以一个n维数值向量的形式呈现,其中每个维度反映了特定输入变量的标量重要性得分。否则,事后方法很难统一到所提出的系统中。例如,有意义的扰动方法[15],其归因结果识别了输入变量中最有影响力的子集,不能统一到所提出的系统中。困难在于,所提出的系统中重新表述的归因的统一范式是一个n维数值向量,其中每个维度定义为标量泰勒交互效应的加权和。如果原始归因的形式与重新表述的归因不同,那么证明它们之间的等价性是不可行的。

声明

本文内容为论文学习收获分享,受限于知识能力,本文对原文的理解可能存在偏差,最终内容以原论文为准。本文信息旨在传播和学术交流,其内容由作者负责,不代表本号观点。文中作品文字、图片等如涉及内容、版权和其他问题,请及时与我们联系,我们将在第一时间回复并处理。

下载1:OpenCV-Contrib扩展模块中文版教程

在「小白学视觉」公众号后台回复:扩展模块中文教程,即可下载全网第一份OpenCV扩展模块教程中文版,涵盖扩展模块安装、SFM算法、立体视觉、目标跟踪、生物视觉、超分辨率处理等二十多章内容。

下载2:Python视觉实战项目52讲

在「小白学视觉」公众号后台回复:Python视觉实战项目,即可下载包括图像分割、口罩检测、车道线检测、车辆计数、添加眼线、车牌识别、字符识别、情绪检测、文本内容提取、面部识别等31个视觉实战项目,助力快速学校计算机视觉。

下载3:OpenCV实战项目20讲

在「小白学视觉」公众号后台回复:OpenCV实战项目20讲,即可下载含有20个基于OpenCV实现20个实战项目,实现OpenCV学习进阶。

交流群

欢迎加入公众号读者群一起和同行交流,目前有SLAM、三维视觉、传感器、自动驾驶、计算摄影、检测、分割、识别、医学影像、GAN、算法竞赛等微信群(以后会逐渐细分),请扫描下面微信号加群,备注:”昵称+学校/公司+研究方向“,例如:”张三 + 上海交大 + 视觉SLAM“。请按照格式备注,否则不予通过。添加成功后会根据研究方向邀请进入相关微信群。请勿在群内发送广告,否则会请出群,谢谢理解~

4008

4008

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?