Transformers in Single Object Tracking: An Experimental Survey

论文地址:https://arxiv.org/pdf/2302.11867

动机

该论文的研究动机是分析和评估最近提出的基于Transformer的单目标跟踪方法,并将它们与CNN和手工特征提取方法进行比较。此外,该研究还旨在通过实验评估这些跟踪器的跟踪鲁棒性和计算效率,并在不同的跟踪场景中测量它们的性能,以确定它们在特定情况下的优缺点。该论文的研究动机是为了提供对Transformer跟踪方法的基本原理、面临的挑战以及未来研究方向的深入了解。

贡献

本文主要介绍了基于Transformer的单目标跟踪方法,对这些方法进行了分类、分析、评估和比较,并提出了未来的研究方向。具体来说,本文介绍了Transformer的基本原理和相关知识,然后介绍了基于CNN-Transformer、One-stream One-stage fully-Transformer、Two-stream Two-stage fully-Transformer等不同架构的跟踪器,并在多个公开数据集上对它们进行了实验评估。最后,本文总结了Transformer跟踪方法的优点和缺点,提出了未来的研究方向。

1、Introduction

视觉对象跟踪 (VOT) 算法旨在估计给定视频序列中对象的状态(即空间位置和大小)。给定视频序列第一帧中目标的初始状态,这些算法跟踪剩余帧中的目标状态。单个对象 VOT 方法捕获目标序列第一帧中目标的外观特征,然后使用它来定位剩余帧中的目标。尽管 VOT 提出了许多基于外观的方法,但由于外观和姿势变化、遮挡、运动模糊、背景混乱、相似对象干扰项和变形等许多挑战,仍远未达到人类实时速度跟踪稳健性。

单目标跟踪算法可以通过多种方式进行分类和分析:

- 基于跟踪模型中使用的特征,VOT 方法可以分为手工制作和基于深度特征的跟踪器。由于分层学习的能力,基于深度特征的外观追踪器的表现明显优于基于手工制作的特征追踪器。

- 基于跟踪器如何将目标对象与其周围环境区分开来,它们可以具有区分性和生成性跟踪器。判别跟踪器将 VOT 视为二元分类任务,并将目标对象与背景分开。另一方面,大多数生成跟踪器通过搜索与每一帧中的参考模板紧密匹配的最佳候选来将 VOT 视为相似性匹配问题。

- 在最近的跟踪器中,两个分支CNN 架构,称为Siamese网络,用于相似性匹配跟踪。然而,基于连体的跟踪器的判别能力很差,因为它们只专注于学习目标对象的视觉表示以匹配相似性,而忽略了背景和目标特定信息,因此在遮挡和变形场景中表现出低性能。尽管 Transformer 和 CNN 是两种类型的人工神经网络模型,但它们在几个方面有所不同,包括它们的架构、设计原则和性能。

尽管 Transformer 和 CNN 是两种类型的人工神经网络模型,但它们在几个方面有所不同,包括它们的架构、设计原则和性能。

- CNN 和 Transformer 以不同的方式消耗图像,CNN 将图像作为像素值数组,Transformers 将图像分别消耗为补丁序列。

- 根据研究,Transformer比最先进的CNN模型更善于捕捉图像的整体信息。

- 此外,Transformer可以更好地捕获图像中的远程依赖关系,而不会牺牲计算效率。

- 另一方面,增加CNN中卷积核的大小会阻碍其学习能力。

- 研究人员还发现,Transformer 很难优化,因此比CNN模型需要更多的训练数据。

- 此外,Transformer 有更多的参数,如果没有足够的训练数据可用,这可能会导致过度拟合。

然而,一旦经过训练,Transformer 可以用比相应的CNN模型更少的计算资源产生测试输出,因为它们可以以并行的方式处理数据。在迁移学习方面,Transformer 显示了有希望的结果,并在最近几年越来越受欢迎,而CNN通常更适合于中小型数据集。总体而言,Transformer 模型正在取代计算机视觉任务中的 CNN,因为它们的注意力机制和局部和全局特征捕获能力。

在一些早期的方法中,通过将CNN和Transformer体系结构结合在一起,提出了一种混合类型的跟踪模型。如图 1 所示,这些混合类型跟踪器,称为基于 CNN-Transformer 的跟踪器,显示出更好的跟踪鲁棒性,同时保持比基于 CNN 的跟踪器的相当跟踪速度,因为它们将 Transformer 的注意力机制与 CNN 的分层学习能力相结合。

研究人员通过提出一组仅依赖于 Transformer 架构的跟踪器,在 VOT 中开始了一个新的时代。这些跟踪器被称为基于完全 Transformer 的跟踪器,由于其全局特征学习能力和信息流技术,它们比基于 CNN 和基于 CNN-Transformer 的跟踪器表现出出色的跟踪鲁棒性。

本研究的主要贡献如下:

- 对基于transformer的跟踪方法的文献进行了全面的回顾。基于非transformer的跟踪器没有包括在我们的文献综述中,因为它们已经被以前的研究覆盖了。

- 通过将最先进的跟踪器分类和分析为完全基于transformer的跟踪器、基于CNN-Transformer的跟踪器和基于CNN的跟踪器,我们在五个具有挑战性的基准数据集上进行了实验评估,然后比较了transformer在VOT中的跟踪鲁棒性。

- 使用作者提供的源代码在一个公共计算平台上评估了最新跟踪器的计算效率。

- 已经对三个基准数据集进行了跟踪属性评估,以确定最近跟踪器最具挑战性的场景。

- 基于实验结果,对基于Transformer的单目标跟踪的未来发展方向提出了建议。

2、Related Work

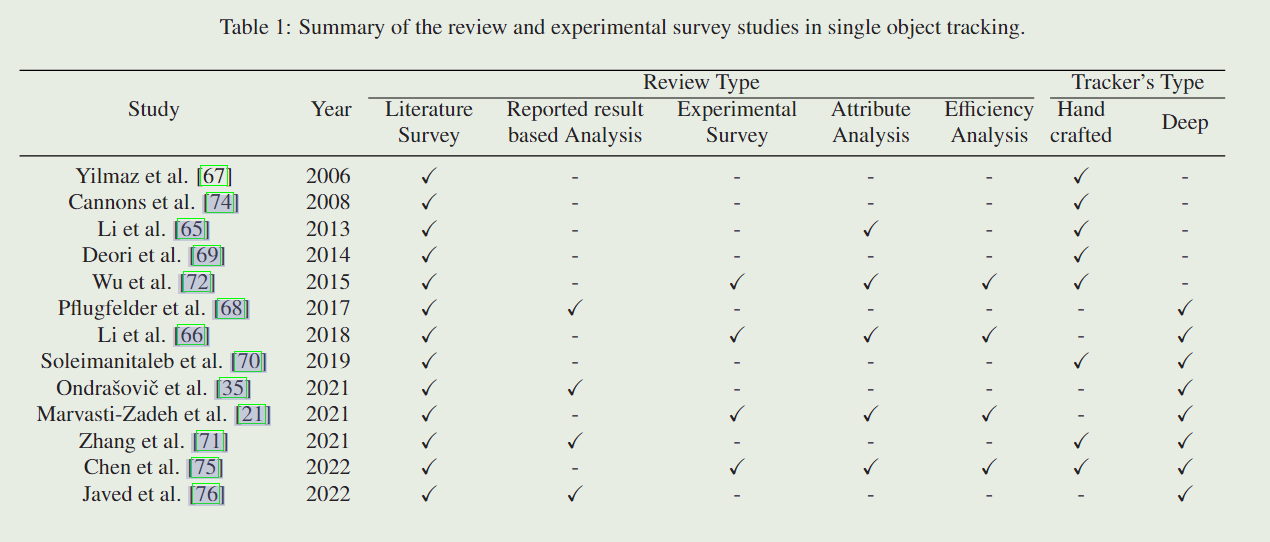

在本节中,我们证明了这项研究的必要性,尽管在过去的二十年中进行了几项实验调查和综述研究。我们在表1中总结了以前的研究,并根据它们的回顾类型和跟踪器对它们进行了分类。

从2006年到2014年,对基于手工特征的VOT方法进行了几项综述性研究。然而,在此期间没有开发基准数据集,因此使用不同的性能指标对各种视频序列进行跟踪器评估。因此,比较跟踪器的性能是一项具有挑战性的任务,因此,综述研究只侧重于进行文献调查。由于基于深度学习的跟踪器在很大程度上优于手工跟踪器,因此这些调查研究在当今时代不再有用。

在过去的九年中,与手工制作的基于特征的跟踪器相比,基于深度学习的单对象跟踪器显示出了出色的跟踪性能。然而,由于他们没有进行实验评估,他们报告的结果和比较不被认为是可接受的。此外,这些调查研究没有考虑跟踪器的效率比较,尽管这是评估的一个重要方面,因为跟踪速度与跟踪器的复杂性直接相关。尽管一些调查研究根据报告的结果比较了跟踪速度,但这种比较被认为是不可接受的,因为跟踪器的速度主要取决于测试它的GPU的效率。

在过去的两年中,与基于CNN的深度跟踪器相比基于transformer的单目标跟踪器显示出了出色的跟踪性能和效率。以往的实验调查研究没有对基于transformer的跟踪器的文献进行回顾,也没有对其优缺点进行分析,因此我们对这些跟踪器进行了详细的文献综述。然后,我们分析了它们在五个基准数据集上的性能:OTB-100、LaSOT、GOT-10k、TrackingNet和UAV123。此外,我们还根据这些跟踪器的跟踪速度、浮点运算次数(FLOPs)和跟踪模型中的参数数量,详细地比较了这些跟踪器的效率。在此基础上,讨论了基于transformer跟踪的未来发展方向。

3、Transformer

在本节中,我们介绍了Transformer和Vision Transformer(ViT)架构,因为它们构成了基于Transformer的单一物体追踪器的基础。Transformer架构基于注意机制,该机制通过使用编码器和解码器组件来实现,如图2所示。

编码器组件由N个相同的编码器层堆叠而成,解码器组件也由N个相同的解码器层堆叠而成。Transformer架构的编码器和解码器组件分别在图2的左侧和右侧进行了说明。在Transformer架构中,所有编码器层都有两个子层:一个自关注层和一个完全连接的前馈层。除了这两个子层之外,所有解码器层中间都有一个编码器-解码器注意层。Transformer架构接收作为矢量序列的输入,并使用位置嵌入算法将该序列中每个标记的位置信息添加到其表示中。嵌入之后,输入数据被送入编码器的自我注意子层,因为它有助于捕捉上下文关系。另一方面,在解码层中,使用编解码子层将注意力集中在输入数据的相关部分。

在自我注意之后,一个全连接的前馈层被用来学习注意特征的复杂表征。它有一个简单的体系结构,有两个线性变换和一个介于它们之间的非线性激活。这一层可以描述为两个核大小为1的卷积。在编码器和解码器层中,都包括了残差连接,然后是归一化层。残差连接被用来保留原始输入数据的线索,并使模型能够学习到输入数据的更准确的表示。

在解码层堆叠之后,使用线性层来产生输出向量。最后,使用Softmax层来产生输出的概率。

3.1、Self-Attention

在Transformer架构中,自我注意机制通过计算输入序列中每个元素与同一序列中所有其他元素之间的注意权重来捕捉输入标记之间的语境关系。Transformer使用“Query”、“Key”和“Value”抽象来计算输入序列的注意力。

在自我注意计算的第一步,三个不同的向量:查询向量 Q Q Q、关键向量 K K K和价值向量 V V V,是通过将输入向量 ( x ) (x) (x)与三个相应的矩阵相乘而产生的: W Q W_Q WQ, W K W_K WK,和 W V W_V WV,在训练阶段被训练过。类似地,所有输入向量被打包在一起以形成输入矩阵 X X X,然后分别生成相应的“查询”、“关键字”和“值”矩阵: Q Q Q、 K K K和 V V V。

作为自我注意的第二步,通过取

Q

Q

Q和

K

K

K的点积来计算输入

X

X

X的分数

S

S

S 如下:

S

=

Q

⋅

K

T

,

S=Q\cdot K^T,

S=Q⋅KT,

分数矩阵

S

S

S 提供了基于特定位置的输入向量应该对输入序列的其他部分给予多少关注。下一步,对分数矩阵

S

S

S进行归一化,得到更稳定的梯度如下:

S

n

=

S

/

d

k

,

S_n = S/ \sqrt{d_\mathrm{k}},

Sn=S/dk,

其中

S

n

S_n

Sn 是归一化的得分矩阵,

d

k

d_k

dk 是

k

e

y

key

key 向量的维度。然后将 SoftMax 函数应用于归一化得分矩阵,以将分数转换为概率

(

P

)

(P)

(P),如以下等式所示:

P

=

S

o

f

t

M

a

x

(

S

n

)

,

P=SoftMax(S_n),

P=SoftMax(Sn),

在自我注意的最后一步中,得到的概率

(

P

(P

(P) 与值矩阵

V

V

V 相乘,以找到自注意力输出值

(

Z

)

(Z)

(Z),如等式所示:

Z

=

P

⋅

V

,

Z = P\cdot V,

Z=P⋅V,

总之,整个自注意力机制可以统一为单个方程,如下所示:

Atention

(

Q

,

K

,

V

)

=

s

o

f

t

m

a

x

(

Q

⋅

K

T

d

k

)

⋅

V

\text{Atention}(Q,K,V)=softmax(\frac{Q\cdot K^T}{\sqrt{d_\text{k}}})\cdot V

Atention(Q,K,V)=softmax(dkQ⋅KT)⋅V

解码器层中的编码器-解码器注意子层与编码器的自我注意子层类似,只是

K

e

y

Key

Key矩阵

K

K

K和

V

a

l

u

e

Value

Value矩阵

V

V

V是从编码器块中得到的,而

Q

u

e

r

y

Query

Query矩阵

Q

Q

Q是从其上一层得到的。

3.2、Multi-Head Self-Attention

自我注意机制无法在不影响对其他同样重要的位置的注意的情况下,将注意力集中在输入的特定位置。因此,通过使用多头来提高自我关注机制的性能,这种技术被称为多头自我关注。

多头自注意力机制中使用了多组权重矩阵(

W

Q

W_Q

WQ、

W

K

W_K

WK 和

W

V

W_V

WV)。它们是随机初始化和单独训练的,因为它们用于将相同的输入数据投影到不同的子空间中。然后,在查询、键和值的每个投影版本上同时计算注意力函数以产生相应的输出值。在多头自注意力的最后阶段,将所有注意力头的输出连接起来,然后与另一个可训练的权重矩阵

W

O

W_O

WO 相乘以获得多头自注意力(

M

a

t

t

e

n

M_{atten}

Matten),如下所示:

M

a

t

t

e

n

=

C

o

n

t

a

t

(

h

e

a

d

1

,

.

.

.

,

h

e

a

d

n

)

⋅

W

O

M_{atten}=Contat(head_1,...,head_n)\cdot W_O

Matten=Contat(head1,...,headn)⋅WO

其中 $head_i $是注意力头

i

i

i 的输出。多头自注意力层用于专注于输入的不同位置并将输入表示为不同的子空间。

3.3、Vision Transformer(ViT)

基于 Transformer 在 NLP 任务中的成功,一些研究试图用于计算机视觉任务并提出了几种架构。在这些模型中,Vision Transformer (ViT)比其他具有简单架构的模型更有效,如图3所示。

在ViT的初始步骤中,输入图像 I ∈ R H × W × C I \in \mathbb{R}^{H \times W \times C} I∈RH×W×C被分成大小相等的小块,大小为 P × P P×P P×P。这里, H H H、 W W W 和 C C C 分别表示输入图像的高度、宽度和通道数。然后展平补丁以形成大小为 $(N × (P^2 · C) $的 2D 序列,其中 N N N 是从输入图像中提取的补丁数量。在ViT架构的下一阶段,补丁嵌入了位置和类信息。然后以序列方式将嵌入的补丁馈送到一组编码器层。然后得到编码器层的输出,并送入多层感知器(MLP)网络以产生特定类别的分数。ViT 的编码器层与 Transformer 架构非常相似,除了使用 GELU 非线性函数而不是 ReLU 函数。

与最先进的卷积神经网络 (CNN) 模型相比,ViT 在大型数据集上进行训练时显示出更好的结果。此外,ViT 的作者通过微调在小型和中等规模的数据集中对其进行了测试,并显示了适度的结果。在 ViT 在图像识别方面的成功之后,已经提出了几种视觉Transformer模型,它已被用于其他计算机视觉任务,例如图像分割、图像增强、图像生成、视频字幕和对象跟踪。为了减少ViT的计算复杂度,Swin Transformer在划分图像的非重叠窗口内局部执行自我注意,并引入移位窗口分区机制进行跨窗口连接。与 Vit 中的固定大小的标记不同,Swin Transformer 从小尺寸的补丁开始构建层次表示,然后逐渐将更深的 Transformer 层中的相邻补丁合并以进行多尺度预测来克服缩放问题。由于纯粹的Transformer 模型难以捕捉到本地信息,CVT在ViT架构中加入了两个基于卷积的操作,即卷积令牌嵌入和卷积投影。由于 ViT 在编码更精细的特征方面效率较低,VOLO 引入了称为 Outlooker 的轻量级注意力机制,以有效地使用更精细的信息对令牌表示进行编码。总体而言,ViT在计算机视觉领域的新时代受到了阻碍。

4、Transformer in Single Object Tracking

基于模型架构、特征提取和特征集成技术,最近的深度跟踪器可以分为三类:基于CNN的跟踪器 ,基于CNN-Transformer的跟踪器和基于完全Transformer的跟踪器。基于 CNN 的跟踪器仅依赖于 CNN 架构进行特征提取和目标检测,而基于 CNN-Transformer 的跟踪器和完全基于 Transformer 的跟踪器部分并完全依赖于 Transformer 架构。

一般来说,Transformer 架构需要大量的训练样本来训练他们的模型。由于目标在跟踪序列的第一帧中给出,因此在 VOT 中无法获得大量样本,因此所有基于全 Transformer 和基于 CNN-Transformer 的跟踪器都使用预训练网络,并将其视为主干模型。此外,其中一些跟踪器在跟踪期间更新他们的模型,其中一些没有更新。此外,其中一些跟踪器使用背景信息来跟踪目标,其中一些跟踪器没有。表 2 通过提供骨干网络、模板更新细节、训练数据集、训练方案细节以及它们是否具有背景意识的信息来总结所有基于 Transformer 和 CNNTransformer 的方法。

我们已经根据模型架构回顾了基于 CNN-Transformer 和基于全 Transformer 的跟踪器的文献。这些跟踪器可分为 "双流两阶段 "跟踪器和 "单流一阶段 "跟踪器。

在“双流两阶段”跟踪器中,使用两个相同的网络分支管道(双流)来提取目标图像和搜索图像的特征。此外,在这类跟踪器中,目标模板和搜索区域的特征提取与特征融合在两个可区分的阶段(两阶段)中完成。另一方面,在“One-Stream One-Stage”跟踪器中,使用单个网络管道,特征提取和特征融合通过单阶段一起完成。

到目前为止,所有基于 CNN-Transformer 的跟踪器都被提出为“双流两阶段”方法,而基于全 Transformer 的跟踪器可以分为“双流两阶段”和“单流单阶段”方法。图 4 显示了基于 CNNTransformer 和基于 fully-Transformer 的跟踪器的分类。

4.1、CNN-Transformer based Trackers

最近大多数基于CNN的追踪器采用了孪生网络架构,使用两个相同的卷积神经网络管道。在这些跟踪器中,通过使用两个相同的 CNN 分支来提取目标模板和搜索区域的特征。然后通过使用相关函数找到目标特征在搜索区域特征中的相似性来完成目标定位。虽然相关操作对于特征相似度匹配过程简单快捷,但捕获目标模板和搜索区域之间的非线性交互(遮挡、变形和旋转)是不够的,因此跟踪器的性能是有限的。为了成功处理这个问题,研究人员开始使用 Transformer 进行基于 CNN-Transformer 的跟踪器的特征融合过程。

与大多数基于 CNN 的跟踪器类似,基于 CNN-Transformer 的跟踪器还使用了两个类似孪生的相同网络管道。在这些管道的开始,目标模板和搜索区域的特征是用CNN提取的。然后,提取的深层特征被平铺成向量,然后被送入Transformer ,以捕捉搜索区域内目标的相似性。所有基于 CNN-Transformer 的跟踪器都使用双流两阶段方法,具有两个相同的网络管道,分别使用卷积和 Transformer 架构进行特征提取和特征融合。

Transformer Meets Tracker: Exploiting Temporal Context for Robust Visual Tracking

论文地址:https://arxiv.org/pdf/2103.11681

第一个基于CNN-Transformer 的跟踪器是由Wang等人提出的,他们将Transformer 引入生成式和辨别式跟踪范式。在他们的连体跟踪架构中,一组模板补丁和搜索区域被送入一个CNN骨干网以提取深层特征。然后,如图5所示,提取的模板特征被送入Transformer 的编码器中,利用注意力机制捕捉高质量的目标特征。同样,搜索区域的特征被送入Transformer 的解码器,通过将前几帧的信息性目标线索与搜索区域的特征聚合在一起产生解码的特征。

在TrSiam管道中,与SiamFC跟踪器类似,从编码特征中裁剪目标特征,然后与解码特征交叉相关以定位目标位置。在TrDiMP管道中,对编码特征应用端到端判别相关滤波器(DCF)生成响应映射,然后使用响应映射在搜索区域中定位目标。由于在此跟踪器中使用了Transformer,一组目标模板的线索用于定位目标,因此跟踪器能够定位具有严重外观变化的目标。

High-Performance Discriminative Tracking With Transformers

论文地址:https://arxiv.org/pdf/2203.13533v2

与TrDiMP跟踪器类似,Yu等人在VOT中引入了编码器-解码器转化器架构,他们的跟踪器被称为DTT。他们还使用了一个类似连体的跟踪框架,并使用骨干CNN架构提取了深层特征。在他们的跟踪模型中,目标模板被送入背景场景,然后Transformer架构捕捉到目标的最有辨识度的线索。由于他们的方法涉及进行跟踪,而不需要训练单独的判别模型,因此它很简单,并在基准数据集中展示了较高的跟踪速度。

Transformer tracking

论文地址:https://arxiv.org/pdf/2103.15436v1

在TransT Tracker中提出了另一个类似Siamese的架构。如图6所示,TransT追踪器有三个模块:一个CNN主干网络,一个基于Transformer的特征融合网络,以及一个预测网络。

与其他基于CNN-Transformer的跟踪器类似,目标模板和搜索区域的特征是使用ResNet50模型提取的。然后使用1×1卷积层对这些特征进行整形,并将其馈送到特征融合网络。基于Transformer的特征融合网络有 N N N个特征融合层,每一层都有一个自我背景增强模块(ECA)和一个交叉特征增强模块(CFA),分别用于增强自我注意和交叉注意。最后,将融合后的特征输入预测网络,分别采用简单的分类和回归分支进行目标定位和坐标定位。TransT跟踪器通过使用Transformer进行特征融合而不是以前的相关匹配,表现出比基于CNN的跟踪器更好的性能。

通过训练Transformer来捕获目标模板和搜索区域特征之间的相互关系,提出了几种CNN-Transformer跟踪器。TrTr跟踪器训练一个Transformer来捕获目标模板的全局信息,然后利用这些线索找到目标与搜索区域之间准确的相互关系。另一个类似的方法是由Xiuhua等人提出的,有一个模板更新机制。最近,Zhong等人提出了一种跟踪器,简称CTT,并通过在Transformer架构中加入交叉相关模块来改进目标和搜索区域特征之间的融合。CTT 跟踪器通过使用基于相关性的 Transformer 架构来避免长期跟踪的背景干扰。

Learning Spatio-Temporal Transformer for Visual Tracking

论文地址:https://arxiv.org/pdf/2103.17154

与之前提到的基于CNN-Transformer的跟踪器相比,Yan等人提出了一种基于DETR物体检测Transformer的新的VOT-Transformer架构。他们的跟踪器被称为STARK,他们训练了Transformer来捕获目标对象的空间和时间线索。ResNet用于提取初始目标模板、动态目标模板和搜索区域的深度特征。然后,如图 7 所示,这些特征被展平、连接,然后馈送到具有编码器和解码器架构的 Transformer。

STARK跟踪器的Transformer有 N N N个编码器层,每层都有一个多头自我关注模块和一个前馈网络模块。编码器捕获跟踪序列中每个元素之间的特征依赖关系,并使用全局上下文信息强化原始特征。这使得模型能够学习用于目标定位的判别特征。跟踪器的解码器学习查询嵌入,通过使用 DETR 的基于Transformer的检测方法来预测目标对象的空间位置。为了确定当前框架中目标的边界框,STARK 引入了一个基于角的预测头。此外,学习了一个分数头来控制动态模板图像的更新。由于STARK的体系结构简单,能够捕获跟踪序列的时空信息,与几种基于CNN的跟踪器相比,它具有更好的跟踪鲁棒性和良好的跟踪速度。

Transforming model prediction for tracking

论文地址:https://arxiv.org//pdf/2203.11192v1

与STARK跟踪器类似,Mayer等人通过利用DETR对象检测Transformer提出了一个跟踪器,称为ToMP。它们的特征提取和 Transformer 架构类似于 STARK 跟踪器。ToMP 跟踪器使用类似于 DiMP 跟踪器的目标定位技术,但使用 Transformer 模型替换模型预测器。根据报道的实验结果,ToMP跟踪器在跟踪性能和速度方面优于STARK跟踪器。

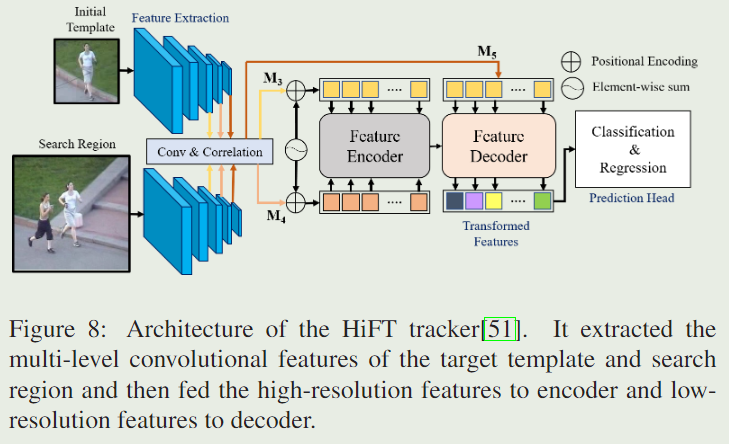

HiFT: Hierarchical Feature Transformer for Aerial Tracking

论文地址:https://arxiv.org//pdf/2108.00202v3

大多数基于 CNN-Transformer 的跟踪器从主干 CNN 架构的最后一个卷积层中获得了深度特征。与这些跟踪器不同,如图8所示,Cho等人从AlexNet模型的最后三层(3,4,5)中提取目标模板和搜索区域的多级卷积特征。

他们的跟踪器被称为HiFT,它最初是为空中跟踪提出的。在这个跟踪器中,高分辨率的交叉相关特征被输入到Transformer的编码器中,以捕捉不同尺度的目标的空间线索。同时,目标模板和搜索区域的最后一个卷积层的低分辨率交叉相关特征被送入转化器的解码器以捕获语义特征。最后,对转换后的特征应用预测头来定位目标状态。HiFT 跟踪器由于其强大的判别能力,比基于 CNN 的跟踪器表现出更好的性能。

Siamese Transformer Pyramid Networks for Real-Time UAV Tracking

论文地址:https://arxiv.org//pdf/2110.08822v1

与HiFT跟踪器类似,Xing等人通过利用主干CNN的多级卷积特征,提出了一种空中跟踪方法,称为SiamTPN。然而,他们的 Transformer 架构与 HiFT 跟踪器不同,因为它们使用 Transformer Pyramid Network (TPN) 来融合目标和搜索区域的多级特征。此外,该跟踪器的 Transformer 架构中使用了池化注意力 (PA) 层而不是多头自注意力层,以降低计算复杂度和内存负载。根据报告的结果,SiamTPN 跟踪器能够在 CPU 上以实时速度跟踪目标。

Transformer Tracking with Cyclic Shifting Window Attention

论文地址:https://arxiv.org//pdf/2205.03806v1

所有基于 CNN-transformer 的早期方法使用 CNN 主干提取目标模板和搜索区域的深度特征,然后展平它们以提供 Transformer 网络。尽管 Transformer 从扁平特征中捕获像素注意力,但来自相对像素位置的有价值的对象级线索会丢失。最近,Song等人注意到这个问题,并提出了一个多尺度循环移动窗口转换器跟踪器(CSWinTT)来解决这个问题。与其他基于 CNN-Transformer 的跟踪器类似,CSWinTT 还使用 ResNet-50 提取了目标模板和搜索区域的深度特征。此后,如图 9 所示,这些特征被分成小窗口,然后每个窗口被展平,然后馈送到 Transformer 以捕获窗口注意力。

此外,CSWinTT 的 Transformer 中使用了多头多尺度注意模块,以特定比例找到目标模板和搜索区域窗口之间的相关性。此外,在CSWinTT的窗口式注意力模块中提出了一种循环移位技术,以融合不同尺度的各注意力头的输出。尽管循环移位和窗口注意的计算成本很高,但 CSWinTT 方法显示出比其他基于 CNN-Transformer 的跟踪器出色的跟踪性能,因为它考虑了窗口级别的注意力而不是像素级别的注意力。

Unified Transformer Tracker for Object Tracking

论文地址:https://arxiv.org//pdf/2203.15175v2

Ma等人提出了第一个基于CNN-Transformer的统一跟踪器,称为UTT。这种统一的跟踪器为单目标跟踪和多目标跟踪提供了一个单一的模型架构,将单目标和多个目标一起跟踪。在这个跟踪器中,从主干 CNN 获得的目标模板和搜索区域的深度特征被馈送到 Transformer 以定位目标。在这个 UTT 方法中,通过使用 Transformer的解码器组件来提取特定于目标的特征。同样地,一个提议解码器组件被用来提取相对于目标的搜索区域特征。最后,这两个特征被馈送到Transformer以预测搜索区域中目标的坐标。实验结果表明,UTT方法通过单一的跟踪体系结构成功地处理了单目标和多目标的跟踪。

基于CNN-Transformer的跟踪器的跟踪性能主要取决于注意机制。在这些跟踪器中,利用自注意机制来丰富目标模板和搜索区域的深层特征,然后利用交叉注意机制来计算它们之间的相关性。在基于CNN-Transformer的跟踪器的交叉相关模块中,每个 query-key 对之间的相关性被独立计算,然后选择相关性最高的一对。Gao等人发现,如果一个key与一个query有很高的相关性,而该key 的邻居与该特定查询的相关性较低,那么该相关性应该是一个噪音。

AiATrack: Attention in Attention for Transformer Visual Tracking

论文地址:https://arxiv.org//pdf/2207.09603v2

基于这一发现,如图10所示,他们提出了一个注意注意注意(AiA)模块,通过在Transformer架构中包含一个内部注意模块,他们的跟踪器被称为AiATrack。

提出的AiATrack方法的内部注意模块通过搜索所有相关向量之间的一致性来提高注意,并且忽略了噪声相关性。此外,AiATrack方法引入了可学习的目标-背景嵌入,在保持上下文信息的同时将目标与背景区分开来。由于注意机制的增强,AiATrack方法成功地避开了干扰目标,从而提高了跟踪性能。

总之,基于CNN- transformer的跟踪器使用CNN主干(如ResNet或AlexNet)提取目标模板和搜索区域的深层特征。然后通过将这些深层特征馈送到Transformer中来增强并相互关联。最后,Transformer 的输出特征用于预测目标位置。基于CNN-Transformer的跟踪器成功地超越了基于Siames-like CNN的跟踪器,因为它们使用了一个可学习的Transformer,而不是线性交叉相关操作。虽然,一些早期的跟踪器借用了对象检测任务中的Transformer体系结构并在没有任何修改的情况下使用它们,但最近的方法发现了基于Transformer的跟踪问题,然后相应地修改了他们的体系结构。总体而言,基于CNN-Transformer的跟踪器显示出比基于CNN的跟踪器更好的跟踪性能。

4.2、Fully-Transformer Based Trackers

虽然,基于CNN-变换器的跟踪器利用Transformer 的注意力机制来增强特征,并对目标模板和搜索区域进行特征整合,但它们仍然依赖于卷积特征,因为它们使用骨干CNN进行特征提取。由于CNN是通过局部卷积核来捕捉特征的,基于CNN-Transformer的跟踪器不能很好地捕捉全局特征表示。最近,针对目标检测、目标分类和分割等计算机视觉任务,提出了Fully-Transformer的几种结构。这些Transformer架构并不依赖CNN的特征,因此它们能够捕捉到全局的特征表示。

Vision Transformer(VIT)是计算机视觉中第一个完全的Transformer架构。VIT用于分割图像分类,然后将图像作为16×16个图像块的序列馈送到Transformer。ViT在海量数据集上的训练优于基于CNN的图像分类器。由于ViT的巨大成功,许多后续的Transformer架构在计算机视觉中被提出。

在CPVT Transformer架构中,ViT的预定义位置嵌入方案被条件位置嵌入所取代。TNT 方法使用 Transformer-Transformer 框架进一步将 16 × 16 个图像补丁细分为 4 × 4 个子块。在TNT中使用内部Transformer块和外部Transformer块分别捕获子补丁与补丁之间的关系之间的交互。

与 CNN 类似,Swin Transformer 通过从学习小尺寸补丁的特征表示然后逐渐合并更深的 Transformer 层中的相邻补丁来捕获图像的分层表示。

CVT将两个基于卷积的操作纳入视觉Transformer 架构,用于图像分类,即卷积符号嵌入和卷积投影。

由于全 Transformer 架构在其他计算机视觉任务中的成功,研究人员开始将它们用于单对象跟踪。基于跟踪网络公式,我们将全 Transformer 跟踪器分为“双流两阶段”跟踪器和“单流单阶段”跟踪器,并在以下小节中回顾他们的文献。

4.2.1、Two-stream Two-stage Trackers

双流两阶段跟踪器有两个相同的、单独的基于Siamese-like Transformer的特征提取分支,以提取目标模板和搜索区域的特征。在特征提取之后,另一个Transformer网络被用来融合这些特征,然后预测目标位置。

Learning Tracking Representations via Dual-Branch Fully Transformer Networks

论文地址:https://arxiv.org/pdf/2112.02571

第一个完全基于transformer的“两流两级”跟踪器是由Xie等人提出的,称为DualTFR。在该跟踪器中,模板和搜索区域图像被分割为标记,然后馈送到相应的特征提取分支。DualTFR在特征提取分支中使用一组局部注意力块(LAB)来捕获小窗口内的注意力。然后将提取的特征馈送到全局注意力块(GAB)中以捕获长期依赖关系。最后,如图11所示,两个分支的输出特征被送入交叉注意力块,以计算目标模板和搜索区域之间的注意力。

由于LAB在高分辨率特征图上计算标记的小窗口内的注意力,而GAB在低分辨率特征图上计算同一张图片的所有标记之间的注意力,DualTFR跟踪器成功地实现了高精度,同时保持了高于实时的速度。

SwinTrack: A Simple and Strong Baseline for Transformer Tracking

论文地址:https://arxiv.org//pdf/2112.00995v3

Lin等人还为VOT使用了双分支全Transformer架构,称为SwinTrack。他们利用 Swin Transformer 进行特征提取,因为它在对象检测中的计算成本较低的情况下表现出更好的性能。在 Swin Transformer 中,图像和特征被划分为不重叠的窗口,然后在窗口内计算自注意力。此外,在下一层中移动窗户以保持连接。在使用Swin Transformer进行特征提取后,将模板和搜索区域的特征连接在一起,如图12所示。

然后,将串联的特征及其对应的位置嵌入反馈给Transformer编码器,以利用自注意机制来丰富它们。然后,利用交叉注意机制,使用Transformer解码块来寻找模板与搜索区域特征之间的关系。最后,通过将特征输入预测头来定位目标,预测头有一个二元分类器和一个边界盒回归模块。基于跟踪精度,SwinTrack在多个基准数据集上优于基于CNN-Transformer的跟踪器和基于CNN的跟踪器。

SparseTT: Visual Tracking with Sparse Transformers

论文地址:https://arxiv.org//pdf/2205.03776v1

虽然Transformer的自注意机制捕获远程依赖关系,但它可能无法充分捕获特定于目标的线索,使其容易受到背景杂乱的干扰。Fu等人注意到了这个问题,然后提出了一种跟踪器,称为SparseTT,通过使用备用注意力模块来提供搜索区域特征中的目标特定注意力。在该跟踪器中,Swin Transformer用于提取目标模板和搜索区域特征,然后将其提供给稀疏Transformer。稀疏Transformer的编码器块与其他Transformer架构类似。解码器块中使用了稀疏多头自注意力模块来关注前景区域。最后,增强的特征被馈送到双头预测网络以检测带有边界框坐标的目标。

总的来说,完全基于Transformer的“两流两阶段”跟踪器使用主干Transformer模型来提取目标模板的特征和搜索区域。这个主干Transformer是一个预训练模型,借鉴了对象检测任务。另一个Transformer用于融合和增强提取的期望。最后,使用一个小的预测网络来定位目标。所有“双流两阶段”跟踪器都具有简单而整洁的跟踪架构,并且比基于 CNN 的跟踪器和基于 CNN-Transformer 的跟踪器表现出更好的性能,因为它们充分利用了 Transformer 的注意力机制来跟踪目标。

4.2.2、One-stream One-stage Trackers

One-stream One-stage Tracker 具有基于完全 Transformer 的网络架构的单个管道。此外,在这些方法中,特征提取和特征融合过程是在单个阶段完成的,而不是前面提到的跟踪方法中的两个阶段。

MixFormer: End-to-End Tracking with Iterative Mixed Attention

论文地址:https://arxiv.org//pdf/2302.02814v2

最近,Cui等人发现,结合特征提取和特征融合过程对于目标跟踪很重要,因为它可以在搜索区域中提取更多的目标特异性线索,并提高相关性。基于这一事实,他们提出了一个完全基于Transformer的单流一阶段跟踪器,被称为MixFormer。如图13所示,在MixFormer跟踪器中使用了一组混合注意模块(MAM)来同时提取和整合目标模板和搜索区域的特征。

MixFormer Tracker以多个目标模板和搜索区域为输入,使用简单的基于全卷积的预测头部网络来定位目标。此外,MixFormer使用了预先训练的CVT Transformer来设计MAM模块,因为CVT在捕获图像中的局部和全局特征依赖关系方面表现出色。与CVT的自我注意机制不同,MAM在目标模板和搜索区域标记上采用双重注意机制,分别捕捉目标特定和搜索特定的线索。此外,在MAM模块中使用了非对称混合注意技术,通过消除目标区域和搜索区域的标记之间不必要的交叉注意来降低计算代价。根据已报道的结果,MixFormer在基准数据集上表现出了良好的跟踪性能。然而,MixFormer显示出较低的跟踪速度,因为MAM模块的计算效率很低。

Backbone is All Your Need: A Simplified Architecture for Visual Object Tracking

论文地址:https://arxiv.org//pdf/2203.05328v2

Chen等人提出了另一种单流一级跟踪器,称为SimTrack。如图14所示,在该跟踪器中,利用预训练好的ViT模型作为主干Transformer,将特征提取与融合相结合。

在SimTrack方法中,目标模板和搜索区域被分割成一组标记,连接起来,然后将其位置嵌入到骨干Transformer中。由于目标模板标记由于分割过程而包含一些背景区域,SimTrack采用中央凹窗口技术来准确捕获特定于目标的线索。在中央凹窗口技术中,模板图像的较小区域被裁剪,目标在中间,然后序列化成图像标记。除了目标模板和搜索区域的标记外,还将中央凹序列馈送到Transformer以捕获更多特定于目标的特性。

Joint Feature Learning and Relation Modeling for Tracking: A One-Stream Framework

论文地址:https://arxiv.org//pdf/2203.11991v4

Ye等人开发了另一种One-stream onstage方法,称为OSTrack,它也结合了使用ViT主干的特征学习和特征融合过程,如图15所示。

他们发现,搜索图像中的一些标记包含背景信息,因此没有必要在跟踪过程中包含这些标记。基于这一事实,OSTrack在一些编码层中包括了一个早期候选消除模块,用于删除包含背景信息的令牌。由于加入了候选剔除模块,提高了OSTrack的跟踪速度和精度。由于OSTrack有效地利用了目标模板特征和搜索区域之间的信息流,提取了特定于目标的鉴别线索,消除了不必要的背景特征,因此在基准数据集上表现出了良好的跟踪性能和较高的跟踪速度。

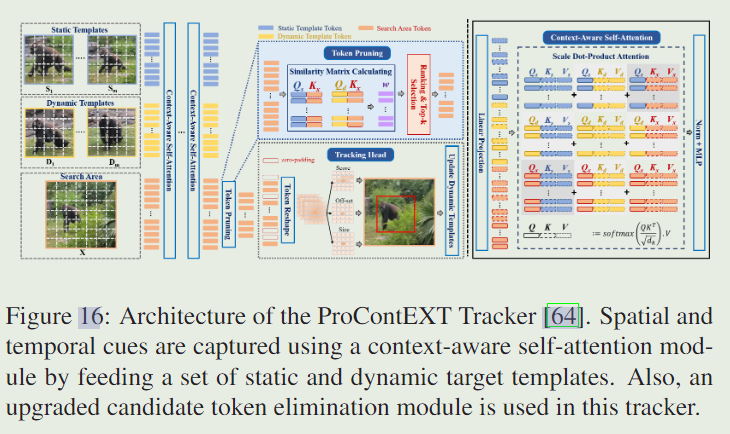

ProContEXT: Exploring Progressive Context Transformer for Tracking

论文地址:https://arxiv.org//pdf/2210.15511v4

与OSTrack类似,最近Lan等人提出了一个带有候选标记消除模块的全变换器跟踪器,他们的跟踪器被称为ProContEXT。ProContEXT跟踪器的体系结构如图16所示。

该跟踪器通过使用上下文感知的自我注意模块来捕捉目标模板的空间和时间线索。在该跟踪器中,静态目标模板、具有时空线索的动态目标模板和搜索区域被拆分,然后被馈送到注意模块。ProContEXT的候选标记消除模块比OSTrack效果更好,因为它在背景标记消除中包含了时间线索。根据报告的结果,ProContEXT 方法优于 OSTrack,并在跟踪基准测试中展示了最先进的性能。

总之,单流流单阶段跟踪器使用全 Transformer 架构将特征学习和特征融合过程结合起来。在这些跟踪器中,目标模板和搜索区域图像被拆分为标记并与它们的位置嵌入连接,然后馈送到 Transformer。由于这些跟踪器使用单个 Transformer 网络提取特征,因此可以有效地集成模板标记和搜索区域的特征,从而识别出更具辨别力的特征并消除不必要的特征。基于这些事实,与其他类型的跟踪器相比,完全基于Transformer的单流、单阶段跟踪器在所有基准数据集上都表现出了出色的性能。

1786

1786

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?