模型论文:https://arxiv.org/pdf/2309.07597

模型数据:https://data.baai.ac.cn/details/BAAI-MTP

BGE的embedding模型是一个表征模型,对pair对文本分别建模成向量,再通过余弦相似度得到向量之间相似度。表征模型适合在离线场景构建索引。

相对的,Reranker模型是交互型模型,将pair对文本共同作为模型输入直接得到相似度,文本之间可以得到更好的特征交互,效果更显著。

向量模型

训练数据

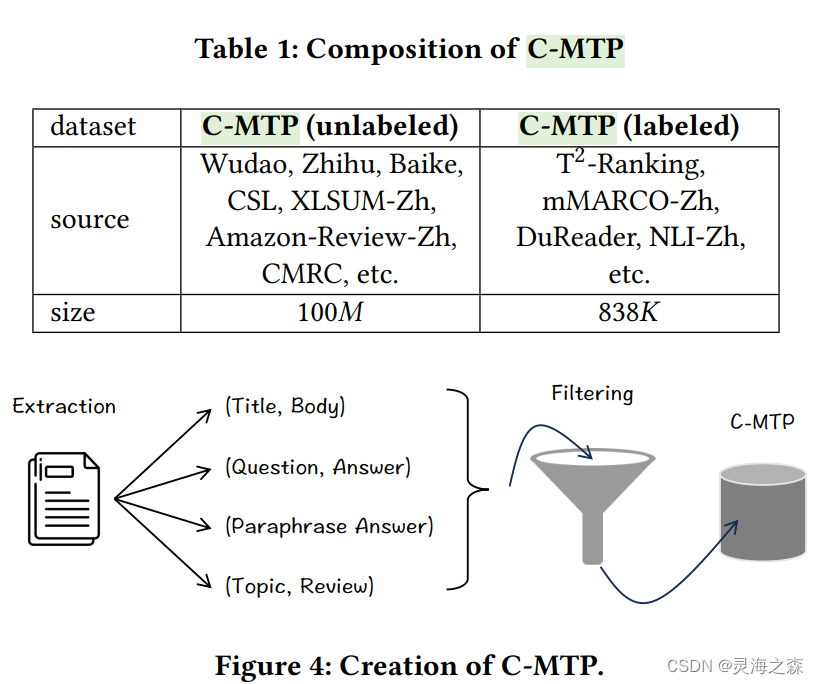

由无标签数据和有标签数据组成。

无标签数据使用了悟道等数据集,有标签数据使用了dureader等数据集。

都是文本对,对于无标签数据还使用Text2Vec-Chinese过滤掉得分低于0.43的pair。

有标签数据直接来自于下游任务的标注数据集,包括DuReader、mMARCO、NLI-Zh等,涵盖retrieval、ranking、similarity comparison等任务。

模型训练

BGE是一个类BERT的模型。

BGE是一个类BERT的模型。

是一个三阶段的训练过程。

1.Pre-Training

使用纯文本的悟道语料,不是文本对。目的是得到更强大的表征能力。做法是采用RetroMAE的训练策略:先对text X进行随机Mask,然后进行encoding,再额外训练一个light-weight decoder(如单层transformer)进行重构。通过这一过程,强迫encoder学习到良好的embedding。作者认为,解码器结构简单,只有单层transformer,而且输入句子的掩码率很高,会使得解码变得具有挑战性,可以迫使生成高质量的句子嵌入,以便可以以良好的保真度恢复原始输入。

2.general-purpose fine-tuning

预训练模型通过对 C-MTP(无标签)进行对比学习进行微调,以区分配对文本与其负样本。

对比学习的一个关键因素是负样本。没有特意挖掘难负样本,而是纯粹依赖批内负样本,并借助大批次(高达 19,200)来提高嵌入的区分性。

3.Task-specific fine-tuning

BGE适合各种类型的任务,如检索、摘要等等。它们包含的任务类型各异,可能会相互影响。

为了将通用的也能在各类任务中有优异表现,采用了以下两个方法:

- 基于指令的微调: 输入数据会被区分,以帮助模型适应不同任务。对于每个文本对 (p,

q),会在查询侧附加一个特定任务的指令。指令是一个言语提示,明确了任务的性质,例如“为这个句子生成表示以用于检索相关文章:”。 - 负样本更新:除了批内负样本,每个文本对 (p, q) 还会挖掘一个难负样本 q’。难负样本从任务的原始语料库中挖掘,遵循了ANN

风格的采样策略。难负样本通常与目标文本相似,但并不匹配,从而增加了模型的训练难度,提升了模型的区分能力。

自定义微调

官方提供了挖掘难负样本的脚本,是从query召回的top2-100中随机抽取,正样本是top1。

构造好数据集后,就可以继续做特定任务上的微调了。

https://github.com/FlagOpen/FlagEmbedding/tree/master/examples/finetune

也可以使用llama_index微调,可以参考我的http://t.csdnimg.cn/EYs91

微调在 Embeding 模型和 Reranker 模型上使用同类型的数据集,并将语义相关性任务视为二分类任务。使用二分类交叉熵损失(BCE)来训练模型,使其能够在语义相关性任务中区分正负样本。

参考:

1.https://zhuanlan.zhihu.com/p/690856333

2.https://zhuanlan.zhihu.com/p/669596130

3.https://zhuanlan.zhihu.com/p/670277586

4.https://zhuanlan.zhihu.com/p/578747792

重排模型

HNSW的近似搜索引入随机性,导致Top-K结果可能包含不够相关的文档且排序不准确,因此需要重排以确保返回的K个文档按相关性正确排序。

文本片段与 query 的相似性和文本片段是否包含 query 的答案(相关性)是两回事。LLM 输入 token 是有限制,所以必须把能回答 query 问题的片段(和问题最相关)给 LLM。

检索

Embedding 也可以给出一个得分,但是这个得分描述的更多的是相似性。Embedding 本质上是一个双编码器,两个文本在模型内部没有任何信息交互。只在最后计算两个向量的余弦相似度时才进行唯一一次交互。所以 Embedding 检索只能把最相似的文本片段给你,没有能力来判断候选文本和 query 之间的相关性。但是相似又不等于相关。

排序

Rerank 本质是一个 Cross-Encoder 的模型。Cross-Encoder 能让两个文本片段一开始就在 BERT 模型各层中通过 self-attention 进行交互。它能够用 self-attention 判断出来这个 query 中的重点在于大连医科大学,而不是怎么样?。所以,如下图所示,大连医科大学怎么样?这个 query 和大连医科大学创建于 1947 年… 更相关。

cross-encoder 需要实时计算两个文本块的相关度,如果候选文本有几万条,每一条都需要和 query 一起送进 BERT 模型中算一遍,需要实时算几万次。这个成本是非常巨大的。

本文介绍了BGE模型,一种基于BERT的多阶段训练方法,利用无标签和有标签数据进行预训练和精细调优。模型通过对比学习提升区分能力,特别强调了难负样本在任务特定微调中的作用。

本文介绍了BGE模型,一种基于BERT的多阶段训练方法,利用无标签和有标签数据进行预训练和精细调优。模型通过对比学习提升区分能力,特别强调了难负样本在任务特定微调中的作用。

2691

2691

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?