前言

在推荐系统中,往往可以通过用户交互序列来动态获取用户的偏好。物品的语义信息往往随着时间和用户发生改变,因此为了更加有效的从用户动态的交互序列中抽取特征完成物品语义信息的更新,本文提出了一种针对于 next-item 推荐的框架,其主要基于序列超图完成推荐。

从图中可以看出来,用户的交互行为随着时间动态变化,而且同一物品随着用户交互行为的变化,对于其语义信息的表示也会随着变化。

该模型的主要特点如下:

- 基于动态的用户交互序列建模超图来表达短期的物品相关性,应用多种类型的卷积层来捕获超图中的多阶关系。

- 利用残差控制层来建模不同时期的连接关系来体现交互序列动态的特点。

- 在将其输入到动态用户建模的自我关注层之前,设计了一个融合层将动态项目嵌入和短期用户意图结合到每个交互的表示中。

论文链接:https://people.engr.tamu.edu/caverlee/pubs/wang20next.pdf

github:https://github.com/wangjlgz/HyperRec

1. Motivation

Items emerge and disappear frequently

作者在国外的 Etsy 测试了物品的生命周期,Etsy 是销售手工制品的最大电子商务平台之一,在图2 (a)中,作者总结了2006年至2018年 Etsy上 列出的所有商品的活动时间,即第一次购买和最后一次购买之间的时间间隔。Etsy中有超过一半的产品在不到一年的时间内处于非活跃状态(很少被人们购买或者点击)。在其他在线平台上也可以找到类似的模式。随着项目的频繁出现和消失,短期关系对于项目建模可能是至关重要的,而从长期的角度来看,项目之间的关系是不稳定的。总结一下就是作者认为,建模短期用户行为序列更加可靠,长期的行为序列将伴随大量的不可靠关系。

The popularity of items changes rapidly along time

作者检索2001年至2005年每个月在亚马逊上最畅销的商品(即排名前1%的商品)。然后计算每个月的畅销书列表与1个月、2个月、3个月、8个月、1年或更长时间后的畅销书之间的Jaccard相似性。在图2 (b)中,如图蓝线所示,连续月份之间的畅销书销量交集仅在30%左右。而且,在6个月的时间间隔后,这两份畅销书名单几乎没有重叠(与Jaccard相似性不到10%)。虽然一个物品的受欢迎程度可以反映用户群体如何看待该物品,但一段时间内的畅销书列表的变化表明,社区中物品的含义可能会随着时间的变化而变化。

The co-occurrence of items changes temporally

Goodreads 是一个用户分享他们对书籍想法的平台。每个用户都有一个条目序列,这些条目是按照时间顺序通过评级、标记或评论与用户进行交互的。作者根据时间戳(按年)分割用户交互的项目序列,并用不同年份的序列训练不同的项目嵌入模型。作者采用 word2vec 生成基于条目共现的图书嵌入(即用户因此阅读的图书)。在这些嵌入的基础上,找到了每本书在不同年份的前10位邻居。然后计算每本书的Jaccard相似邻居,通过曲线可以发现物品之间的关系是随时间变化的,而且时间差越长,变化越大。

综上所述,从长远的角度来看,物品之间的关系持续发生变化,导致物品的语义发生变化。因此,在为下一项推荐建模它们的动态模式时,利用项目之间的短期相关性具有充足的可解释性。

3. HyperRec

本文提出的模型是基于用户交互超图,在建模随着时间和用户变化的动态关系时合并短期物品相关性。换句话说就是根据用户交互序列建模超图来捕获随着时间和用户喜好变化的动态关系,然后从超图中进行信息提取得到短期物品的相关性来辅助进行物品嵌入完成推荐。

3.1 Problem Setting

设 N N N 个用户的用户集为 U = { u 1 , u 2 , … , u N } \mathbf{U}=\{u_1,u_2,\dots,u_N\} U={u1,u2,…,uN}, P P P 个物品的物品集为 I = { i 1 , i 2 , … , i P } \mathbf{I}=\{i_1,i_2,\dots,i_P\} I={i1,i2,…,iP},设置 Q Q Q 个不同的时间戳 T = { t 1 , t 2 , … , t Q } \mathbf{T}=\{t_1,t_2,\dots,t_Q\} T={t1,t2,…,tQ},每一个时间戳 t n ∈ T t_n \in \mathbf{T} tn∈T 相当于某一段短时间。对于每一个用户,设置用户交互序列表示为 L u = { ( i 1 u , t 1 u ) , ( i 2 u , t 2 u ) , … , ( i ∣ L u ∣ u , t ∣ L u ∣ u ) } \mathbf{L}^u=\{(i_1^u,t_1^u),(i_2^u,t_2^u),\dots,(i_{|\mathbf{L}^u|}^u,t_{|\mathbf{L}^u|}^u)\} Lu={(i1u,t1u),(i2u,t2u),…,(i∣Lu∣u,t∣Lu∣u)},其中 ( i n u , t n u ) (i_n^u,t_n^u) (inu,tnu) 代表在时间戳 t n u t_n^u tnu 的范围内用户 u u u 与物品 i n u i_n^u inu 产生了交互。物品嵌入初始表示为 E = [ e 1 , e 2 , … , e P ] \mathbf{E}=[\mathbf{e}_1,\mathbf{e}_2,\dots,\mathbf{e}_P] E=[e1,e2,…,eP],物品的嵌入与他们的 ID 有关,并且随着模型迭代是可训练的,但是用户的嵌入在不同的时间戳中保持不变。

next-item 推荐的目标是预测用户 u u u 在经过交互序列 L u \mathbf{L}^u Lu 后最可能产生交互的物品。

3.2 Sequential Hypergraphs

每个用户相当于一个超边,超边可以连接两个及以上个节点,图中的节点相当于物品。此外,除了超图中的直接连接外,物品之间的高阶连接也可以暗示它们的相关性。例如在图1的右侧,iPhone8 同时被用户 E 和 D 的两条超边相连接,同时对于 Apple lighting Cable 来说 iPhone8 与它是二阶连接关系。利用超图卷积网络(hypergraph convolutional network, HGCN),可以利用直接连接和高阶连接来提取物品之间的短期相关性。同时,一个物品在不同的时期不应该是离散的,因为它过去的特征可以暗示它未来的特征。例如,虽然图1中的 iPhone8 从 2017 年到 2019 年在意义上发生了根本的变化,但 2019 年的表示应该继承 iPhone8 在 2017 年表示的一些特征。

Short-term Hypergraphs

根据时间戳的不同,我们可以根据此原则对建立的超图进行若干子集的划分。可表示为

G

=

{

G

t

1

,

G

t

2

,

…

,

G

t

Q

}

\mathbf{G}=\{\mathbf{G}^{t_1},\mathbf{G}^{t_2},\dots,\mathbf{G}^{t_Q}\}

G={Gt1,Gt2,…,GtQ}。每一个超图子集满足

G

t

n

=

(

V

t

n

,

E

t

n

,

W

t

n

,

H

t

n

)

\mathbf{G}^{t_n}=(\mathcal{V^{t_n},\mathcal{E}^{t_n},\mathbf{W}^{t_n},\mathbf{H}^{t_n}})

Gtn=(Vtn,Etn,Wtn,Htn),其中权重和超图关联矩阵的建立完全基于发生在时间戳

t

n

t_n

tn 的用户物品交互历史。在本文中,超图的权重矩阵进行了限制,具体来说

W

t

n

\mathbf{W}^{t_n}

Wtn是一个由每一条超边的权重值

W

ϵ

ϵ

t

n

W_{\epsilon\epsilon}^{t_n}

Wϵϵtn 所组成的对角矩阵。作者限制每一个条超边分享相同的权重满足

W

ϵ

ϵ

t

n

=

1

,

∀

ϵ

∈

E

t

n

W_{\epsilon\epsilon}^{t_n}=1,\forall\epsilon\in\mathcal{E}^{t_n}

Wϵϵtn=1,∀ϵ∈Etn。

D

t

n

\mathbf{D}^{t_n}

Dtn 和

B

t

n

\mathbf{B}^{t_n}

Btn 分别是节点和超边的对角度矩阵,可以表述为:

D

V

V

t

n

=

∑

ϵ

=

1

∣

E

t

n

∣

W

ϵ

ϵ

t

n

H

V

ϵ

t

n

,

B

ϵ

ϵ

t

n

=

∑

i

=

1

∣

V

t

n

∣

H

i

ϵ

t

n

\mathbf{D}_{\mathcal{V}\mathcal{V}}^{t_n}=\sum_{\epsilon=1}^{|\mathcal{E^{t_n}|}}W_{\epsilon\epsilon}^{t_n}H_{\mathcal{V}\epsilon}^{t_n},\mathbf{B}_{\epsilon\epsilon}^{t_n}=\sum_{i=1}^{|\mathcal{V}^{t_n}|}H_{i\epsilon}^{t_n}

DVVtn=ϵ=1∑∣Etn∣WϵϵtnHVϵtn,Bϵϵtn=i=1∑∣Vtn∣Hiϵtn

目标是从每个短期超图中通过捕获物品相关性来提取物品语义。

Hypergraph Convolution Network (HGCN)

超图节点的初始嵌入为

X

t

n

,

0

=

[

x

1

t

n

,

0

,

x

2

t

n

,

0

,

…

,

x

∣

V

t

n

∣

t

n

,

0

]

\mathbf{X}^{t_n,0}=[\mathbf{x}_1^{t_n,0},\mathbf{x}_2^{t_n,0},\dots,\mathbf{x}_{|\mathcal{V}^{t_n}|}^{t_n,0}]

Xtn,0=[x1tn,0,x2tn,0,…,x∣Vtn∣tn,0],卷积层可以定义为:

x

i

t

n

,

1

=

τ

(

∑

v

=

1

∣

V

t

n

∣

∑

ϵ

=

1

∣

E

t

n

∣

H

i

ϵ

t

n

H

v

ϵ

t

n

W

ϵ

ϵ

t

n

x

v

t

n

,

0

P

0

)

\mathbf{x}_i^{t_n,1}=\tau(\sum_{v=1}^{|\mathcal{V}^{t_n}|}\sum_{\epsilon=1}^{|\mathcal{E}^{t_n}|}H_{i\epsilon}^{t_n}H_{v\epsilon}^{t_n}W_{\epsilon\epsilon}^{t_n}\mathbf{x}_v^{t_n,0}\mathbf{P}^0)

xitn,1=τ(v=1∑∣Vtn∣ϵ=1∑∣Etn∣HiϵtnHvϵtnWϵϵtnxvtn,0P0)

其中

τ

\tau

τ 代表非线性激活函数例如作者在实验中使用的ReLu,

P

0

\mathbf{P}^0

P0 代表第一层的可训练权重矩阵。这个卷积操作将每个超边与它连接的所有节点进行编码,然后通过聚合它所在的所有超边的信息输出每个节点的嵌入。我们可以将这个卷积过程写成矩阵形式:

X t n , 1 = τ ( H t n W t n H t n T X t n , 0 P 0 ) \mathbf{X}^{t_n,1}=\tau(\mathbf{H}^{t_n}\mathbf{W}^{t_n}{\mathbf{H}^{t_n}}^T\mathbf{X}^{t_n,0}\mathbf{P}^{0}) Xtn,1=τ(HtnWtnHtnTXtn,0P0)

为了防止叠加多个卷积层造成的数值不稳定性,需要添加对称归一化:

X

t

n

,

1

=

f

(

X

t

n

,

0

,

H

t

n

,

W

t

n

∣

P

0

)

=

τ

(

D

t

n

−

1

2

H

t

n

W

t

n

B

t

n

−

1

H

t

n

T

D

t

n

−

1

2

X

t

n

,

0

P

t

n

)

(1)

\mathbf{X}^{t_n,1}=f(\mathbf{X}^{t_n,0},\mathbf{H}^{t_n},\mathbf{W}^{t_n}|\mathbf{P}^{0})\\=\tau({\mathbf{D}^{t_n}}^{-\frac{1}{2}}\mathbf{H}^{t_n}\mathbf{W}^{t_n}{\mathbf{B}^{t_n}}^{-1}{\mathbf{H}^{t_n}}^{T}{\mathbf{D}^{t_n}}^{-\frac{1}{2}}\mathbf{X}^{t_n,0}\mathbf{P}^{t_n})\tag1{}

Xtn,1=f(Xtn,0,Htn,Wtn∣P0)=τ(Dtn−21HtnWtnBtn−1HtnTDtn−21Xtn,0Ptn)(1)

其中

f

(

⋅

)

f(\cdot)

f(⋅) 用来表示一个超图卷积层用它的单跳邻居更新每个节点的操作。可以堆叠多个卷积层来递归地聚合超图中来自高阶邻居的信息。在这种超图卷积网络(HGCN)中,

L

t

h

L^{th}

Lth 层的输出可以计算为:

X

t

n

,

L

=

f

(

X

t

n

,

(

L

−

1

)

,

H

t

n

,

W

t

n

∣

P

(

L

−

1

)

)

\mathbf{X}^{t_n,L}=f(\mathbf{X}^{t_n,(L-1)},\mathbf{H}^{t_n},\mathbf{W}^{t_n}|\mathbf{P}^{(L-1)})

Xtn,L=f(Xtn,(L−1),Htn,Wtn∣P(L−1))

X t n , L \mathbf{X}^{t_n,L} Xtn,L 从以前的层继承嵌入,以捕获超图中项目相关性的传播。而在不同的时间段,超图的拓扑结构会发生变化,导致动态的条目嵌入反映了不同时间段的短期相关性。

Residual Gating

当物品发生变化时,它们的特性在不同的时间戳之间仍然存在联系。项目的某些特性将从上一个时间段保留到下一个时间段。例如,项目可能有一些内在的特征平滑地变化或始终不变。为了将以前的剩余信息传播到现在或将来的时间戳,本文引入了一个残差门控机制,通过结合动态嵌入

t

1

,

…

,

t

n

−

1

t_1,\dots,t_{n-1}

t1,…,tn−1 的集合来生成

t

n

t_n

tn 时刻的每个节点的初始嵌入,上述过程可以表示为:

x

i

t

n

,

0

=

g

x

i

t

<

n

,

L

+

(

1

−

g

)

e

i

,

g

=

e

z

R

T

σ

(

W

R

x

i

t

<

n

,

L

)

e

z

R

T

σ

(

W

R

x

i

t

<

n

,

L

)

+

e

z

R

T

σ

(

W

R

e

i

)

\mathbf{x}_i^{t_n,0}=g\mathbf{x}_i^{t\lt n,L}+(1-g)e_i,g=\frac{e^{z^T_R\sigma(\mathbf{W}_R\mathbf{x}_i^{t \lt n,L})}}{e^{z^T_R\sigma(\mathbf{W}_R\mathbf{x}_i^{t \lt n,L})}+e^{z^T_R\sigma(\mathbf{W}_Re_i)}}

xitn,0=gxit<n,L+(1−g)ei,g=ezRTσ(WRxit<n,L)+ezRTσ(WRei)ezRTσ(WRxit<n,L)

其中 W R \mathbf{W}_R WR 和 z R \mathbf{z}_R zR 分别代表门控单元的转换矩阵和向量表示, σ ( ⋅ ) \sigma(\cdot) σ(⋅) 代表 tanh 函数。 x i t < n , L \mathbf{x}_i^{t \lt n,L} xit<n,L 代表在时间戳 t n t_n tn 之前物品 i i i 的嵌入表示。如果物品 i i i 在之前的超图中没有出现过,则不考虑之前时间戳的物品嵌入也就是忽略残差部分令 x t n , 0 = e i \mathbf{x}^{t_n,0}=\mathbf{e}_i xtn,0=ei。用门控函数计算的 g g g 用来控制将被保留的残差信息的百分比。通过这个剩余门控,按顺序连接超图。在每个时间段,每个项目都将由静态物品嵌入和过去的残差信息初始化。在此基础上,HGCN 结合短期物品相关性,生成具有表达性的动态物品嵌入。

3.3 Dynamic User Modeling

Short-term User Intent

短期用户意图可以从用户在某段时间内与之交互的所有物品中推断出来。超图包含了用户在短期内接触的所有物品。因此可以将嵌入在每个超边上的动态节点集合起来,通过以下操作来推断每个用户的短期意图:

U t n = τ ( B t n − 1 2 H t n T D t n − 1 2 X t n , L P L ) (2) \mathbf{U}^{t_n}=\tau({\mathbf{B}^{t_n}}^{-\frac{1}{2}}{\mathbf{H}^{t_n}}^T{\mathbf{D}^{t_n}}^{-\frac{1}{2}}\mathbf{X}^{t_n,L}\mathbf{P}^L)\tag{2} Utn=τ(Btn−21HtnTDtn−21Xtn,LPL)(2)

上述生成的结果满足 U t n = [ u 1 t n , u 2 t n , … , u ∣ E t n ∣ t n ] \mathbf{U}^{t_n}=[u_1^{t_n},u_2^{t_n},\dots,u_{|\mathcal{E}^{t_n}|}^{t_n}] Utn=[u1tn,u2tn,…,u∣Etn∣tn] 可以被看作是短期用户意图在 t n t_n tn 的集合。

FusionLayer

然后将动态项目嵌入和短期用户意图结合起来,以便对序列中的每个交互进行表示。融合层在

t

n

t_n

tn 上生成用户

u

u

u 和项目

i

i

i 之间交互的表示:

e

i

,

u

t

n

=

α

u

u

u

t

n

+

α

d

x

i

t

n

,

L

+

(

1

−

α

d

−

α

u

)

e

i

α

u

=

e

z

T

σ

(

W

F

u

u

t

n

)

e

z

T

σ

(

W

F

u

u

t

n

)

+

e

z

T

σ

(

W

F

x

i

t

n

,

L

)

+

e

z

T

σ

(

W

F

e

i

)

α

d

=

e

z

T

σ

(

W

F

x

i

t

n

,

L

)

e

z

T

σ

(

W

F

u

u

t

n

)

+

e

z

T

σ

(

W

F

x

i

t

n

,

L

)

+

e

z

T

σ

(

W

F

e

i

)

(3)

e_{i,u}^{t_n}=\alpha_u\mathbf{u}_u^{t_n}+\alpha_d\mathbf{x}_i^{t_n,L}+(1-\alpha_d-\alpha_u)e_i\\\alpha_u=\frac{e^{\mathbf{z}^T\sigma(\mathbf{W}_F\mathbf{u}_u^{t_n})}}{e^{\mathbf{z}^T\sigma(\mathbf{W}_F\mathbf{u}_u^{t_n})}+e^{\mathbf{z}^T\sigma(\mathbf{W}_F\mathbf{x}_i^{t_n,L})}+e^{\mathbf{z}^T\sigma(\mathbf{W}_F\mathbf{e}_i)}}\\\alpha_d=\frac{e^{\mathbf{z}^T\sigma(\mathbf{W}_F\mathbf{x}_i^{t_n,L})}}{e^{\mathbf{z}^T\sigma(\mathbf{W}_F\mathbf{u}_u^{t_n})}+e^{\mathbf{z}^T\sigma(\mathbf{W}_F\mathbf{x}_i^{t_n,L})}+e^{\mathbf{z}^T\sigma(\mathbf{W}_F\mathbf{e}_i)}}\tag{3}

ei,utn=αuuutn+αdxitn,L+(1−αd−αu)eiαu=ezTσ(WFuutn)+ezTσ(WFxitn,L)+ezTσ(WFei)ezTσ(WFuutn)αd=ezTσ(WFuutn)+ezTσ(WFxitn,L)+ezTσ(WFei)ezTσ(WFxitn,L)(3)

其中 e i \mathbf{e}_i ei 和 x i t n , L \mathbf{x}^{t_n,L}_i xitn,L 分别代表静态和动态的物品嵌入对应可参考 Residual Gating 部分的物品嵌入生成过程。 u u t n \mathbf{u}_u^{t_n} uutn 代表在时间戳 t n t_n tn 的短期用户偏好嵌入, W F \mathbf{W}_F WF 和 z \mathbf{z} z 分别代表变换矩阵和向量表示。为了避免过拟合现象,在训练期间,交互发生在与想要预测的时间戳相同的时间。也就是在生成 e i , u t n \mathbf{e}_{i,u}^{t_n} ei,utn 时喂入 u u t n − 1 \mathbf{u}_u^{t_{n-1}} uutn−1 和 x i t n − 1 , L \mathbf{x}_i^{t_{n-1},L} xitn−1,L。

Self-attention

作者采用自我注意作为基本模型来捕获交互序列中的动态模式, e i , u t n \mathbf{e}_{i,u}^{t_n} ei,utn 可以被认为是在 t n t_n tn 时间戳时用户 u u u 和物品 i i i 的交互嵌入。假设有一个用户 u u u 按时间顺序交互的项目序列 L u = { ( i 1 u , t 1 u ) , ( i 2 u , t 2 u ) , … , ( i ∣ L u ∣ u , t ∣ L u ∣ u ) } \mathbf{L}^u=\{(i_1^u,t_1^u),(i_2^u,t_2^u),\dots,(i_{|\mathbf{L}^u|}^u,t_{|\mathbf{L}^u|}^u)\} Lu={(i1u,t1u),(i2u,t2u),…,(i∣Lu∣u,t∣Lu∣u)}。为了表达第 k k k 个交互,需要将 k k k 的位置信息加入到考虑范围,也就是说利用 o k u = e i k u , u t k u + p k \mathbf{o}_k^u=\mathbf{e}_{i_k^u,u}^{t_k^u}+\mathbf{p}_k oku=eiku,utku+pk,其中 p k \mathbf{p}_k pk 代表对于该交互序列来说位置 k k k 的特征嵌入。

基于此,我们可以得到序列嵌入列表

(

o

1

u

,

o

1

u

,

…

,

o

∣

L

u

∣

u

)

(\mathbf{o}_1^u,\mathbf{o}_1^u,\dots,\mathbf{o}_{|\mathbf{L}^u|}^u)

(o1u,o1u,…,o∣Lu∣u),自我注意力被用来根据序列嵌入列表中每一项对于目标项

o

∣

L

u

∣

u

\mathbf{o}_{|\mathbf{L}^u|}^u

o∣Lu∣u 的注意力分数生成最终的嵌入,第一步是生成注意力分数,

o

j

u

\mathbf{o}_j^u

oju 对于

o

∣

L

u

∣

u

\mathbf{o}_{|\mathbf{L}^u|}^u

o∣Lu∣u 的注意力分数表示成如下形式:

a

t

t

(

o

∣

L

u

∣

u

,

o

j

u

)

=

(

W

Q

o

∣

L

u

∣

u

)

T

(

W

K

o

j

u

)

d

att(\mathbf{o}_{|\mathbf{L}^u|}^u,\mathbf{o}_j^u)=\frac{(\mathbf{W}_Q\mathbf{o}_{|\mathbf{L}^u|}^u)^T(\mathbf{W}_K\mathbf{o}_j^u)}{\sqrt{d}}

att(o∣Lu∣u,oju)=d(WQo∣Lu∣u)T(WKoju)

其中

W

Q

\mathbf{W}_Q

WQ 和

W

K

\mathbf{W}_K

WK 代表变化矩阵,

d

d

d 代表嵌入的维度,可以理解成一种归一化机制并且简化运算。最终基于注意力机制的信息传播可以表示为:

d

u

t

∣

L

u

∣

u

=

∑

j

=

1

∣

L

u

∣

a

t

t

(

o

∣

L

u

∣

u

,

o

j

u

)

(

W

V

o

j

u

)

(4)

d_u^{t_{|\mathbf{L}^u|}^u}=\sum_{j=1}^{|\mathbf{L}^u|}att(\mathbf{o}_{|\mathbf{L}^u|}^u,\mathbf{o}_j^u)(\mathbf{W}_V\mathbf{o}_j^u)\tag{4}

dut∣Lu∣u=j=1∑∣Lu∣att(o∣Lu∣u,oju)(WVoju)(4)

其中 W V \mathbf{W}_V WV 代表变换矩阵,最后 d u t ∣ L u ∣ u d_u^{t_{|\mathbf{L}^u|}^u} dut∣Lu∣u 可以代表在时间戳 t ∣ L u ∣ u t_{|\mathbf{L}^u|}^u t∣Lu∣u 经过交互列表 ∣ L u ∣ |\mathbf{L}^u| ∣Lu∣ 的当前偏好嵌入。(感觉像transformer乱入)

3.4 Preference Prediction

在预测用户对物品的偏好时,既要考虑动态物品嵌入,也要考虑静态物品嵌入,因此可以表示为:

y

‾

u

,

i

t

n

+

1

=

d

u

t

<

n

+

1

T

(

x

i

t

<

n

+

1

,

L

+

e

i

)

(5)

\overline{y}_{u,i}^{t_{n+1}}={\mathbf{d}_u^{t\lt n+1}}^T(\mathbf{x}_i^{t \lt n+1,L}+e_i)\tag{5}

yu,itn+1=dut<n+1T(xit<n+1,L+ei)(5)

其中

d

u

t

<

n

+

1

\mathbf{d}_u^{t\lt n+1}

dut<n+1 和

x

i

t

<

n

+

1

,

L

\mathbf{x}_i^{t \lt n+1,L}

xit<n+1,L 分别代表在时间戳

t

n

+

1

t_{n+1}

tn+1 之前的动态用户偏好嵌入和动态物品嵌入。损失函数选择 BPR loss,表示形式为:

L

=

∑

(

u

,

t

,

i

,

j

)

∈

C

−

l

n

δ

(

y

‾

u

,

i

t

−

y

‾

u

,

j

t

)

+

λ

∣

∣

θ

∣

∣

2

L=\sum_{(u,t,i,j)\in\mathbf{C}}-ln\delta(\overline{y}_{u,i}^t-\overline{y}_{u,j}^t)+\lambda||\theta||^2

L=(u,t,i,j)∈C∑−lnδ(yu,it−yu,jt)+λ∣∣θ∣∣2

其中

∣

∣

θ

∣

∣

2

||\theta||^2

∣∣θ∣∣2 代表 L2正则化,

λ

\lambda

λ 代表正则化权重,

δ

\delta

δ 在实验中代表 Sigmoid 函数。每个元素

(

u

,

t

,

i

,

j

)

(u,t,i,j)

(u,t,i,j) 在训练集

C

\mathbf{C}

C 代表真实三元组

(

u

,

t

,

i

)

(u,t,i)

(u,t,i) (用户

u

u

u 和物品

i

i

i 在时间戳

t

t

t 产生真实交互) 和 没有产生真实交互的负样本

(

u

,

t

,

j

)

(u,t,j)

(u,t,j) 。

4. Experiments

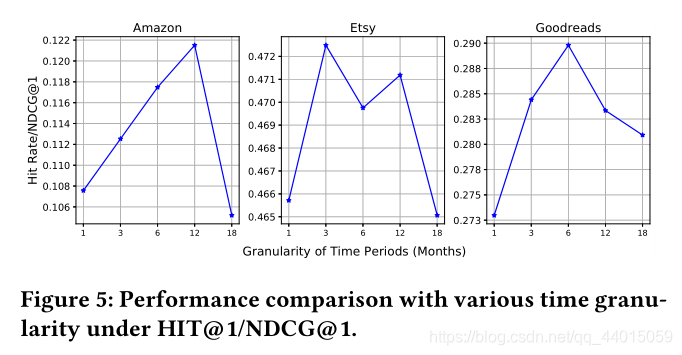

HyperRec是一种针对next-item推荐的框架,利用用户交互序列构建超图来捕捉物品的动态相关性。模型通过超图卷积网络捕获短期物品关系,残差门控机制保留物品特性,动态用户建模结合自我关注层揭示交互序列动态模式。实验表明,该模型在捕获物品语义变化和用户偏好方面表现出优越性能。

HyperRec是一种针对next-item推荐的框架,利用用户交互序列构建超图来捕捉物品的动态相关性。模型通过超图卷积网络捕获短期物品关系,残差门控机制保留物品特性,动态用户建模结合自我关注层揭示交互序列动态模式。实验表明,该模型在捕获物品语义变化和用户偏好方面表现出优越性能。

852

852

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?