Dual Graph Convolutional Networks for Graph-Based Semi-Supervised Classification

Introduction

这篇文章的主要思想,是基于半监督学习的两个基本假设:

- (1)局部一致性:距离比较近的数据,通常有相同的标签;

- (2)全局一致性:处在相似的上下文中的数据,通常有相同的标签。如下图所示,该图卷积网络包括两个通路, C o n v A ConvA ConvA嵌入了半监督分类局部一致性的信息,是一个传统的图卷积过程; C o n v P ConvP ConvP 嵌入了半监督分类全局一致性的信息,是作者的一个创新点。在两个通路后,作者设计了一个新的 L o s s Loss Loss 函数,可以将局部一致性和全局一致性完美结合,取得一个好的实验效果。

Local Consistency Convolution: C o n v A ConvA ConvA

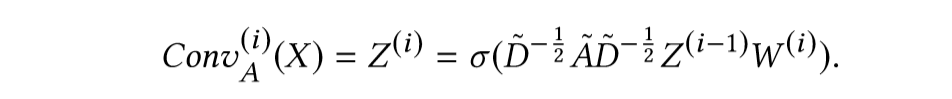

c o n v A convA convA 的计算公式如下:

- A ~ = A + I N \tilde{A} = A + I_N A~=A+IN 是无向图 G G G的自环邻接矩阵。

- I N I_N IN是单位矩阵。

- D ~ i i = ∑ j A ~ i j \tilde{D}_{ii} = \sum_j \tilde{A}_{ij} D

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

2631

2631

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?