残差网络

非常非常深的神经网络是很难训练的,因为存在梯度消失和梯度爆炸问题。跳跃连接能够有效的解决这一问题,可以从某一层网络层获取激活,然后迅速反馈给另外一层,甚至是神经网络的更深层。

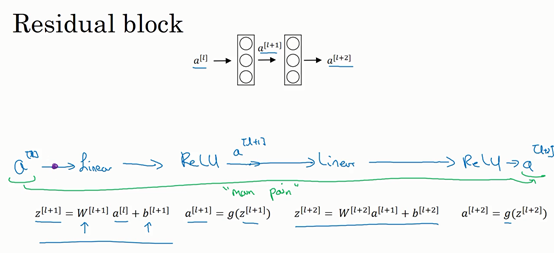

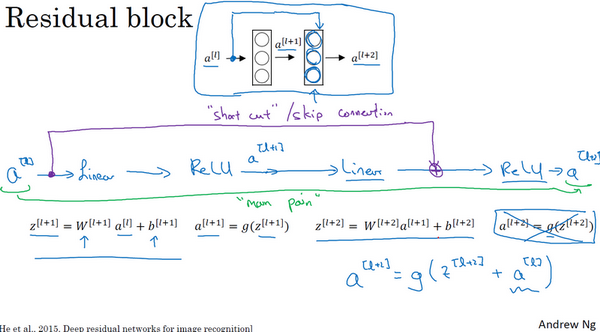

残差块

在一般情况下,a[l]输入到神经网络后得到输出a[l+2]的过程如上图,将a[l]拷贝到最后一个linear之后,Relu之前,此路径成为捷径。

a[l]跳过一层或者好几层,从而将信息传递到神经网络的更深层,成为捷径或跳跃连接

ResNet

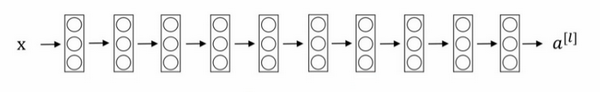

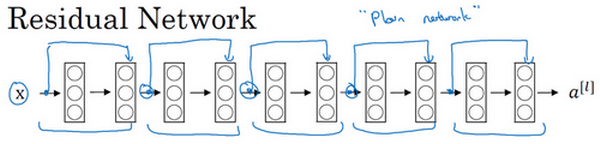

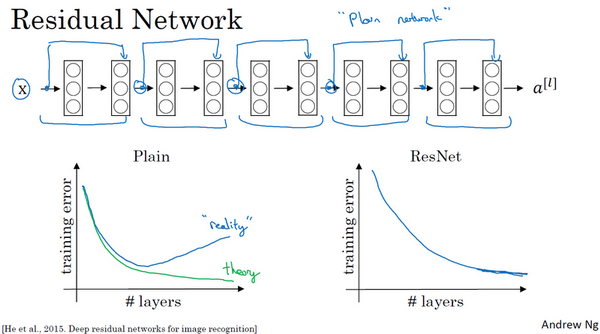

首先我们看一个普通网络(Plain network),这个术语来自ResNet论文。

把它变成ResNet的方法是加上所有跳跃连接,正如前一张幻灯片中看到的,每两层增加一个捷径,构成一个残差块。如图所示,5个残差块连接在一起构成一个残差网络。

如果我们使用标准优化算法训练一个普通网络,比如说梯度下降法,或者其它热门的优化算法。如果没有残差,没有这些捷径或者跳跃连接,凭经验你会发现随着网络深度的加深,训练错误会先减少,然后增多。

ResNet即使网络再深,训练的表现却不错

为什么残差网络会有用?

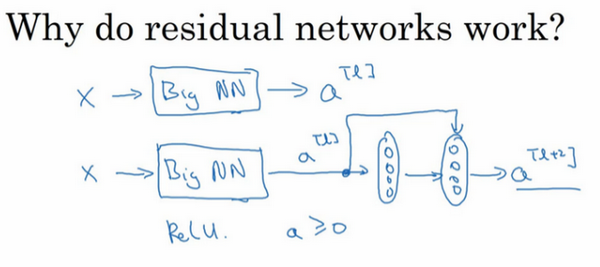

一个网络深度越深,它在训练集上训练的效率就会有所减弱。假设有一个大型神经网络,其输入X,经过一个很大的神经网络BIGNN得到输出a[l],增加深度后:

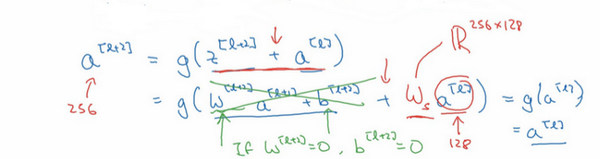

权重w和偏差b都取0的时候,结果表明,残差块学习这个恒等式函数并不难,跳跃连接得出a[l+2]=a[l],即使给神经网络增加了这两层,它的效率也并不逊色于更简单的神经网络,因为学习恒等函数对它来说很简单。

残差网络的目标不仅仅是保持网络的效率,还要提升它的效率。想象一下,如果这些隐藏层单元学到一些有用信息,那么它可能比学习恒等函数表现得更好。

假设z[l+2]与a[l]具有相同维度,所以ResNet使用了许多same卷积,所以使得a[l]的维度等于这个输出层的维度,能够添加远程连接。

7587

7587

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?