NeuroExplainer: Fine-Grained Attention Decoding to Uncover Cortical Development Patterns of Preterm Infants

摘要

除了模型的准确性外,目前的神经影像学研究还需要更多可解释的模型输出来关联大脑发育、退行性变或疾病,以发现非典型的局部改变。为此,现有方法通常以事后方式解释网络输出。然而,对于具有高维和冗余信息的神经影像数据,解释因子的端到端学习可以反向保证细粒度的可解释性,同时提高模型的准确性。同时,大多数方法只处理网格化数据,不支持基于大脑皮层表面的分析。

本文提出了一个可解释的几何深度网络,即NeuroExplainer,其应用用于揭示与早产相关的婴儿皮层发育模式的改变。

给定基本的皮层属性作为网络输入,采用分层注意力解码框架来学习球形空间中的细粒度注意力和相应的判别表示,以准确识别足月等效年龄的足月出生婴儿的早产儿。

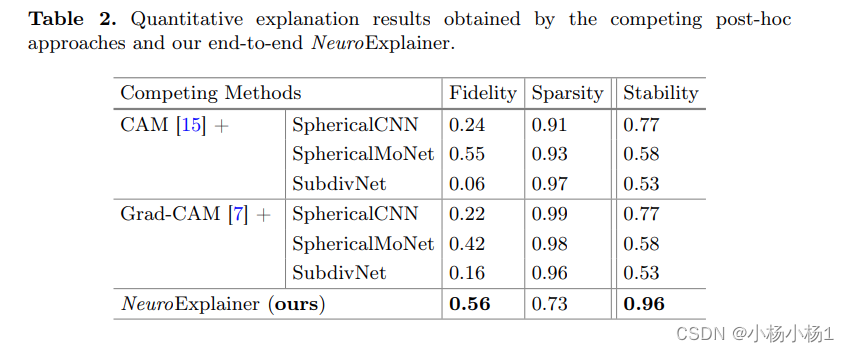

NeuroExplainer 在受试者水平弱监督下学习分层注意力解码模块,以及从有关大脑发育的领域知识中推断出的靶向正则化器。这些先验引导的约束隐式地最大化了网络训练中的解释性指标(即保真度、稀疏性和稳定性),推动学习的网络输出详细的解释和准确的分类。

代码地址

方法

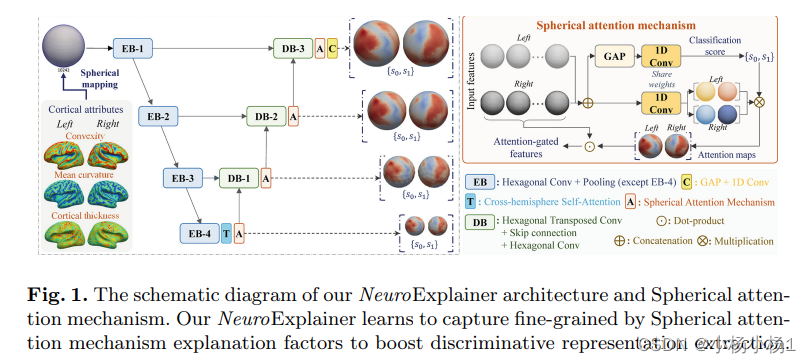

NeuroExplainer 学习通过球形注意力机制解释因素来捕捉细粒度,以促进判别性表征提取

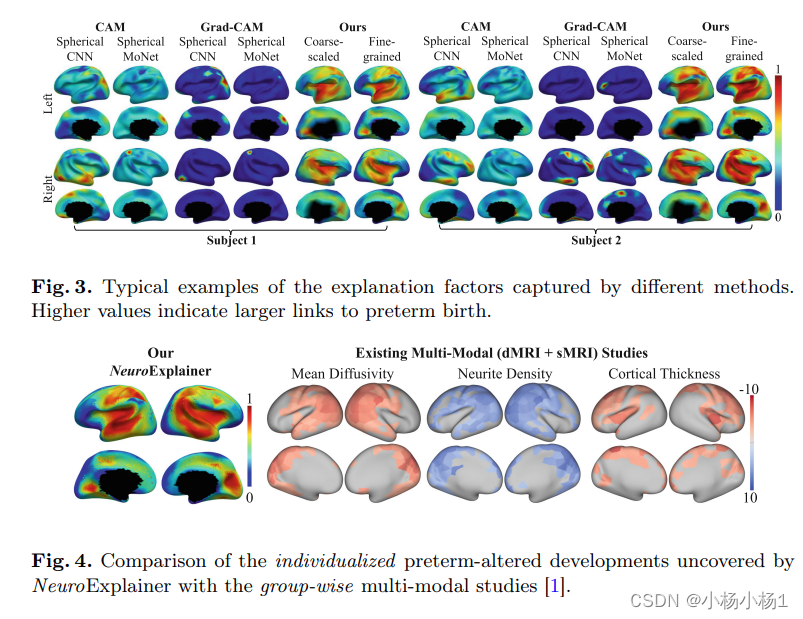

如图 1 所示, NeuroExplainer 适用于两个大脑半球(每个半球有 10242 个顶点)的高分辨率球面。输入是基本的顶点皮层属性,即厚度、平均曲率和凸度。该架构有两个主要部分,包括一个编码分支,用于在下采样的半球表面上产生与任务相关的初始注意力,以及一组注意力解码块,用于分层地将这种顶点注意力传播到更高分辨率的球体上,最终在输入的高分辨率表面上捕获细粒度的解释因子,以提升预测任务

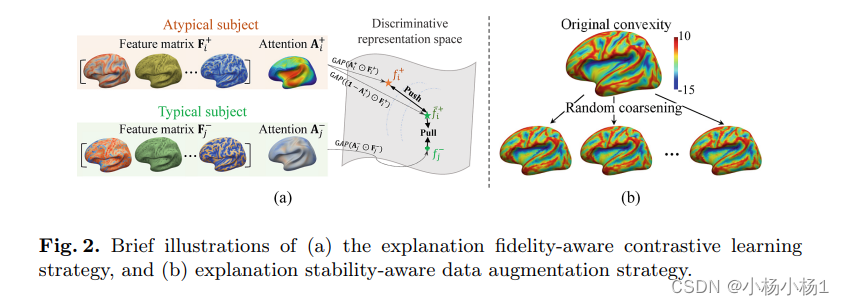

a为对比学习策略,b为数据增强策略

为了对解释因素进行以任务为导向的学习,通过考虑有关婴儿大脑发育的基本领域知识,设计了一套有针对性的正则化策略。假设婴儿期的人类大脑具有大致一致的发育,而不同组(例如早产儿和足月出生)之间的结构/功能差异通常被合理化因此,我们要求我们的 NeuroExplainer 捕获的早产改变的皮层发育模式具有区分性、空间稀疏性和鲁棒性,这表明在部署可解释的深度网络时,设计了以下约束,这些约束同时优化了保真度、稀疏性和稳定性指标

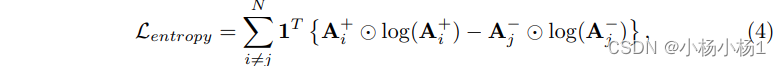

1.可解释稀疏感知正则化:公式结合图片看

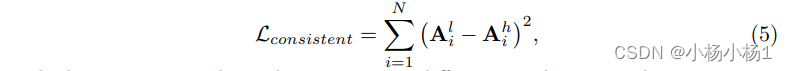

2.解释稳定性感知正则化

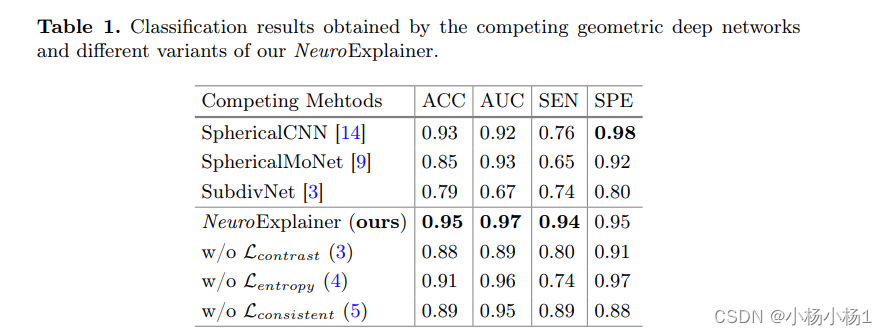

实验结果

本文介绍了一种名为NeuroExplainer的可解释几何深度网络,通过分层注意力解码捕捉早产婴儿大脑皮层发育的细微变化。该方法结合了编码分支和注意力解码块,利用领域知识引导的正则化策略提升模型的准确性与解释性。

本文介绍了一种名为NeuroExplainer的可解释几何深度网络,通过分层注意力解码捕捉早产婴儿大脑皮层发育的细微变化。该方法结合了编码分支和注意力解码块,利用领域知识引导的正则化策略提升模型的准确性与解释性。

1239

1239

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?