From Static to Dynamic: Adapting Landmark-Aware Image Models for Facial Expression Recognition in Videos

论文链接:https://arxiv.org/abs/2312.05447v1

文章目录

动机

挑战

- 与SFER相比,DFER任务在数据数量和标注质量上都存在不足

- 公开的大规模SFER数据集是野外图像,主要从互联网上抓取,DFER数据集通常是通过收集电影或电视剧中的视频来构建的。无论数据来源和质量如何差异,视频数据与图像数据相比明显不足,在SFER和DFER数据集之间的样本和受试者数量上产生了实质性差异。

- 此外,视频数据中面部表情的复杂性增加和注释者的主观性导致DFER数据集的注释模糊性高于SFER数据集,进一步加剧了这种情况。

- DFER的另一个挑战在于如何有效地建模时间维度以捕获视频中面部表情的动态特征

- 与静态图像相比,视频剪辑包含重要的时间信息。将情绪状态视为一个动态过程,个体的情绪状态会随着时间而变化。因此,准确捕捉情绪的动态变化是实现高性能DFER建模的关键。

发展历程

准确捕捉情绪的动态变化是实现高性能DFER建模的关键:

- 3D卷积神经网络

- 2D卷积神经网络与递归神经网络相结合

- CNN与Transformer架构相结合

然而,这些方法通常集中于将视频剪辑映射到类别标签,依赖于相对稀疏的监督信号,并且缺乏专门为FER域设计的显式动态捕获过程。换句话说,他们没有明确地模拟整个视频中表情面部的动态变化,从而限制了他们完全捕捉面部表情的时间动态的能力。

为了缓解上述主要挑战,应该探索可以利用先验知识,有效捕获视频中的动态情感变化并提供更可靠的监督信号的新方法,以提高DFER性能。

- CLIPER和DFER-CLIP利用非常强大的视觉语言模型CLIP的先验知识来增强DFER,取得了令人鼓舞的结果。然而,尽管同时利用了CLIP的视觉和语言知识,这些视觉语言模型仍然不如当前最先进的视觉方法MAE-DFER 。

- 图像向视频迁移

- I3D模型可以将从静态图像中学习到的视觉知识转移到视频中,从而提高下游任务的性能。然而,像I3D这样的模型需要重新训练它们的所有参数,以捕获更细粒度的时空特征(计算量大)

- 基于适应器的学习方法:可以通过仅微调参数的子集来有效地将图像模型转换为视频。然而,由于缺乏先前的面部知识,这些上游模型的一般特征和特定的FER特征之间存在显着的域差距

相关工作

- 野外动态人脸表情识别

- 第一类涉及使用**3D CNN **同时对时间和空间信息进行建模。然而,这种方法在计算上是昂贵的,并且模型可能不容易扩展到更深的架构。

- 第二种是将**2D CNN与RNN相结合,**它首先使用2D CNN从每帧中提取特征,然后使用RNN对时间信息进行建模。

- 第三个新兴的研究趋势涉及Transformer方法的利用。Former-DFER进行的研究利用基于卷积的空间Transformer和时间Transformer来实现时空融合。(进行时空融合)

- 与上述方法相比,我们的方法利用了面部标志检测和SFER数据的先验知识。

- 参数高效的迁移学习方法

- 提示学习:通常专注于同一领域的迁移学习(例如,图像到图像或视频到视频)

- 适应学习:而后者的目标通常是使图像模型适应基于视频的任务。

本文的主要贡献

- 图像级表示增强:利用在AffectNet上学习的静态特征和面部地标感知特征作为SFER和DFER任务的先验知识。通过将这两个特征与多视图互补提示器(MCP)融合,图像级表示得到显著增强

- 将静态FER模型有效地扩展为动态FER模型:时间建模适配器(TMA)模块,本文的FER模型在各种DFER基准测试中实现了SOTA性能,同时保持了极大的参数效率(仅调整整个模型的< 10%参数)

- 基于Emotion-Anchors的自蒸馏损失:在这个损失中,我们利用一组参考样本来生成更可靠的软标签,其概率分布在所有情感类别上。这种损失提供的辅助监督防止模糊的情绪标签恶化FER模型,进一步改善我们的DFER模型。

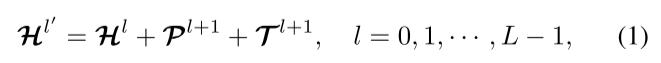

整体框架

概览

解释:将面部关键点的提示信息和时序信息结合起来更新图像信息

解释:经过transformer层得到更强的图像特征表示

图像级别的特征增强

静态面部表情特征的选择

为了利用SFER模型的图像级表示能力并获得更强大的静态面部表情特征,我们采用AffectNet作为预训练数据集。AffectNet是现有最大的SFER数据集,包含来自互联网的超过100万张人脸图像和大约45万张手动标注的图像。我们首先在AffectNet数据集上训练模型,以获得鲁棒的表情外观表示,然后在其他FER数据集上对其进行微调。

面部关键点感知特征

使用Mobile-FaceNet进行关键点检测

- 它们对关键的面部区域表现出敏感性,如嘴、鼻子和眼睛,使模型能够更多地关注与面部表情相关的局部细节。它们用于增强模型表现真实面部表情的能力。

- 此外,动态面部变化的过程(例如,肌肉运动)被隐式地编码在面部地标感知特征的序列内,这也用于增强模型捕获视频中面部表情的动态信息的能力。

引导提示生成

为了充分利用面部表情和面部标志感知功能的潜力,我们利用多视图互补提示(MCP)模块来生成引导提示。

什么是MCPs?

MCP原来叫模态互补提示器(Modality-Complementary Prompter),是在多模态对象跟踪领域中提出的。

解释:利用1×1卷积来提取

解释:以类似自注意力的方式强调与面部表情相关的细节

解释:学习到的提示

图像模型到高效视频模型的扩展

TMA(Temporal-Modeling Adapter)位于Transformer层之间,包括三个组件:

(1)Temporal Adapter(T-Adapter)

(2)LayerNorm层

(3)Vanilla Adapter

T-Adapter通过引入时间多头自注意(TMSA),专注于时间建模

转变为

转变为

- 全连接层进行下采样

- 时间多头自注意力捕获帧间关系

- 上采样为原始维度,之后reshape为N×T×D

为了增强TMA的时态信息捕获能力,减少SFER和DFER之间的域差距,我们为其配备了Vanilla适配器

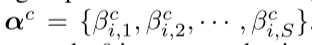

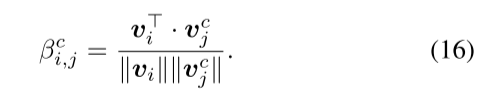

基于Emotion-Anchors的自蒸馏损失

作用:提供辅助监督信号,以防止模糊的表情标签恶化FER模型的性能

假设:大多数人工标注是可靠的,FER模型可以逐渐学习识别正确的样本

transformer最后一层的特征:

输出的概率:

解释:计算出每个样本与各个类别中其它样本的余弦相似度

解释:选择每个类别中最相近的K个样本

解释:相当于一个样本的标签的概率分布还考虑了与它相近标签的概率分布

``

``

实验

消融实验

交叉数据集评价的比较(S2D没有TMA和SDL)

AFFECTNET-SMALL从AFFECTNET-7中取样,数据大小与RAF-DB相同。结果是由SFER模型产生的(S2D没有TMA和SDL)。在AFFECTNET-7上训练的模型的表示能力更鲁棒。

为了探究这种差异是否源于数据大小或样本多样性?

答:样本的多样性。众所周知,AffectNet数据集的噪声水平高于RAF-DB数据集。

疑问:为什么只轩RAF-DB进行对比

不同预训练SFER数据的比较(S2D+SDL)

这进一步表明,AffectNet在DFER数据集上也显示出更好的泛化性能,与前面提到的来自AffectNet的静态面部表情特征的上级鲁棒性一致。因此,我们使用AffectNet-7的静态FER功能进行DFER任务。

疑问:为什么在AffectNet预训练的数据集在DFEW上提升的这么少,甚至还有下降。

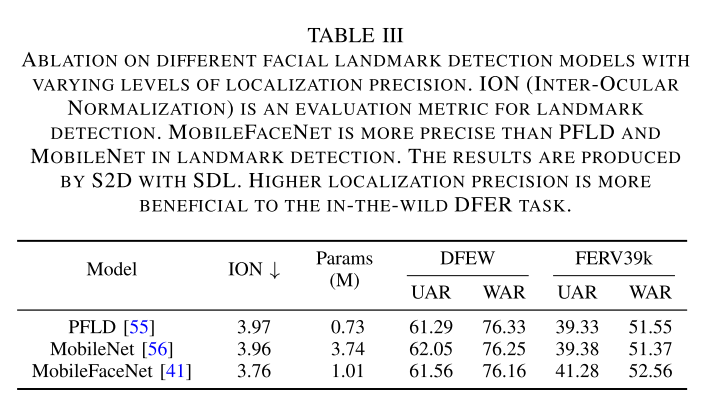

不同定位精度水平的不同面部关键点检测模型(S2D+SDL)

ION(INTER-OCULAR NORMALIZATION)是关键点检测的一个评价指标。MOBILEFACENET在关键点检测方面比PFLD和MOBILENET更精确。结果由S2D和SDL生成。更高的定位精度更有利于野外DFER任务。

多视角互补提示器的消融研究

SFER数据集上的结果是由我们的SFER模型(S2D无TMA和SDL)产生的,而DFER数据集上的结果是由我们的S2D有SDL产生的。

- None:无面部地标感知功能

- MCP:融合静态功能和关键点感知功能与多视图互补提示器

- CAP:融合静态功能和面部地标感知功能,并采用常用的拼接+投影模式。

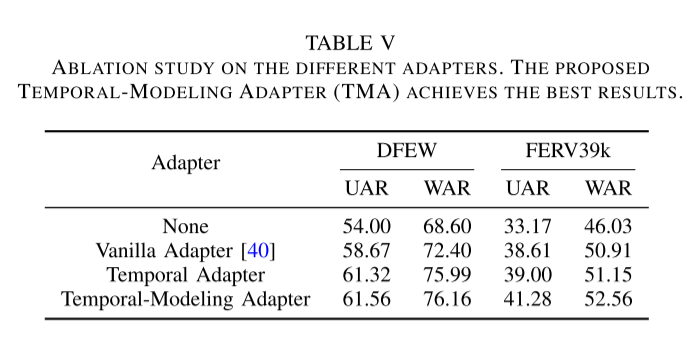

不同适配器的消融研究

所提出的时间模拟粘合剂(TMA)达到最佳效果。

SDL的可靠性

将SDL与原始的独热编码和常用的标签平滑方法进行了比较

各个组件的贡献

MCP:多视图互补提示符; TMA:时间建模administrator; SDL:基于情绪锚的自蒸馏损失。

对比实验

与RAF-DB、AFFECTNET-7、AFFECTNET-8和FERPLUS测试集上的最先进SFER方法进行比较

我们用粗体突出显示最佳结果,并在次佳结果下加下划线。在AFECTNET-8数据集上预先训练的S2 D。结果由SFER模型(不含TMA和SDL的S2 D模型)产生。我们的方法实现了可比的,甚至更好的性能比以前的国家的最先进的SFER方法。

与DFEW、FERV 39 K和MAFW上的最新技术方法的比较

- :沿每个视频样本的时间轴对两个剪辑进行同步采样,然后计算平均分数作为测试期间的最终预测。

†:采用过采样策略进行培训。

过采样策略,通过增加小目标对于损失函数的贡献,以此提升小目标检测的性能。在训练阶段对有小目标的图像进行Oversampling(过采样),来解决含有小目标的图像较少的问题,过采样简单来说就是将一张图片重复加入训练几次,这种方式十分简单,但也有效,并且实现方式也很简单只需要将含有小目标的样本多复制几遍并修改名字就行。复制的次数就是oversampleing rate(过采样率),通过控制oversampleing rate来实现大中小的样本数量均衡。

UAR:未加权平均召回; WAR:加权平均召回。

与最先进的方法在DFEW上关于每个情绪类别比较

- :沿每个视频样本的时间轴对两个剪辑进行同步采样,然后计算平均分数作为测试期间的最终预测。

†:采用过采样策略进行培训。

UAR:未加权平均召回; WAR:加权平均召回。

改进在快乐、悲伤、中性、愤怒和惊讶中尤为明显。例如,S2D在悲伤、中性和愤怒上分别超过M3DFEL 14.87%、7.43%、9.95%。与MAE-DFER相比,MAE-DFER通过自监督学习实现了无偏表示,并且在厌恶方面表现良好,由于缺乏相关的训练样本(仅占整个数据集的1.2%),监督模型在建模厌恶方面表现出偏差。为了缓解这一问题,我们额外使用过采样策略训练了S2D模型,这大大提高了次要类别,厌恶和恐惧的性能(25.52%-1.38%= 24.14%,50.22%-34.71%=15.51%),同时保持了最高的UAR和WAR指标。

可视化

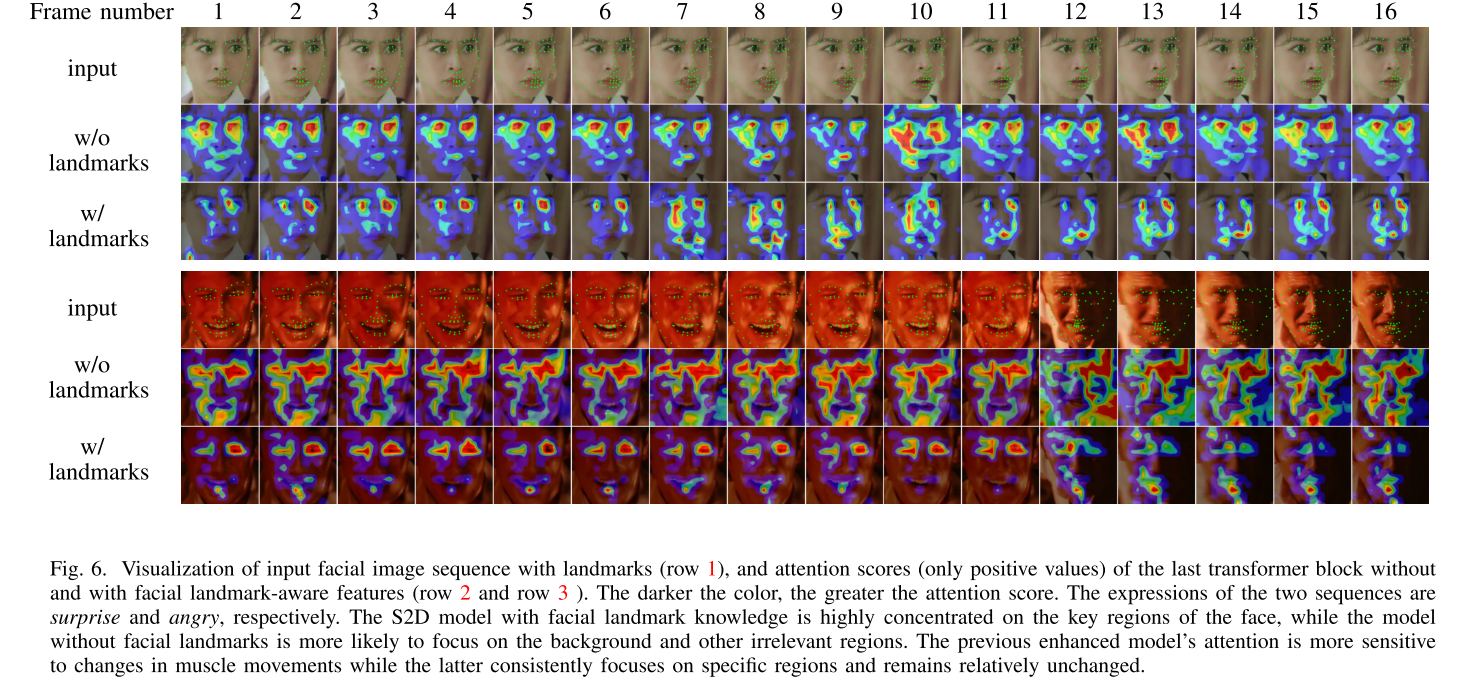

注意力可视化

为了确认S2D模型中面部地标感知特征的关键作用,我们将图6中最后一个Transformer块的注意力分数可视化。我们的观察表明**,具有面部地标知识的S2D模型的注意力高度集中在面部的关键区域**,这对FER来说信息量更大。相比之下,没有面部地标知识的模型的注意力更加分散,这表明倾向于关注背景和其他不相关的区域。

例如,在第一个序列中,第3行的第11帧表明模型的注意力主要集中在眼睛和嘴巴上,而不是第2行的第11帧中所示的其他不相关区域。这种区别在第二序列中甚至更加明显,特别是与第2行的帧2相比,第3行的帧2中。这表明,面部关键点感知的功能成功地将模型的注意力引导到情感相关的面部区域,从而有利于FER。

此外,通过检查注意力随时间的变化,我们观察到没有关键点知识的模型始终关注特定区域(例如,第一序列行2中的眼睛,以及第二序列行2中的眼睛和面部),并且保持相对不变。相比之下,具有关键点知识的模型对肌肉运动的变化表现出更高的敏感性,其注意力相应地在两个序列的第3行中转移。例如,在第一个序列中,当女人张开嘴时,模特的注意力主要集中在她的嘴唇上,随着她的嘴闭合而逐渐减少(从第6帧到第13帧)。在第二个序列中也可以观察到类似的现象,其中模型的注意力最初在第3行中从帧1到帧11集中在眼睛和嘴上,然后在帧4中在嘴上消失,逐渐减弱,最后从帧5到帧11完全消失在嘴上。这些观察结果有力地表明,我们的模型准确地捕捉了面部情绪在时间维度上的动态变化,肌肉运动隐式地编码在面部地标感知特征中。

特征分布的可视化

我们逐渐将MCP、TMA和SDL添加到基线模型中,并使用t-SNE可视化DFEW(fd 1)测试集的高级特征。图7表明,与基线模型相比,我们提出的模块显着增强了高级特征的区分性和可分离性。TMA模块的加入显着提高了高层次特征的可辨别性,表明其在捕获动态面部表情变化的DFER的有效性。与第3列相比,第4列中每个类别的特征分布更加集中,特别是对于快乐,其表现出比其他表情更明显的边界。这要归功于拟议的SDL。然而,值得注意的是,与惊讶和恐惧相对应的特征是混合的,难以区分。此外,厌恶特征是分散的,缺乏一个明确的聚类中心。这与表X中的情感特定准确度一致,并归因于可用数据集中厌恶的数据短缺。

输出概率分布的可视化

为了评估我们提出的SDL的有效性,在有和没有SDL的S2D模型的输出概率分布之间进行了比较。

如图8所示,左上角的女性表现出微妙的微笑,由于她面部肌肉的最小变化而难以辨别。没有SDL的模型给快乐和中性都分配了高分(如左侧条形图所示),边际差为0.02,表明预测是模糊的。相反,SDL增强的S2D模型分配快乐的得分比中立的高0.23(右侧条形图)。在左下角的示例中也观察到类似的现象。

在图8的右栏中,虽然愤怒和悲伤在两个人的脸上都表现得很清楚,但没有SDL的模型为愤怒和悲伤提供了类似的分数(0.43 vs. 0.46,0.37 vs. 0.35),导致错误的预测。相比之下,配备SDL的S2D以高辨别力有效区分愤怒和悲伤。SDL提供的软标签具有较少的模糊性,有助于降低模型的不确定性。因此,结合了SDL的模型对模糊表情(例如,微笑和中性),没有SDL的模型很难区分某些模糊的样本(例如,图8中的示例)。

总结

在本文中,我们提出了一个简单而强大的框架,S2D,它适应了一个关键点感知的图像模型,用于视频中的面部表情识别。本研究表明可以利用来自SFER数据和面部界标检测的先验知识来增强DFER性能。这项工作中采用的多视图互补提示器(MCP)有效地利用了在AffectNet数据集上学习的静态面部表情特征和来自MobileFaceNet 的面部地标感知特征。此外,S2D加入时间建模适配器(TMA)从静态表情识别拓展到动态表情识别,并采用了自蒸馏损失(SDL)。在广泛使用的基准测试上的实验结果一致表明,S2D实现了与以前最先进的方法相当的性能,证明了我们的模型能够学习SFER的鲁棒图像级表示和DFER的强大动态面部表示。最后,与以前的自监督方法相比,S2D对于DFER更有效,更实用,只有9M个可调参数。我们相信它将作为一个坚实的基线,并有助于相关研究。在未来,我们将探索更有效的方法来利用SFER模型中的先验面部知识和其他潜在知识来提高DFER性能。

本文介绍了一种名为S2D的方法,通过结合静态面部表情特征、关键点感知和时间建模,有效提升视频中面部表情识别的性能。文章详细阐述了模型结构、自蒸馏损失的应用以及实验结果,表明S2D在DFER任务上表现出色且参数效率高。

本文介绍了一种名为S2D的方法,通过结合静态面部表情特征、关键点感知和时间建模,有效提升视频中面部表情识别的性能。文章详细阐述了模型结构、自蒸馏损失的应用以及实验结果,表明S2D在DFER任务上表现出色且参数效率高。

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?