what?什么是机器学习

研究关于“学习算法”(一类能从数据中学习出其背后潜在规律的算法)的一门学科。

PS:假设用P来评估计算机程序在某任务类T上的性能,若一个程序通过利用经验E在T中任务上获得了性能改善,则我们就说关于T和P,该程序对E进行了学习。

基本术语

算法:学得“模型”的具体方法

模型:泛指从数据中学得的结果

示例&样本:关于⼀个事件或对象的描述。(数据集中的每条记录)

我们也把“一个示例”称为一个“特征向量”

属性&特征:反映事件或对象在某方面的表现或性质的事项。

向量中的各个维度称为特征或者属性

维数:描述示例的属性个数

样本空间&输入空间&属性空间:属性张成的空间

由于样本采⽤的是标明各个特征取值的特征向量来进⾏表示,根据线性代数的知识可知,有向量便会有向量所在的空间,因此称 表示样本的特征向量所在的空间为样本空间,通常⽤花式大写的X表示

训练数据:训练过程中使用的数据

训练样本:训练数据中的每个样本

训练集:训练样本组成的集合

标记(label):关于示例结果的信息

样例(example):拥有了标记信息的示例

(若将标记看作对象本身的一部分,则”样例“有时也称为”样本“)

标记空间&输出空间:所有标记的集合γ

分类:当标记取值为离散型时,称此类任务为分类

回归:当标记取值为连续型时,称此类任务为回归

监督学习:训练数据有标记信息

无监督学习:训练数据无标记信息

真相&假设&模型

我们已经默认样本的背后是存在某种潜在的规律,我们称这种潜在的规律为真相或者真实 ,例如样本是⼀堆好⻄⽠和坏⻄⽠时,我们默认的便是好⻄⽠和坏⻄⽠背后必然存在某种规律能将其区分开。当我们应 ⽤某个机器学习算法来学习时,产出得到的模型便是该算法所找到的它⾃⼰认为的规 律,**由于该规律通常并不⼀定就是所谓的真相,所以也将其称为假设 。**通常机器学习 算法都有可配置的参数,同⼀个机器学习算法,使⽤不同的参数配置或者不同的训练 集,训练得到的模型通常都不同。

泛化:学得模型适用于新样品(模型未见示例)的能力

分布:此处的分布指的是概率论中的概率分布,通常假设样本空间服从⼀个未知分布D,而我们收集到的每个样本都是独⽴地从该分布中采样得到,即独立同分布 。通常收集到的样本越多,越能从样本中反推出D的信息,即越接近真相

假设空间和版本空间

归纳与演绎

归纳:特殊到一般的泛化过程

演绎:一般到特殊的特化过程

归纳学习

从样例中学习显然是一个归纳的过程,亦称为“归纳学习”

广义:大体相当于从样例中学习

狭义:要求从训练数据中学得概念(concept),亦称为”概念学习“或“概念形成”。

假设空间和版本空间

假设空间(Hypothesis Space): 假设空间是指机器学习算法或模型所能够表示的所有可能解决问题的函数集合。它包含了所有可能的模型参数、参数组合,或者函数形式,用来对数据进行拟合或进行预测。不同的算法或模型会有不同的假设空间。例如,在线性回归中,假设空间包含了所有可能的线性函数;在神经网络中,假设空间包含了各种神经元连接和层次组合的网络结构。

版本空间(Version Space): 版本空间是指在机器学习中,由训练数据所定义的所有可能假设的集合。它是一个假设空间的子集,其中的每个假设都与训练数据一致。版本空间是一种对模型的不确定性的表示,它包含了多个假设,可能都能够很好地解释训练数据,但在未见过的数据上可能表现不同。版本空间可以帮助我们理解模型的泛化能力和不确定性。

总结:

假设空间是模型能够表示的所有可能解决问题的函数集合,它决定了模型的表达能力。

版本空间是在给定训练数据下,与训练数据一致的假设集合,它反映了模型在训练数据上的不确定性。

在学习过程中,机器学习算法会试图从假设空间中找到最好的假设,即能够在训练数据上表现良好并具有较强泛化能力的假设,从而实现对未知数据的准确预测。

归纳偏好

归纳偏好(Inductive Bias):是指在机器学习算法中对可能的假设进行选择的一种倾向或偏好。它是算法开发者或设计者事先对问题的某些方面进行假设的结果,以帮助算法在假设空间中进行搜索并选择适当的模型。它有助于缩小假设空间并使算法能够更快地找到合适的解决方案。归纳偏好可以是根据问题的特点、数据分布、领域知识、算法设计等方面的选择,以指导算法在学习过程中偏向某些假设,而不是盲目地搜索所有可能的假设。

奥卡姆剃刀

若有多个假设与观察一致,则选最简单的那个

奥卡姆剃刀是一种常用的、自然科学研究中最基本的原则

没有免费的午餐(No Free Lunch Theorem)

在考虑所有可能的问题和任务的情况下,所有优化算法或学习算法的平均性能是相同的。

NFL定理最重要的寓意,是让我们清楚的认识到,脱离具体问题,空泛的谈论“什么学习算法更好”毫无意义,因为若考虑所欲潜在的问题,则所有的学习算法都一样,要谈论算法的相对优劣,必须要针对具体的学习问题。

数据决定模型的上限,⽽算法则是让模型⽆限逼近上限

数据决定上限:从数据量的角度来说,通常数据量越⼤模型效果越好,因为数据量⼤即表示累计的经验多,因此 模型学习到的经验也多,自然表现效果越好。

从特征⼯程的⻆度来说,通 常对特征数值化越合理,特征收集越全越细致,模型效果通常越好,因为此时模型更易 学得样本之间潜在的规律。

算法则是让模型⽆限逼近上限:是指当数据相关的⼯作已准备充分时,接下来便可⽤各 种可适⽤的算法从数据中学习其潜在的规律进⽽得到模型,不同的算法学习得到的模型 效果⾃然有⾼低之分,效果越好则越逼近上限,即逼近真相。

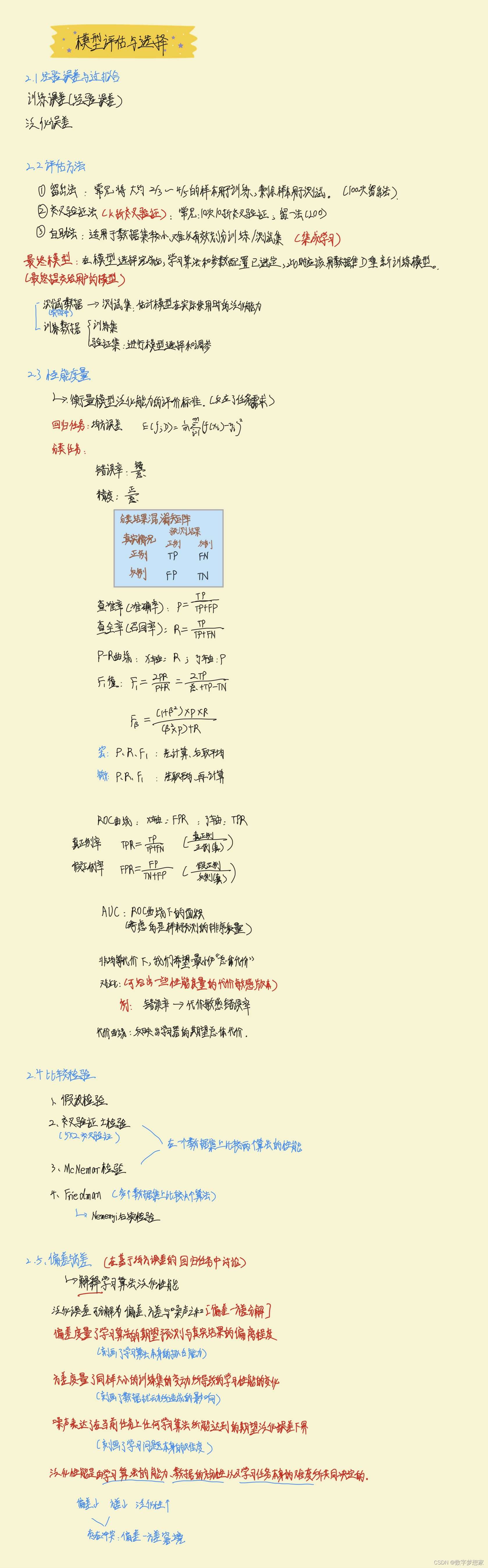

第二章(手写笔记)

827

827

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?