ABSTRACT

推荐系统通过从收集的数据中了解用户的个人偏好,提供基本的网络服务。然而,在许多情况下,系统还需要忘记一些训练数据。从隐私的角度来看,用户希望有一个工具来从训练过的模型中消除他们的敏感数据的影响。从实用程序的角度来看,如果一个系统的实用程序被一些坏的数据损坏了,系统需要忘记这些数据来重新获得实用程序。虽然遗忘非常重要,但在现有的推荐系统中还没有得到很好的考虑。虽然有一些研究对机器遗忘的问题进行了研究,但现有的方法由于不能考虑协作信息,因此不能直接应用于推荐。

在本文中,我们提出了RecEraser,一个针对推荐任务的通用和高效的机器学习框架。RecEraser的主要思想是将训练集划分为多个碎片,用这些碎片训练子模型。具体来说,为了保持数据的协作信息,我们首先设计了三种新的数据划分算法,将训练数据划分为平衡组。然后,我们进一步提出了一种自适应聚合方法来提高全局模型的效用。在三个公共基准上的实验结果表明,RecEraser不仅可以实现有效的遗忘,而且在模型效用方面优于最先进的遗忘方法。源代码可以在https://github.com/chenchongthu/Recommendation-Unlearning上找到

KEYWORDS

机器解除学习;选择性删除、推荐系统;协同过滤;

INTRODUCTION

推荐系统为用户提供个性化的服务,以缓解信息过载的问题,在电子商务[14,38]、社交媒体[8,10,16,48]、新闻门户[41]等广泛的应用中发挥着越来越重要的作用。个性化推荐系统的关键被称为协作过滤[28,31,37,42],它根据用户的历史记录(如查看、点击和评级)来学习用户的偏好。

一旦推荐系统建立起来,它就有可能记住训练数据。然而,在许多情况下,推荐系统还需要忘记某些敏感数据及其完整的血统,这在本文中被称为推荐遗忘。首先考虑隐私,最近的研究表明,用户的敏感信息可能从训练过的模型中泄露,如推荐系统[50]、大型预训练[4]和精细的自然语言模型[49]。在这种情况下,用户希望有一个工具来从训练过的模型中消除他们的敏感信息的影响。第二个原因是效用。如今,人们会逐步收集新的数据,以进一步完善现有的模型[51]。然而,不良数据(或称为脏数据),例如中毒攻击中的污染数据[33]或分布外(OOD)数据[3],将严重降低推荐的性能。一旦这些数据被识别出来,系统就需要忘记它们,以重新获得效用。此外,用户的偏好通常是动态的和可改变的[44]。例如,一个想要购买手机的用户会很高兴看到关于手机的推荐。但在购买后,她/他会在一段时间内对新手机的推荐不感兴趣。在这种情况下,用户将希望删除某些数据,以便系统能够提供更多有用的建议。

最简单的遗忘方法是在去除需要被遗忘的样本后,从原始数据中进行重新训练。.不幸的是,应用这种方法的困难在于对大规模数据的计算成本昂贵。在计算机视觉和自然语言处理[1,2,13,22,24]领域,人们一直致力于解决机器遗忘的低效问题。例如,SISA方法[1]将训练数据随机分割成几个不相交的片,然后根据每个片训练子模型。然后,通过多数投票或平均投票对子模型进行聚合,得到最终的预测结果。当一些数据样本被要求遗忘时,只需要重新训练相应的子模型。但是,现有的方法不能直接应用于推荐任务。由于推荐系统依赖于用户和项目之间的协作信息,因此将数据随机划分为碎片可能会严重损害推荐性能。此外,现有的学习方法中的聚合部分通常为每个子模型分配一个静态权重。虽然最近的方法GraphEraser[13]使用了一种基于学习的方法来分配权重,但在预测不同的用户-项目交互时,权重不能自适应地改变。针对现有解决方案的上述问题,在本工作中,我们提出了一种新的高效的可擦推荐框架,即RecEraser,,在保持高推荐性能的同时实现高效的遗忘。RecEraser的一般思想是将训练集划分为多个碎片,并为每个碎片训练一个子模型。为了保持数据的协作信息,我们分别根据用户、项目和交互的相似性设计了三种数据划分策略。与传统的社区检测和聚类方法[15,23,34]不同,我们的数据划分策略是为了实现平衡划分,使学习效率不受不平衡碎片大小的影响。此外,考虑到推荐系统通常面临着不同的用户和项目,子模型对预测不同的用户-项目对应该有不同的贡献。为了进一步提高推荐性能,我们提出了一种基于注意力的自适应聚合方法。为了评估我们的方法,我们在三个真实世界的数据集上进行了广泛的实验。由于RecEraser的架构对于基本模型与模型无关,因此我们使用了三个具有代表性的推荐模型BPR [42]、WMF [11,31]和LightGCN [28]作为其基本模型。实验结果表明,它不仅可以实现有效的遗忘,而且在性能上优于SISA [1]和GraphEraser[13]等最先进的遗忘框架。进一步的消融研究也表明了我们提出的数据划分策略和自适应聚合方法的有效性。这项工作的主要贡献是:

(1)据我们所知,这是第一个解决机器遗忘问题的工作。提出了一种通用的可擦除推荐框架。

(2)设计了三种数据划分策略,将推荐数据分割成平衡的碎片,并提出了一种基于注意力的自适应聚合方法,以进一步提高了RecEraser的性能。

(3)我们在三个真实世界的数据集和三个具有代表性的推荐模型上进行了广泛的实验。结果表明,RecEraser不仅可以实现有效的遗忘,而且在推荐性能方面优于最先进的遗忘框架。

RELATED WORK

Item Recommendation

通过网飞挑战,早期的推荐方法[36,37]被设计出来,通过将用户和项目映射到矩阵分解等潜在因素空间来建模用户的显式反馈。后来,研究人员发现,用户主要通过隐性反馈与物品进行互动,比如在电子商务网站上的购买和在在线视频平台上观看视频。然后提出了一种从内隐反馈[9,12,30,31,42]中学习的大量推荐方法。具体地说,Hu等人[31]提出了一种基于非抽样的方法WMF,它假设所有未观察到的项目都是负样本。最近的一些研究也已经解决了非抽样学习的低效问题。例如,Chen等人[11]为推荐模型推导了一个灵活的非抽样损失,它实现了有效和高效的性能。在另一项研究中,Rendle等人[42]提出了一种成对学习方法BPR,这是一种基于抽样的方法,基于用户相对于项目对的相对偏好来优化模型。

由于深度学习的普及,有大量的文献利用不同的神经网络进行推荐系统。在[30]的研究中,He等人提出了一个神经协同滤波(NCF)框架,通过联合学习矩阵分解和前馈神经网络来处理隐式反馈数据。NCF框架已经被广泛扩展,以适应不同的推荐场景[27,45]。近年来,探索新提出的深度学习架构在推荐中的应用已成为一种趋势。如注意机制[7,47]、卷积神经网络[29,52]、递归神经网络[41]和图神经网络[6,19,46]等。具体来说,Wang等人[46]提出了NGCF,通过在用户-项目交互图上传播嵌入来利用高阶接近性。通过去除非线性激活函数和特征变换,将NGCF进一步扩展到LightGCN [28]。LightGCN比普通的GCN模式更有效,并在Top-𝐾推荐任务中取得了最先进的性能。

Machine Unlearning

机器遗忘1,在机器学习中也被称为选择性遗忘[24]或数据删除/删除[21,26],指的是根据训练模型的要求去除训练数据的指定子集的影响的过程。以往关于机器不学习的研究可分为两类:近似不学习和精确不学习。

(值得注意的是,遗忘的目的不同于差异隐私(DP)方法[18,20],后者旨在保护用户的隐私信息,而不是删除它们。此外,遗忘通常需要比DP更严格的保证。)

Approximate unlearning

近似遗忘为数据删除提供了统计保证,因此a.k.a统计遗忘[24,26,32]。其基本思想是放松对精确删除的要求,也就是说,它只提供了一个统计保证,即未学习的模型不能与从未在被删除的数据[26]上训练过的模型区分开来。它们通常采用基于梯度的更新策略,以快速消除要求删除[40]的样本的影响。例如,Guo等人[26]、戈拉卡等人[24]和戈拉卡等人[25]提出了不同的牛顿方法来近似凸模型的再训练,如线性回归、逻辑回归和神经网络的最后一个全连接层。另一种方法是消除需要删除的样本对所学模型的影响,这些样本是基于影响函数来学习模型的。与精确遗忘方法相比,近似遗忘方法通常更有效。然而,它们的保证是概率性的,很难应用于非凸模型,如深度神经网络。这使得它们不太适合用于推荐系统的应用,如GDPR和CCPA。

Exact unlearning

精确学习的目的是确保请求数据从学习模型中完全删除。早期的工作通常是为了加快简单模型或在某些特定条件下的精确解读[2, 5, 43],比如SVM(支持向量机)的留一交叉验证[5, 35],𝑘-均值聚类中可证明的高效数据删除[21],以及基于统计查询学习的Naïve Bayes的快速数据删除,该学习假设训练数据是按决定顺序的[2]。最近,具有代表性的工作是SISA(切割、分离、切片和聚合)[1]。SISA是一个相当通用的框架,它的关键思想可以抽象为三个步骤:

(1)将训练数据分成几个不相交的碎片;

(2)在每个数据碎片上独立训练子模型(即无需通信);

(3)将所有碎片的结果汇总,以进行最终预测。

这样,只需对受影响的子模型进行再训练,就可以有效地实现遗忘。随后,Chen等[13]将这一思想应用于改进的分片算法的图解。.我们的RecEraser与现有的方法在以下方面有所不同:

(1)我们设计了新的数据划分方法来保持数据的协作信息;

(2)我们提出了一种自适应聚合方法来提高全局模型的效用。

这些设计使我们的RecEraser更适合推荐任务。

RECOMMENDATION UNLEARNING

我们首先介绍了关键符号,然后制定了建议遗忘任务,并讨论了它与现有方法的区别和挑战。

Notations and Problem Formulation

表1描述了本文中使用的符号和关键概念。我们将用户集和项目集分别表示为U和V。用户项交互矩阵记为Y=[𝑦𝑢𝑣]∈{0,1},表示𝑢是否与项𝑣有交互。给定一个目标用户𝑢,推荐任务是推荐一个𝑢可能感兴趣的项目列表。对于Recommendation Unlearning,如果用户𝑢想要撤销对𝑣项(即𝑦𝑢𝑣)的一条记录,则推荐系统需要获得在Y\𝑦𝑢𝑣上训练的未学习模型。在形式上,recommended unlearning 的任务是实现三个总体目标。

可证明的保证:它是被遗忘的基本要求,它要求被撤销的数据必须真正被遗忘,并且不影响模型参数。

高遗忘效率:遗忘所需样本的遗忘过程应该尽可能快。

可比性性能:未学习模型的预测性能应该与从头开始的再训练的性能相当。

Challenges of Recommendation Unlearning

现有的机器解除学习方法主要设计在计算机视觉和自然语言处理领域,不能直接应用于推荐任务。例如,最先进的解除学习方法SISA [1]使用一种随机方法将训练数据划分为多个碎片。然而,推荐的输入是用户-项目交互,其中包含了丰富的协作信息。随机划分训练数据会破坏协作信息,这可能会损害推荐性能。一种很有前途的方法是使用社区检测或聚类方法[15,23,34]。然而,由于真实世界数据的底层结构,这些方法可能会导致高度不平衡的数据分区。因此,如果所需的样本属于一个较大的碎片,将会影响遗忘效率。为了解决上述问题,我们需要设计新的平衡数据分区方法,以保存用户和项目之间的协作信息。此外,现有的学习方法通常在推理阶段使用静态聚合策略,这不适用于通常面临各种用户和项目的推荐系统。虽然最近的方法GraphEraser[13]使用了一种基于学习的方法来分配权重,但在预测不同的用户-项目交互时,权重不能自适应地改变。为了进一步提高推荐解除学习框架的性能,子模型的权重应该取决于它对单个用户(或一个项目)的特征的学习能力。

RECERASER METHOD

在本节中,我们首先概述了重述框架,然后详细介绍了我们提出的模型的两个关键组成部分: 1)平衡数据分区和2)基于注意力的自适应聚合。

Overview

RecEraser的总体框架如图1所示。从图中,我们首先简单地做一个我们的方法的概述:

(1)RecEraser包括三个阶段:平衡数据分区、子模型训练和基于注意力的自适应聚合。

(2)平衡数据分割部分是为了在保留协同信息的同时对训练数据进行分割。数据被分割后,为每个碎片数据(𝑀𝑖)训练一个子模型(𝑆𝑖)。所有的子模型都共享相同的模型架构,并且可以并行地进行训练,以加快训练过程。在预测阶段,对每个个体的预测,采用基于注意力的自适应聚合策略来寻找不同子模型的最优权重。

(3) 当数据需要解除学习时,只需对其中一个子模型(其分片包含要解除学习的点)和聚合部分进行重新训练。这比从头开始重新训练整个模型要有效得多。

Balanced Data Partition

正如我们之前提到的,用于推荐任务的数据通常包含丰富的协作信息。为了保存协作信息,一种很有前途的方法是依赖于社区检测和聚类方法[15,23,34]。然而,直接应用它们可能会导致高度不平衡的数据分区。在[13]的激励下,我们提出了三种新的平衡数据分区方法,即基于用户的平衡分区(UBP)、基于项目的平衡分区(IBP)和基于交互的平衡分区(InBP)。与[13]通过所有节点嵌入的k-means来划分数据不同,我们的三种数据划分策略分别基于用户、项目和交互的相似性,这对于推荐任务更加灵活。UBP方法根据用户的相似性来划分训练数据,如算法1所示。

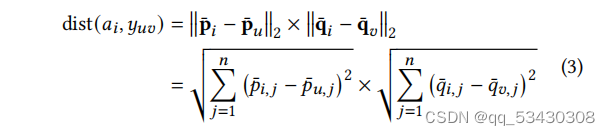

给定一个完整的用户集U,首先随机选择𝐾锚定用户作为每个子模型的中心,用a={𝑎1,𝑎2,……,𝑎𝐾}表示。对于每个锚定用户,通过估计相对于所有其他用户的距离来发现相应的碎片。 按照𝑘-means[34]的设定,本工作中采用了欧氏距离,其定义如下:

其中,¯p𝑎𝑖和¯p𝑢是锚定用户𝑎𝑖和用户𝑢的嵌入向量。嵌入向量由预先训练的模型计算(本工作使用WMF[31],但可以应用任何其他嵌入向量)。

然后,我们得到𝑚×𝐾距离得分,其中𝑚表示用户数量。这些分数按升序排序,以得到𝐸𝑠。.对于𝐸𝑠中的每个用户-锚对,如果𝑆𝑖的大小小于碎片𝑡的最大数量,则将训练交互Y𝑢分配给碎片𝑆𝑖。最后,将新的锚点计算为相应碎片中所有用户的平均值:

UBP方法重复上述步骤,直到它满足停止标准(达到最大迭代或锚点不改变)。IBP方法是基于预先训练好的项目嵌入的相似性,这与UBP相似,但变化很小。为了避免重复,我们不一步一步地引入它。

UBP和IBP分别使用用户和项目来对局部属性进行建模,这可能会忽略训练交互的全局特征(用户-项目对)。因此,我们进一步提出了一种基于交互的平衡划分方法(InBP),该方法考虑了用户-项目对的相似性来分割训练数据。如算法2所示,InBP的输入包括预先训练好的用户嵌入¯P={¯p1,¯p2,……,¯p𝑚},项目嵌入¯Q={¯q1,¯q2,……,¯q𝑛},用户项目交互Y,碎片的数量𝐾,和碎片𝑡的最大数量。

InBP与UBP的主要区别如下:

(1) InBP随机选择𝐾锚点A={𝑎1,𝑎2,…,𝑎𝐾}从用户-项交互Y中,其中𝑎𝑖=(p𝑖,q𝑖)、p𝑖和q𝑖为数据点𝑎𝑖的嵌入向量;

(2)锚点𝑎𝑖与相互作用𝑦𝑢𝑣之间的距离计算如下:

其中,¯p𝑢和q¯𝑣为数据点𝑦𝑢𝑣的预训练嵌入向量;

(3)对于𝐸𝑠中的每个交互对,如果𝑆𝑖的大小小于碎片𝑡的最大数量数,则将训练交互𝑦𝑢𝑣分配给碎片𝑆𝑖;

(4)新锚点更新如下:

Attention-based Adaptive Aggregation

在对训练数据进行分割后,在每个碎片数据𝑆𝑖上训练一个子模型𝑀𝑖。一般来说,不同的子模型对预测不同的用户-项目对应该有不同的贡献。例如,如果碎片𝑆𝑖包含了用户𝑢比碎片𝑆𝑗更多的训练交互,那么当预测𝑢的偏好时,𝑀𝑖的权重更有可能大于𝑀𝑗。虽然最近的方法GraphEraser[13]使用了一种基于学习的方法来分配权重,但在预测不同的用户-项目交互时,权重不能改变。为了进一步提高推荐性能,我们提出了一种基于注意力的自适应聚合方法。

考虑到不同子模型学习到的用户和项目的表示可能会嵌入到不同的空间中,我们首先将它们转移到相同的表示空间中。具体来说,对于子模型𝑆𝑖学习到的P𝑖和Q𝑖,传输方案为:

其中,W𝑖∈R𝑑×𝑑是一个转移矩阵,将P𝑖和Q𝑖投影到全局表示空间,b𝑖∈R𝑑是偏置向量,𝑑表示嵌入大小。

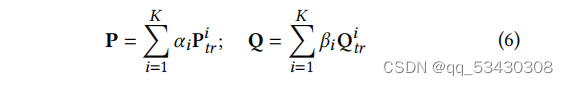

然后计算用户和项目的聚合嵌入情况如下:

其中,𝛼𝑖和𝛽𝑖是聚合用户和项目嵌入的注意权重,指示从子模型𝑆𝑖中传播了多少信息。更准确地说,𝛼𝑖和𝛽𝑖的定义为:

其中W1∈R𝑘×𝑑、b1∈R𝑘和h1∈R𝑘为用户注意的参数,W2∈R𝑘×𝑑、b2∈R𝑘和h2∈R𝑘是项目注意的参数。𝑘是注意大小的维数,𝜎是非线性激活函数ReLU [39]。所有碎片上的注意权重都通过softmax函数进行了归一化。

基于注意力的自适应聚合方法根据以下优化为不同的子模型分配权重:

其中,P和Q是用户和项目的聚合嵌入,Y是用户-项目交互的真正对象,L表示基模型的损失函数(例如,BPR成对损失[42]),和Θ为注意网络的参数。在Θ上进行了由𝜆参数化的ℓ2正则化,以防止过拟合。.请注意,只有注意网络的参数通过等式(8)进行优化。而由子模型学习到的嵌入数据P𝑖和Q𝑖则是固定的。

整个训练数据Y用于训练,也可以要求撤销。因此,我们的聚合方法在接收到数据的卸载请求时需要重新训练,这个训练时间也是忘却时间的一部分。.幸运的是,所提出的聚合方法只需要几个时期(大约10个时期)就可以学习最佳的注意力分数,与其他聚合方法相比,能有效地提高性能。

Training

我们的RecEraser的架构对于基本模型是与模型无关的。在这项工作中,我们用三个具有代表性的推荐模型来实例化RecEraser:BPR [42],WMF [31],和LightGCN [28]。上述方法的评分函数都是基于向量内积的。形式上,对于每个子模型𝑀𝑖,评分函数定义为ˆ𝑦𝑢𝑣=p𝑖𝑢⊤q𝑖𝑣,其中p𝑖𝑢和q𝑖𝑣分别表示𝑀𝑖学习到的用户𝑢和项目𝑣的嵌入。

为了优化目标函数,我们使用小批量的Adagrad [17]作为优化器。其主要优点是在模型学习过程中学习速率可以自适应。RecEraser采用两步训练过程。第一步是训练子模型。为了加快训练过程,我们还可以并行地训练不同的子模型。第二步是通过等式(8)修复子模型和训练基于注意力的聚合部分。

EXPERIMENTS

Experimental Setup

数据集。我们在三个真实世界和公开的数据集上进行了实验,它们已被广泛用于评价推荐模型的性能:Yelp2018,Movielens-1m,和Movielens-10m。由于我们关注的是Top-𝑁推荐任务,因此我们遵循广泛使用的预处理方法,将这些数据集转换为隐式反馈。具体来说,详细评级被转换为0或1,指示用户是否与项目交互。表2总结了这些数据集的统计细节。

比较方法。我们在不同的推荐模型上与最先进的机器解除学习方法进行了比较。所比较的推荐模型包括:

BPR:这是一种被广泛使用的推荐模型,它利用贝叶斯个性化排序目标函数来优化矩阵分解。

WMF:这是一个非抽样推荐模型,它将所有缺失的交互视为负实例,并对它们进行均匀加权。在我们的实验中,它是通过[11]提出的有效的非采样方法进行训练的。

LightGCN:这是一种最先进的图神经网络模型,它简化了GNN的设计,使其更适合推荐。

所比较的机器解除学习方法包括:

评估方法。对于每个数据集,我们随机选择80%的交互作用以构建训练集并将剩余的作为测试集。从训练集中,我们随机选择10%的交互作用作为验证集来调整超参数。对于每个用户,我们的评估协议对训练集中除积极的项目外的所有项目进行了排序。为了评估推荐的性能,我们采用了两种广泛使用的评估方案:Recall@𝑁和NDCG@𝑁。Recall@𝑁测量地面真相是否排在顶级𝑁项目中,而NDCG@𝑁是一个位置感知的排名指标,它给更高的位置分配更高的分数。

超参数设置。使用网格搜索仔细地调整了炒作参数,以实现最佳的性能。在特定于模型的超参数的情况下,我们在它们的原始论文建议的范围内调整它们。调优过程后,batch size大小设置为512,学习速率设置为0.05,嵌入大小𝑑设置为64,注意大小𝑘设置为32。每个epoch的最大数目被设置为1000。我们的实验也采用了早期停止策略,当验证集上的Recall@10在连续10个时期内没有增加时,即终止训练。

Recommendation Performance

我们首先评估了不同的遗忘方法的推荐性能。在本节中,所提出的InBP方法用于RecEraser,所有遗忘方法的碎片数设置为10。为了评估不同的Top-𝑁推荐结果,我们在实验中设置了长度为𝑁= 10、20和50。结果如表2所示。从表格中,可以得出以下观察结果:

首先,再训练方法通常可以获得最好的性能,因为它使用了原始数据集,而不需要忘记进行训练的样本。但是,如下一节所示,它的解除学习效率很低,特别是在模型复杂且原始数据集较大时。

其次,我们提出的RecEraser在三个数据集上获得了比最先进的遗忘基线明显更好的性能(𝑝<0.01)。具体来说,在Yelp2018数据集上,当使用基本模型BPR、WMF和LightGCN时,RecEraser分别比SISA平均提高了59%、41%和46%。与GraphEraser相比,上述改进分别为11%、32%和19%。在其他数据集上,RecEraser的结果也很显著。实质性的改善可以归因于两个原因:(1)通过所提出的InBP方法对数据进行分区,通过保留协作信息来提高性能;(2)采用所提出的基于注意力的聚合方法对子模型进行自适应聚合,可以进一步提高模型的全局性能。

第三,考虑到在每个数据集上的性能,我们观察到遗忘方法的性能取决于数据集的稀疏性。例如,由于这两个数据集比yelp2018相对密集,因此RecEraser的性能与-1m和-10m的再训练方法更具可比性。用户偏好更难从稀疏的用户-项目交互中学习,因此应该仔细设置碎片的数量,以平衡学习效率和性能。我们将在第5.5节中进行进一步的讨论。

Unlearning Efficiency

在本节中,我们进行了实验来探索我们提出的RecEraser的遗忘效率。根据[13]的设置,我们从训练数据中随机抽取100个用户-项目交互,记录相应的子模型和聚合部分的再训练时间,并计算平均再训练时间。在我们的实验中,碎片数设置为10,本节的所有实验都在同一台机器上运行(IntelXeon8核CPU2.4 GHz和单NVIDIA GeForce GTX TITAN X GPU)。结果如表4所示。

实验结果表明,与再训练方法相比,我们提出的再训练RecEraser可以显著提高解除学习效率。例如,在电影-10m数据集上,我们的RecEraser只需要320分钟、16分钟和920分钟就可以达到BPR、WMF和LightGCN的最佳性能,而retrain方法分别需要3250分钟、292分钟和25330分钟。这种加速速度超过10倍,这在实践中是非常有价值的,并且很难通过简单的工程努力来实现。对于再训练方法,在大数据上进行训练是非常耗时的。对于我们的RecEraser,只有相应的子模型和聚合部分需要重新训练,以忘记所需的数据。此外,我们可以对更大的数据集容忍更多的碎片,以进一步提高遗忘效率,同时保持性能。

Ablation Study

所提出的数据分区方法的效果。在本文中,我们提出了三种基于用户、项目和交互的相似性的平衡数据划分方法。我们首先进行消融研究,以了解其影响。.图2显示了结果w.r.t.回顾一下Yelp2018和Movielens-100万数据集上的不同方法。随机划分的结果也显示为基线。.从图2中,可以得出两个观察结果:首先,我们可以看到,我们提出的方法,UBP,IBP,和InBP,与随机方法相比,可以获得更好的推荐性能。以在Yelp2018数据集ASAN实例上训练的LightGCN,INBP的Recsall@20为0.0568,而随机的结果为0.0472。其次,从总体上来看,InBP的性能一般比UBP和IBP都优,这表明基于用户-项目交互对推荐的数据集进行分区比仅基于用户或项目进行分区更有效。

所提出的基于注意力的聚合方法的效果。为了说明所提出的基于注意力的聚合方法(AttAgg)的有效性,我们在两个数据集上与MeanAgg和静态Agg进行了比较。在SISA [1]中使用了MeanAgg,通过对所有子模型的预测进行平均,得到聚合得分。静态代理已被用于GraphEraser[13],这是一种基于学习的方法,为不同的子模型分配权重。但是,不同的用户-项目交互的权重不能改变。图3显示了上述方法的性能。我们可以看出,与MeanAgg方法和静态Agg方法相比,所提出的AttAgg方法可以有效地提高推荐性能。.例如,在使用WMF方法的yelp2018上,AttAgg获得了Recall@20分数的0.0572,而MeanAgg的结果为0.0475,静态Agg的结果为0.0482。这是有意义的,因为推荐系统通常面对各种各样的用户和项目,每个子模型学习到的特征对用户和项目的不同预测应该有不同的贡献。在预测不同的用户-项目对时,使用AttAgg有助于自适应地为不同的子模型分配权重。

Impact of the Shard Number

我们在Yelp2018和Movielens-1m数据集上进行了实验,以调查碎片数的影响。图4中的实验结果显示,随着所有推荐模型的碎片数的增加,平均遗忘时间都在减小。这是有意义的,因为碎片越多意味着碎片越小,这将提高学习效率。同时,三种推荐模型的推荐性能均略有下降。这是因为推荐模型需要协作信息来进行模型学习,这通常会随着碎片数量的增加而减少。.在实践中,应该仔细选择碎片的数量,以平衡学习效率和推荐绩效。

CONCLUSION AND FUTURE WORK

在本文中,我们提出了一种新的RecEraser框架,据我们所知,这是第一个为推荐任务量身定制的机器遗忘方法。为了在保持数据协作信息的同时有效地学习,我们首先设计了三种数据分区策略。然后,我们进一步提出了一种自适应聚合方法来提高全局模型的效用。在三个真实数据集和三个有代表性的推荐模型上进行了广泛的实验。所提出的RecEraser不仅可以实现有效的遗忘,而且在模型效用方面也优于最先进的遗忘方法。我们相信RecEraser的见解是鼓舞未来的发展推荐遗忘方法。随着数据保护需求在实际应用程序中的普及,可擦除的模型在推荐中变得越来越重要。我们的RecEraser也有可能有利于许多其他应该考虑协作信息的任务。在这项工作中,我们关注于解除学习请求依次到达的设置,以研究解除学习在推荐系统中学习的可行性。或者,系统还可以将几个顺序的卸载请求聚合到一个批处理中,然后一次卸载该批处理。目前,如何在批处理设置中使用SISA框架有效地学习仍然是一个有待解决的问题。在未来,我们寻求提高批量设置推荐的遗忘效率。此外,我们还将尝试整合用户和项目的内容特征,并在社交网络嵌入等其他相关任务中探索我们的方法。

ACKNOWLEDGMENTS

国家自然科学基金资助项目(No.和清华大学国强研究所。

948

948

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?