目录

YOLOv8 是 ultralytics 公司在 2023 年 1月 10 号开源的 YOLOv5 的下一个重大更新版本,目前支持图像分类、物体检测和实例分割任务,在还没有开源时就收到了用户的广泛关注。

考虑到 YOLOv8 的优异性能,MMYOLO 也在第一时间组织了复现,由于时间仓促,目前 MMYOLO 的 Dev 分支已经支持了 YOLOv8 的模型推理以及通过 projects/easydepoly 支持部署,我们将尽快发布可训练版本,敬请期待!

官方开源地址: https://github.com/ultralytics/ultralytics

MMYOLO 开源地址: https://github.com/open-mmlab/mmyolo/blob/dev/configs/yolov8/

按照官方描述,YOLOv8 是一个 SOTA 模型,它建立在以前 YOLO 版本的成功基础上,并引入了新的功能和改进,以进一步提升性能和灵活性。具体创新包括一个新的骨干网络、一个新的 Ancher-Free 检测头和一个新的损失函数,可以在从 CPU 到 GPU 的各种硬件平台上运行。

不过 ultralytics 并没有直接将开源库命名为 YOLOv8,而是直接使用 ultralytics 这个词,原因是 ultralytics 将这个库定位为算法框架,而非某一个特定算法,一个主要特点是可扩展性。其希望这个库不仅仅能够用于 YOLO 系列模型,而是能够支持非 YOLO 模型以及分类分割姿态估计等各类任务。

总而言之,ultralytics 开源库的两个主要优点是:

- 融合众多当前 SOTA 技术于一体

- 未来将支持其他 YOLO 系列以及 YOLO 之外的更多算法

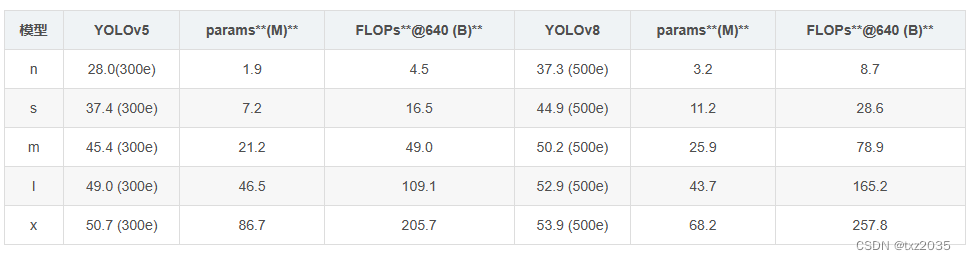

YOLOv8效果对比

下表为官方在 COCO Val 2017 数据集上测试的 mAP、参数量和 FLOPs 结果。可以看出 YOLOv8 相比 YOLOv5 精度提升非常多,但是 N/S/M 模型相应的参数量和 FLOPs 都增加了不少,从上图也可以看出相比 YOLOV5 大部分模型推理速度变慢了。

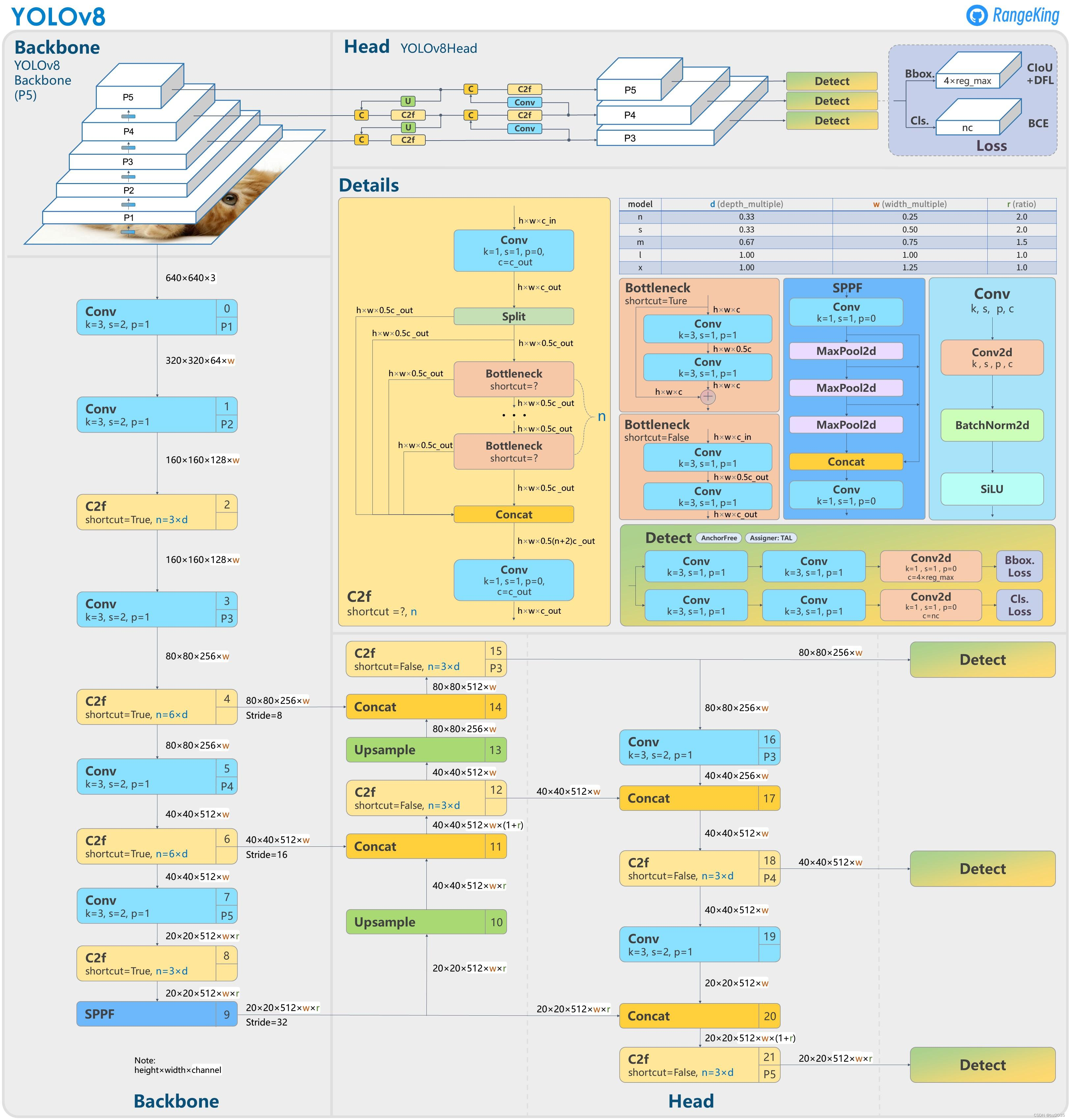

具体到 YOLOv8 算法,其核心特性和改动可以归结为如下:

提供了一个全新的 SOTA 模型,包括 P5 640 和 P6 1280 分辨率 的目标检测网络和基于 YOLACT 的实例分割模型。和 YOLOv5 一样,基于缩放系数也提供了 N/S/M/L/X 尺度的不同大小模型,用于满足不同场景需求

骨干网络和 Neck 部分可能参考了 YOLOv7 ELAN 设计思想,将 YOLOv5 的 C3 结构换成了梯度流更丰富的 C2f 结构,并对不同尺度模型调整了不同的通道数,属于对模型结构精心微调,不再是无脑一套参数应用所有模型,大幅提升了模型性能。不过这个 C2f 模块中存在 Split 等操作对特定硬件部署没有之前那么友好了

Head 部分相比 YOLOv5 改动较大,换成了目前主流的解耦头结构,将分类和检测头分离,同时也从 Anchor-Based 换成了 Anchor-Free

Loss 计算方面采用了 TaskAlignedAssigner 正样本分配策略,并引入了 Distribution Focal Loss

训练的数据增强部分引入了 YOLOX 中的最后 10 epoch 关闭 Mosiac 增强的操作,可以有效 地 提升精度

从上面可以看出,YOLOv8 主要参考了最近提出的诸如 YOLOX、YOLOv6、YOLOv7 和 PPYOLOE 等算法的相关设计,本身的创新点不多,偏向工程实践,主推的还是 ultralytics 这个框架本身 。

1,配置

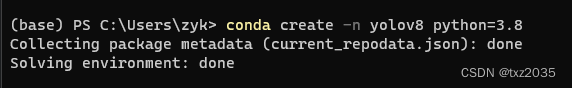

1.1使用Anaconda创建自己的YOLOv8环境

conda create -n yolov8 python=3.8

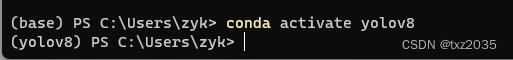

激活虚拟环境

conda activate yolov8

1.2 安装pytorch

pip install torch==1.12.0+cu116 torchvision==0.13.0+cu116 --extra-index-url https://download.pytorch.org/whl/cu116 -i https://pypi.tuna.tsinghua.edu.cn/simple

根据自己的电脑选择

1.3安装依赖包

pip install ultralytics

pip install -r requirements.txt -i https://pypi.mirrors.ustc.edu.cn/simple/

2,训练数据集

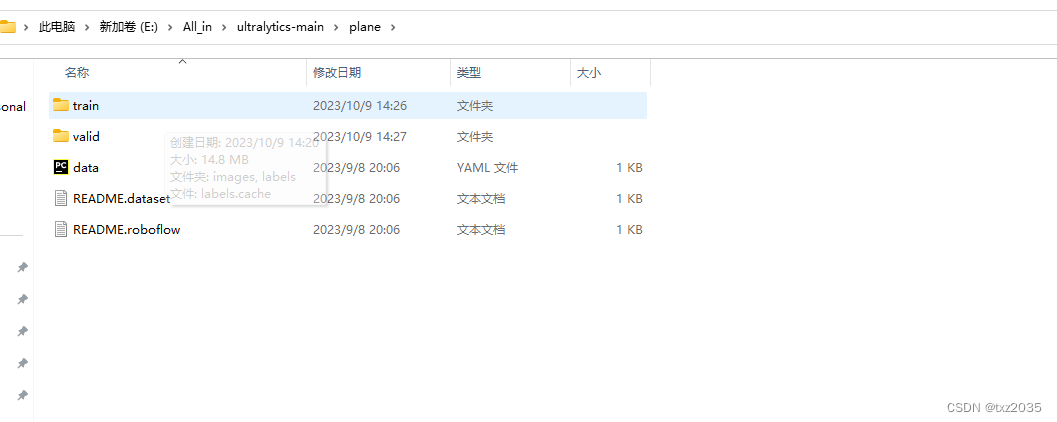

2.1 准保好数据集

2.2把数据集的yaml文件放在

E:\All_in\ultralytics-main\ultralytics\cfg\datasets

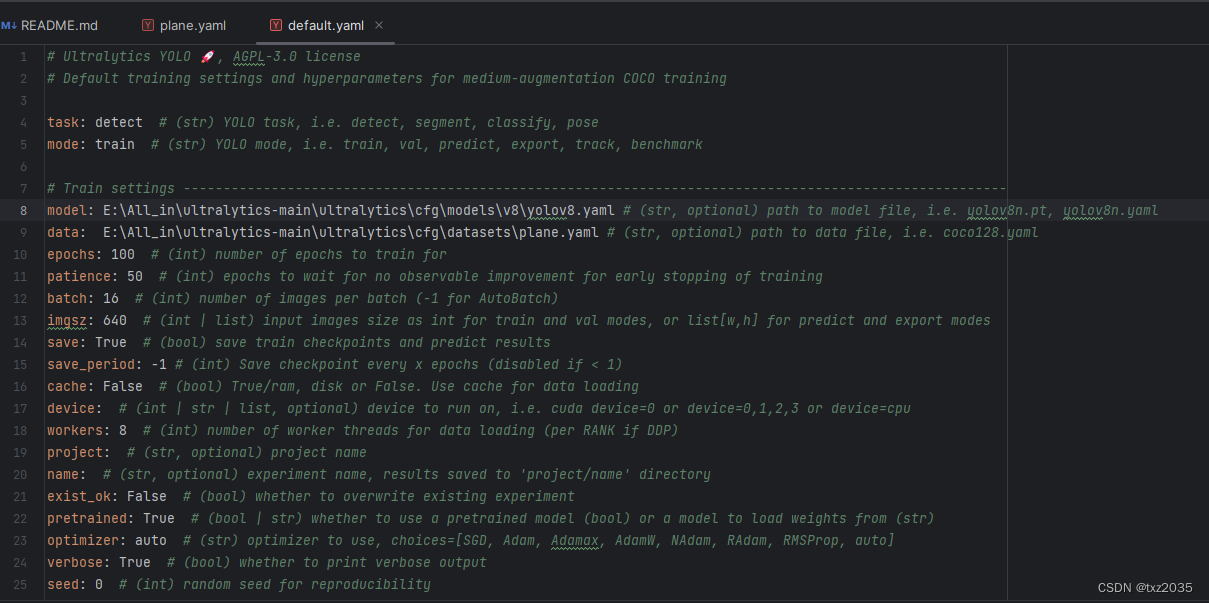

2.3 找到default.yaml文件

E:\All_in\ultralytics-main\ultralytics\cfg\default.yaml

在这个文件里面修改参数路径,就可以进行训练验证测试

task按自己需要,检测,分类,分割都可以

mode:看你当下是要训练还是验证或者预测

model:yolov8n.pt,或者yolov8n.yaml 如果是yaml就是从零开始训练

data:填写你的训练集的yaml文件名

works:最好设置为0 部分人可能会报错

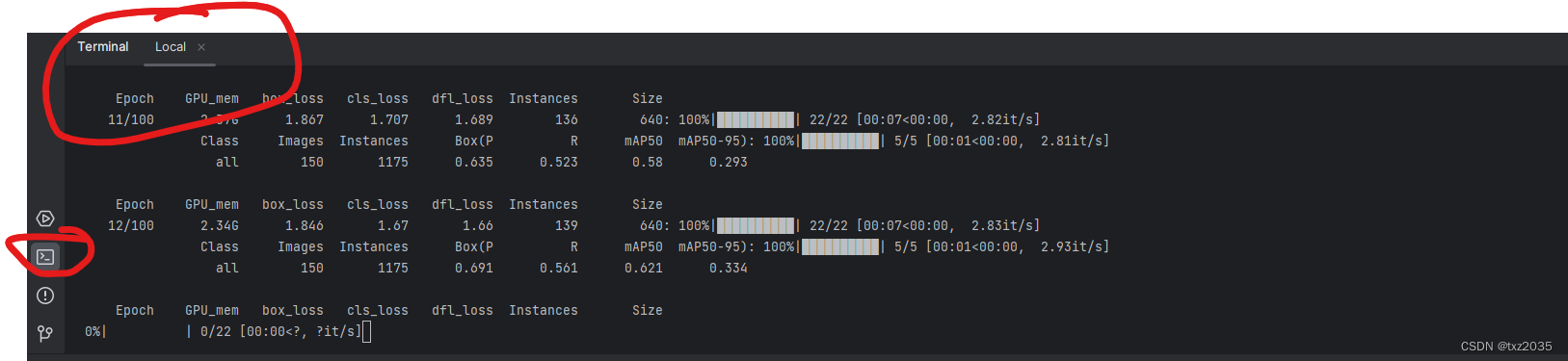

2.4 在terminal中输入命令

yolo cfg=ultralytics/cfg/default.yaml

测试:

修改default文件即可

3063

3063

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?