TATT:A Text Attention Network for Spatial Deformation Robust Scene Text Image Super-resolution

单位:香港理工大学, OPPO 研究院

论文:https://arxiv.org/abs/2203.09388

摘要:

场景文本图像超分辨率旨在提高低分辨率图像中文本的分辨率和可读性。尽管深度卷积神经网络(cnn)已经取得了显著的改进,但对于空间变形的文本,特别是旋转和曲线形状的文本,重建高分辨率图像仍然很困难。这是因为目前基于cnn的方法采用的是基于局部的操作,不能有效地处理变形引起的变化。在本文中,我们提出了一个基于CNN的文本注意网络(TATT)来解决这个问题。文本识别模块首先提取文本的语义作为文本先验信息。在此基础上,我们设计了一种新的基于变压器的模块,利用全局注意机制,在文本重构过程之前对文本进行语义引导。此外,我们提出了文本结构一致性损失,通过对规则文本和变形文本的重建施加结构一致性来细化视觉外观。在基准TextZoom数据集上的实验表明,所提出的TATT不仅在PSNR/SSIM指标方面实现了最先进的性能,而且在下游文本识别任务中显著提高了识别精度,特别是对于具有多方向和弯曲形状的文本实例。

1.介绍

图像中的文字是我们日常生活中重要的信息来源,可以根据不同的目的进行提取和解释。然而,场景文本图像在成像过程中经常遇到各种质量退化,导致分辨率低、结构模糊。该问题严重影响了下游高级识别任务的性能,包括场景文本检测[23,46]、光学字符识别(OCR)和场景文本识别[21,31,32]。因此,提高场景文本图像的分辨率和视觉质量是必要的。

在过去的几年里,为了提高文本图像的图像质量,人们开发了许多场景文本图像超分辨率(STISR)方法,其中基于深度学习的方法取得了显著的进展[4,9,35,36,41]。通过使用降级和原始文本图像对的数据集,可以训练深度卷积神经网络(CNN)对文本图像进行超解析。cnn具有很强的表达能力,可以从数据中学习各种先验,表现出很强的性能。TPGSR模型[22]是一项最新进展,该模型首先将文本的语义识别为先验信息,然后用于指导文本重构过程。利用高水平的先验信息,TPGSR可以恢复语义正确的文本图像,并具有令人信服的视觉质量。

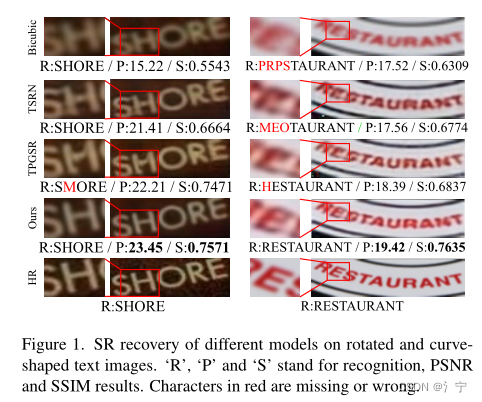

尽管有了很大的进步,但许多基于cnn的方法在处理空间变形的文本图像,包括旋转和弯曲形状的文本图像时仍然存在困难。图1中显示了两个例子,其中左边图像中的文本具有旋转,而右边图像中的文本具有弯曲形状。我们可以看到目前有代表性的方法,包括TSRN[35]和TPGSR[22],产生带有语义错误字符的模糊文本。这是因为目前工作中的架构主要采用基于局部的操作,如卷积,不能有效地捕捉由变形引起的较大位置变化。特别地,TPGSR模型采用了一种简单的方法来利用文本先验:它只是通过卷积将文本先验与图像特征合并。这种安排只能让文本先验在较小的局部范围内与图像特征相互作用,限制了文本先验对文本重构过程的影响。在此基础上,为了获得更好的STISR性能,应该采用一些基于全局的操作(如注意)来捕获文本图像中的长程相关性。

在本文中,我们提出了一种新的架构,称为文本a张力网络(TA TT),用于空间变形鲁棒文本超分辨率。与TPGSR类似,我们首先使用文本识别模块将字符语义识别为文本优先(TP)。然后,我们设计了一个基于转换器的模块,称为TP解释器,以实现文本先验和图像特征之间的全局交互。具体来说,TP解释器操作文本先验和图像特征之间的交叉注意,以捕获它们之间的长程相关性。图像特征可以在空间变形的情况下获得丰富的语义引导,从而改进文本重构。为了进一步细化空间变形下的文本外观,我们设计了一个文本结构一致性损失,它测量了规则文本和变形文本之间的结构距离。从图1可以看出,我们的方法恢复的字符在语义正确的情况下具有更好的视觉质量。

总体而言,我们的贡献可归纳如下:

•我们提出了一种新的方法,通过使用CNN和Transformer将先前的文本与空间变形的文本图像对齐,以获得更好的SR恢复。

•我们提出了一种文本结构一致性损失,以增强从空间变形的低分辨率文本图像中恢复文本结构的鲁棒性。

•我们提出的模型不仅在TextZoom数据集上的各种评估指标上实现了最先进的性能,而且在恢复方向扭曲和曲线形状的低分辨率文本图像方面也表现出出色的泛化性能。

2.相关工作

2.1单幅图像超分辨率

单图像超分辨率(SISR)旨在从给定的低分辨率(LR)输入图像中恢复高分辨率(HR)图像。传统的图像先验设计方法包括统计先验[11]、自相似先验[24]和稀疏先验[40]。最近的基于深度学习的方法训练卷积神经网络(cnn)来解决SISR任务并实现领先的性能。开创性的工作SRCNN[8]采用三层CNN学习SR恢复。后来,人们开发了更复杂的CNN架构来提升SISR性能,例如残差块[19]、拉普拉斯金字塔[17]、密集连接[44]和通道注意机制[43]。近年来,生成对抗网络已被应用于SISR中,以达到逼真的效果.

2.2. 场景文本图像超分辨率(STISR)

与一般用于自然场景图像的SISR不同,STISR侧重于场景文本图像。它不仅能提高文本图像的分辨率,还能重构语义正确的文本,从而有利于下游识别任务。早期的方法直接采用了来自SISR的CNN架构来完成STISR的任务。在[9]中,Dong等人将SRCNN[8]扩展到文本图像,并在ICDAR 2015比赛[27]中获得最佳表现。PlugNet[25]采用可插拔超分辨率单元对特征域LR图像进行处理。TextSR[36]利用文本感知损失生成所需的HR图像,有利于文本识别。

为了解决现实场景下的STISR问题,Wang等[35]建立了一个现实场景下的STISR图像数据集,即TextZoom,其中LR和HR文本图像对是从现实场景下的SISR数据集中裁剪而来[2,42]。他们还提出了TSRN[35],利用序列残差块来挖掘内部特征中的语义信息。SCGAN[39]采用多类GAN损失来监督STISR模型,以获得更直观的人脸和文本图像。此外,Quan等[29]提出了一种在高频域和图像域协同恢复模糊文本图像的级联模型。Chen et al[4]和Zhao et al[45]通过自参图像特征和参信道来增强网络块结构以提高STISR性能。

2.3. 场景文本识别

场景文本识别的目的是从输入图像中提取文本内容。一些早期的方法倾向于先识别每个字符,然后再解释整个单词[12,14],而另一些方法则将文本图像视为一个整体,进行单词级分类[13]。CRNN[31]将文本识别视为图像到序列的问题,提取图像特征,并使用循环神经网络对语义信息进行建模。使用CTC [10] loss进行训练,使预测序列与目标序列对齐。近年来,基于注意力的方法由于其对文本图像形状变化提取文本的鲁棒性而取得了很大进展[6,7]。尽管这些方法取得了很好的性能,但低分辨率图像中的文本识别仍然存在困难。因此,本文旨在解决高分辨率文本图像的恢复问题,以获得更好的识别。

3.方法

3.1. 总体架构

我们的TATT网络管道如图2所示。

它以低分辨率(LR)文本图像Y∈R^(h×w×3)为输入,通过以下两条路径进行处理。在第一个路径中,输入图像被发送到TP生成器(TPG),以预测文本优先fp的识别概率序列(类似于[22])。这个过程可以记为fP = TPG(Y)。fP∈Rl×|A|是一个长度为l的序列,由大小为|A|的分类概率向量组成。A表示由' 0 '到' 9 ',' A '到' z '和一个空白类(总共37个)组成的字符集。第二条路径通过9 × 9的卷积层从输入LR图像Y中提取图像特征fI∈R^(h×w×c)(我们将此过程表示为fI = Conv(Y))

然后,将文本先验fP和图像特征fI传递给TP解释器TPI(·),计算一个TP映射fT M∈R^(h×w×c),记为fTM = TPI(fP, fI)。TP Interpreter计算文本先验fP与图像特征fI之间的相关性,并将fP中的语义引导分配到空间域中的相应位置,指导最终的SR文本恢复。所得到的TP图fTM是一种调制图,可用于增强图像特征的语义特定部分。

最后,将TP映射fTM和图像特征fI传递给重构模块。该模块包括5个文本优先引导块(TPGBs),逐步融合fTM和fI,以及最后的像素- shuffle层,以提高分辨率。5个TPGBs中的每一个都首先通过元素相加的方式合并fTM和fI,然后使用序列循环块(SRB)[35]重建高分辨率图像特征。这个模块的输出是超分辨率(SR)文本图像。

3.2 TP解释器

在该体系结构中,关键部分是TP解释器(TPI)的设计。TP Interpreter的目的是对图像特征fI之前的文本fP进行解释,从而将语义引导作用于图像特征域中的相关空间位置。一个直观的想法是将fP放大到fI的形状,然后通过卷积将它们合并。由于卷积运算的有效范围较小,fP的语义不能分配到fI中较远的空间位置,特别是在空间变形文本的情况下。因此,我们转而设计一个基于transformer的带有注意机制的TP解释器,以加强文本先验fP与图像特征fI之间的全局相关性。

如图3所示,所提出的TP解释器由编码器部分和解码器部分组成。编码器通过对fP中每个字符的语义进行关联,对优先于fP的文本进行编码,输出上下文增强特征fE。解码器在fE和fI之间进行交叉注意,将语义信息解释为图像特征。

编码器。编码器将fP之前的文本作为输入,并将其投射到C通道以匹配图像特征通道。由于先前的输入文本在编码器中是并行处理的,因此模型不知道TP中的语义顺序。因此,在将fP送入编码器之前,我们以元素的方式将固定位置编码(FPE)添加到fP,从而对位置进行编码。注意,我们在本文中采用正弦位置编码[34]作为我们的FPE。在对位置进行编码之后,前面的文本被传递到编码器模块。编码器有一个多头自注意(MSA)层和一个前馈网络(FFN)层[34]。在当前层和上一层之间部署跳过连接,以实现剩余学习。MSA层在fP之前对文本中的语义元素进行全局关联,从而得到上下文增强的TP特征fE∈Rl×c,以供后续计算。由于空间限制、MSA和FFN的描述省略。详情可参考[34]。

译码器。解码器模块接受编码器模块fE和图像特征fI的输出执行全局交叉注意。与编码器中的设置类似,我们首先在fI中添加一个位置编码来包含位置信息。我们设计了一种循环位置编码(recurrent positional encoding, RPE),以更好地编码图像特征在水平方向上序列依赖所包含的偏差,更好地帮助模型在后续交叉注意中查找文本语义特征[20,33]。在RPE中,我们保持与图像特征形状相同的可学习参数,并在水平方向上编码顺序依赖关系,以帮助模型更好地学习相邻上下文。详见补充文件。

然后将位置编码图像特征f 'I和编码器输出fE传递给解码器模块进行相关计算。首先,在信道维度上将fE和f 'I的特征划分为n个子组,然后在信道维度上将fE和f 'I的特征进行交叉注意操作。然后对fE的第I组和f’I进行交叉注意操作CAi:

通过MCA操作,文本优先的fE可以有效地与图像特征f’I进行交互,将语义域的每个元素与空间域的位置相关联。这样,在TP图fT - M中增强了空间域中语义有意义的区域,可以用来调制图像特征,进行特定语义的文本重建。

3.3. 文本结构一致性缺失

虽然提出的TA TT网络可以获得较好的性能,但重构后的文本图像还需要一些改进以改善视觉外观。这是因为CNN模型在表示变形后的文本特征方面有一定的困难,而且重构后的文本图像字符结构较弱,对比度相对较低。作为补救措施,我们模拟变形的文本图像,并设计一个文本结构一致性(TSC)损失来训练所提出的TATT网络。

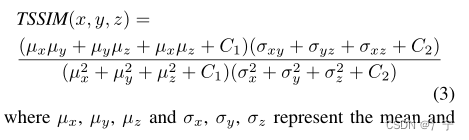

我们考虑最小化三幅图像之间的距离,即SR文本图像的变形版本DF(Y), SR文本图像的变形版本LR文本图像F(DY)和变形的ground truth D(X),其中D表示随机变形1。通过增加三项之间的相似性,我们可以鼓励CNN模型在遇到空间变形时减少性能下降。提出的TSC损失首先测量了上述三元组之间的结构相似性。为此目的,我们将结构相似指数度量(SSIM)[38]扩展为三重SSIM (tsim),描述为

3.4. 总损失函数

在训练中,总体损失函数包括超分辨率损失LSR,文本先验损失LTP和提出的TSC损失LTSC。SR损失LSR测量我们的SR输出F(Y)与地面真实HR图像x之间的差值。我们采用L2范数进行计算。TP损失测量了先前从LR图像中提取的文本与地面真相之间的L1范数和KL散度。加上TSC损耗LTSC,总体损耗函数描述如下:

4. 实验

4.1. 实现细节

TA TT在单个RTX 3090 GPU上进行训练和测试。我们采用Adam[16]优化器来训练批量大小为64的模型。训练时间为500 epoch,学习率为10−3。我们模型的输入图像是宽64,高16,而输出图像是2× SR的结果。我们将(5)中的α和β分别设置为1和0.1(参见有关烧蚀的补充文件)。LT SC中的变形操作D是通过在[−10,10]度范围内施加随机旋转,在[0.5,2.0]范围内施加剪切和纵横比来实现的。MSA层和MCA层的头号都设置为4(遵循[3]中的最佳设置)。MSA、MCA和FFN计算中的图像特征通道数c、dk均设置为64。TA TT的模型尺寸总共是14.9M。训练时,TPG使用从[1]得到的预训练权重初始化,其他部分随机初始化。测试时,TA TT将占用6.5GB的GPU内存,批处理大小为50。

4.2. 数据集

TextZoom。TextZoom[35]有21,740个LR-HR文本图像对,通过在现实场景中改变相机的焦距收集,其中17,367个样本用于训练。其余样本根据相机焦距分为三个子集进行测试,即易(1619个样本)、中(1411个样本)和难(1343个样本)。文本标签是在TextZoom提供的。

场景文本识别数据集。除了在TextZoom中进行的实验外,我们还采用ICDAR2015 [15], CUTE80[30]和SVTP[28]来评估我们的模型在恢复空间变形LR文本图像时的鲁棒性。ICDAR2015有2077个场景文本图像用于测试。大多数文本图像都存在低质量和透视失真的问题,这使得识别极具挑战性。CUTE80也在野外收集。测试集共有288个样本。SVTP中的样本多为曲线形文本。测试集的总大小为649。除了在原始样本上评估我们的模型外,我们还进一步降低图像质量,以测试模型在不可预测的恶劣条件下的泛化能力。

4.3消融实验

在本节中,我们将研究TP解释器、TSC损失函数和位置编码的有效性的影响。本节中的所有评估都是在真实世界的stir数据集TextZoom[35]上执行的。

文本识别采用CRNN[31]进行。

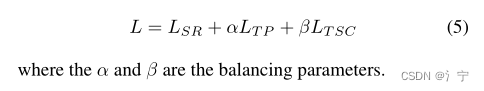

TP解释器对SR恢复的影响。由于我们的TP解释器旨在提供更好的TP和图像特征之间的对齐,并使用文本语义来指导SR恢复,因此我们将其与其他引导策略进行比较,例如,首先对TP进行上采样,以匹配图像特征与反卷积层[22]或像素洗牌,以匹配图像特征之前的文本,然后将它们融合以使用元素添加或SFT层[37]2进行引导。结果如表1所示。可以看到,所提出的TP解释器获得了最高的PSNR/SSIM,这也表明了最好的SR性能。

参考SR文本图像识别,可以看到使用像素- shuffle和反卷积策略提供较差的指导(46.2%和49.8%)。与SFT层联合使用无稳定改善(47.9%和48.6%)。这是因为所有的竞争策略都没有在文本语义和图像特征之间进行全局关联,导致语义引导对SR恢复的效果较差。相比之下,我们的TP解释器可以获得良好的语义上下文和准确的文本区域对齐。从而加强了对图像特征的引导,将文本识别结果提高到52.6%。这验证了使用TP解释器是利用TP语义进行SR恢复的有效方法。一些视觉对比如图4所示。可以看到,TP解释器的设置可以产生具有正确语义的最高质量的SR文本图像。

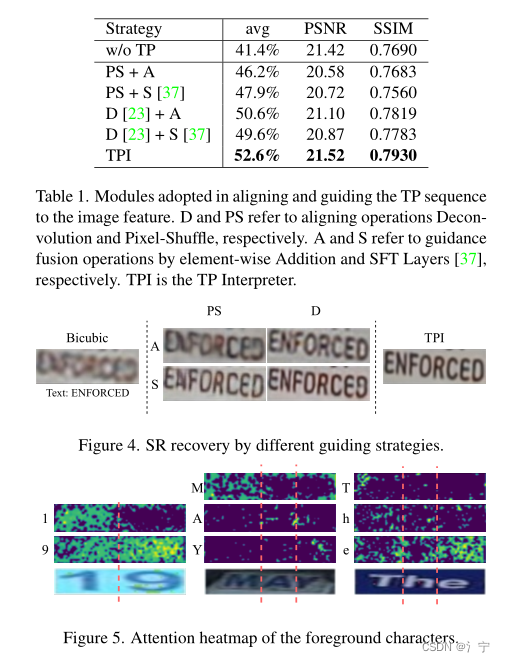

为了演示TP解释器如何提供全局上下文,我们将注意力热图可视化图5中的MCA((1)中SM层的输出)。可以看到,对应的前景字符的区域具有最高的权重(突出显示)。从而证明了TP解释器在图像特征中寻找语义的能力。附近的其他一些突出显示的区域也表明TP Interpreter可以意识到邻近的上下文,这可以为最终的SR恢复提供更好的指导。

TSC损失对训练的影响。为了验证TSC损失在精炼文本结构方面的有效性,我们比较了有和没有TSC损失训练的4个模型的结果,包括基于非TP的TSRN [35], TBSRN[4],基于TP的TPGSR[22]和TA TT。从表2的结果可以看出,当采用我们的TSC损失时,所有模型在SR文本识别中都获得了性能提升(TSRN为4.3%,TBSRN为1.3%,TPGSR为0.8%,TA TT为1.0%)。值得注意的是,尽管TBSRN[4]被声称对多向文本具有鲁棒性,但它仍然可以通过我们的TSC损失进行改进,这表明使用TSC损失进行训练可以提高针对各种空间变形重建字符结构的鲁棒性。

RPE的有效性。我们评估了反复位置编码在学习文本先验引导中的影响。我们部署了固定位置编码(FPE)、可学习位置编码[3]和在编码器和解码器模块中引入循环位置编码(RPE),并在SR文本图像上比较相应的文本识别结果。从表3中,我们观察到在解码器中使用LPE或FPE的性能有限,因为它们对序列信息的学习能力较弱。在译码器中采用RPE, SR识别率提高了1.8%,说明RPE有利于文本序列语义学习。

4.4. 与艺术现状比较

TextZoom的结果。我们在现实世界的STISR数据集TextZoom[35]上进行实验,将所提出的TA TT网络与最先进的SISR模型(包括SRCNN[8]和SRResNet[18]和HAN[26])以及STISR模型(包括TSRN [35], TPGSR [22], PCAN[45]和TBSRN[4])进行比较。对于TPGSR,我们比较了它的两个模型,即1-stage和3-stage (TPGSR-3)。评价指标为SSIM/PSNR和文本识别精度。对比结果如表4和表5所示。

可以看到,我们用LT SC训练的模型获得了最佳的PSNR(21.52)和SSIM(0.7930)总体性能。验证了该方法在提高图像质量方面的优越性。在SR文本识别方面,该方法利用ASTER[32]和CRNN[31]文本识别模型,在各种设置下都达到了最新的精度。它甚至超过了仅使用单级的3级模型TPGSR-3。

我们还测试了三种最具竞争力的STISR方法的推理速度,即TBSRN(982帧/秒),TPGSR(1085帧/秒)和我们的TA TT模型(960帧/秒)。TA TT与TPGSR和TBSRN具有相当的识别速度,而在使用ASTER作为识别器的SR图像文本识别中,TA TT比TPGSR和TBSRN分别高出2.7%和3.6%。

进一步研究其在空间上的表现基于变形文本图像,我们从TextZoom测试集中手动选取804个旋转和曲线形状的样本来评估比较模型。从表6的结果可以看出,我们的TA TT模型获得了最好的性能,当遇到空间变形的文本时,与TPGSR和TBSRN等模型的平均差距更大。

我们还在图6中可视化了TextZoom的常规样本和空间变形样本的恢复结果。如果没有TP的引导,TSRN和TBSRN的表现就很难读懂,而且在视觉上是不可接受的。在TP引导下,TPGSR在恢复空间变形图像时仍然不稳定。相比之下,我们的TA TT网络在所有情况下的样本文本语义恢复方面都比所有竞争对手表现得更好。随着TSC的损失,我们的模型进一步提升了视觉质量具有更好细化的字符结构的样本。

泛化到识别数据集。我们对我们的TA TT网络的泛化性能进行了评估真实世界文本图像数据集,包括ICDAR15 [15], CUTE80[30]和SVTP[28]。这些数据集是为文本识别而建立的,包含自然场景中空间变形的文本图像。由于这些数据集中的一些图像质量较好,我们只选择了低分辨率的图像(即低于16 × 64),以533个样本组成我们的测试集(391个来自ICDAR15, 3个来自CUTE80, 139个来自SVTP)。由于退化相对较小,我们手动添加了一些退化,包括对比度变化,高斯噪声和高斯模糊(详见补充文件)。我们在本次测试中与TSRN [35], TBSRN[4]和TPGSR[22]进行了比较,并评估了SR结果的识别精度。所有模型都在TextZoom上进行训练,并在挑选的低质量图像上进行测试。

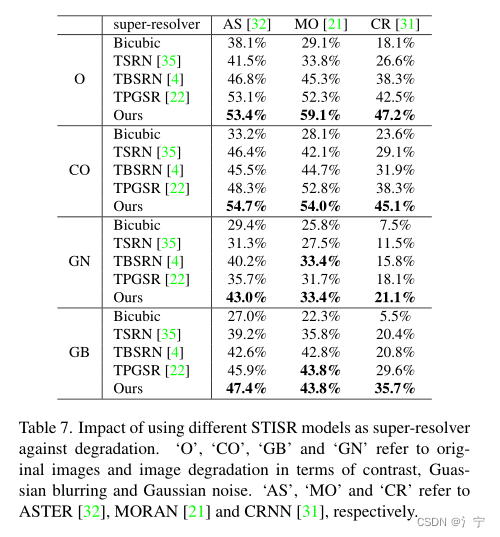

结果如表7所示,我们可以看到,所提出的TA TT网络在所有退化类型中都达到了最高的识别精度。这表明,我们的TATT网络虽然在TextZoom上训练,但可以很好地推广到其他数据集的图像上。重建的高质量文本图像可以用于文本识别等下游任务。

5. 结论与讨论

本文提出了一种用于单文本图像超分辨率的Text a tentenn网络。我们利用文本先验,即从文本图像中提取的语义信息,来指导文本图像重建过程。为了解决空间变形文本的恢复问题,我们开发了一个基于转换器的模块,称为TP解释器,用于将语义域的优先文本与图像特征域的字符区域进行全局关联。此外,我们提出了文本结构一致性损失,通过在恢复的规则文本和变形文本之间施加结构一致性来细化文本结构。我们的模型不仅在文本超分辨率任务中,而且在下游文本识别任务中都取得了最先进的性能。

如图7所示,虽然所提出的TATT网络记录了最先进的结果,但在恢复极其模糊的文本方面存在局限性。在这种情况下,文字中的汉字笔画混合在一起,很难分开。此外,由于我们的模型采用了全局关注,我们的TATT网络的计算复杂度随着图像中文本的长度呈指数级增长。希望能够降低TATT的计算复杂度,提高TATT的运行效率,这将是我们未来的工作方向。

原文作者:Jianqi Ma, Zhetong Liang, Lei Zhang

8422

8422

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?