1 INTRODUCTION

根据深度学习的主要技术贡献将其分为以下几类:

- 全卷积网络

- 带有图形模型的卷积模型

- 基于编码器-解码器的模型

- 基于多尺度和金字塔网络的模型

- 基于R-CNN的模型(例如分割)

- 扩展卷积模型和DeepLab家族

- 基于循环神经网络的模型

- 基于注意力的模型

- 生成模型和对抗训练

- 带有活动轮廓模型的卷积模型

- 其他模型

本调查报告的一些主要贡献可以总结如下:

- 本调查涵盖了当代关于分割问题的文献,并概述了截至2019年提出的100多种分割算法,分为10类。

- 我们对使用深度学习的分割算法的不同方面进行了全面的回顾和深刻的分析,包括训练数据、网络架构的选择、损失函数、训练策略及其关键贡献。

- 我们提供了大约20个流行的图像分割数据集的概述,分为2D, 2.5D (RGBD)和3D图像。

- 我们在流行的基准上提供了用于分割目的的审查方法的属性和性能的比较摘要。

- 我们为基于深度学习的图像分割提供了几个挑战和潜在的未来方向。

2 OVERVIEW OF DEEP NEURAL NETWORKS

本节概述了计算机视觉社区使用的一些最突出的深度学习架构,包括卷积神经网络(cnn)[13]、循环神经网络(rnn)和长短期记忆(LSTM)[14]、编码器-解码器[15]和生成式对抗网络(GANs)[16]。随着近年来深度学习的普及,其他几种深度神经结构也被提出,如transformers、胶囊网络、门控循环单元、空间Transformer网络等。

2.1 Convolutional Neural Networks (CNNs)

cnn主要由三种类型的层组成:

- 卷积层

- 非线性层,它在特征映射(通常是元素)上应用激活函数,以便通过网络对非线性函数进行建模

- 池化层,使用统计信息(均值、最大值等)替换特征图的一个小邻域,并降低空间分辨率。每个层中的单元是局部连接的,即每个单元从前一层的一个小邻域(称为感受野)中接收加权输入。通过堆叠层以形成多分辨率金字塔,更高级别的层学习越来越宽的感受野中的特征。这种方法可以用来构建逐级扩展的特征表示,以捕获图像中不同尺度的信息。

- 一些最著名的CNN架构包括:AlexNet[19]、VGGNet[20]、ResNet[21]、GoogLeNet[22]、MobileNet[23]和DenseNet[24]。

2.2 Recurrent Neural Networks (RNNs) and the LSTM

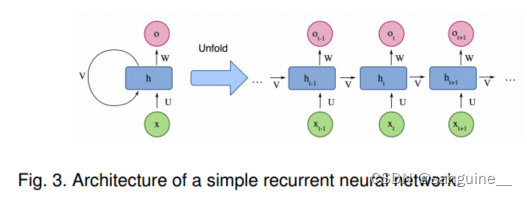

rnn[25]被广泛用于处理顺序数据,如语音、文本、视频和时间序列,其中任何给定时间/位置的数据取决于先前遇到的数据。在每个时间戳,模型收集当前时间Xi的输入和前一步hi−1的隐藏状态,并输出一个目标值和一个新的隐藏状态(图3)。

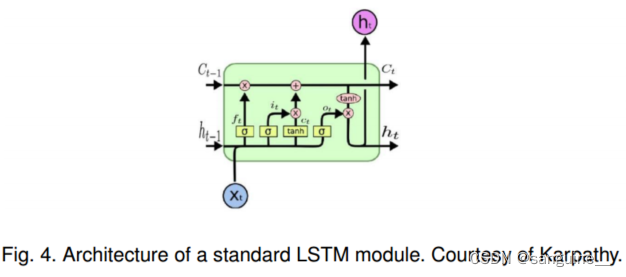

LSTM 架构包括三个门(输入门、输出门、遗忘门),它们调节信息进入和离开存储值的内存单元的流动,这些值可以在任意时间间隔内存储。LSTM 的设计使得它能够更有效地处理长序列,并且能够更好地捕获序列中的长期依赖关系。

2.3 Encoder-Decoder and Auto-Encoder Models

编码器-解码器模型是一组学习通过两阶段网络将数据点从输入域映射到输出域的模型:编码器由编码函数z = f(x)表示,将输入压缩为潜在空间表示;解码器y = g(z)的目的是预测潜在空间表示的输出[15],[26]。这里的潜在表示本质上指的是特征(向量)表示,它能够捕获输入的潜在语义信息,这对预测输出很有用。这些模型在图像到图像的翻译问题以及NLP中的序列到序列模型中非常流行。图5展示了一个简单的编码器-解码器模型的框图。这些模型通常通过最小化重构损失L(y;),它测量真地输出Y和随后的重建

之间的差异。这里的输出可以是图像的增强版本(例如图像去模糊或超分辨率),也可以是分割映射。自编码器是输入和输出相同的编码器-解码器模型的特殊情况。

2.4 Generative Adversarial Networks (GANs)

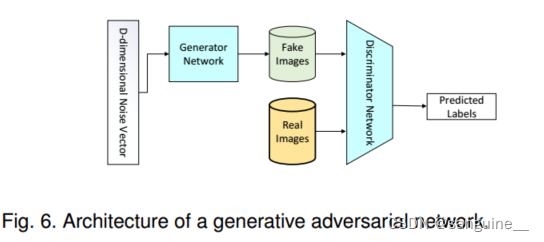

在GAN中,包含两个网络:生成器(Generator)和判别器(Discriminator)。生成器网络G学习将噪声z(具有先验分布)映射到目标分布y,使其与“真实”样本相似。判别器网络D试图区分生成的样本(“伪造”)和“真实”样本。GAN的损失函数LGAN由两部分组成:第一部分是真实样本的损失,即判别器对真实样本的预测误差;第二部分是生成样本的损失,即判别器对生成样本的预测误差。

在训练过程中,GAN可以被看作是生成器G和判别器D之间的极小极大博弈。判别器D试图最小化其在区分伪造样本和真实样本上的分类错误,从而最大化损失函数;而生成器G试图最大化判别器网络的错误,从而最小化损失函数。训练完成后,生成器模型将会是G*,其定义为最小化生成器G和最大化判别器D的损失函数LGAN。

在实践中,这个函数可能在训练生成器G时提供的梯度不足,特别是在初始阶段(当判别器可以轻松区分伪造样本和真实样本时)。因此,一个可能的解决方案是将训练目标从最小化Ez∼pz(z)[log(1 − D(G(z)))]改为最大化Ez∼pz(z)[log(D(G(z))],以更有效地训练生成器G。

卷积GAN模型:该模型在用于图像生成时比全连接网络工作得更好。

条件GAN模型:该模型可以生成以类别标签为条件的图像,从而可以生成具有指定标签的样本。

3 DL-BASED IMAGE SEGMENTATION MODELS

本节详细回顾了截至2019年提出的100多种基于深度学习的分割方法,分为10类(基于其模型架构)。值得一提的是,在许多这些作品中有一些共同的部分,例如编码器和解码器部分,跳过连接,多尺度分析,以及最近使用的扩展卷积。

3.1 Fully Convolutional Networks

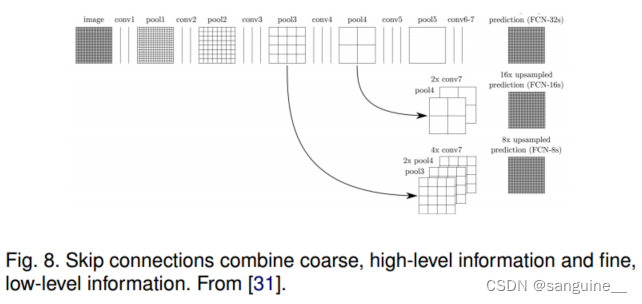

Long等人[31]使用全卷积网络(FCN)提出了语义图像分割的首批深度学习工作之一。FCN(图7)仅包含卷积层,这使得它能够获取任意大小的图像并生成相同大小的分割图。作者修改了现有的CNN架构,如VGG16和GoogLeNet,通过用全卷积层替换所有全连接层来管理非固定大小的输入和输出。因此,模型输出的是空间分割图,而不是分类分数。

通过使用跳跃连接,将模型最后一层的特征图上采样并与前一层的特征图融合(图8),该模型将语义信息(来自较深、较粗的层)和外观信息(来自较浅、较细的层)结合起来,以产生准确、详细的分割。该模型在PASCAL VOC、NYUDv2和SIFT Flow上进行了测试,取得了最先进的分割性能。

这项工作被认为是图像分割的一个里程碑,表明深度网络可以在可变图像上以端到端方式进行语义分割训练。然而,尽管传统的FCN模型很受欢迎和有效,但它也有一些局限性——它的速度不够快,无法进行实时推理,它没有有效地考虑全局上下文信息,而且它不容易转移到三维图像中。一些努力试图克服FCN的一些限制。

例如,Liu等人[32]提出了一个名为ParseNet的模型来解决fcn忽略全局上下文信息的问题。ParseNet通过使用层的平均特征来增加每个位置的特征,从而为fcn添加全局上下文。层的特征映射在整个图像上汇集,从而产生上下文向量。这个上下文向量被归一化和非池化,以产生与初始特征相同大小的新特征映射。然后将这些特征映射连接起来。简而言之,ParseNet是一个用所描述的模块替换卷积层的FCN(图9)。

非池化(Unpooling)是一种与池化相反的操作,用于将特征图的尺寸从较小的表示恢复到原始输入图像的尺寸。在卷积神经网络(CNN)中,池化层通常用于减小特征图的尺寸,减少参数数量并提取关键特征。而非池化层则用于将特征图的尺寸恢复到原始大小,以便进行后续处理或输出。

在非池化操作中,通常会使用一些策略来实现特征图的上采样,例如反池化(反池化)或插值等方法。这些方法可以根据不同的需求和网络结构来选择,以确保特征图的尺寸恢复到适当的大小,并保持特征的有效性。

3.2 Convolutional Models With Graphical Models

如前所述,FCN忽略了潜在有用的场景级语义上下文。为了整合更多的上下文,有几种方法将概率图形模型,如条件随机场(CRFs)和马尔可夫随机场(MRFs)合并到DL架构中。

Chen等[37]提出了一种基于cnn和全连接crf相结合的语义分割算法(图10)。他们表明,深度cnn的最后一层的响应没有充分定位到精确的对象分割(由于cnn的不变性特性,使得cnn适合于分类等高级任务)。为了克服深度CNN较差的定位特性,他们将CNN最后一层的响应与一个全连接的CRF结合起来。他们表明,与以前的方法相比,他们的模型能够以更高的准确率定位片段边界。

Schwing和Urtasun[38]提出了一种用于图像分割的全连接深度结构化网络。他们提出了一种联合训练cnn和全连接crf进行语义图像分割的方法,并在具有挑战性的PASCAL VOC 2012数据集上取得了令人鼓舞的结果。在[39]中,Zheng等人提出了一种类似的将CRF与CNN相结合的语义分割方法。

Lin等人在一项相关研究中提出了一种基于上下文深度条件随机场(CRF)的高效语义分割算法。他们通过探索“patch-patch”上下文(图像区域之间的上下文)和“patch-background”上下文,利用上下文信息来改善语义分割效果。在这项研究中,研究人员关注了图像中不同区域之间的关系(“patch-patch”上下文),以及图像区域与背景之间的关系(“patch-background”上下文)。通过分析和利用这些上下文信息,他们设计了一种算法,能够更好地理解图像中不同区域之间的联系,从而提高语义分割的准确性和效率。

Liu等人在一项研究中提出了一种语义分割算法,将丰富的信息整合到马尔可夫随机场(MRFs)中,包括高阶关系和标签上下文的混合。与以往通过迭代算法优化MRFs的方法不同,他们提出了一种CNN模型,即Parsing Network,可以在单次前向传递中实现确定性的端到端计算。

高阶关系:传统的MRFs通常考虑相邻像素之间的关系,即一阶关系。而高阶关系则指的是考虑更多像素之间的关系,例如考虑更大范围内像素的相互作用,以更好地捕捉图像中的复杂结构和模式。

标签上下文:标签上下文指的是像素的标签(即语义类别)之间的关系和相互作用。通过混合标签上下文,可以考虑不同语义类别之间的关联性,从而更好地理解图像中不同区域的语义信息。

3.3 Encoder-Decoder Based Models

另一种流行的图像分割深度模型是基于卷积编码器-解码器架构。大多数基于dl的分割工作使用某种编码器-解码器模型。我们将这些工作分为两类,用于一般分割的编码器-解码器模型和用于医学图像分割的编码器模型(以便更好地区分应用程序)。

3.3.1 Encoder-Decoder Models for General Segmentation

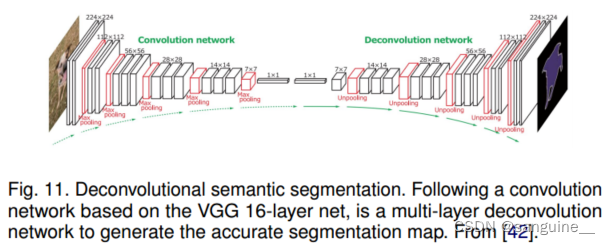

Noh等人在一项早期的研究中基于反卷积(也称为转置卷积)提出了一种语义分割方法。他们的模型包括两部分,一个使用从VGG 16层网络中采用的卷积层作为编码器,以及一个以特征向量为输入并生成像素级类别概率地图的反卷积网络。反卷积网络由反卷积和反池化层组成,用于识别像素级类别标签并预测分割掩模。该网络在PASCAL VOC 2012数据集上取得了令人满意的性能,并且在当时没有外部数据训练的方法中获得了最好的准确率(72.5%)。

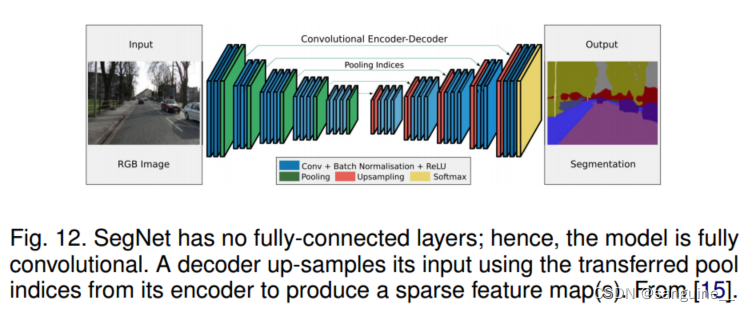

Badri-narayanan等人在一项名为SegNet的研究中提出了一种用于图像分割的卷积编码器-解码器架构。SegNet的核心可训练分割引擎包括一个编码器网络和一个相应的解码器网络,其拓扑结构与VGG16网络中的13个卷积层完全相同,并在最后接一个逐像素分类层。

具体来说:

- 编码器网络:与VGG16网络中的卷积层相同,用于提取输入图像的特征。

- 解码器网络:SegNet的解码器网络采用了一种新颖的上采样方法,它利用了在对应编码器的最大池化步骤中计算的池化索引来执行非线性上采样,从而避免了需要学习上采样的过程。这种方法使得解码器能够将低分辨率的输入特征图进行上采样,生成稠密的特征图。

- 参数数量:SegNet在可训练参数数量上明显比其他竞争架构更小,这使得模型更加轻量化和高效。

此外,研究人员还提出了SegNet的贝叶斯版本,用于模拟卷积编码器-解码器网络在场景分割中固有的不确定性。这种方法有助于更好地理解模型的预测结果,并提高模型在复杂场景下的鲁棒性。

池化索引:在最大池化操作中,通常会记录下每个池化窗口中最大值所在的位置,即池化索引。这些池化索引记录了原始图像中每个池化窗口中最显著的特征位置。

非线性上采样:传统的上采样方法通常是线性插值,例如双线性插值。而在SegNet中,利用了池化索引来执行非线性上采样,即根据池化索引的位置信息进行上采样操作。这种非线性上采样方法可以更好地保留原始图像中的重要特征位置和结构信息,有助于提高分割结果的准确性和细节保留能力。

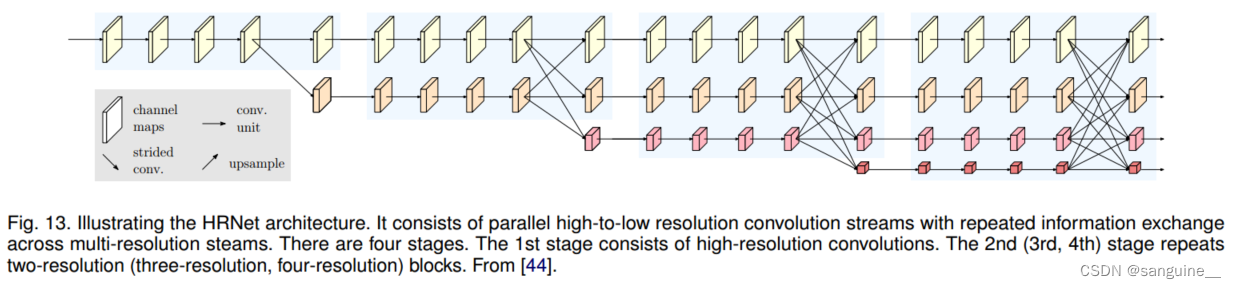

这一类别中另一个流行的模型是最近开发的分割网络,高分辨率网络(HRNet)[44]图13。与在DeConvNet、SegNet、U-Net和V-Net中恢复高分辨率表示不同,HRNet通过并行连接高到低分辨率卷积流,并在不同分辨率之间重复交换信息,从而在编码过程中保持高分辨率表示。最近关于语义分割的许多工作都是利用上下文模型(如自注意及其扩展)将HRNet作为主干。

(图13:说明HRNet体系结构。它由并行的高分辨率到低分辨率的卷积流组成,在多分辨率流之间进行重复的信息交换。有四个阶段。第一阶段由高分辨率卷积组成。第二(第三,第四)阶段重复两分辨率(三分辨率,四分辨率)块。从[44]。)

其他一些研究采用转置卷积或编码器-解码器进行图像分割,如堆叠反卷积网络(Stacked deconvolution Network, SDN)[45]、Linknet[46]、W-Net[47],以及用于RGBD分割的位置敏感反卷积网络[48]。基于编码器-解码器的模型的一个限制是由于在编码过程中丢失了高分辨率表示而丢失了图像的细粒度信息。然而,这个问题在最近的一些体系结构(如HR-Net)中得到了解决。

转置卷积是一种神经网络中常用的操作,用于实现上采样(upsampling)或反卷积(deconvolution)操作。它的作用是将输入特征图的尺寸放大,并且通常用于生成对抗网络(GANs)、语义分割、图像重建等任务中。

在转置卷积中,一个小的输入特征图通过转置卷积操作会被放大为一个更大尺寸的输出特征图。这种放大的过程类似于将一幅图像从低分辨率放大到高分辨率的过程。转置卷积操作可以增加特征图的尺寸,从而实现对图像信息的细化和扩展。

转置卷积的实现通常是通过使用带有可学习参数的卷积核,并结合适当的填充和步长设置来实现的。它的核心原理是将输入特征图的每个像素值扩展到更大的区域,并使用卷积核参数来控制像素值之间的权重关系,从而实现特征的放大和重建。

总的来说,转置卷积是一种在神经网络中常用的操作,用于实现特征图的上采样和图像的放大重建。

3.3.2 Encoder-Decoder Models for Medical and Biomedical Image Segmentation

有几个模型最初是为医学/生物医学图像分割开发的,它们受到fcn和编码器-解码器模型的启发。U-Net[49]和V-Net[50]是两种众所周知的此类架构,它们现在也被用于医疗领域之外。

Ronneberger等人提出的U-Net用于分割生物显微镜图像。他们的网络和训练策略依赖于数据增强,以有效地从极少量的标注图像中学习。U-Net架构包括两部分:一个用于捕获上下文的收缩路径,以及一个对称的扩展路径,用于实现精确定位。

具体来说:

- 收缩路径:用于捕获图像的全局上下文信息,采用类似全卷积网络(FCN)的结构,通过3×3卷积提取特征。

- 扩展路径:用于实现精确的像素级定位,采用上采样(或反卷积)操作,减少特征图数量同时增加它们的维度。

- 特征传递:网络中的下采样部分生成的特征图被复制到上采样部分,以避免丢失模式信息。

- 分割输出:最后,通过1×1卷积处理特征图,生成一个分割地图,对输入图像的每个像素进行分类。

U-Net在30个透射光显微镜图像上进行训练,并在2015年ISBI细胞跟踪挑战中取得了巨大的优势胜利。这表明U-Net在生物显微镜图像分割任务上取得了显著的成功,通过有效的网络设计和训练策略,即使在数据稀缺的情况下也能取得优异的性能。

针对不同类型的图像,开发了各种各样的U-Net扩展。例如,Cicek[51]提出了3D图像的U-Net架构。Zhou等人[52]开发了一种嵌套的U-Net架构。U-Net也被用于解决其他各种问题。例如,Zhang等[53]开发了一种基于U-Net的道路分割/提取算法。

Milletari等人提出的V-Net,这是另一个著名的基于全卷积网络(FCN)的模型,用于3D医学图像分割。他们引入了一种基于Dice系数的新目标函数进行模型训练,使模型能够处理前景和背景体素数量之间存在强烈不平衡的情况。该网络在前列腺MRI体积上进行端到端的训练,并学会一次性预测整个体积的分割。其他相关的医学图像分割工作包括用于从胸部CT图像中快速自动分割肺叶的渐进式密集V-Net(PDV-Net)等,以及用于病变分割的3D-CNN编码器。

具体来说:

-

Dice系数:是一种用于评估两个样本之间相似度的指标,常用于评估图像分割的准确性。通过基于Dice系数的目标函数,V-Net可以更好地处理前景和背景之间的体素数量不平衡,提高了分割的准确性和稳定性。

-

端到端训练:V-Net在MRI前列腺体积上进行端到端的训练,这意味着整个网络以原始数据作为输入,直接学习将输入映射到输出,而无需手动设计特征提取器或其他中间步骤。

-

其他相关工作:除了V-Net,还有一些其他医学图像分割的相关工作,如PDV-Net用于肺叶分割和3D-CNN编码器用于病变分割。这些工作表明在医学图像领域,基于深度学习的方法在自动化和准确性方面取得了显著进展。

3.4 Multi-Scale and Pyramid Network Based Models

多尺度分析:是一种在图像处理中常见的技术,旨在利用不同尺度的信息来提高算法的性能。通过在神经网络结构中引入多尺度分析,可以更好地捕获图像中的细节和全局信息,从而提高模型的准确性和鲁棒性。

Feature Pyramid Network (FPN):是由Lin等人提出的一种神经网络模型,最初用于目标检测,后来也被应用于图像分割任务。FPN利用深度卷积神经网络中固有的多尺度、金字塔式的层级结构,以较低的额外成本构建特征金字塔。为了合并低分辨率和高分辨率特征,FPN由自底向上路径、自顶向下路径和横向连接组成。连接的特征图然后通过3×3卷积进行处理,以生成每个阶段的输出。最后,自顶向下路径的每个阶段生成一个预测来检测对象。对于图像分割任务,作者使用两个多层感知器(MLP)来生成掩模。

Zhao等人[56]开发了金字塔场景解析网络(PSPN),这是一个多尺度网络,可以更好地学习场景的全局上下文表示(图15)。使用残差网络(ResNet)作为特征提取器,利用扩展网络从输入图像中提取不同的模式。然后将这些特征图输入到金字塔池模块中,以区分不同尺度的模式。它们在四个不同的尺度上汇集,每个尺度对应于一个金字塔级别,并通过一个1 × 1的卷积层进行处理,以减少它们的维度。金字塔级别的输出被上采样,并与初始特征映射连接,以捕获本地和全局上下文信息。最后,使用卷积层生成逐像素预测。

Ghiasi和Fowlkes[57]开发了一种基于拉普拉斯金字塔的多分辨率重建架构。

-

多分辨率重建架构:这是一种用于图像分割任务的架构,利用拉普拉斯金字塔来处理不同分辨率的特征图。通过从高分辨率特征图中引入跳跃连接和乘法门控,该架构逐步优化从低分辨率特征图重建的分割边界。这种方法可以帮助提高分割结果的准确性和细节。

-

空间分辨率和高维特征表示:作者指出,卷积特征图的表面空间分辨率可能较低,但高维特征表示中包含了重要的亚像素定位信息。这意味着即使在低分辨率下,卷积神经网络学习到的特征表示仍然包含有关像素级别细节的信息,通过适当的处理和重建,可以提高对图像细节的捕获和分割准确性。

还有其他使用多尺度分析进行分割的模型,如DM-Net(动态多尺度过滤器网络)[58]、上下文对比网络和门控多尺度聚合(CCN)[59]、自适应金字塔上下文网络(APC-Net)[60]、多尺度上下文交织(MSCI)[61]和显著目标分割[62]。

3.5 R-CNN Based Models (for Instance Segmentation)

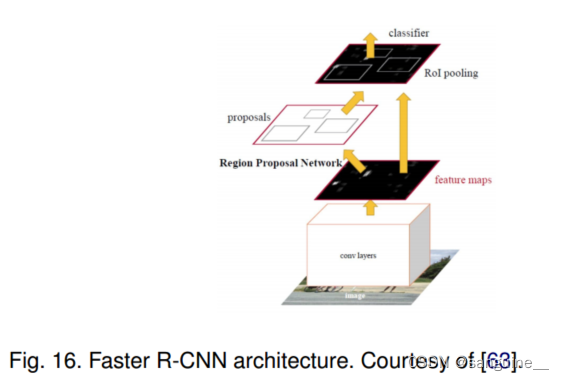

区域卷积网络(R-CNN)及其扩展(Fast R-CNN, Faster R-CNN, Maksed-RCNN)在目标检测应用中已经被证明是成功的。特别是,为目标检测而开发的Faster R-CNN[63]架构(图16)使用区域建议网络(RPN)来提出候选边界框。RPN提取感兴趣区域(RoI), RoIPool层从这些建议中计算特征,从而推断出边界框坐标和对象的类别。R-CNN的一些扩展已经被大量用于解决实例分割问题;即,同时执行对象检测和语义分割的任务。

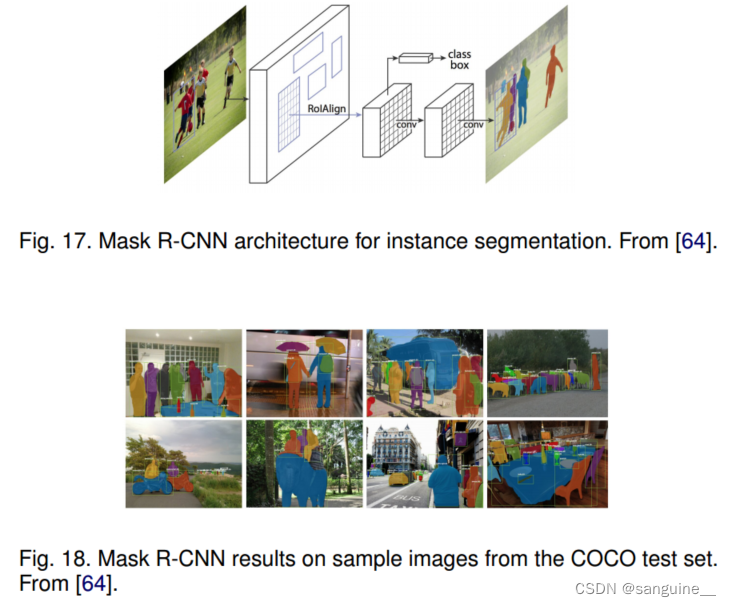

在该模型的一个扩展中,He等人[64]提出了用于对象实例分割的Mask R-CNN,该算法在许多COCO挑战中击败了之前的所有基准测试。该模型有效地检测图像中的物体,同时为每个实例生成高质量的分割掩码。Mask R-CNN本质上是一个具有3个输出分支的Faster RCNN(图17)——第一个计算边界框坐标,第二个计算相关的类,第三个计算二进制掩码以分割对象。Mask R-CNN损失函数将边界框坐标、预测类和分割掩码的损失结合起来,并对它们进行联合训练。图18显示了一些示例图像上的Mask-RCNN结果。

Liu等[65]提出的路径聚合网络(PANet)基于Mask R-CNN和FPN模型(图19)。该网络的特征提取器采用FPN结构和新的增强自底向上路径,改善了低层特征的传播。第三条路径的每个阶段都将前一阶段的特征映射作为输入,并使用3×3卷积层对它们进行处理。使用横向连接将输出添加到自顶向下路径的同一阶段特征图中,这些特征图为下一阶段提供信息。与Mask RCNN一样,自适应特征池化层的输出馈送三个分支。前两个使用完全连接的层来生成边界框坐标和相关对象类的预测。第三种是用FCN对RoI进行处理以预测目标掩码。

Dai等[66]开发了一个用于实例感知语义分割的多任务网络,该网络由三个网络组成,分别是区分实例、估计掩码和对对象进行分类。这些网络形成一个级联结构,并被设计成共享它们的卷积特征。Hu等人[67]提出了一种新的部分监督训练范式,以及一种新的权重传递函数,可以在大量的类别集上训练实例分割模型,所有类别都有框注释,但只有一小部分类别有蒙版注释。

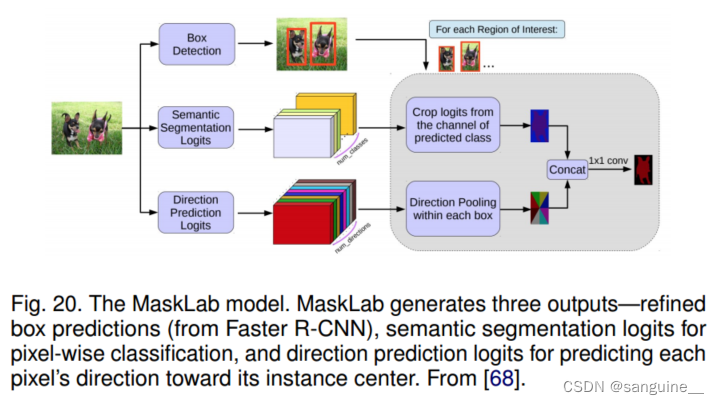

Chen等人[68]基于Faster R-CNN,通过使用语义和方向特征对目标检测进行细化,开发了一个实例分割模型MaskLab(图20)。该模型产生三种输出,盒检测、语义分割和方向预测。在fastrcnn对象检测器的基础上,预测框提供了对象实例的精确定位。在每个感兴趣的区域内,MaskLab通过结合语义和方向预测来执行前景/背景分割。

方向预测是指在图像处理和计算机视觉任务中,对于每个像素或区域预测其相对于某个参考方向的方向或角度。在图像分割、目标检测和场景理解等任务中,方向预测可以帮助模型更好地理解图像中对象或结构的方向信息,从而提高对图像内容的理解和分析能力。

具体来说,方向预测可以用于以下几个方面:

目标检测和识别:在目标检测任务中,方向预测可以帮助模型更准确地定位和识别目标对象的方向,例如车辆的行驶方向或人体的朝向。

实例分割:在实例分割任务中,方向预测可以帮助模型更好地理解对象的形状和结构,从而更准确地分割出不同实例之间的边界。

场景理解:在场景理解任务中,方向预测可以提供关于场景中物体或结构方向的信息,有助于更全面地理解图像内容。

通过方向预测,模型可以学习到图像中对象或结构的方向信息,从而提高对图像内容的理解和分析能力,进而改善各种计算机视觉任务的性能和准确性。

Tensormask是由Chen等人提出的一个有趣的模型,它基于密集滑动窗口实例分割。在这个模型中,他们将密集实例分割视为对4D张量的预测任务,并提出了一个通用框架,可以在4D张量上实现新颖的操作。他们展示了张量视图相对于基线方法的显著优势,并产生了与Mask R-CNN相媲美的结果。Tensormask在密集对象分割方面取得了令人满意的结果。简而言之,Tensormask是一种基于4D张量的实例分割模型,通过引入新的操作和框架,实现了对密集对象分割的有效预测,并在实验中表现出色。

基于R-CNN开发了许多其他实例分割模型,例如针对掩码提案开发的模型,包括R-FCN[70]、DeepMask[71]、PolarMask[72]、边界感知实例分割[73]和CenterMask[74]。值得注意的是,还有一个很有前景的研究方向,试图通过学习自下而上分割的分组线索来解决实例分割问题,如Deep Watershed Transform[75]、实时实例分割[76]和基于深度度量学习的语义实例分割[77]。

3.6 Dilated Convolutional Models and DeepLab Family

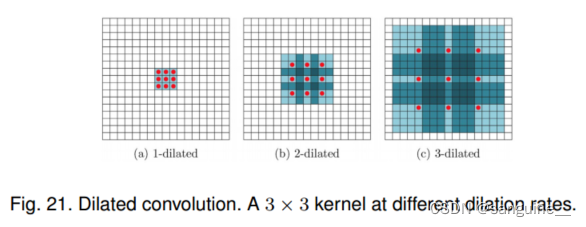

扩展卷积(又名“亚特罗斯”卷积)为卷积层引入了另一个参数,即扩展率。信号x(i)的扩展卷积(图21)定义为,其中r为定义核w权值间距的扩展率。例如,一个扩展率为2的3 × 3核在仅使用9个参数的情况下,将具有与5 × 5核相同大小的接受野,从而在不增加计算成本的情况下扩大了接受野。扩张卷积在实时分割领域中很受欢迎,最近的许多出版物都报道了这种技术的使用。其中最重要的包括DeepLab家族[78]、多尺度上下文聚合[79]、密集上采样卷积和混合扩张卷积(ducc - hdc)[80]、密集连接的亚特拉斯空间金字塔池(DenseASPP)[81]和高效神经网络(ENet)[82]。

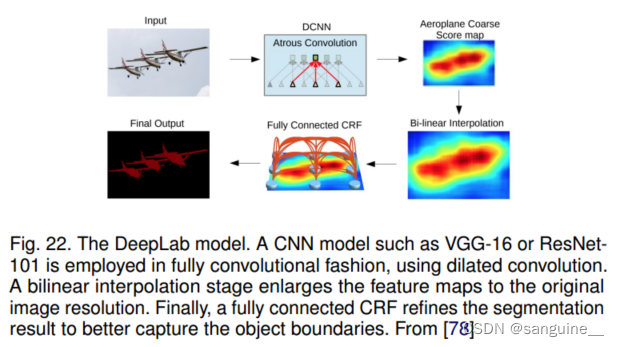

DeepLabv1和DeepLabv2是由Chen等人开发的一些最流行的图像分割方法之一。DeepLabv2具有三个关键特点:

-

使用扩张卷积(dilated convolution):用于解决网络中分辨率降低的问题,这是由最大池化和步幅引起的。扩张卷积可以扩大卷积核的感受野,从而在不丢失分辨率的情况下捕获更广泛的信息。

-

空洞空间金字塔池化(Atrous Spatial Pyramid Pooling,ASPP):通过在多个采样率下使用滤波器来探测传入的卷积特征层,从而在多个尺度上捕获对象和图像上下文,以稳健地在多个尺度上分割对象。

-

改进的对象边界定位:通过结合深度卷积神经网络和概率图模型的方法,改进了对象边界的定位。

最佳的DeepLab模型(使用ResNet-101作为骨干网络)在2012年PASCAL VOC挑战赛上达到了79.7%的mIoU分数,在PASCAL-Context挑战赛上达到了45.7%的mIoU分数,在Cityscapes挑战赛上达到了70.4%的mIoU分数。图22展示了DeepLab模型,与DeepLabv1类似,主要区别在于使用了扩张卷积和ASPP。

随后,Chen等人[12]提出了DeepLabv3,它结合了扩展卷积的级联和并行模块。并行卷积模块在ASPP中进行分组。在ASPP中加入了1 × 1卷积和批处理归一化。所有输出由另一个1 × 1卷积连接和处理,以创建具有每个像素logits的最终输出。

2018年,Chen等人[83]发布了Deeplabv3+,它使用编码器-解码器架构(图23),包括由深度卷积(输入的每个通道的空间卷积)和点卷积(1×1以深度卷积为输入的卷积)组成的可分离卷积。他们使用DeepLabv3框架作为编码器。最相关的模型具有改进的异常主干,具有更多层,扩展的深度可分离卷积,而不是最大池化和批处理归一化。在COCO和JFT数据集上进行预训练的最佳DeepLabv3+在2012年PASCAL VOC挑战中获得了89.0%的mIoU得分。

3.7 Recurrent Neural Network Based Models

虽然cnn很适合解决计算机视觉问题,但它们并不是唯一的可能。rnn在建模像素之间的短期/长期依赖关系方面很有用,可以(潜在地)改进分割图的估计。使用rnn,像素可以连接在一起并依次处理以建模全局上下文并改进语义分割。然而,其中一个挑战是图像的自然二维结构。

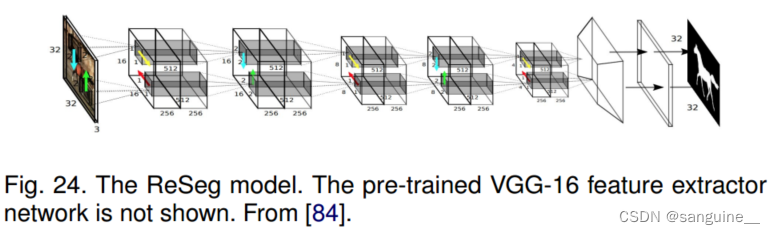

Visin等人提出了一种基于循环神经网络(RNN)的语义分割模型,名为ReSeg。这个模型主要基于另一项工作,即用于图像分类的ReNet。每个ReNet层由四个RNN组成,水平和垂直双向扫描图像,对补丁/激活进行编码,并提供相关的全局信息。为了使用ReSeg模型进行图像分割,ReNet层被堆叠在预训练的VGG-16卷积层之上,这些卷积层提取通用的局部特征。然后,ReNet层后面跟着上采样层,以恢复最终预测中的原始图像分辨率。采用门控循环单元(GRUs)是因为它们在内存使用和计算能力之间提供了良好的平衡。简而言之,ReSeg是一种基于RNN和ReNet的语义分割模型,通过在图像分类中使用的ReNet结构,结合RNN进行图像分割。这种方法利用RNN扫描图像并提取全局信息,以实现更准确的图像分割。

在另一项工作中,Byeon等人[86]使用长短期记忆(LSTM)网络开发了一种像素级的场景图像分割和分类。他们研究了自然场景图像的二维(2D) LSTM网络,考虑到标签的复杂空间依赖性。在这项工作中,分类、分割和上下文集成都是由2D LSTM网络进行的,允许在单个模型中学习纹理和空间模型参数。

Liang等[87]提出了一种基于图长短期记忆(Graph LSTM)网络的语义分割模型,这是将LSTM从序列数据或多维数据推广到一般的图结构数据。它不是在现有的多维LSTM结构(如行、网格和对角LSTM)中将图像均匀地划分为像素或斑块,而是将每个任意形状的超像素作为语义一致的节点,并自适应地为图像构建无向图,其中超像素的空间关系自然地用作边缘。图25给出了传统逐像素RNN模型和图- lstm模型的可视化比较。为了使Graph LSTM模型适应语义分割(图26),将建立在超像素地图上的LSTM层附加到卷积层上,以增强具有全局结构上下文的视觉特征。卷积特征通过1 × 1卷积滤波器生成所有标签的初始置信度图。通过基于初始置信度映射的置信度驱动方案确定后续图LSTM层的节点更新顺序,然后图LSTM层依次更新所有超像素节点的隐藏状态。

Xiang和Fox [88]提出了一种名为Data Associated Recurrent Neural Networks(DA-RNNs)的方法,用于联合3D场景映射和语义标记。DA-RNNs利用一种新的循环神经网络架构对RGB-D视频进行语义标记。网络的输出与Kinect-Fusion等映射技术集成在一起,以将语义信息注入重建的3D场景中。简而言之,DA-RNNs是一种用于3D场景映射和语义标记的方法,通过结合循环神经网络架构和RGB-D视频,将语义信息与映射技术相结合,以提高对重建3D场景的语义理解。

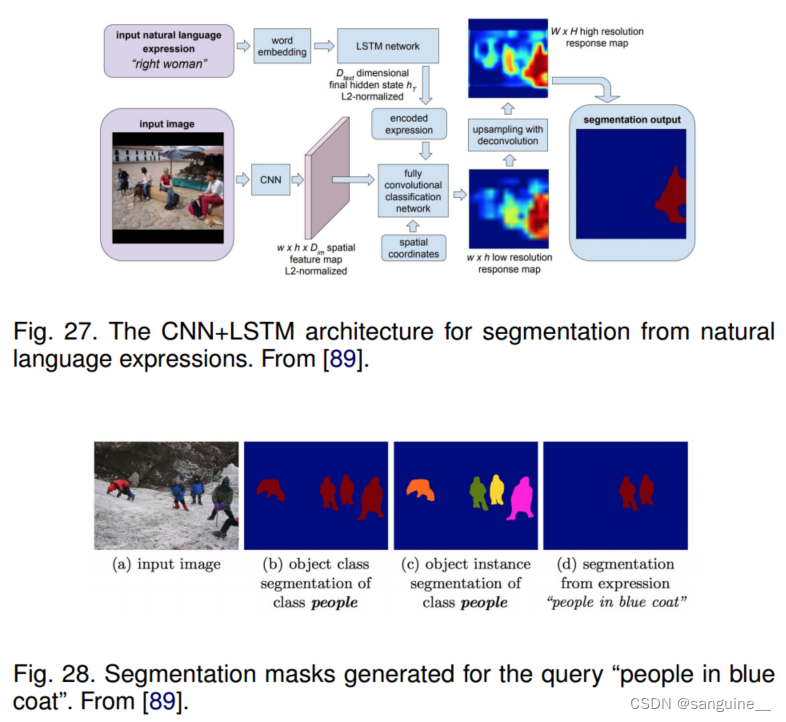

Hu等人[89]开发了一种基于自然语言表达的语义分割算法,利用CNN对图像进行编码,利用LSTM对其自然语言描述进行编码。这与传统的基于预定义语义类别集的语义分割不同,例如,“两个人坐在右边的长凳上”这样的短语需要将右边长凳上的两个人分割出来,而不是其他长凳上站着或坐着的人。为了为语言表达生成逐像素的分割,他们提出了一种端到端可训练的循环和卷积模型,共同学习处理视觉和语言信息(见图27)。在考虑的模型中,使用循环LSTM网络将指代表达式编码为向量表示,使用FCN从图像中提取空间特征图,并为目标对象输出空间响应图。该模型的一个示例分割结果(针对查询“穿蓝色外套的人”)如图28所示。简而言之,这项工作提出了一种结合了CNN和LSTM的模型,用于根据自然语言描述进行图像语义分割,以实现更精细的目标分割,而不仅仅是基于预定义的语义类别进行分割。

预定义的语义类别分割是指在图像分割任务中,将图像中的像素分配到预先定义的一组语义类别中的过程。这意味着每个像素被标记为属于某个特定的类别,如人、车辆、树木等,这些类别是在训练阶段提前定义好的。在预定义的语义类别分割中,模型的目标是根据这些固定的类别对图像进行分割,使得每个像素都被赋予一个特定的语义标签。

相比之下,基于自然语言表达的语义分割则允许根据自然语言描述来指导图像分割过程,从而实现更具有灵活性和精细度的目标分割。这种方法可以根据自然语言描述中的具体要求,仅将图像中符合描述的目标进行分割,而不受预定义类别的限制。

RNN(循环神经网络)模型的一个局限性是,由于这些模型的顺序性质,它们的运行速度会比其CNN(卷积神经网络)对应模型慢,因为这种顺序计算不能轻松地并行化。

由于RNN模型的顺序性质,每个时间步的计算都依赖于前一个时间步的结果,导致难以实现并行计算,从而使得RNN模型在处理大规模数据时速度较慢,相比之下,CNN模型能够更有效地利用并行计算的优势,因此在某些情况下可能比RNN模型更快速。

3.8 Attention-Based Models

注意力机制在计算机视觉领域一直受到持续探索,因此发现将这种机制应用于语义分割的研究论文并不令人意外。

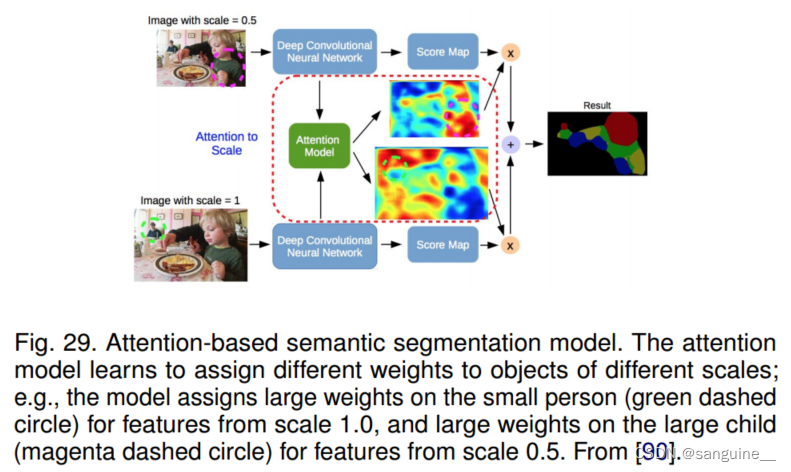

Chen等人[90]提出了一种学习在每个像素位置软加权多尺度特征的注意机制。他们采用了一种强大的语义分割模型,并与多尺度图像和注意力模型共同训练(图29)。注意机制优于平均池化和最大池化,使模型能够评估不同位置和尺度上特征的重要性。

(图29:基于注意力的语义分割模型。注意模型学习给不同尺度的物体分配不同的权重;例如,模型为来自1.0比例的特征赋予小个子(绿色虚线圈)较大的权重,为来自0.5比例的特征赋予大孩子(洋红色虚线圈)较大的权重。从[90]。)

与训练卷积分类器学习标记对象的代表性语义特征的其他工作不同,Huang等人[91]提出了一种使用反向注意机制的语义分割方法。他们的反向注意网络(RAN)架构(图30)训练模型捕捉相反的概念(即,与目标类不相关的特征)。RAN是一个三分支网络,同时执行正向和反向注意学习过程。

Li等[92]开发了一种用于语义分割的金字塔注意网络。该模型利用全局上下文信息对语义分割的影响。他们将注意力机制和空间金字塔结合起来,提取精确的密集特征用于像素标记,而不是复杂的扩张卷积和人为设计的解码网络。

最近,Fu等[93]提出了一种用于场景分割的双注意网络,该网络可以基于自注意机制捕获丰富的上下文依赖关系。具体来说,他们在扩展的FCN上附加了两种类型的注意力模块,分别在空间和通道维度上对语义相互依赖进行建模。位置注意模块通过所有位置特征的加权和选择性地聚合每个位置的特征。

其他许多研究都探讨了语义分割的注意机制,如OCNet[94]提出了一种受自我注意机制启发的对象上下文池,期望最大化注意(EMANet)[95],交叉注意网络(CCNet)[96],端到端实例分割与循环注意[97],场景解析的点向空间注意网络[98],以及判别特征网络(DFN)[99],其中包括两个子网络:平滑网络(包含通道注意块和全局平均池来选择更具区别性的特征)和边界网络(使边界的双边特征可区分)。

3.9 Generative Models and Adversarial Training

自从gan被引入以来,它已经被广泛应用于计算机视觉的任务中,也被用于图像分割

Luc等[100]提出了一种用于语义分割的对抗性训练方法。他们训练了一个卷积语义分割网络(图31),以及一个对抗网络,该网络从分割网络生成的分割地图中区分出真实的分割地图。他们表明,对抗性训练方法可以提高斯坦福背景和PASCAL VOC 2012数据集的准确性。

Souly等人提出了使用生成对抗网络(GANs)进行半弱监督语义分割的方法。在这种方法中,有一个生成器网络提供额外的训练样本给一个多类别分类器,该分类器在GAN框架中充当鉴别器,为样本分配一个来自K个可能类别的标签y,或将其标记为伪样本(额外类别)。

半弱监督学习是一种介于强监督学习和弱监督学习之间的学习方式。在半弱监督学习中,模型在训练过程中同时使用有标签数据和部分无标签数据。在这种情况下,生成对抗网络(GANs)被用于利用额外的无标签数据来提高语义分割模型的性能。生成器网络生成额外的训练样本,这些样本被用于帮助多类别分类器学习更好地对图像进行语义分割。鉴别器网络则负责判断生成的样本是真实样本(有标签数据)还是伪样本(额外类别),从而帮助模型进行半弱监督学习。

在另一项工作中,Hung等人[102]开发了一个使用对抗网络的半监督语义分割框架。他们设计了一个FCN鉴别器,在考虑空间分辨率的情况下,将预测概率图与ground truth 分割分布区分开来。该模型考虑的损失函数包含三个方面:分割基础真值上的交叉熵损失、鉴别器网络的对抗损失和基于置信度映射的半监督损失;即鉴别器的输出。

FCN鉴别器指的是Fully Convolutional Network(全卷积网络)中的鉴别器部分。在生成对抗网络(GANs)中,通常包含一个生成器网络和一个鉴别器网络。在FCN中,鉴别器网络通常用于判断生成的图像或特征图是真实数据还是生成数据。

在语义分割任务中,FCN鉴别器可以被设计为一个网络,用于区分生成的语义分割图与真实的语义分割图。通过训练鉴别器网络,可以使生成器网络生成更逼真的语义分割结果,从而提高整体的分割性能。

因此,FCN鉴别器在全卷积网络中扮演着重要的角色,帮助生成对抗网络学习生成更准确的语义分割结果。

Xue等人提出了一种用于医学图像分割的带有多尺度L1损失的对抗网络。他们使用了一个全卷积网络(FCN)作为分割器,用于生成分割标签地图,并提出了一种新颖的对抗性评论网络,其中包含一个多尺度L1损失函数,以促使评论者和分割器学习捕捉像素之间长距离和短距离空间关系的全局和局部特征。

其他各种出版物报道了基于对抗性训练的分割模型,例如使用gan的细胞图像分割[104],以及物体不可见部分的分割和生成[105]。

3.10 CNN Models With Active Contour Models

fcns与活动轮廓模型(Active Contour Models, acm)之间协同作用的探索[7]最近引起了研究兴趣。一种方法是制定受ACM原理启发的新损失函数。例如,受[106]的全局能量公式的启发,Chen等人[107]提出了一种监督损失层,该层在FCN训练过程中结合了预测掩模的面积和大小信息,解决了心脏MRI中心室分割的问题。

活动轮廓模型(Active Contour Model,ACM),也称为“蛇”(Snake),是一种在图像处理和计算机视觉领域常用的技术。活动轮廓模型是一种基于能量最小化的方法,用于在图像中找到感兴趣的对象的边界或轮廓。

活动轮廓模型通常由一个表示轮廓的曲线或曲面组成,该曲线或曲面在图像中移动以适应对象的边界。通过定义能量函数,活动轮廓模型可以根据图像的特征和先验知识来调整轮廓的形状,以使其与对象的边界对齐。

在图像分割任务中,活动轮廓模型可以用于自动或半自动地提取图像中的对象或区域。通过在图像中移动轮廓并最小化能量函数,活动轮廓模型可以帮助识别对象的边界,并实现准确的分割。

活动轮廓模型在医学图像分割、目标跟踪、图像重建等领域都有广泛的应用,是一种常见且有效的图像处理技术。

一种不同的方法最初试图将ACM仅仅用作FCN输出的后处理器,并尝试通过预训练FCN进行适度的共同学习。用于自然图像语义分割任务的ACM后处理器的一个例子是Le等人[108]的工作,其中将水平集ACM实现为rnn。Rupprecht等人的深度活动轮廓[109]是另一个例子。对于医学图像分割,Hatamizadeh等[110]提出了一种集成的深度活动病灶分割(DALS)模型,该模型训练FCN主干来预测一种新的局部参数化水平集能量泛函数的参数函数。在另一项相关研究中,Marcos等人[111]提出了深度结构化活动轮廓(Deep Structured Active Contours, DSAC),它将acm和预训练fcn结合在一个结构化预测框架中,用于在航空图像中构建实例分割(尽管需要手动初始化)。对于同一个应用程序,Cheng等[112]提出了与DSAC类似的深度活动射线网络(DarNet),但采用了基于极坐标的不同显式ACM公式,以防止轮廓自相交。Hatamizadeh等人[113]最近提出了一种真正的端到端反向传播可训练、完全集成的FCN-ACM组合,称为深度卷积主动轮廓(Deep Convolutional Active Contours, DCAC)。

3.11 Other Models

除了上述模型之外,还有其他几种流行的深度学习分割架构,例如:上下文编码网络(EncNet),它使用基本特征提取器并将特征映射提供给上下文编码模块[114]。RefineNet[115],这是一个多路径细化网络,明确地利用下采样过程中可用的所有信息,利用远程剩余连接实现高分辨率预测。Seednet[116],它引入了一种带有深度强化学习的自动种子生成技术,可以学习解决交互式分割问题。”“对象-上下文表示”(OCR)[44],它在ground-truth的监督下学习对象区域,并计算对象区域表示,以及每个像素与每个对象区域之间的关系,并用对象上下文表示增强表示像素。其他模型包括BoxSup[117]、Graph convolutional networks[118]、Wide ResNet[119]、Exfuse(增强底层和高层特征融合)[120]、Feedforward-Net[121]、显著性感知模型用于测量视频分割[122]、双图像分割(DIS)[123]、FoveaNet(视角感知场景解析)[124]、Ladder DenseNet[125]、双边分割网络(BiSeNet)[126]、场景解析语义预测指导(SPGNet)[127]、门状cnn[128]、自适应上下文网络(AC-Net)[129]、动态结构语义传播网络(DSSPN)[130]、符号图推理(SGR)[131]、CascadeNet[132]、尺度自适应卷积(SAC)[133]、统一感知解析(UperNet)[134]、通过再训练和自训练进行分割[135]、密集连接的神经结构搜索[136]、分层多尺度关注[137]。

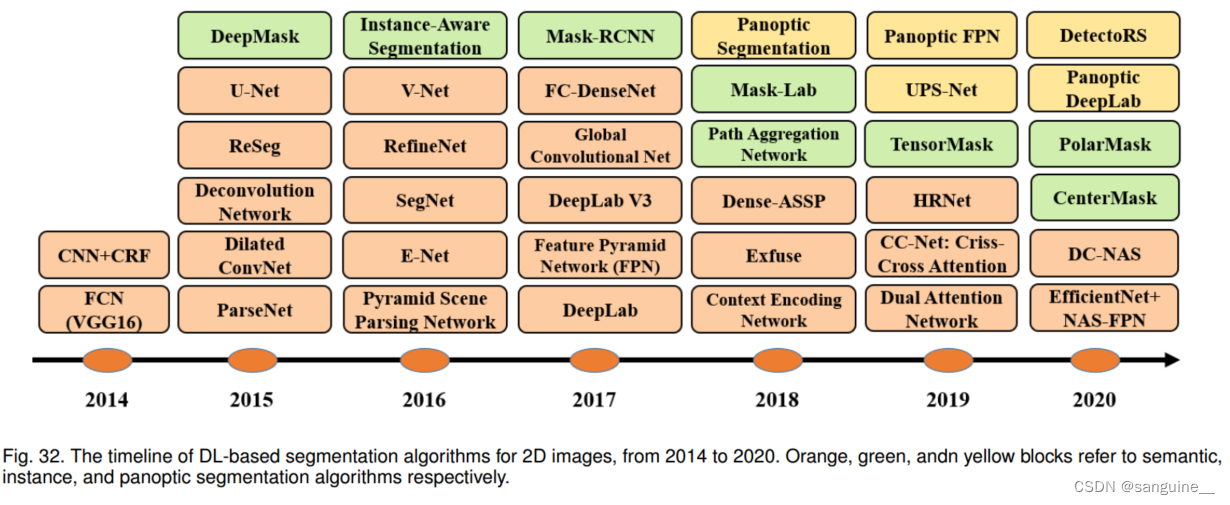

Panoptic segmentation[138]也是另一个越来越受欢迎的有趣的分割问题,在这个方向上已经有了一些有趣的工作,包括Panoptic Feature Pyramid Network[139]、注意力引导的Panoptic segmentation[140]、Seamless Scene segmentation[141]、Panoptic deeplab[142]、统一的Panoptic segmentation Network[143]、高效的Panoptic segmentation[144]。图32展示了2014年以来基于dl的语义分割流行作品的时间轴,以及实例分割。鉴于近年来发展起来的大量作品,我们只展示一些最具代表性的作品。

4 IMAGE SEGMENTATION DATASETS

在本节中,我们提供了一些最广泛使用的图像分割数据集的总结。我们将这些数据集分为3类- 2d图像,2.5D RGB-D(颜色+深度)图像和3D图像-并提供有关每个数据集特征的详细信息。列出的数据集具有逐像素的标签,可用于评估模型性能。

- 一些工作使用数据增强来增加标记样本的数量,例如医学图像分析中的数据集。它也有利于产生更快的收敛,减少过拟合的机会,并增强泛化。(平移、反射、旋转、扭曲、缩放、色彩空间移动、裁剪和对主成分的投影。)

4.1 2D Datasets

以下是一些最受欢迎的:

-

PASCAL Visual Object Classes (VOC)[145]是计算机视觉中最流行的数据集之一,带有注释的图像可用于5个任务:分类、分割、检测、动作识别和人物布局。几乎所有文献中报道的流行分割算法都在这个数据集上进行了评估。对于分割任务,有21类对象标签:车辆、家庭、动物、飞机、自行车、船、公共汽车、汽车、摩托车、火车、瓶子、椅子、餐桌、盆栽、沙发、电视/监视器、鸟、猫、牛、狗、马、羊、人(如果像素不属于这些类别,则标记为背景)。该数据集分为训练集和验证集两组,分别有1464张和1449张图像。有一个针对实际挑战的私人测试集。图33显示了一个示例图像及其逐像素标签

- PASCAL Context[147]是PASCAL VOC 2010检测挑战的扩展,它包含所有训练图像的像素级标签。它包含400多个类(包括最初的20个类加上来自PASCAL VOC分割的背景),分为三类(对象,材料和混合)。该数据集的许多对象类别过于稀疏,而且;因此,通常选择59个常用类的子集来使用。

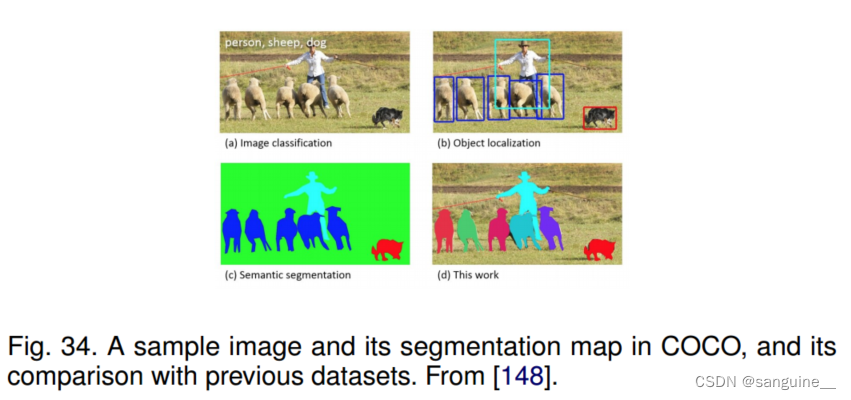

- 微软公共对象上下文(MS COCO)[148]是另一个大规模对象检测、分割和字幕数据集。COCO包含了复杂的日常场景的图像,其中包含了自然环境中的常见物体。该数据集包含91种对象类型的照片,在328k张图像中总共有250万个标记实例。图34显示了给定样本图像的MS-COCO标签与先前数据集之间的差异。检测挑战包括80多个类,提供超过82k的图像用于训练,40.5k的图像用于验证,超过80k的图像用于测试集。

-

cityscape[149]是一个关注城市街景语义理解的大型数据库。它包含了来自50个城市的街道场景中记录的各种立体视频序列,除了一组20k弱注释帧外,还具有5k帧的高质量像素级注释。它包括30类语义和密集的像素注释,分为8类:平面、人、交通工具、建筑、物体、自然、天空和虚空。图35显示了来自该数据集的四个样例分割映射。

- ADE20K /MIT场景解析(SceneParse150)为场景解析算法提供了一个标准的训练和评估平台。该基准测试的数据来自ADE20K数据集[132],该数据集包含超过20K的以场景为中心的图像,用对象和对象部分进行了详尽的注释。基准分为20K图像进行训练,2K图像用于验证,另一批图像用于测试。这个数据集中有150个语义类别。

- sifflow[150]包括来自LabelMe数据库子集的2,688张带注释的图像。这些256 × 256像素的图像基于8种不同的户外场景,其中包括街道、山脉、田野、海滩和建筑物。所有图像都属于33个语义类中的一个。

- 斯坦福背景[151]包含来自现有数据集的场景户外图像,如LabelMe、MSRC和PASCAL VOC。它包含715张至少有一个前景对象的图像。该数据集是逐像素注释的,可用于语义场景理解。使用Amazon的Mechanical Turk (AMT)获得该数据集的语义和几何标签。

- 伯克利分割数据集(BSD)[152]包含来自30个人类受试者的1000个Corel数据集图像的12,000个手工标记的分割。旨在为图像分割和边界检测的研究提供实证依据。一半的分割是通过向受试者呈现彩色图像获得的,另一半是通过呈现灰度图像获得的。

- YouTube - objects[153]包含从YouTube收集的视频,其中包括10个PASCAL VOC类(飞机、鸟、船、汽车、猫、牛、狗、马、摩托车和火车)的对象。原始数据集不包含逐像素的注释(因为它最初是为对象检测而开发的,带有弱注释)。然而,Jain等[154]手动标注了126个序列的子集,然后提取了一个子集的帧,进一步生成语义标签。总的来说,在这个数据集中有大约10,167个带注释的480 × 360像素帧可用。

- KITTI[155]是移动机器人和自动驾驶领域最流行的数据集之一。它包含数小时的交通场景视频,使用各种传感器模式(包括高分辨率RGB,灰度立体摄像机和3D激光扫描仪)记录。原始数据集不包含用于语义分割的ground truth,但研究人员为了研究目的对数据集的部分进行了手动注释。例如,Alvarez等人[156]为道路检测挑战中的323张图像生成了地面真值,分为道路、垂直和天空3类。

- 其他数据集也可用于图像分割目的,如语义边界数据集(SBD) [157], PASCAL Part [158], SYNTHIA[159],和Adobe的人像分割[160]。

4.2 2.5D Datasets

NYU-D V2[161]由来自各种室内场景的视频序列组成,由微软Kinect的RGB和深度摄像头记录。它包括来自3个城市的450多个场景的1449对密集标记的对齐RGB和深度图像。每个对象都标有一个类和一个实例号(例如,cup1、cup2、cup3等)。它还包含407,024个未标记的帧。与其他现有数据集相比,该数据集相对较小。图36显示了一个示例图像及其分割映射。

SUN-3D[162]是一个大规模RGB-D视频数据集,包含41个不同建筑中254个不同空间捕获的415个序列;已经标注了8个序列,以后还会标注更多。每个带注释的帧都带有场景中物体的语义分割,以及关于相机姿势的信息。

SUN RGB-D[163]为在所有主要场景理解任务中推进最先进的目标提供了一个RGB-D基准。它由四个不同的传感器捕获,包含10,000张类似PASCAL VOC的RGB-D图像。整个数据集被密集标注,包括146,617个2D多边形和58,657个具有精确对象方向的3D边界框,以及场景的3D房间类别和布局。

UW RGB-D对象数据集[164]包含300个使用Kinect式3D摄像机记录的常见家庭物体。这些对象被组织成51个类别,使用WordNet上-下名关系进行排列(类似于ImageNet)。该数据集使用Kinect式3D相机记录,该相机记录同步和对齐640×480像素RGB和深度图像,频率为30 Hz。该数据集还包括8个自然场景的注释视频序列,包含来自数据集(UW RGB-D场景数据集)的对象。

ScanNet[165]是一个RGB-D视频数据集,包含超过1500次扫描的250万次观看,带有3D相机姿势、表面重建和实例级语义分割的注释。为了收集这些数据,设计了一个易于使用和可扩展的RGB-D捕获系统,包括自动表面重建,并且语义标注是众包的。使用这些数据有助于在几个3D场景理解任务上实现最先进的性能,包括3D对象分类、语义体素标记和CAD模型检索。

4.3 3D Datasets

略

5 PERFORMANCE REVIEW

5.1 Metrics For Segmentation Models

理想情况下,应该从多个方面对模型进行评估,例如定量准确性、速度(推理时间)和存储需求(内存占用)。然而,到目前为止,大多数研究工作都集中在评估模型准确性的指标上。

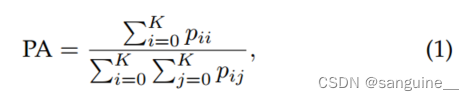

像素精度只是找到正确分类的像素的比例,除以总像素数。对于K + 1类(K个前景类和背景类),像素精度定义为Eq 1:

其中pij是类I预测的属于类j的像素数。

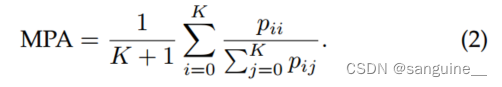

平均像素精度(MPA)是PA的扩展版本,其中以每类的方式计算正确像素的比例,然后在类的总数上取平均值,如Eq 2:

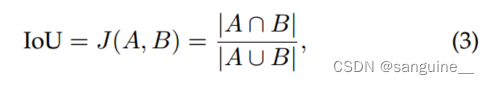

交集/联合(IoU)或Jaccard索引是语义分割中最常用的度量之一。定义为预测分割图与the ground truth的相交面积除以预测分割图与the ground truth的并集面积:

其中A和B分别表示真实值和预测分割图。取值范围为0 ~ 1

Mean-IoU是另一个流行的度量,它被定义为所有类的Mean-IoU。它被广泛用于报告现代分割算法的性能。

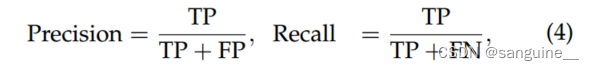

精度/召回率/ F1分数是报告许多经典图像分割模型准确性的流行指标。精确度和召回率可以为每个类定义,也可以在聚合级别定义,如下所示:

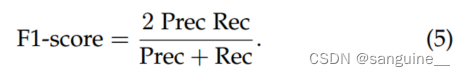

式中TP为真阳性分数,FP为假阳性分数,FN为假阴性分数。通常我们感兴趣的是准确率和召回率的组合。一种流行的度量被称为F1分数,它被定义为精度和召回率的调和平均值:

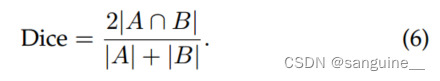

Dice coefficient 是图像分割的另一个流行度量(在医学图像分析中更常用),它可以定义为预测图和真实图重叠面积的两倍,除以两个图像中的总像素数。Dice系数与IoU非常相似:

当应用于布尔数据(例如,二值分割图),并将前景作为一个正类时,Dice系数本质上与F1分数相同,定义为Eq 7:

5.2 Quantitative Performance of DL-Based Models

下表总结了几种著名的基于dl的分割模型在不同数据集上的性能。表1着重于PASCAL VOC测试集。显然,自从引入FCN(第一个基于dl的图像分割模型)以来,模型的准确性有了很大的提高。表2关注的是Cityscape测试数据集。最新模型在该数据集上比初始FCN模型的相对增益约为23%。

表3关注的是MS COCO材料测试集。这个数据集比PASCAL VOC和Cityescapes更具挑战性,因为最高的mIoU约为40%。表4侧重于ADE20k验证集。这个数据集也比PASCAL VOC和Cityescapes数据集更具挑战性。

表5提供了在COCO test-dev 2017数据集上突出的实例分割算法在平均精度和速度方面的性能。表6提供在MS-COCO val数据集上,突出的全景分割算法在全景质量方面的表现[138]。最后,表7总结了几种主要的RGB-D分割模型在NYUD-v2和SUN-RGBD数据集上的性能

6 CHALLENGES AND OPPORTUNITIES

6.1 More Challenging Datasets

为了语义分割和实例分割,已经创建了几个大规模的图像数据集。然而,仍然需要更多具有挑战性的数据集,以及不同类型图像的数据集。对于静止图像,具有大量对象和重叠对象的数据集将非常有价值。这可以使训练模型更好地处理密集的对象场景,以及在现实世界场景中常见的对象之间的大重叠。

随着三维图像分割的日益普及,特别是在医学图像分析中,对大规模三维图像数据集的需求也越来越大。这些数据集比低维数据集更难创建。现有的用于3D图像分割的数据集通常不够大,有些是合成的,因此更大、更具挑战性的3D图像数据集可能非常有价值。

6.2 Interpretable Deep Models

虽然基于dl的模型在具有挑战性的基准测试中取得了令人鼓舞的性能,但关于这些模型仍然存在一些悬而未决的问题。例如,深度模型到底在学习什么?我们应该如何解释这些模型学习到的特征?什么是能够在给定数据集上达到一定分割精度的最小神经结构?虽然有一些技术可以可视化这些模型的学习卷积核,但缺乏对这些模型的潜在行为/动态的具体研究。更好地理解这些模型的理论方面可以开发出针对各种细分场景的更好的模型。

6.3 Weakly-Supervised and Unsupervised Learning

弱监督学习(又名少镜头学习)[182]和无监督学习[183]正在成为非常活跃的研究领域。由于在许多应用领域,特别是在医学图像分析中,为分割问题收集标记样本是有问题的,因此这些技术在图像分割方面具有特别的价值。迁移学习方法是在大量标记样本(可能来自公共基准)上训练通用图像分割模型,然后在一些特定目标应用程序的样本上对该模型进行微调。

自监督学习是另一个很有前途的方向,在各个领域都引起了很大的关注。在自监督学习的帮助下,可以捕获图像中的许多细节,用更少的训练样本来训练分割模型。基于强化学习的模型也可能是另一个潜在的未来方向,因为它们很少受到图像分割的关注。例如,MOREL[184]引入了一种用于视频中运动物体分割的深度强化学习方法。

6.4 Real-time Models for Various Applications

在许多应用中,精度是最重要的因素;然而,在一些应用中,分割模型也很重要,它可以在接近实时的情况下运行,或者至少接近普通相机帧速率(至少每秒25帧)。这对于部署在自动驾驶汽车上的计算机视觉系统非常有用。目前的大多数模型都远没有达到这个帧率;例如,FCN8处理低分辨率图像大约需要100毫秒。

基于扩展卷积的模型在一定程度上有助于提高分割模型的速度,但仍有很大的改进空间。

6.5 Memory Efficient Models

许多现代分割模型即使在推理阶段也需要大量的内存。到目前为止,很多努力都是为了提高这些模型的准确性,但为了使它们适合特定的设备,如移动电话,网络必须简化。这可以通过使用更简单的模型,或者使用模型压缩技术来实现,甚至可以训练一个复杂的模型,然后使用知识蒸馏技术将其压缩成一个更小的、内存效率更高的网络来模仿复杂的模型。

6.6 3D Point-Cloud Segmentation

大量的工作集中在二维图像分割,但很少有解决三维点云分割。然而,人们对点云分割越来越感兴趣,它在3D建模、自动驾驶汽车、机器人、建筑建模等方面有着广泛的应用。处理三维无序和非结构化数据(如点云)带来了几个挑战。例如,在点云上应用cnn和其他经典深度学习架构的最佳方式尚不清楚。基于图的深度模型可能是点云分割的一个潜在探索领域,可以实现这些数据的其他工业应用

6.7 Application Scenarios

在本节中,我们简要地研究了最近基于dl的分割方法的一些应用场景,以及未来的一些挑战。最值得注意的是,这些方法已经成功地应用于遥感领域的卫星图像分割[185],包括城市规划[186]或精准农业[187]的技术。机载平台[188]和无人机[189]收集的遥感图像也使用基于dl的技术进行了分割,为解决涉及气候变化等重要环境问题提供了机会。分割这类图像的主要挑战与数据的非常大的维度(通常由具有数百甚至数千个光谱带的成像光谱仪收集)和有限的真实信息有关,以评估分割算法获得的结果的准确性。基于dl的分割的另一个非常重要的应用领域是医学成像[190]。在这里,一个机会是设计可用于评估快速传播的新疾病和流行病的标准化图像数据库。最后但并非最不重要的是,我们还应该提到生物学[191]和建筑材料评估[192]中基于dl的分割技术,这些技术为解决高度相关的应用领域提供了机会,但也面临着与大量相关图像数据和用于验证目的的有限参考信息相关的挑战。

7 CONCLUSIONS

我们调查了100多种基于深度学习模型的最新图像分割算法,这些算法在各种图像分割任务和基准测试中取得了令人印象深刻的表现,分为十类,如:CNN和FCN、RNN、R-CNN、扩展CNN、基于注意力的模型、生成和对抗模型等。我们总结了这些模型在一些流行基准(如PASCAL VOC、MS COCO、cityscape和ADE20k数据集)上的定量性能分析。最后,我们讨论了图像分割在未来几年可能面临的一些挑战和潜在的研究方向。

3444

3444

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?