微观角度的可解释性,一个深度学习模型的可解释性是其内 在的固有性质,指模型的决策在多大程度上可以被人类预测和理解。模型的可解释性越强,代表模 型的行为对人类越透明,模型的不确定性也就越低;反之模型的可解释性越弱,模型做出预测的机 制就不能被人类所理解,它的不可控性也越大

主动解释 和事后解释两大类:主动解释为模型在做出预测的过程中可以同时生成相应的解释,如注意力显著 性在网络前向传播时即可生成,自我可解释的网络会设计一些可解释单元。事后解释为在模型做出 决策之后,通过一些算法来有效地揭示模型做出预测的原因

可解释深度知识追踪模型

刘坤佳-国防科技大学博士 2021年10月21月

引言

目前知识追踪存在的问题:

当前知识追踪方法多针对知识点建模,忽略了习题信息建模与用户个性化表征,并且对于预测结果缺乏可解释性

当前深度知识追踪方法多针对习题对应的知识点建模,而忽视了题目本身蕴含的丰富信息.例如,考察同一知识点的不同题目可能由于难度设置不同而导致不同的作答结果.另外,目前的方法假设学生认知水平变化程度相同,忽视了学生认知状态与习题表示的个性化交互,因此无法建模学生知识状态变化的个体差异.再者,基于深度学习的方法预测过程和结果缺乏可解释性.在实际应用中,尤其是在线教育领域,可解释的预测结果不仅可以提升系统透明度,还能提高用户对系统的信任和对预测结果的接受程度.当前的研究对预测结果的可解释性多集中在为认知状态变化过程提供可视化展示,但是并未给出得到当前预测结果所依据的推理路径,因此不能直接为预测结果提供解释

解决方法

1)利用习题与知识点的上下文信息挖掘其间隐含关系,丰富习题知识点图关系类型,缓解数据稀疏问题;

2)基于用户认知状态学习个性化注意力权重,得到习题知识点关系图中用户对不同邻居节点的关注程度,充分考虑用户知识状态差异,实现习题个性化表示;

3)提供一种可解释框架,通过个性化注意力机制,在习题知识点关系图中选择推理路径,实现对知识追踪结果的可解释;

4)在多个知识追踪数据集上对提出的IDKT模型进行广泛验证,均取得最佳预测表现,有力验证了所提模型的有效

相关工作

EKT,余玄相似度计算习题之间的相似性,以此作为知识状态的权重,提高预测能力的同时也为结果提供可解释性,Deep-IRT将DKT与IRT(深度信息反应理论)结合,保留了深度学习的预测能力,同时参照IRT 理论,从习题难度和用户个人能力2方面为预测结果提供解释.上下文感知的注意力知识追踪

模型框架

如图4所示,IDKT 生成了2 条推理路径:对照id的实际含义,就可以对所得推理路径进行解释.以推理路径1为例,模型预测用户未正确作答id为86623的习题可能因为其考察了id为280的知识点.而知识点280与知识点310相关,由此得出的解释路径是,用户在知识点310存在薄弱环节导致当前习题没有回答正确.通过以上过程,IDKT 将个性化注意力权值转化为推理路径,为结果提供可解释性.该解释可以指导用户找出学习过程的薄弱知识点,也可以为后续个性化学习资源推荐、智能问答等提供依据

展望

后续工作将主要研究引入更丰富上下文知识的方法,将习题知识点图扩展为有向带权图,以此有效刻画知识之间先修关系的方向性和节点之间的关联程度差别

Deep-IRT Make Deep Learning Based Knowledge Tracing Explainable Using Item Response Theory

解决问题:深度知识追踪模型其参数和表示长期以来一直被批评为无法解释。

Deep-IRT,它是项目响应理论 (IRT) 模型和基于称为动态键值记忆网络 (DKVMN) 的深度神经网络架构的知识追踪模型的综合,用于进行深度学习基于可解释的知识追踪。具体来说,我们使用 DKVMN 模型来处理学生的学习轨迹,并随着时间的推移估计项目难度水平和学生能力。然后,我们使用 IRT 模型使用估计的学生能力和项目难度来估计学生正确回答项目的概率。实验表明,Deep-IRT 模型保留了 DKVMN 模型的性能,同时提供了对学生和项目的直接心理解释。

引言

据我们所知,还没有一个模型是高度复杂和通用的,但同时可以解释。因此,设计一个继承这两个类别优点的模型是很有吸引力的。

本文提出深度项目反应理论(Deep- IRT来解释基于深度学习的知识追踪模型。Deep- IRT模型的灵感来自贝叶斯深度学习[17]学习模型和心理测量模型。具体来说Deep- IRT模型利用DKVMN模型来处理输入数据,并返回IRT模型的心理上有意义的参数。DKVMN模型执行特征工程工作,从学生的历史问答交互中提取潜在特征。然后,所提取的潜在特征被用于推断随着时间的推移每个KC的难度水平和学生能力。基于估计的学生能力和KC难度水平,IRT模型预测学生正确回答KC的概率。通过用DKVMN模型和IRT模型来描述知识追踪任务,我们从这两个模型中获得了优点。Deep- IRT模型受益于深度学习技术的进步,例如,捕捉人类难以设计的特征。另一方面,我们通过引入一个众所周知的心理测量模型来增强可解释性,这个模型很容易被许多人理解。

我们的实验表明,提出的Deep- IRT模型保留了DKVMN模型的性能。我们还通过Deep- IRT模型对难度水平和学生的学习能力进行了分析。分析表明,Deep- IRT模型估计的难度水平与其他传统方法一致,如IRT模型和项目分析[1]。然而,深IRT模型仍然存在DKT模型中发现的重建问题[20]。

我们的主要贡献总结如下:

- 提出的Deep- IRT知识追踪模型能够推断对学生能力和KCs难度水平的有意义的估计,同时保留了基于深度学习的知识追踪模型的预测能力。

- Deep- IRT模型通过利用整个学习轨迹,而不是传统的教育测试环境,潜在地提供了一种估计KC难度水平的替代方法。

- 我们建议使用深度学习模型来输出心理测量模型的参数,以便利用深度学习能力并提供可解释的心理测量参数。除了知识追踪任务之外,这种思想还可以应用到其他地方。

模型

基于多层注意力网络的可解释认知追踪方法

华中师范大学

引言

贡献:

1)针对当前深度认知追踪模型对预测结果普遍缺乏可解释性或仅通过建模题目之间浅层关系提供解释的问题,提出了一种通过多层注意力网络挖掘题目多语义深层关联信息的方法,能够显著提升模型对预测结果的可解释性.

2)提出了评估认知追踪模型预测结果是否具有可解释性的基本思想,由此设计了提升模型可解释性的损失函数以及预测结果可解释性度量指标

相关工作

根据解释的对象可解释知识追踪可以分为两类,

| 面向学生认知状态的解释 | 模型内部存在可理解的参数对应每个技能的掌握状态(标量值). deep-irt,其主要方式是将深度模型的输出作为IRT模型的输入,进而利用IRT 模型做预测.由于IRT 模型的约束,深度模型的输出可以对应IRT模型中可解释的参数(比如可理解的认知状态、学生能力、题目难度等). |

| 面向模型预测过程的解 释 | 旨在解释模型为什么做出这样的预测, 基于注意了的,EKT,SAKT,RKT,AKT是通过计算当前答题与历史记录的相关性,进而解释模型在预测时关注哪些记录 有研究者使用分层相关性传播方法(LRP)对认知追踪模型进行事后可解释分析,计算模型输出与输入的相关性来解释其预测结 |

模型

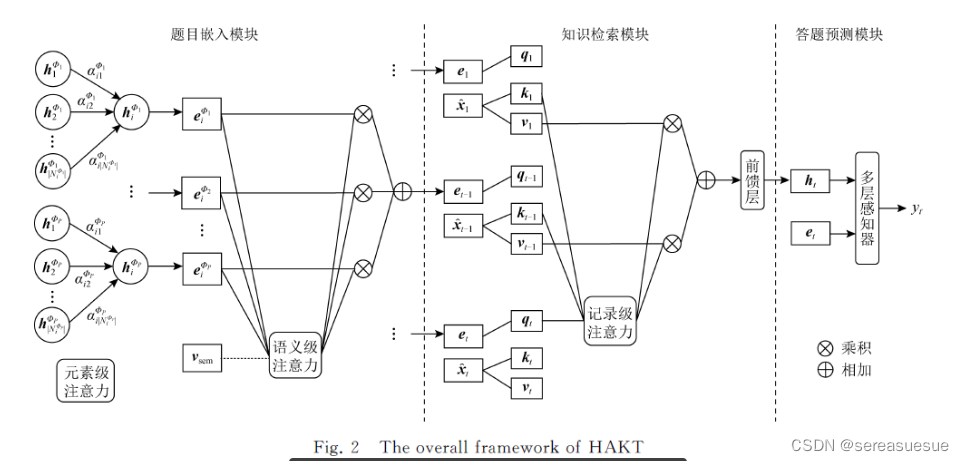

本文提出基于多层注意力网络的认知追踪模型,包含元素级、语义级和记录级3层注意力.图2展示了模型的整体框架,包括题目嵌入模块、知识检索模块和答题预测模块

1613

1613

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?