本次简单介绍一下MSRA初始化方法,方法同样来自于何凯明paper 《Delving Deep into Rectifiers:Surpassing Human-Level Performance on ImageNet Classification》.

Motivation

网络初始化是一件很重要的事情。但是,传统的固定方差的高斯分布初始化,在网络变深的时候使得模型很难收敛。此外,VGG团队是这样处理初始化的问题的:他们首先训练了一个8层的网络,然后用这个网络再去初始化更深的网络。

“Xavier”是一种相对不错的初始化方法,我在我的另一篇博文“深度学习——Xavier初始化方法”中有介绍。但是,Xavier推导的时候假设激活函数是线性的,显然我们目前常用的ReLU和PReLU并不满足这一条件。

MSRA初始化

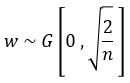

只考虑输入个数时,MSRA初始化是一个均值为0方差为2/n的高斯分布:

推导证明

推导过程与Xavier类似。

首先,用下式表示第L层卷积:

本文详细介绍了MSRA初始化方法,源自何凯明的论文《Delving Deep into Rectifiers: Surpassing Human-Level Performance on ImageNet Classification》。讨论了初始化在网络深度增加时的重要性,指出传统的高斯初始化和VGG团队的策略的局限性。接着,解释了MSRA初始化的公式和推导过程,特别强调了在ReLU激活函数下的适用性。文中还提到了初始化对ReLU和PReLU的影响,并对比了MSRA与Xavier初始化的效果,特别是在深层网络中的优势。

本文详细介绍了MSRA初始化方法,源自何凯明的论文《Delving Deep into Rectifiers: Surpassing Human-Level Performance on ImageNet Classification》。讨论了初始化在网络深度增加时的重要性,指出传统的高斯初始化和VGG团队的策略的局限性。接着,解释了MSRA初始化的公式和推导过程,特别强调了在ReLU激活函数下的适用性。文中还提到了初始化对ReLU和PReLU的影响,并对比了MSRA与Xavier初始化的效果,特别是在深层网络中的优势。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1057

1057

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?