摘要:

贡献1:提出了一个新的数据集Places,这个数据集有700万张标注的图片。

贡献2:提出了一种新方法来比较数据集的密度及多样性。

贡献3:在一些以风景为中心的数据集上获得了最好的结果。

贡献4:将CNN可视化,来显示以物体为中心和以风景为中心的内部表达的不同之处。

一.介绍

人类的场景识别能力是通过采样了大量的自然场景,并且将其注入到了我们的神经,才获得了这个能力。那么我们要给人工智能系统学习多少张图片,才能获得和人类一样的能力?

物体分类随着CNN网络的发展和ImageNet数据集的出现获得了巨大的突破。然而同样的网络在场景分类上获得的精度跟手工特征的算法差不多,这种差异是因为没有足够的基于场景的数据集。

这里引入了Places数据集,一个场景分类数据集大于SUN数据集,用这个数据集我们在不同的数据集上测试,获得的结果都好于用ImageNet预训练的相同结构的网络。

在Section2介绍一下Places数据集和收集过程。在Section3,比较Places,SUN,ImageNet的密度和多样性。在Section4显示用场景数据集训练的结果。最后,将用场景数据集训练的特征和用ImageNet训练的特征可视化,比较一下差异。

二.Places

选出一些热门的形容词,结合场景类别去搜索(可以搜索到一个类别但是多样性丰富的场景)。将大于或等于200X200的图片保留,同时删除和SUN重复的图片。

用Amazon Mechanical Turk进行两轮手工筛选。

三.比较以场景为中心的数据集

比较数据集是非常难以量化的,比如照相机的姿势,装饰跟个和出现的目标。

一个好的数据集至少要有以下特点:(1)密度,有高度集中的数据。(2)多样性,包括不同的外观和角度。但是一般要判断两张图片是否相似都是非常主观的,因此我们定义了依据密度和多样性的相对测量来比较数据集,这只需要排名相似度。我们来用相对性测量比较SUN,ImageNet和Places的密度和多样性。

3.1相对密度和多样性

密度是测量数据的集中程度,我们假设在一个高密度的数据集有类似的相邻图片。给定数据集A和B,从A中随机选择a1,从B中随机选择b1。然后选择a1旁边的图片a2,选择b1旁边的图片b2,则a2和b2分别是a1和b1的相邻图片。然后分别测量a1和a2,b1和b2的距离,用d(a1,a2)和d(b1,b2)表示。最后可以得到DenB(A) = p(d(a1,a2)<d(b1,b2)),也就是相对密度,表示A的随机抽查的两张相邻图片的距离小于B的随机抽查的两张相邻图片的距离,也就是A的密度比B的密度大的概率。那么如果DenA(B)>DenB(A),则A比B密度大。

最后多个数据集的相对密度可以用以下公式表示:

如果一个数据集中,即使有很多类别,但是每个类的图片都非常相似,那么这个数据集将会有很大的密度。

至于数据集多样性的测量,则是受生物学启发。主要思想就是如果数据集B的每张图片比数据集A更相似,那么数据集A将会有更大的多样性。用公式DivB(A) = 1-p(d(a1,a2)<d(b1,b2))。那么如果DivB(A)>DivA(B),则A有比B更大的多样性。

对于多个数据集的相对多样性可以用以下公式比较:

3.2实验结果:

分为人工选择和电脑计算两个实验,最后的结论就是三个数据集密度差不多,但是Places有最大的多样性,ImageNet次之,SUN再次之。在三个数据集中,最大多样性的类分别是playground,veranda和waiting room。

3.3Cross Dataset Generalization

用ImageNet-CNN网络提取特征,然后用SVM分类器分类,用三种不同的数据集分别训练一样的网络,然后在不同的数据集上测试,结果如下:

四.为场景识别和深度特征训练神经网络

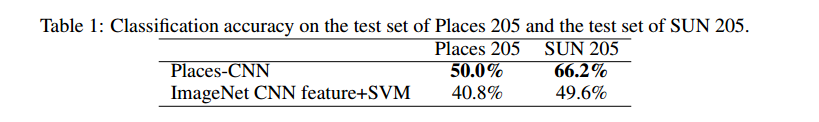

分别用Imagenet训练的网络和Places训练的网络,去测试Places205和SUN205数据集。

4.1可视化深度特征

将Imagenet的100000张图片和SUN397的108754张图片输入到两个网络中,然后把每个单元获得的结果(100000+108754个结果)按照激活值的大小排序,选取前100的单元,然后将其值进行平均,最后计算其响应值,得到以下结果:

可以看到Places-CNN有更多看起来像风景的特征,所以两种网络的结构一样,但是用不同的数据集去训练,可以获得不同的结果。用以场景为中心的数据集去训练的网络,有更多的看起来像风景的激活单元。

4.2在Places205和SUN205的结果

结论就是用Places训练的网络性能比较好。

4.3Generic Deep Features for Visial Recognition

用场景为中心的数据集训练的网络Places-CNN在场景为中心的数据集上有更好的表现;用目标为中心的数据集训练的网络ImageNet-CNN在目标为中心的数据集上有更好的表现,所以两种网络可以互补对方的劣势。

结果如下:

用预训练的Places-CNN微调到SUN数据集的网络,也获得了最好的结果。

最后,将ImageNet-CNN和Places-CNN训练的数据集结合在一起,去除重复的类别,总共1183类去训练一个相同结构的网络,Hybrid-CNN获得了以下较好的结果:

五.结论

本论文有四个贡献:

1.给出了一个大规模的场景识别数据集Places。

2.介绍了一个方法,通过测量数据集的密度和多样性来比较不同数据集的偏置和好坏程度。

3.用感受野证明了以目标为中心和以场景为中心的数据集有不同的内部表达。

4.用本论文的数据集训练的深度特征,在目前所有已知的场景识别的数据集上获得了state-of-the-art的结果。

2495

2495

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?