1

- 题目:Accelerating Convolutional Neural Networks via Activation Map Compression

- 时间:2019

- 会议:CVPR

- 研究机构:三星

1.1 abstract

本篇论文的主要贡献:

- 增加网络稀疏性而不降低精度的训练方法

- 对特征图的无损压缩

1.2 方法

our desire is to achieve sparser activation maps

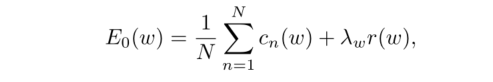

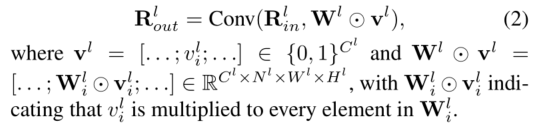

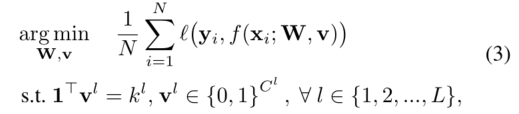

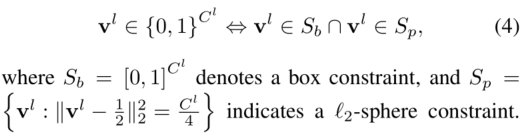

修改损失函数:

其中:

- w表示权重,x表示特征图

- N表示mini-batch大小,L表示层数

- λ、α表示大于零的常数

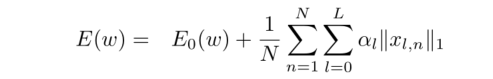

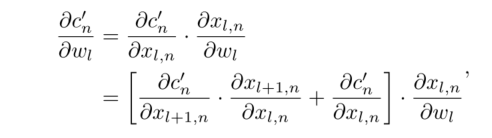

同时给了后向传播的公式

压缩算法: sparse-exponential-Golomb (SEG)

1.3 实验

Speed-up factor is calculated by dividing the number of non-zero activations of the baseline by the number of non-zero activations of the sparse models

Many Sparse models not only have an increased sparsity in their activation maps, but also demonstrate increased accuracy

2

- 题目:Efficient Neural Network Compression

- 时间:2019

- 会议:CVPR

- 研究机构:韩国KAIST

2.1 abstract

本篇论文的主要贡献:

- 基于SVD的网络压缩

- 快速找到最优rank配置的方法

2.2 奇异值分解

2.3 确定rank配置

- 确定范围,缩写搜索空间

- 指定跟精度相关的指标

2.3 实验

Results with 20% FLOPs reduction are given in Table 2

3

- 题目:Compressing Convolutional Neural Networks via Factorized Convolutional Filter

- 时间:2019

- 会议:CVPR

- 研究机构:清华深圳院

1011

1011

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?