1. Motivation

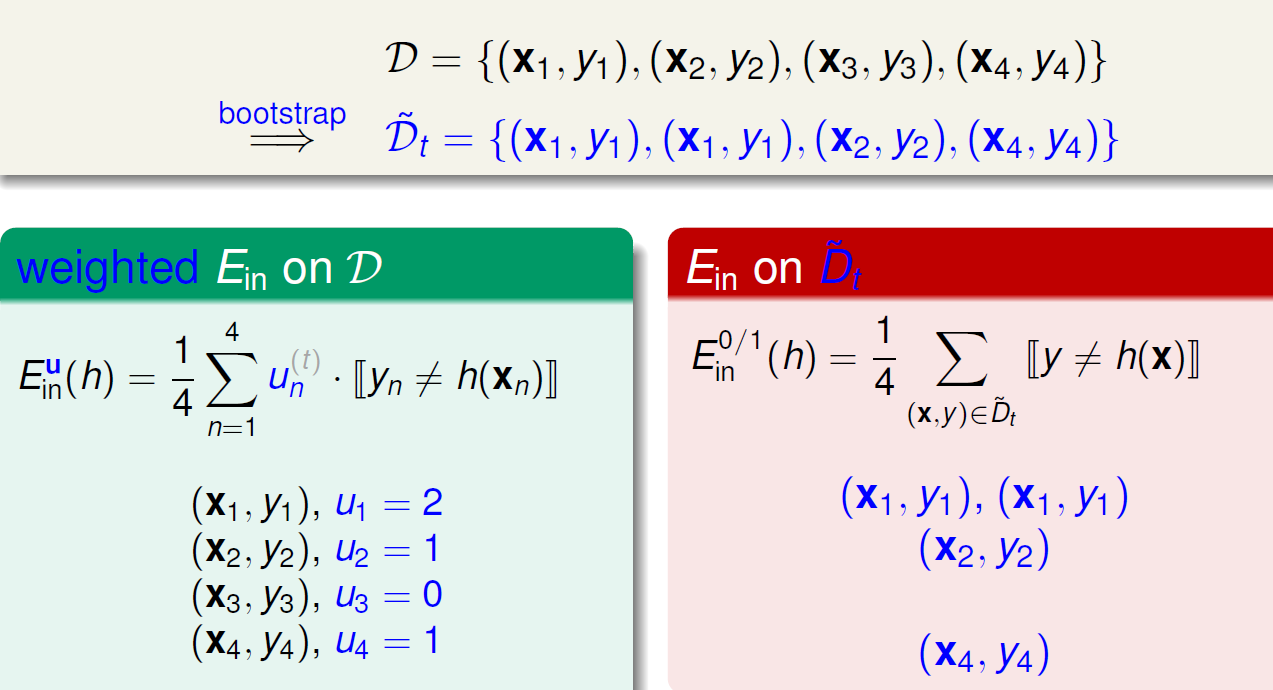

bootstrap在训练集上通过有放回的采样构造出不同的训练数据,该过程可以看作在完整训练集上,为每一个样本赋予不同的权重。若该样本在本次抽样中没有被选中,则其权重为0。

在采样得到的每一个数据集

u(t)n

上训练得到模型

gt

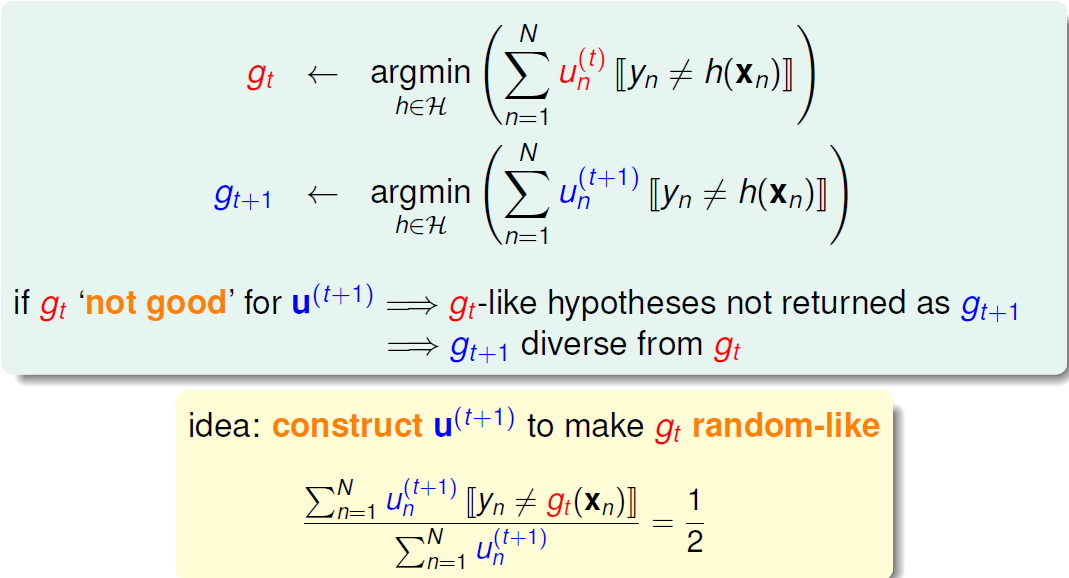

。为了增加不同

gt

之间的差异性,可采用如下思路:经过训练得到的模型

gt

在数据集

u(t)n

上具有较好的表现,我们希望

gt

在数据集

u(t+1)n

上的表现较差,这样通过

u(t+1)n

训练出的模型

gt+1

与

gt

就会存在差异。

具体做法就是让

gt

模型在构造出的

u(t+1)n

数据集上的二分类准确率为50%,这样就等同于机选。

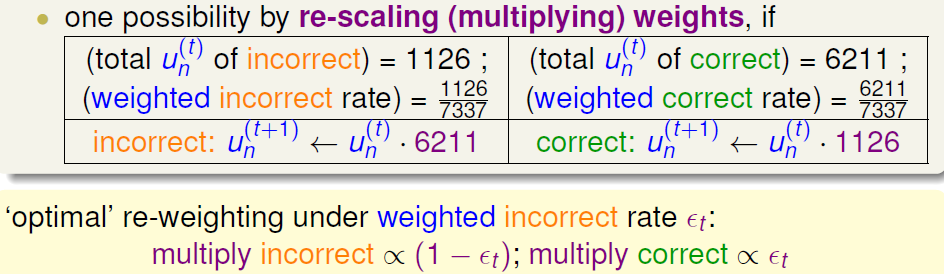

具体例子如下:在数据集 u(t)n 上,模型 gt 分类正确的数据有6211个,分类错误的数据有1126个。因此在构造 u(t+1)n 时,将分类错误的样本权重乘以 1126 ,将分类正确的样本权重乘以 6211 。即放大错误,减小正确的影响。

将多个较弱的模型

2. Algorithm

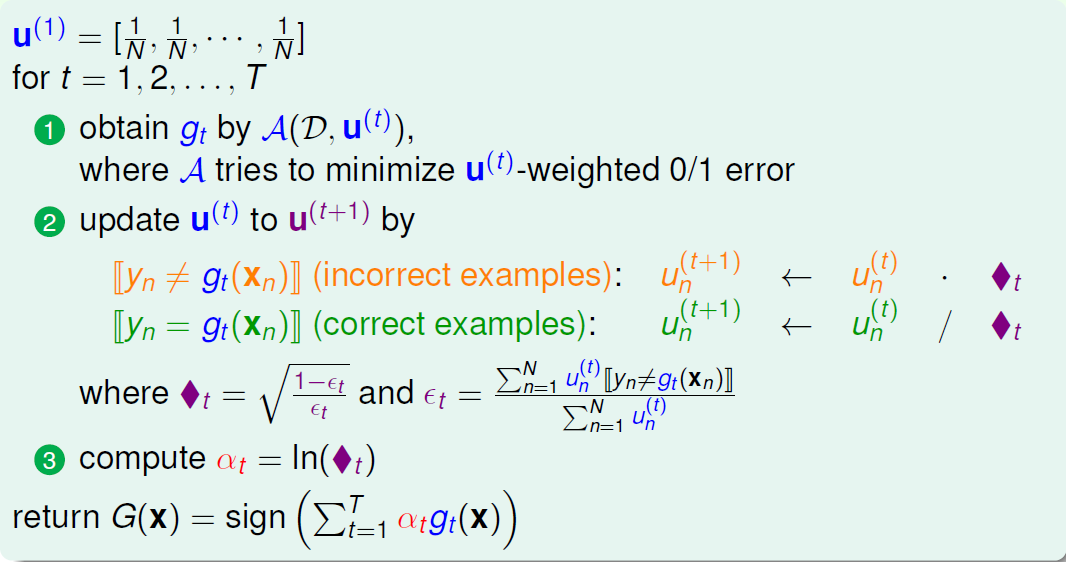

Adaptive Boosting 算法训练出多个不同的模型 gt ,并将其组合起来形成一个更强的模型 G(x) 。Adaptive Boosting在训练模型和计算模型权重上是同时进行的。具体流程如下:

本文介绍了AdaBoost算法的工作原理,包括如何通过有放回的采样构造不同的训练数据集,并利用这些数据集训练出多个弱分类器。此外还讨论了如何调整样本权重来提高后续模型的差异性。

本文介绍了AdaBoost算法的工作原理,包括如何通过有放回的采样构造不同的训练数据集,并利用这些数据集训练出多个弱分类器。此外还讨论了如何调整样本权重来提高后续模型的差异性。

1174

1174

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?