The two assumptions we need about the cost function(2个关于成本函数的假设)

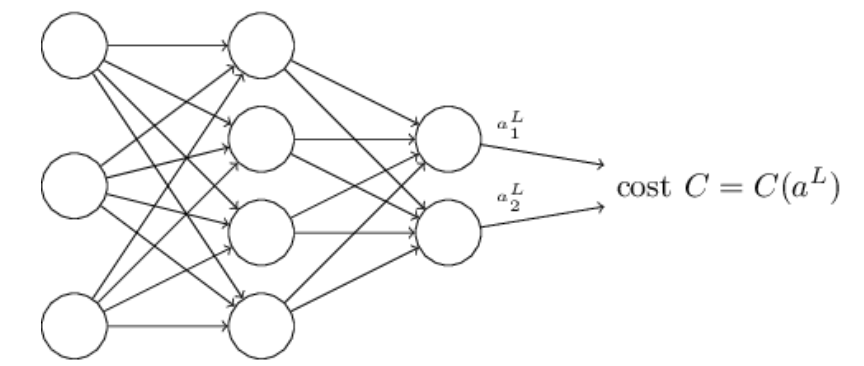

反向传播的全局是计算网络的成本函数

C

关于权重

C=12n∑x||y(x)−aL(x)||2 (26)

这里:

n

是训练样本的总数;sum指的是所有独立训练样本x的和;

好了,那么我们需要做些什么假设来了解我们的成本函数

C

,以使反向传播可以被应用?第一个假设是,成本函数可以写成平均

我们这样假设的原因,是因为反向传播实际上是计算偏导数(求导后,系数为1)。记住这个假设,我们将成本函数

Cx

写成

C

。我们最终会将

第二个假设我们需要做的是,成本可以被写成是神经网络的输出函数:

举个例子,平方成本函数满足这个要求,因为对于每个训练样本

x

,平方成本可以写成:

并且因此是输出激活的函数。当然,成本函数也依赖于我们期望的输出

y

,并且你可能会奇怪为什么不考虑成本为

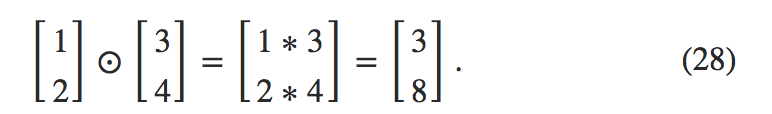

The Hadamard product, s⊙t(Hadamard乘积,s⊙t)

反向传播算法基于普通线性代数运算-比如向量加法、矩阵的乘法等等。但是有一些运算平时很少被使用。特别地,假设

这种对应元素相乘有时也被称为Hadamard乘法或者Schur乘法。我们这里称它为Hadamard乘法。好的矩阵库提供了Hadamard乘积的快速实现,并且将在实现反向传播时使用。

4万+

4万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?