早在3月份的时候,当时就有童鞋提到被封禁,但是根据评论区的情况,实际上当时Kaggle只是封禁NSFW内容的生成,就在我孜孜不倦地寻找Colab的下个白嫖平台时,看到还有人一直在推荐用Kaggle,结果上去一看才发现Kaggle也被封禁了,9月份官方人员正式提到禁止SD Webui这类AI绘画项目的运行,Kaggle上相关的code脚本均告失效,

https://www.bilibili.com/read/cv22179070/

相关脚本的维护者还推荐别人用回Colab,真是白嫖党一大噩耗,像其他平台比如autodl也要钱,更别说他家还禁止涩涩,大抵只能自建主机了。

https://www.kaggle.com/code/qq2575044704/stable-diffusion-webui

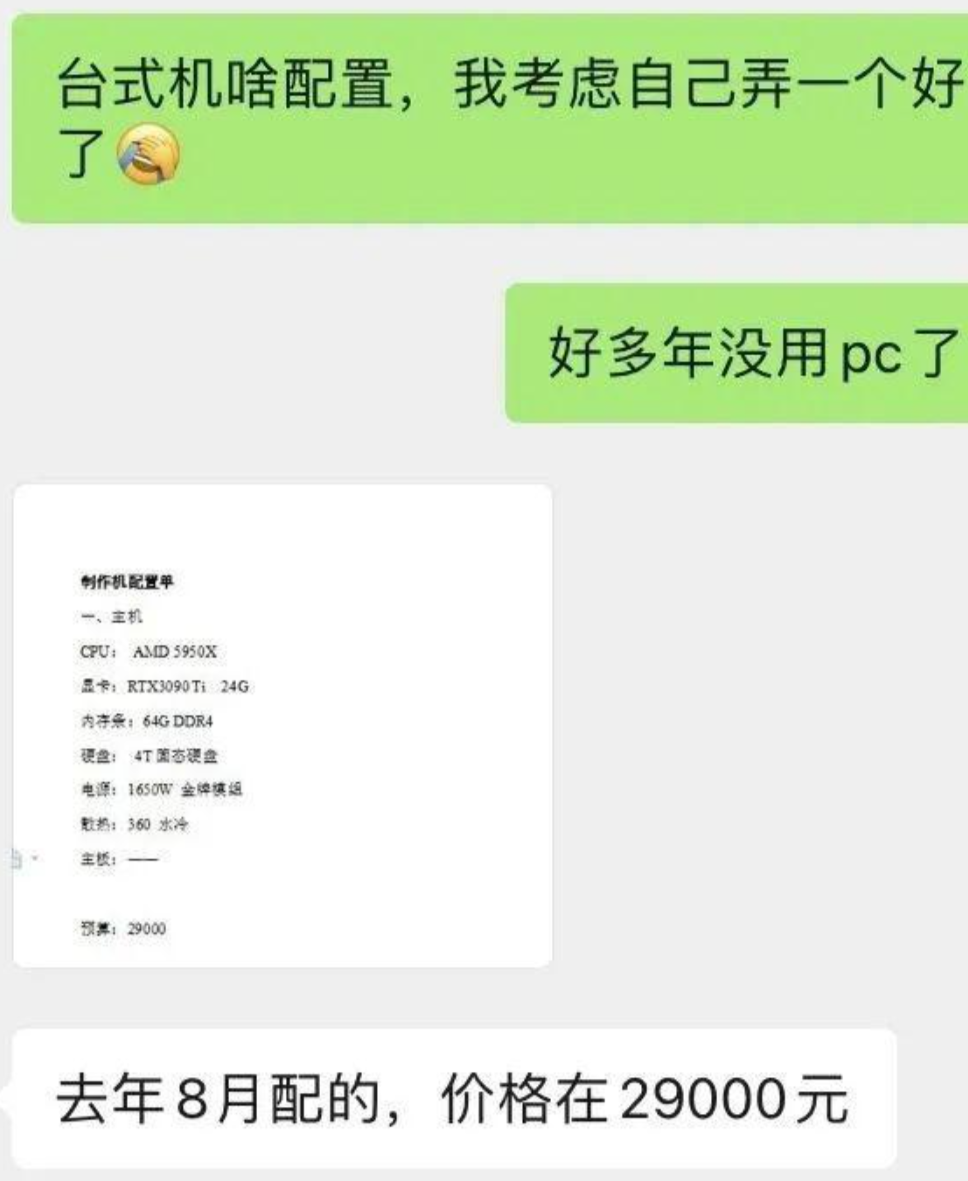

我无数次想过,要不就去买个台式机吧,问了一圈好点的基本上价格都在2~3w,毕竟一块3090就要一万多了。在安装上虽然不是很方便,但是好在网上教程多,而且还有那种可以更新的本地版本。在便携上,对于要经常外出的人,台式机真的太笨重了,更别提价格对于白嫖党实在不友好,转了一圈看来只能回归colab,毕竟一个月也就几十上百块钱,不用一下子投入这么多,可惜国内想给钱还有点困难,搜了一圈只能去找万能的某宝,看了下有家店还算比较便宜,遇上野鱼工作室,试着买了下感觉还行,暂时先这么着,看看后续还有没有些新平台出来了。

953

953

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?