Batch Normalization是由google提出的一种训练优化方法。解决在训练过程中,中间层数据分布发生改变的问题,以防止梯度消失或爆炸、加快训练速度。参考论文:Batch Normalization Accelerating Deep Network Training by Reducing Internal Covariate Shift

BN层的作用是加快网络学习速率,论文中提及其它的优点都是这个优点的副产品。

Normalization是数据标准化(归一化,规范化),Batch 可以理解为批量,加起来就是批量标准化。在CNN中,Batch就是训练网络所设定的图片数量batch_size。

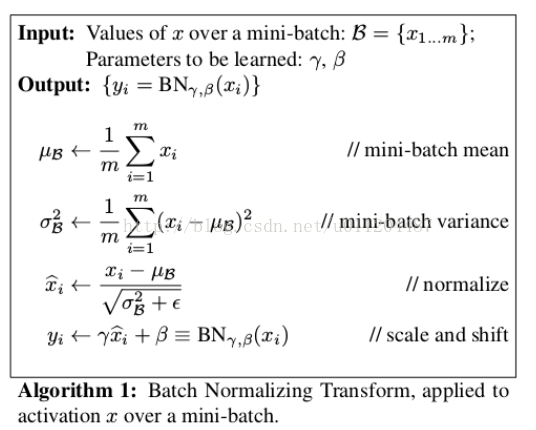

输入:输入数据x1..xm(这些数据是准备进入激活函数的数据)

即:BN介于卷积和激活之间,而LRN在caffenet在pooling后,在alexnet中在pooling前

计算过程,

1.求数据均值;

2.求数据方差;

3.数据进行标准化(正态化)

4.训练参数γ,β

5.输出y通过γ与β的线性变换得到原来的数值

在训练的正向传播中,不会改变当前输出,只记录下γ与β。

在反向传播的时候,根据求得的γ与β通过链式求导方式,求出学习速率以至改变权值

解决的问题是梯度消失与梯度爆炸。

随机梯度下降法(SGD)对于训练深度网络简单高效,但是它有个毛病,就是需要我们人为的去选择参数,比如学习率、参数初始化、权重衰减系数、Drop out比例等。这些参数的选择对训练结果至关重要,以至于我们很多时间都浪费在这些的调参上。那么使用BN之后,你可以不需要那么刻意的慢慢调整参数。

321

321

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?