图 1. 最近最先进的方法与我们的方法之间的比较。 KinD [34] 是一种具有代表性的配对监督方法。 EnGAN [11] 考虑了非配对监督学习。 ZeroDCE [7] 和 RUAS [14] 引入了无监督学习。我们的方法(只包含三个大小为 3×3 的卷积)也属于无监督学习。如放大区域所示,这些比较方法出现了不正确的曝光、颜色失真和结构不足,从而降低了视觉质量。相比之下,我们的结果呈现出鲜艳的色彩和清晰的轮廓。此外,我们在(b)中报告了计算效率(SIZE、FLOPs 和 TIME)以及在包括增强(PSNR、SSIM 和 EME)、检测(mAP)和分割( mIoU)在(c)中,可以很容易地观察到我们的方法明显优于其他方法。

Abstract

现有的弱光图像增强技术大多不仅难以处理视觉质量和计算效率,而且在未知的复杂场景中通常无效。在本文中,我们开发了一种新的自校准照明 (SCI) 学习框架,用于在现实世界的弱光场景中实现快速、灵活和稳健的增亮图像。具体来说,我们建立了一个具有权重共享的级联光照学习过程来处理这个任务。考虑到级联模式的计算负担,我们构建了自校准模块,该模块实现了每个阶段结果之间的收敛,产生仅使用单个基本块进行推理的增益(在以前的工作中尚未开发),这大大降低了计算成本。然后,我们定义了无监督训练损失,以提升可以适应一般场景的模型能力。此外,我们进行了全面的探索,以挖掘 SCI 的内在属性(现有作品中缺乏的),包括操作不敏感的适应性(在不同的简单操作的设置下获得稳定的性能)和模型无关的通用性(可以应用于基于光照的现有作品)以提高性能)。最后,大量的实验和消融研究充分表明了我们在质量和效率方面的优势。微光人脸检测和夜间语义分割的应用充分揭示了 SCI 的潜在实用价值。源代码可在 https://github.com/vis-opt-group/SCI 获得。

1. Introduction

低光图像增强旨在使隐藏在黑暗中的信息可见以提高图像质量,它最近在多个新兴的计算机视觉领域引起了广泛关注[18,24,25]。下面我们梳理一下两个相关主题的发展历程。此外,我们描述了我们的主要贡献。

Model-based Methods.一般来说,Retinex 理论 [16] 描述了微光图像增强的基本物理规律,即微光观察可以分解为照度和反射率(即清晰的图像)。受益于 l2-范数的便捷解,Fu 等人。 [5, 6] 首先使用 l2-范数来约束光照。此外,郭等人[8]采用相对总变化[28]作为光照的约束。但是,它的致命缺陷在于过曝的外观。李等人[13] 在一个统一的优化目标中对噪声去除和弱光增强进行了建模。 [10]中的工作提出了一种半解耦分解模型,用于同时提高亮度和抑制噪声。一些作品(例如,LEACRM [17])也利用相机的响应特性进行增强。受限于定义的正则化,它们大多会产生不令人满意的结果,并且需要针对实际场景手动调整大量参数。

Network-based Methods.通过调整曝光时间,[3] 中的工作构建了一个新的数据集,称为 LOL 数据集。这项工作还设计了倾向于产生不自然的增强结果的 RetinexNet。 KinD [34] 通过引入一些训练损失和调整网络架构来改善 RetinexNet 中出现的问题。 DeepUPE [22] 定义了一个用于增强低光输入的照明估计网络。 [30] 中的工作提出了一个递归带状网络,并通过半监督策略对其进行训练。 EnGAN [11] 设计了一个在非配对监督下注意增强的生成器。 SSIENet [33] 构建了一个分解型架构来同时估计光照和反射率。 ZeroDCE [7] 启发式地构建了具有学习参数的二次曲线。最近,刘等人[14] 使用架构搜索构建了一个受 Retinexin 启发的展开框架。不可否认,这些深度网络是精心设计的。然而,它们并不稳定,难以实现始终如一的卓越性能,尤其是在未知的现实世界场景中,细节不清晰和曝光不当无处不在。

Our Contributions.为了解决上述问题,我们开发了一种新颖的自校准照明 (SCI) 学习框架,用于快速、灵活和稳健的低光图像增强。通过重新开发光照学习过程的中间输出,我们构建了一个自校准模块,赋予单个基本块更强的表示,并在每个阶段的结果之间收敛以实现加速。更具体地说,我们的主要贡献可以总结为:

• 我们开发了一个用于光照学习的自校准模块,具有权重共享,以赋予每个阶段的结果之间的收敛性,提高曝光稳定性并大大减少计算负担。据我们所知,这是第一个通过利用学习过程来加速弱光图像增强算法的工作。

• 我们定义了无监督训练损失,以在自校准模块的影响下约束每个阶段的输出,赋予对不同场景的适应能力。属性分析表明,SCI具有对操作不敏感的适应性和与模型无关的通用性,这在现有工作中是没有的。

• 进行了广泛的实验来说明我们与其他最先进的方法相比的优势。进一步执行在暗面检测和夜间语义分割方面的应用,以揭示我们的实用价值。简而言之,SCI 重新定义了基于网络的低光图像增强领域的视觉质量、计算效率和下游任务性能的峰值点。

2. The Proposed Method

在本节中,我们首先介绍具有权重共享的光照学习,然后构建自校准模块。接下来是无监督训练损失。最后,我们对我们构建的 SCI 进行了全面的讨论。

2.1. Illumination Learning with Weight Sharing

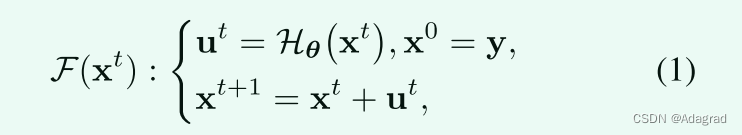

根据 Retinex 理论,弱光观察 y 和想要的清晰图像 z 之间存在联系:y = z ⊗ x,其中 x 表示照明分量。通常,照明被视为核心组件,需要主要针对弱光图像增强进行优化。根据 Retinex 理论,通过去除估计的光照可以进一步获得增强的输出。在这里,受作品 [8, 14] 中提出的照明阶段优化过程的启发,通过引入带有参数 θ 的映射 Hθ 来学习照明,我们提供了一个渐进的视角来建模这个任务,基本单元写为

其中 ut 和 xt 分别表示第 t 阶段 (t = 0, ..., T − 1) 的残差项和光照。需要注意的是,我们没有在 Hθ 中标记阶段编号,因为我们采用了权重共享机制,即在每个阶段使用相同的架构 H 和权重 θ。

事实上,参数化算子 Hθ在光照和低光观察之间学习了一个简单的残差表示 ut。这个过程受到共识的启发,即照明和弱光观察在大多数区域是相似或存在的线性连接。与采用低光观察和光照之间的直接映射(现有工作中常用的模式,例如,[14, 22])相比,学习残差表示大大降低了计算难度,既保证了性能又提高了稳定性,尤其是对于曝光控制。

事实上,我们可以直接利用上面构建的过程和给定的训练损失和数据来获得增强模型。但值得注意的是,具有多个权重共享块的级联机制不可避免地会增加可预见的推理成本。重温这个共享过程,每个共享块都期望输出一个尽可能接近期望目标的结果。更进一步,理想的情况是第一个块可以输出期望的结果,满足任务需求。同时,后面的块输出与第一个块相似甚至完全相同的结果。这样,在测试阶段,我们只需要一个块就可以加快推理速度。接下来,我们将探讨如何实现它。

2.2. Self-Calibrated Module

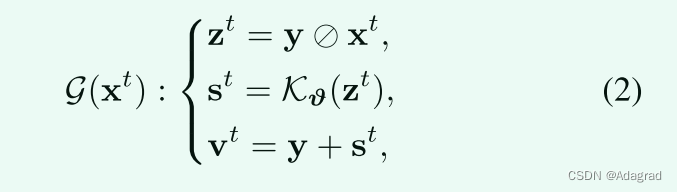

在这里,我们的目标是定义一个模块,使每个阶段的结果收敛到同一个状态。我们知道每个阶段的输入都源于前一阶段,第一阶段的输入明确定义为低光观察。一个直观的想法是,我们是否可以将每个阶段的输入(除了第一阶段)和弱光观察(即第一阶段的输入)连接起来,以间接探索每个阶段之间的收敛行为。为此,我们引入了一个自校准的地图 s 并将其添加到低光观察中,以呈现每个阶段和第一阶段的输入之间的差异。具体来说,自校准模块可以表示为

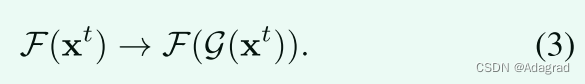

其中 t ≥ 1,vt 是每个阶段的转换输入,Kϑ是引入的参数化算子具有可学习的参数 ϑ。那么第t阶段(t≥1)的基本单元的转换可以写为

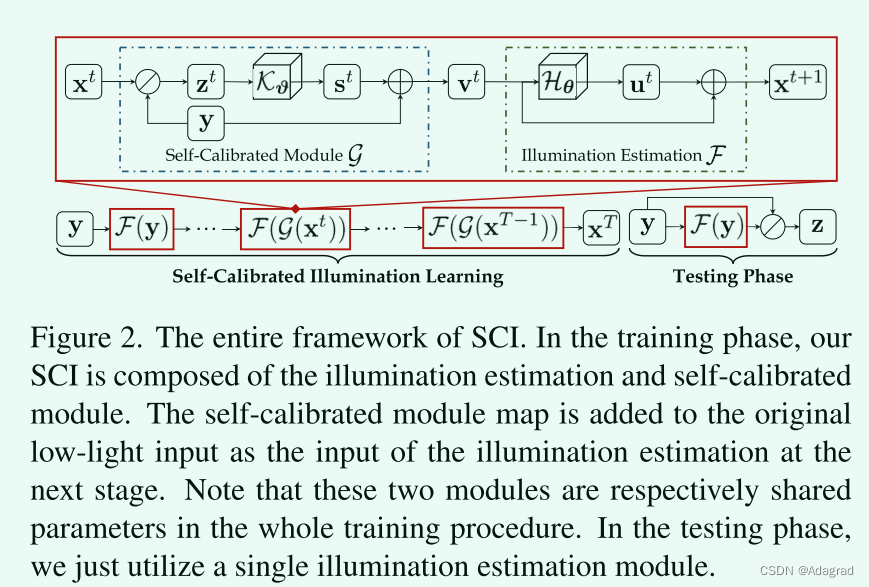

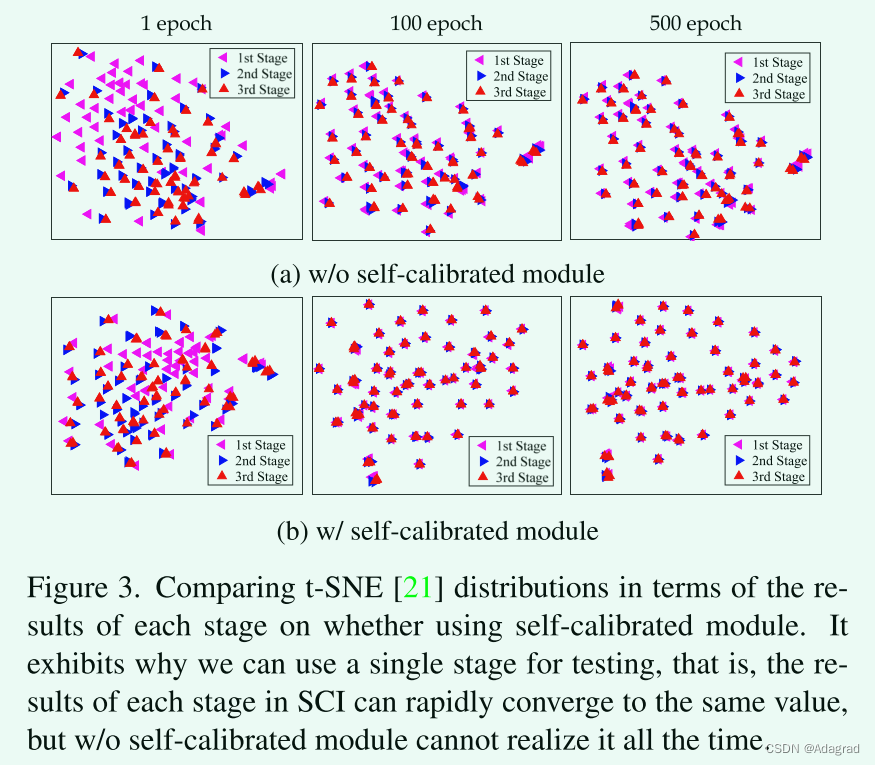

实际上,我们构建的自校准模块通过整合物理原理来逐步校正每个阶段的输入,从而间接影响每个阶段的输出。为了评估自校准模块对收敛的影响,我们在图 3 中绘制了每个阶段的结果之间的 tSNE 分布,我们可以很容易地观察到每个阶段的结果确实收敛到相同的值。但这种现象在没有自校准模块的情况下是找不到的。此外,上述结论也反映了我们确实实现了第二节最后一段所述的意图。 2.1,即使用权重共享模式训练多个级联块,但仅使用单个块进行测试。

我们还在图 2 中提供了总体流程图,以了解我们建立的 SCI 框架。

2.3. Unsupervised Training Loss

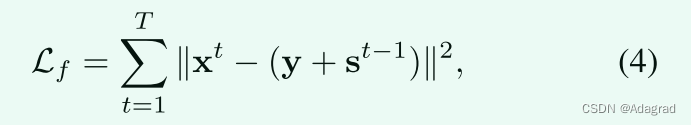

考虑到现有配对数据的不准确性,我们采用无监督学习来扩大网络能力。我们将总损失定义为 Ltotal = αLf + βLs,其中 Lf 和 Ls 分别代表保真度和平滑损失。 α 和 β 是两个正平衡参数 。保真度损失是为了保证估计的光照和每个阶段的输入之间的像素级一致性,公式为

其中 T 是总阶段数。实际上,这个函数利用重新定义的输入 y + st−1 来约束输出光照 xt,而不是手工制作的地面实况或普通的低光输入。

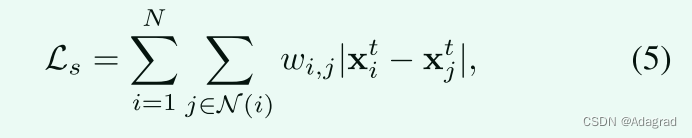

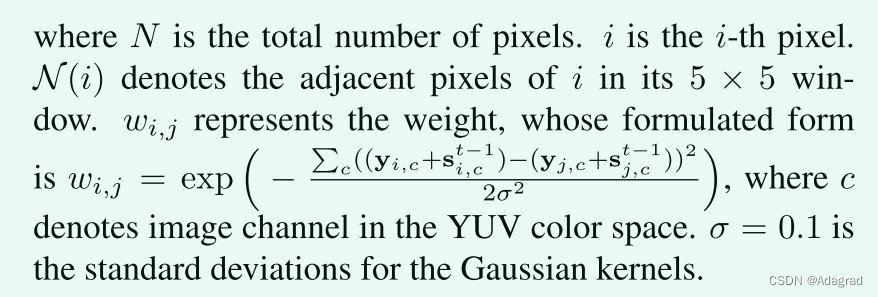

照明的平滑性是这项任务中的广泛共识 [7, 34]。在这里,我们采用具有空间变化 l1 范数 [4] 的平滑项,表示为

2.4. Discussion

本质上,自校准模块在学习更好的基本块(本工作中的光照估计模块)中起到辅助作用,该模块通过权重共享机制级联以生成整体光照学习过程。更重要的是,自校准模块赋予了每个阶段的结果之间的收敛性,这在现有的工作中还没有被探索过。而且,SCI的核心思想实际上是引入了额外的网络模块来辅助训练,而不是在测试中。它改进了模型表征,以实现仅使用单个块进行测试。也就是说,可以将“权重共享+任务相关的自校准模块”的机制转移到处理其他任务进行加速。

3. Exploring Algorithmic Properties

在本节中,我们对我们提出的 SCI 进行探索,以深入分析其特性。

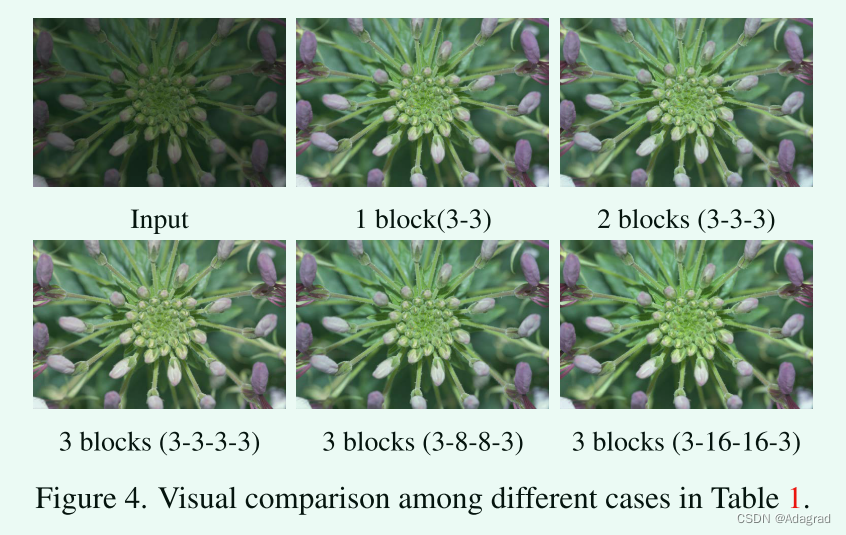

3.1. Operation-Insensitive Adaptability

一般来说,基于网络的方法中使用的操作应该是固定的,不能随意改变,因为这些操作是在大量实验的支持下获得的。幸运的是,我们提出的算法在 Hθ 的不同极其简单甚至幼稚的设置上表现出惊人的适应性。如表1所示,我们可以很容易地观察到我们的方法在不同的设置(块3×3卷积+ReLU的数量)下获得了稳定的性能。此外,我们在图 4 中提供了视觉比较,可以很容易地观察到,我们具有不同设置的 SCI 都使低光观察变亮,显示出非常相似的增强结果。重新审视我们设计的框架,可以得到这个属性在于 SCI 不仅转换了光照的共识(即残差学习),而且还整合了物理原理(即逐元素除法运算)。本实验也验证了我们设计的SCI的有效性和正确性。

3.2. Model-Irrelevant Generality

如果不限制任务相关的自校准模块,我们的 SCI 实际上是一种广义的学习范式,因此理想情况下,它可以直接应用于现有工作。在这里,我们以最近提出的代表作品 RUAS [14] 为例进行探索。表 2 和图 5 展示了使用我们的 SCI 训练 RUAS 之前/之后的定量和定性比较。显然,尽管我们只使用了 RUAS 展开过程中使用的单个块(即 RUAS (1))来评估我们的训练过程,但性能仍然取得了显着提高。更重要的是,我们的方法可以显着抑制原始 RUAS 中出现的过度曝光。这个实验反映了我们的学习框架确实足够灵活,并且具有很强的模型无关通用性。此外,这表明也许我们的方法可以转移到基于任意光照的低光图像增强工作中,我们将在未来尝试这样做。

4. Experimental Results

在本节中,我们首先提供了所有实现细节。然后我们进行了实验评估。接下来,我们将增强方法应用于暗面检测和夜间语义分割。最后,我们对 SCI 进行了算法分析。所有实验均在具有单个 TITAN X GPU 的 PC 上进行。

4.1. Implementation Details

Parameter Settings.

在训练过程中,我们使用了参数 β1 = 0.9、β2 = 0.999 和 = 10−8 的 ADAM 优化器 [12]。小批量大小设置为 8。学习率初始化为 10-4。训练 epoch 数设置为 1000。根据 Sec 中的结论,我们在所有实验中采用 3 个卷积 + ReLU 和 3 个通道作为 Hθ 的默认设置。自校准模块包含四个卷积层,保证了训练过程的轻量化。事实上,网络的形式可能并不固定,我们已经在补充材料中做过实验来验证它。

Compared Methods.

至于低光图像增强,我们将我们的 SCI 与最近提出的四种基于模型的方法(包括 LECARM [17]、SDD [10]、STAR [26])、四种先进的监督学习方法(包括 RetinexNet [3]、KinD [34]、FIDE [27]、DRBN [30])和四种无监督学习方法(包括 EnGAN [11]、SSIENet [33]、ZeroDCE [7] 和 RUAS [14])。至于暗面检测,除了在检测器之前进行上述基于网络的增强工作外,我们还比较了最近提出的暗面检测方法 HLA [24]。

Benchmarks Description and Metrics.

对于弱光图像增强,我们从 MIT 数据集 [2] 中随机抽取 100 张图像,从 LSRW 数据集 [9] 中随机抽取 50 张测试图像进行测试。我们使用了两个全参考指标,包括 PSNR 和 SSIM,五个无参考指标,包括 DE [20]、EME [1]、LOE [23] 和 NIQE [23]。至于暗面检测,我们使用了 DARK FACE 数据集 [31],该数据集由 1000 张具有挑战性的测试图像组成,这些图像是从 CVPR 2021 举行的 UG2+ PRIZE CHALLENGE 的子挑战中随机抽取的。我们将检测准确率和召回率视为评估指标。至于夜间语义分割,我们使用 ACDC [19] 中的 400 张图像进行训练,其余 106 张图像作为评估数据集。评估的指标定义为 IoU 和 mIoU。

4.2. Experimental Evaluation on Benchmarks

Performance Evaluation.

如表 3 所示,我们的 SCI 取得了具有竞争力的表现,尤其是在无参考指标方面。如图 6-7 所示,先进的深度网络生成了未知的面纱,导致了不显眼的细节和不自然的颜色。相比之下,我们的 SCI 以鲜艳的色彩和突出的纹理实现了最佳的视觉质量。更多视觉比较可以在补充材料中找到。

Computational Efficiency.

此外,我们在表 4 中报告了一些最近提出的基于 CNN 的方法的模型大小、FLOP 和运行时间(GPU 秒)。显然,与其他网络相比,我们提出的 SCI 是最轻量级的,并且明显优于其他网络.

4.3. In-the-Wild Experimental Evaluation

野外场景中的弱光图像增强极具挑战性。图像局部过曝信息的控制、整体色彩的校正、图像细节的保留都是亟待解决的问题。在这里,我们测试了来自 DARK FACE [31] 和 ExDark [15] 数据集的大量具有挑战性的野外示例。如图 8 所示,通过大量实验可以看出,我们的方法取得了比其他方法更令人满意的可视化效果,尤其是在曝光水平、结构描绘、颜色呈现方面。限于篇幅,我们在补充材料中提供了更多比较。

4.4. Dark Face Detection

我们利用 S3FD [32],一种众所周知的人脸检测算法来评估暗面检测性能。请注意,S3FD 是使用原始 S3FD 中提供的 WIDER FACE 数据集 [29] 进行训练的,我们使用 S3FD 的预训练模型来微调通过各种方法增强的图像。

同时,我们执行了一种名为 SCI+ 的新方法,将我们的 SCI 作为基本模块嵌入到 S3FD 的前端,用于任务损失和增强结合的联合训练。如图 9 所示,我们的方法(SCI 和 SCI+)在所有比较方法中取得了最好的成绩,增强版本比微调版本获得了更好的性能。图 10 进一步展示了视觉比较。可以很容易地观察到,通过应用我们的 SCI,也可以检测到较小的物体,而其他方法则无法做到这一点,如放大区域所示。

4.5. Nighttime Semantic Segmentation

在这里,我们采用 PSPNet [35] 作为基线来评估所有方法在“预训练 + 微调”模式(类似于 SCI 在暗面检测中的版本)的分割性能。表 5 和图 11 展示了不同方法之间的定量和定性比较结果。我们的性能明显优于其他最先进的方法。如图 11 中的放大区域所示,所有比较的方法都产生了一些未知的伪影,从而损害了生成的分割图的质量。

4.6. Algorithmic Analyses

Comparing Decomposed Components.

实际上,我们的 SCI 属于基于光照的学习方法,增强的视觉质量在很大程度上取决于估计的光照。在这里,我们将我们的 SCI 与三种代表性的基于照明的学习方法进行了比较,包括 RetinexNet、KinD 和 SSIENet。如图 12 所示,我们可以很容易地看到,我们估计的光照保持了出色的平滑性。它确保我们生成的反射率在视觉上更加友好。

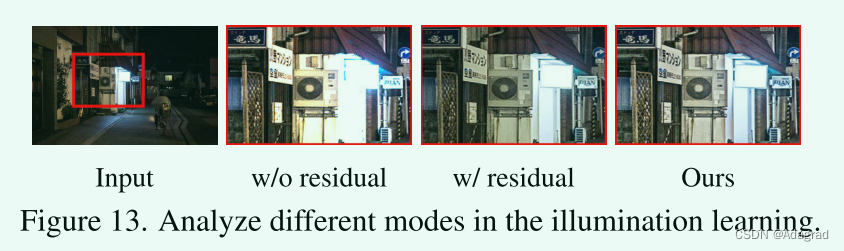

Ablation Study.

我们在图 13 中比较了不同模式的性能。直接学习光照会导致图像过度曝光。学习光照和输入之间的残差的过程确实抑制了过度曝光,但整体图像质量仍然不高,尤其是对于细节的把握。相比之下,使用我们的方法增强的结果不仅抑制了过度曝光,而且丰富了图像结构。

5. Concluding Remarks

在本文中,我们成功地建立了一个轻量级但有效的框架,自校准照明 (SCI),用于针对不同的现实世界场景进行低光图像增强。我们不仅对 SCI 的优良特性进行了深入探索,而且还进行了广泛的实验,以表明我们在低光图像增强、暗面检测和夜间语义分割方面的有效性和优越性。

Broader Impacts.

从任务的角度来看,SCI 提供了一个高效且有效的学习框架,并且在图像质量和推理速度方面都获得了极其优越的性能。或许它会为微光图像增强进入一个高速、高质量的新时代打下坚实的基础。在方法设计上,SCI 开辟了一个新的视角(即在训练阶段引入辅助过程来提升基本单元的模型能力),以提高其他低级视觉问题对现实世界场景的实用性。

Acknowledgements:

这项工作得到了国家重点研发计划(2020YFB1313503)、国家自然科学基金(Nos. 61922019、61733002和62027826)和中央高校基本科研业务费专项资金的支持。

3913

3913

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?