注:几篇关于AI 教父 Hinton 的文章合集。

AI 教父拿下诺奖,却很后悔

原创 朱秋雨 南风窗 2024 年 10 月 09 日 17:38 广东

作者 | 南风窗记者 朱秋雨

编辑 | 向由

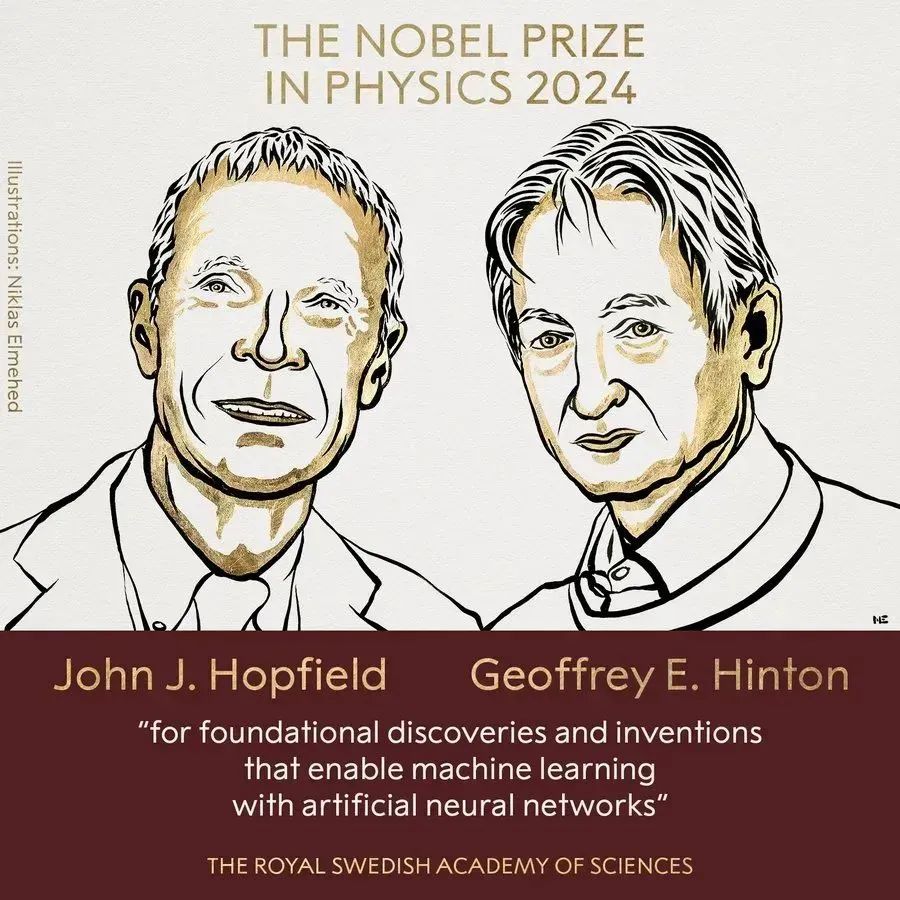

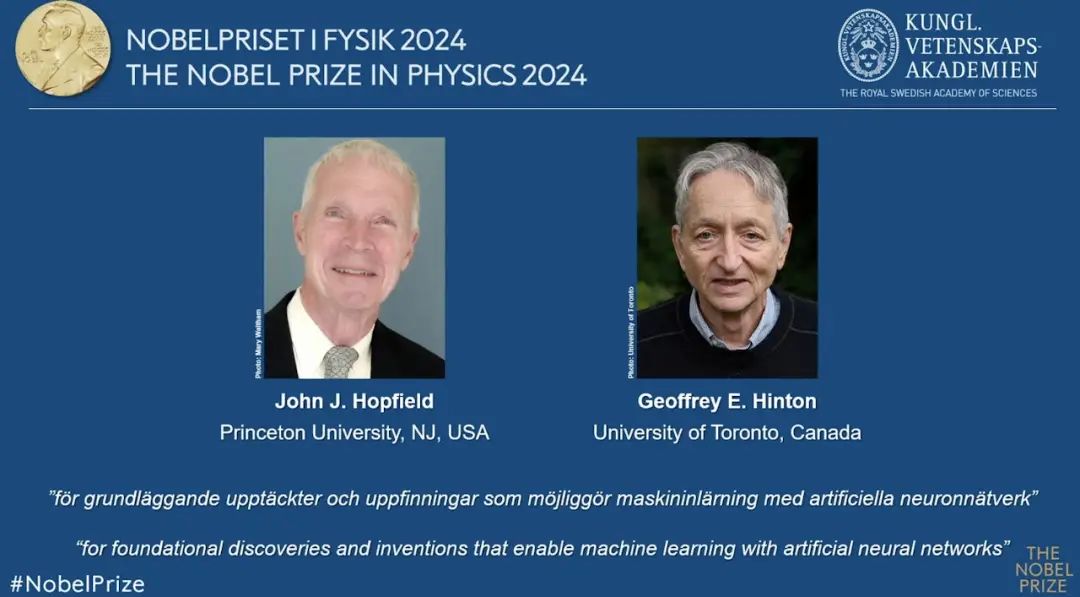

10 月 8 日,2024 年物理学奖花落两位 “冷门学者”:91 岁高龄的约翰・霍普菲尔德(John Hopfield)和 77 岁的杰弗里・辛顿(Geoffrey Hinton)。

这是令人意外的一次颁奖。毕竟,数个诺奖预测都相信,物理奖应该是天体物理、粒子物理、应用物理、量子物理、凝聚态物理、经典物理、原子分子和光物理七大类中的一个。诺贝尔物理学奖不应是两个研究机器学习(Machine Learning)、掀开当前人工智能(AI)革命的大师与教父。

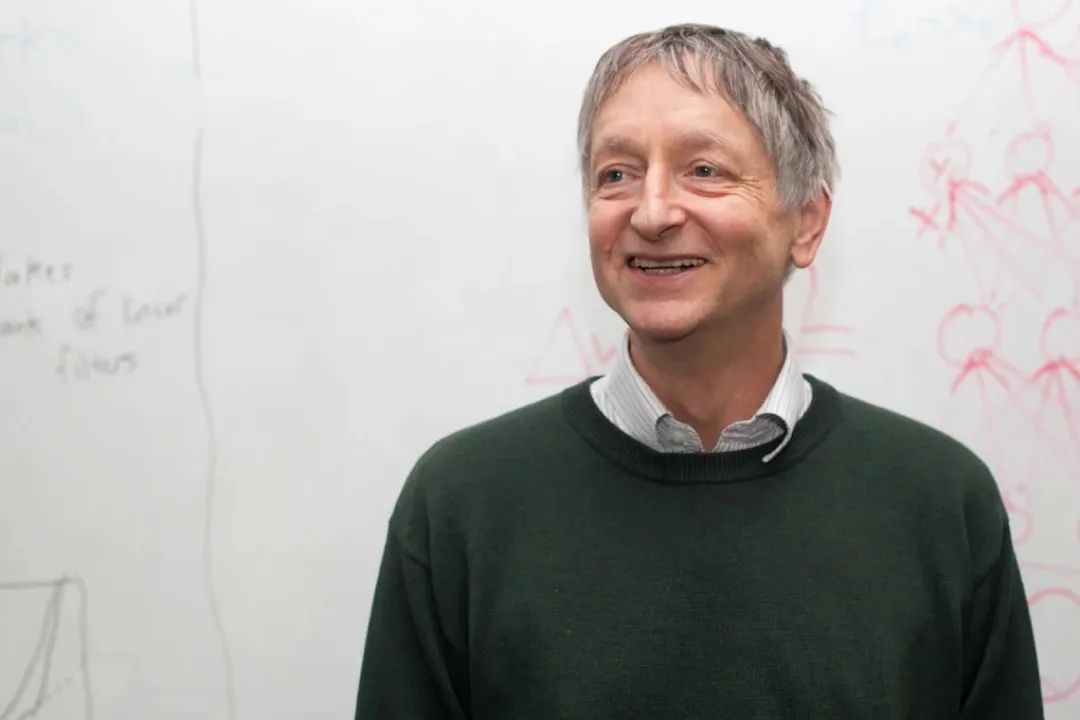

被称为 “AI 教父” 的辛顿自己没有想到,一个身体不好,坐不了飞机,三任妻子都死于癌症的男人,会收到诺贝尔物理学奖获奖的通知电话。

10 月 8 日,在瑞典斯德哥尔摩举行的 2024 年诺贝尔物理学奖公布现场 / 新华社记者 彭子洋 摄

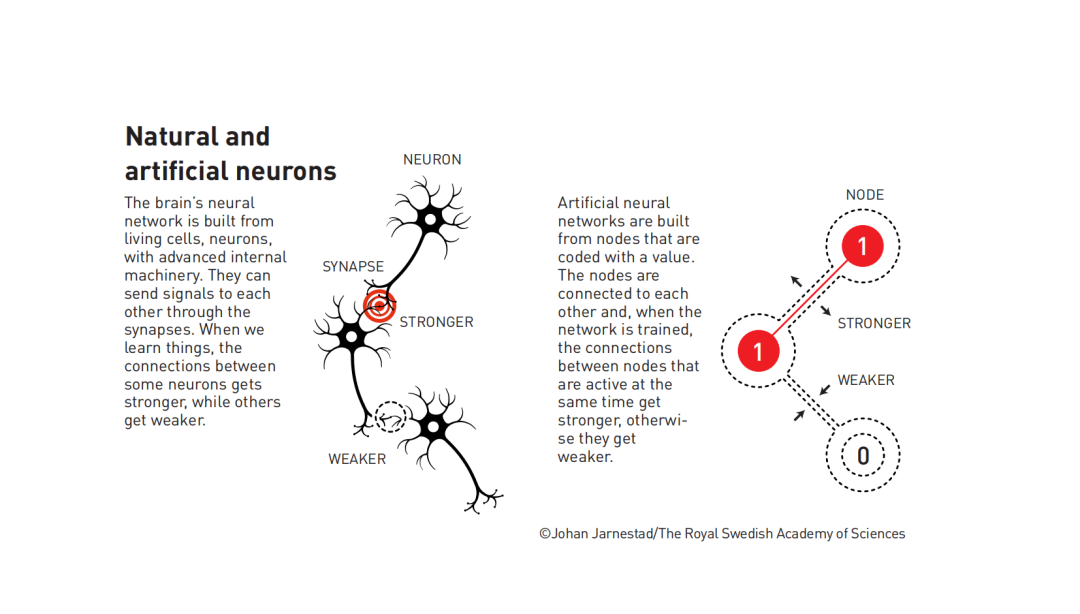

而仔细查看他们的研究会发现,在终其一生的思索里,他们都在试图用数学系统发明计算机神经网络,模拟人类大脑工作。人脑有 100 万亿个神经元连接,随时随地在互动与发射信号,像深海般充满奥秘。要想实现神经网络的野心,他们不可避免地运用物理、生物、心理学等领域的知识与灵感。

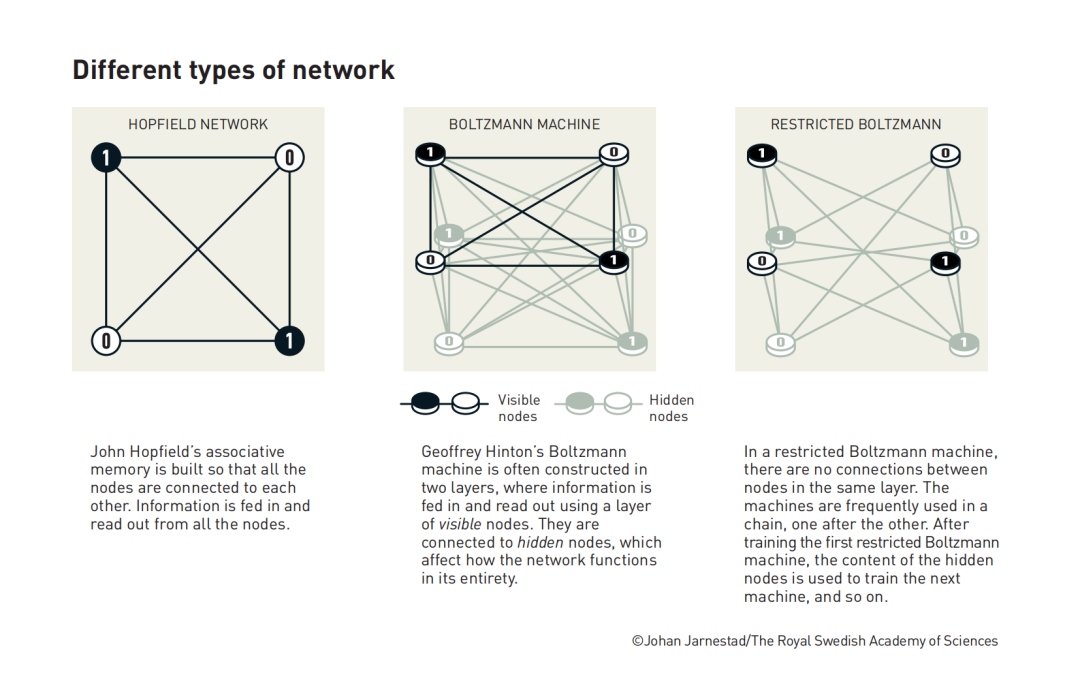

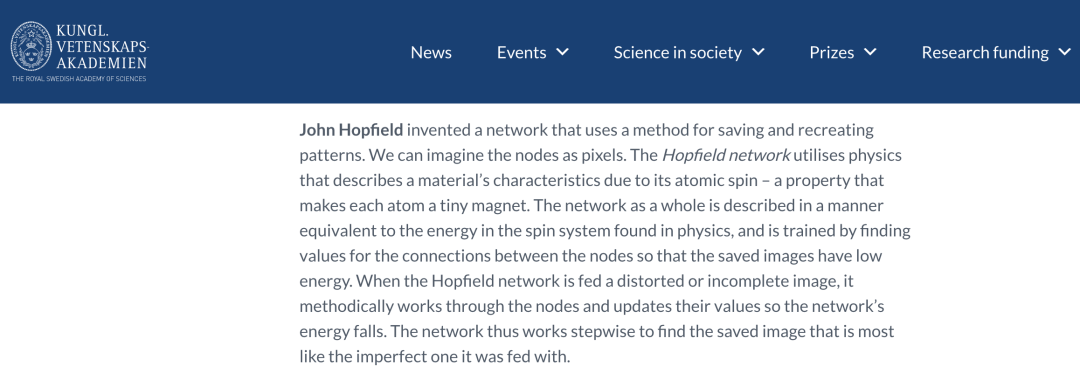

于是,1980 年代,两个跨学科的天才都提出了令 21 世纪惊叹的发现:约翰・霍普菲尔德运用物理学原子自旋原理,发明了一种得以保存记忆的神经网络。后人以他的名字命名,Hopfield 神经网络。

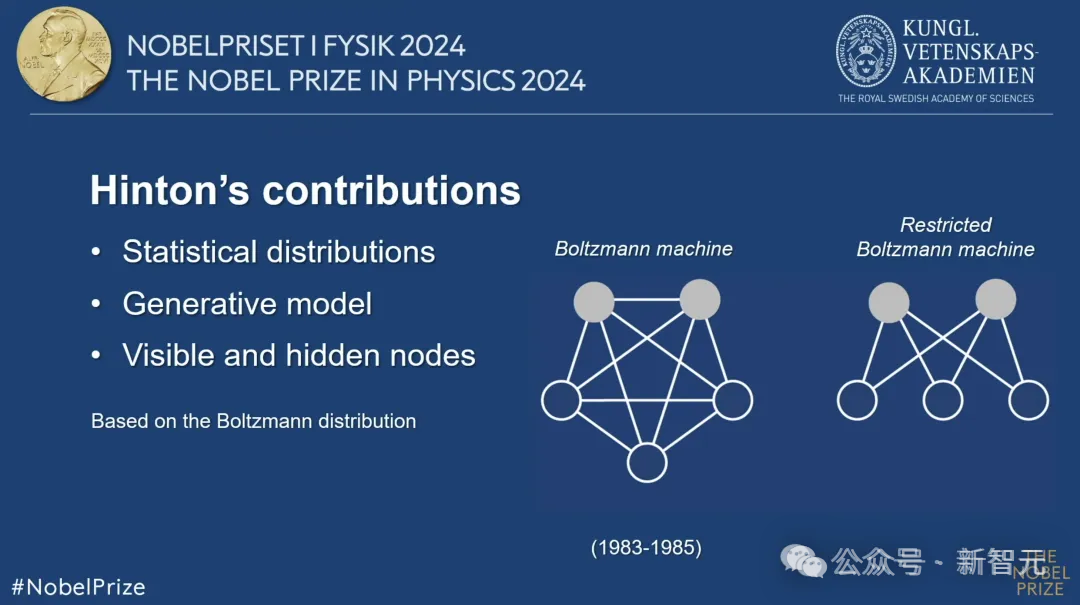

至于教父辛顿,他以 Hopfield 网络为基础,开发了一种新的神经网络:玻尔兹曼机(Boltzmann machine)。这个晦涩的新词,灵感同样来源于物理学 —— 奥地利物理学家路德维希・玻尔兹曼百年前提出的理论,涉及一个与 AI 完全无关的现象(加热气体中粒子的平衡)。

科学的突破与发现并非一蹴而就。人工智能在过往 30 多年发展起起伏伏,充满嘈杂声响,信念不断被推倒又重建。以辛顿为代表的 AI 学者,用他们的人生证明:有时候,成功来源于走在前方无人小径时,最大程度地坚持自我。

1 处处碰壁的天才

77 岁的杰弗里・辛顿,随着 ChatGPT 等大模型的火爆,在近年越来越名声大噪。他早已是图灵奖得主,密集地接受各方采访。

不过,说的内容并非所有人都爱听。就像那位不苟言笑的核物理专家奥本海默,他张口闭口说 AI 可能对人类的威胁,强大的超级人工智能会让人类进入末世,仿佛这个工具是别人发明的一样。

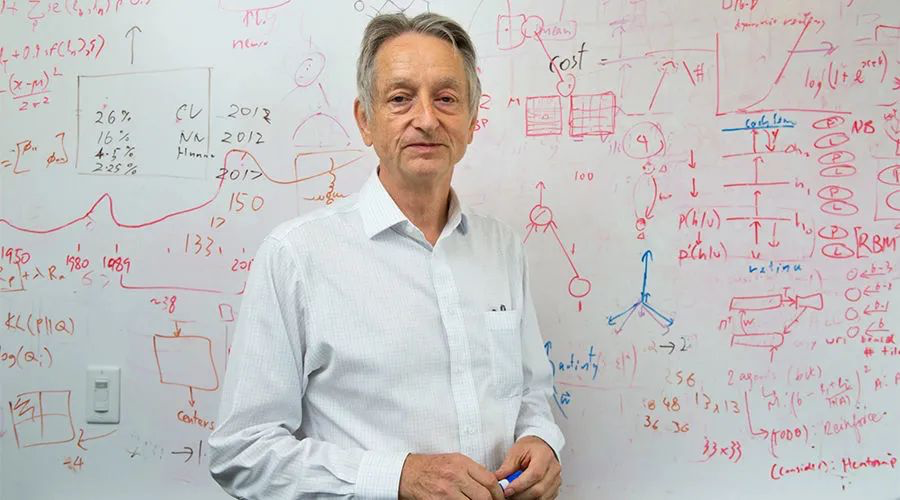

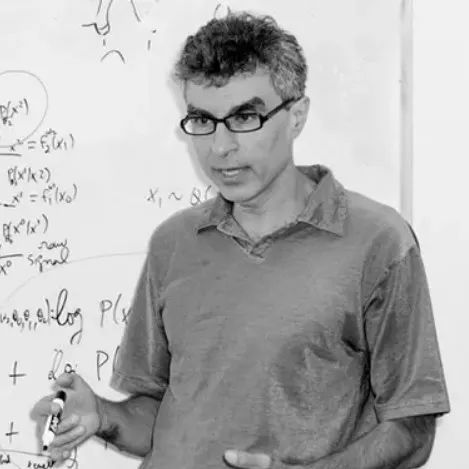

杰弗里・辛顿

除了这种看似知识分子的反思与忏悔,真正接触过辛顿的记者,都在回头书写时记录下了对他的印象:身体不好。从 2005 年开始,辛顿的腰背部出现问题。他开始很难坐立,不敢搭乘飞机出行,平时办公也是站着的。遇上商务宴席,他也不能坐在椅子上,而是选择双腿跪在地上,经常换来服务员奇怪的眼光。

他曾形容自己破烂的身体:“我每天都很煎熬,情况发展到了可能会瘫痪的地步,所以我很认真地对待这件事。如果我能完全控制自己的生活,它就不会带来任何问题。”

失去控制总是让人心生绝望,但在辛顿的人生里,他从来都是与缺乏确定性、无法受控的事情相伴。1947 年,辛顿出生在英国一个科学家和教授世家,父亲是研究甲虫的剑桥生物学家。他的亲戚们还包括《牛虻》的作者艾捷尔・伏尼契;“中国人的好朋友”、写中国土地革命《翻身》的作者韩丁;参加曼哈顿计划的女核物理学家寒春……

而在十几岁时,早慧的辛顿已经遇上了促使他思考一生的命题。他回忆,那是高中时期,一位朋友问他,“你知道吗?大脑的记忆并不是储存在某个特定的地方,而是分布在整个大脑,在整个神经网络里传播,就像全息图一样工作。” 他从此开始对人脑机制产生了浓厚兴趣。

大学期间,因为这个问题,辛顿曾学过 5 个专业,先是数、理、化,大二时又学了哲学、建筑学,后来又攻读了心理学。四年大学让他发现,所有的这些学科都无法解答人脑神经元如何连接并工作的奥秘。最终,毕业后的辛顿选择当一名木匠。

当木匠可以让人收获平静,这是他高中时期最高兴的活。只是,这位天真的知识分子也发现,没有内耗的活往往匹配较低的薪水,他不适合用此谋生。这段日子里,一到周末,他就到图书馆自学大脑工作原理。

1972 年,他再度 “转行”。凭借发表论文,他到爱丁堡大学就读人工智能学的博士 —— 又是一个全新的领域。

尽管他不熟悉计算机科学,辛顿却有着自己的直觉和信念。不巧的是,此时正值人工智能的寒冬,人们从过往对 AI 的极度乐观,到被冰冷的现实鞭打至谷底。1971 年,英国政府进行了一项人工智能进展的研究,结果显示,“大多数人工智能研究和相关工作人员承认,他们对过去 25 年取得的成就感到非常失望”。

报告称:“迄今为止,AI 在任何地方取得的成果,都没有实现它当初承诺的重大影响。”

图源:八斤制图

令人沮丧的结果并非致命的,更大的问题是,在当时人工智能界,人们开始广泛地怀疑从前的信念,即运用模拟人脑的神经网络,进行机器学习(神经网络只是众多机器学习算法和模型的一种)。

最著名的论断来自于当时的 “人工智能之父” 马文・明斯基。他对模拟人脑的 “联结主义” 派表示公开怀疑,认为计算机如果要拥有人类智能,必须用属于计算机的方式来实现。1969 年,他为此专门写了一本书,写道,“多层感知机(1960 年代的一种神经网络)不会有发展前景,因为世界上没人可以将多层感知机训练得足够好,哪怕是令它可以学会最简单的函数方法。”

明斯基的论断解释了 AI 为何过去失败了,也让人们重新拥抱了新的愿景 —— 符号人工智能。1972 年,连辛顿的博士导师朗吉特・希金斯都被明斯基的理论说服了。他开始劝说自己的学生,换一个有前途的方向吧,别做神经网络了。

辛顿回忆:“我们每周见一次面,有时会以一场大喊大叫的争论结束。”

《我,机器人》剧照

博士期间,他的研究方向始终与导师期望的背道而驰。辛顿说,他认可明斯基指出的神经网络的缺陷,但与多数人的选择不同,他想继续往 “有缺陷的方向” 前进,完善前人指出的漏洞。

至于他能这么做的原因,辛顿回忆,这可能是源于他从小在宗教学校上学,却是全班唯一不信仰宗教的人。“这对科学家是一种很好的训练,让你对自己的观点充满信心。每个人都可能是错的,你需要坚持自己的主张,直到实现它或者(彻底)否定它。做科学就需要这样的精神。”

2 交叉学科的力量

固执的辛顿在 1978 年顺利博士毕业。当时的学者也没预料到,他的坚持从此掀开了人工智能深度学习革命,并让 21 世纪的各大巨头争相进行科技军备竞赛。

那时博士毕业后,孤独的辛顿漂至了美国,总算在加州大学圣迭戈分校找到了一些志同道合的人士。他们有的来自神经生物学,有的像辛顿一样来自认知科学系,重要的是,他们分享着对联结主义的信仰,相信用计算机多层神经网络可以模拟人类大脑的演算方式。最终,机器也可以像蹒跚学步的孩子一样自我学习和进步,拥有推理能力。

看上去像天方夜谭的野心,却在当时被一群人真情实意地相信着。1982 年,加州理工学院教授霍普菲尔德率先开发了一种神经网络,用于模拟大脑如何相互作用并产生稳定记忆。

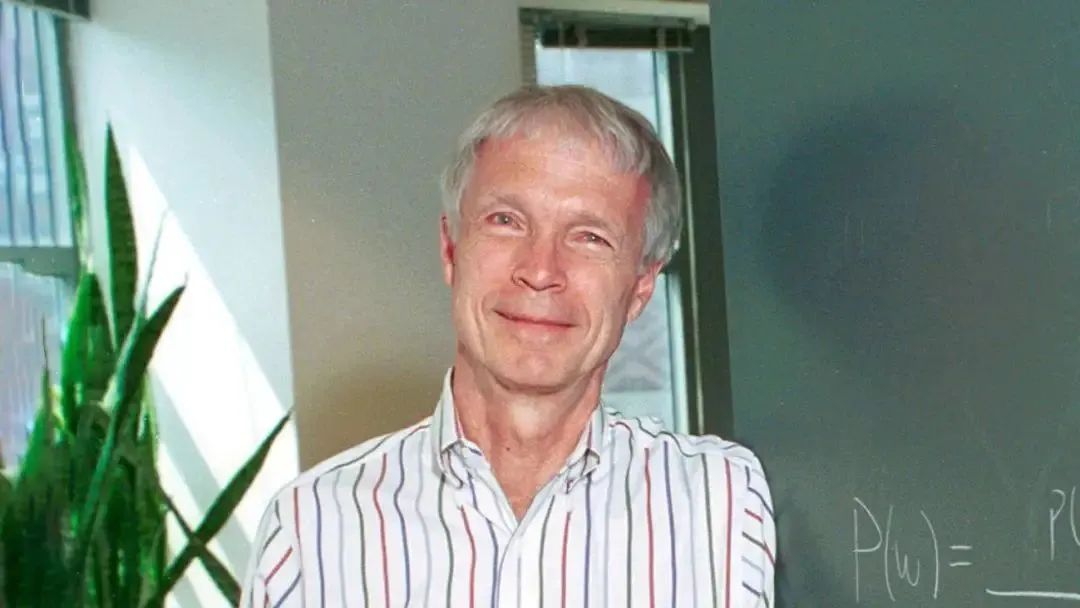

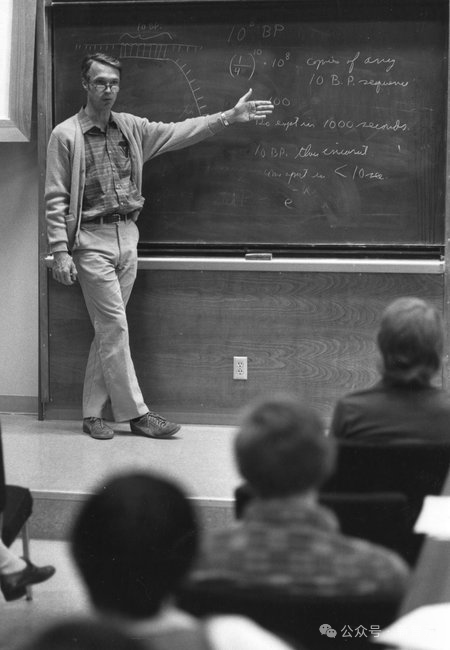

霍普菲尔德获奖后的第一张照片

这个神经网络的构建,也汲取了人类大脑的工作智慧。霍普菲尔德曾回忆,促使他走向这条道路的是一次受邀参加神经科学的会议。会议内容令他着迷,并让他开始思考神经网络的动力学特性。

人脑的运作好比需要集体演奏的交响曲,只有当神经元共同作用时,它们才能产生新的、强大的特性。“如果你只关注网络中的每一个独立神经元,是很难察觉这些特性的。” 他说。

拥有物理学背景的霍普菲尔德,开始想到原子自旋而产生的特性。这一特性使每个原子都成为了一个微小的磁铁。相邻原子的自旋会相互影响,自旋方向一致的区域得以形成。

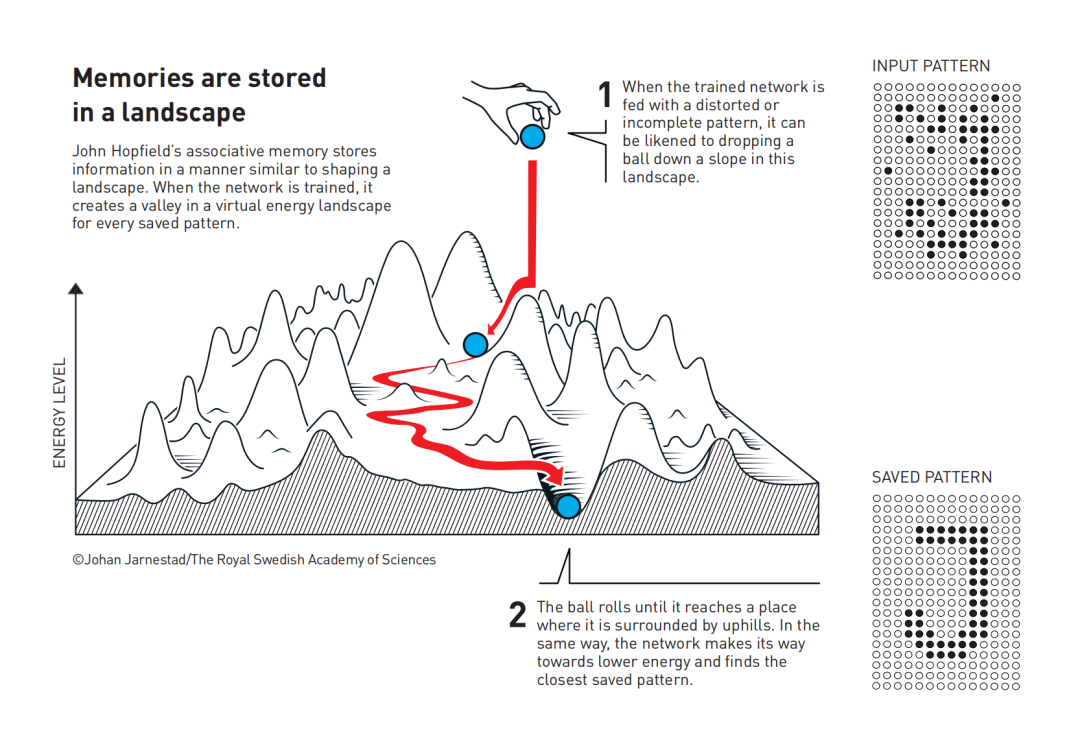

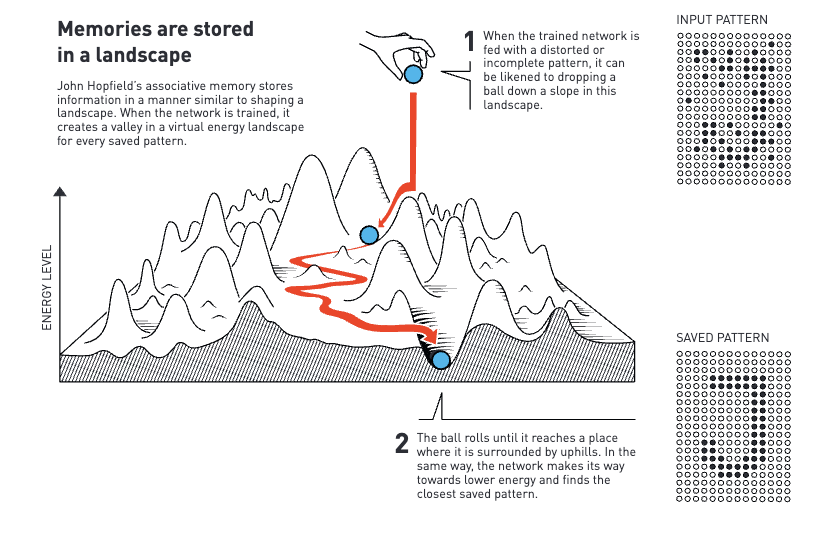

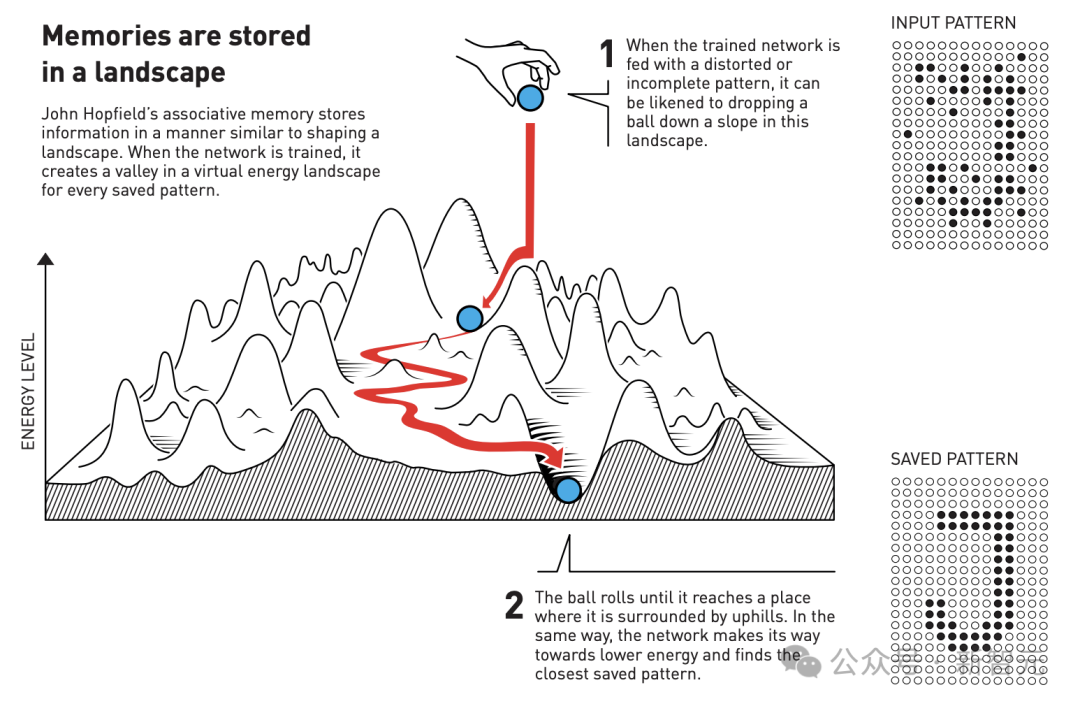

运用自旋特性,霍普菲尔德成功构建了有节点和连接的神经网络,并以能量函数作为表达。大致实现原理类似于人类的联想记忆。比如,如果神经网络接收到不完整或稍有失真的模式时,该方法能够通过能量的原理,找到与之最相近的已存储模式。

霍普菲尔德的模型示意图。首先让分子体系记住右下角的图像(字母 “J”)。此时,如果将分子体系的状态改成右上角的图,那么每个分子会按照既定的规则更改自身的能量,最终使得整体重新回到右下角的图像

记忆、存储、重现信息,这是霍普菲尔德神经网络的进步,也被后人视为联结主义复兴的标志。更年轻的辛顿也深受影响和鼓舞。

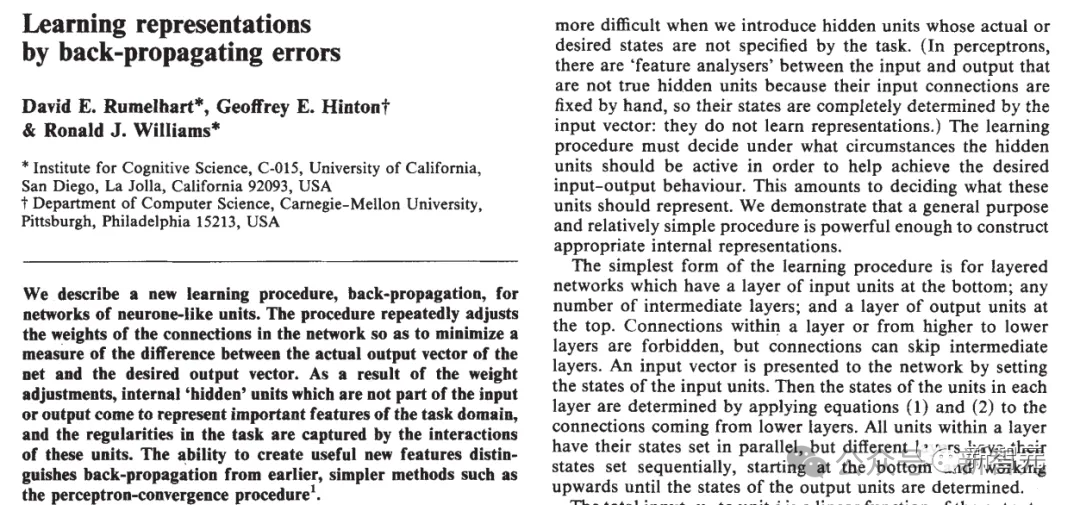

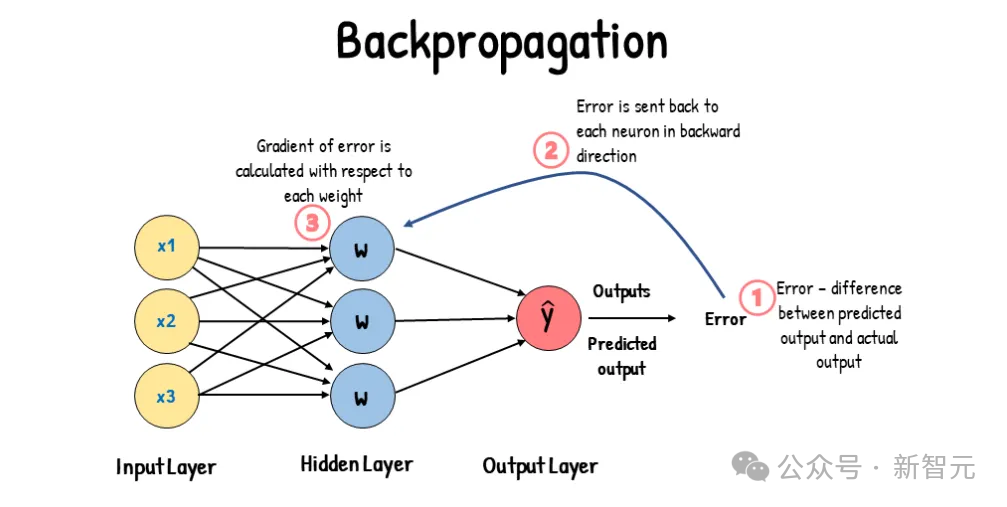

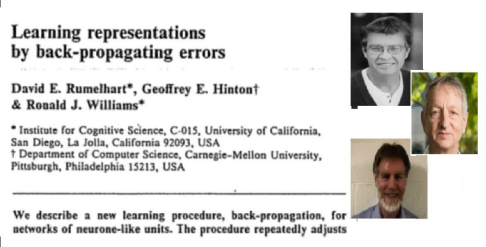

1986 年,辛顿与两名学者共同发表了一篇题为 “通过反向传播误差来学习” 的论文,成为了当代机器深度学习的奠基之作。

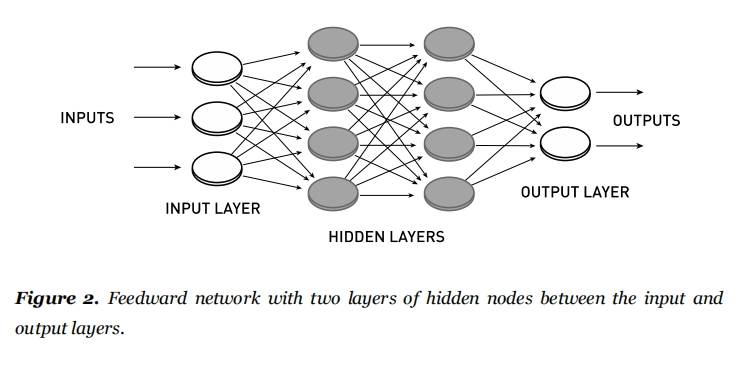

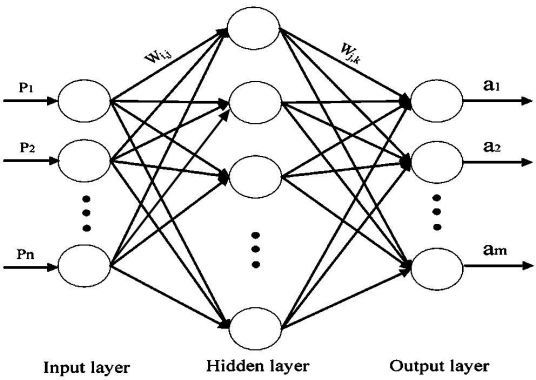

所谓的反向传播,实际是一个基于微分的算法。需要指出的是,1980 年代的研究重点与上世纪 60 年代已经截然不同:1960 年代的神经网络是一个单层网络,而吸取了明斯基教训的科学家们在 20 年后,希望建立的是有多层结构的神经网络。

他们相信,只要研究人员能够建立一个多层的网络,每一层都向下一层提供信息,这个系统就可以学习过去无法理解的复杂图形。换句话说,一个更像大脑的系统就会出现。

这个过程变成了解出嵌套函数的数学问题。如果要训练一个符合现实的神经网络,科学家们发现,他们的工作重点需要考量神经网络的输出和真实结果之间的误差;接着选择恰当的损失函数来表示误差,再根据梯度下降等优化算法,一步步修正权值参数,最后得到能拟合的神经网络模型。

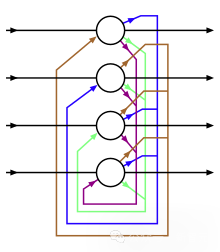

在输入层和隐藏层之间具有两层隐藏节点的馈送网络输出层

但新的难题出现了:多层神经网络内含多个隐藏层,当误差出现时,研究者们很快发现,他们极难找到误差是在哪发生的。

擅长叛逆的辛顿与同事们同时也擅长逆向思维。1986 年,他们提出反向传播算法,精髓是将误差从输出层开始倒推,反过来逐层把误差传播至每一个隐层上,直到输入层为止。每一层都依赖后面已经计算好的信息去完成求导,故称作 “反向传播”。

反向传播成功解决了多层神经网络的训练问题,证明了神经网络绝非停留在想象里的空中楼阁。

同一时期,辛顿与同事们发明了玻尔兹曼机。

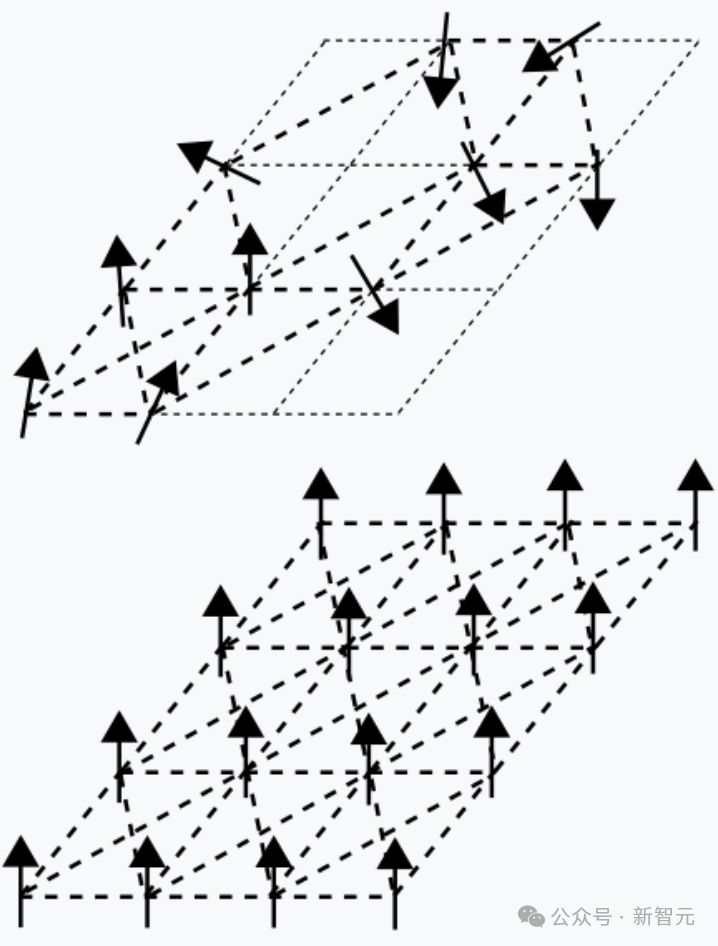

玻尔兹曼机和霍普菲尔德模型的不同在于,内部增加了隐藏节点,使得节点之间可以通过概率调节整个网络的功能

这个新神经网络汲取了统计物理学的原理,希望分析各个组件能够共同存在的各种状态,并计算它们出现的概率。这也是当今短视频等平台算法令人无法自拔的基本原理:算法可以分析和找到大数据之间的联系,接着计算不同类别的人最大概率会喜欢和讨厌的内容,并根据每次的点击情况,实时进行概率计算和内容推送。

1986 年,经过训练的玻尔兹曼机能够识别出它未曾见过的信息中的熟悉特征。这也就意味着,计算机拥有了自我学习的能力,这正是神经网络的拥趸多年来所期许的。

辛顿和同事谢诺夫斯基都为此激动不已。“这是我一生之中最激动人心的时刻,” 谢诺夫斯基说,“我们确信,已经弄清楚了大脑是如何工作的。”

3 冷门二十年

约 30 年后,诺贝尔物理学奖认可了玻尔兹曼机的发明。

“他们都是真正的先驱者,寻找到了解决问题的新方法。” 诺贝尔物理学委员会成员 Anders Irbäck 教授在 2024 年盛赞。

只是,对 80 年代的辛顿来说,萦绕在前方的仍是时而大喜、时而大悲的情绪,以及与科学有关的迷雾之中。

他和同事都以为将改变世界进程的玻尔兹曼机,只在 80 年代末期人工智能的又一波热潮时得到了关注。

1990 年代,人工智能发展再度进入瓶颈期。各种基于统计的机器学习方法兴起,研究神经网络的人越来越少了。辛顿成为了少数几个仍在其中坚持的人。

杰弗里・辛顿曾在社交媒体上写道:毛毛虫提取营养物质,然后转化为蝴蝶。GPT-4 也像人类社会的蝴蝶般,提取了人类数十亿的知识

后来人们才发现,当时的停滞并不代表辛顿提出的理论和设想是错误的。想法受限于当时计算机技术处理计算的能力。

辛顿在一次采访中感慨:“追溯到 1986 年,我们首次开发出反向传播算法,我们因其能学习到多层的特征探测而感到兴奋,我们认为已经解决了这个问题。但在解决实际问题中却没有出现大的突破,这非常令人失望,我们完全猜错了需要的计算资源和标记案例数量。”

这样的停滞伴随着辛顿接下来的 20 余年科研历程,神经网络始终不受学界主流认可。为了拿到教研经费,他曾在伦敦大学学院、多伦多大学等地工作,最后终于在 2004 年从加拿大高等研究院申请到了每年 50 万美元的经费支持。

直到 2006 年以前,辛顿即使已经在英国、加拿大是院士级别的人物,但他的发现只在学界里有名气,从未得到现实的广泛应用。但他始终坚信神经网络将引起人工智能革命。据称,为了给自己打气,辛顿还养成了一种自我激励的方法,每周发泄般大吼一次:“我发现大脑是怎样工作的啦!”

天然神经系统和人工神经网络的相似性。关于人工神经网络的理论在几十年前就已形成,但当时人们并没有找到实现它的方法

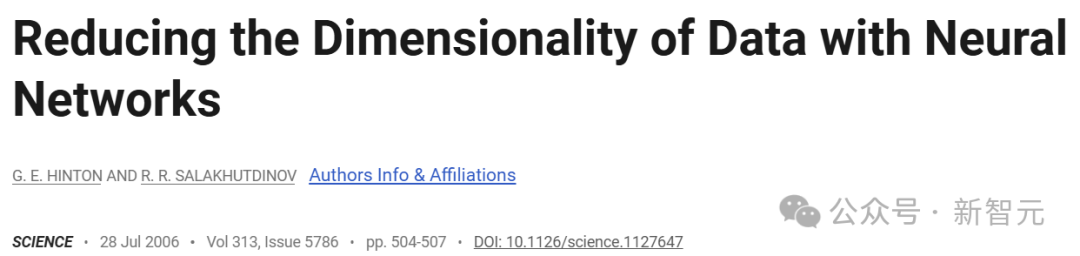

2006 年,深度学习革命终于在全球打响。这个新时代的序幕依然是由辛顿和学生拉开的。他们在两篇论文里论证道,深度神经网络具有自主学习的能力。比起人类,深度学习的自编码器对数据有更本质的刻画,从而有利于可视化和分类。

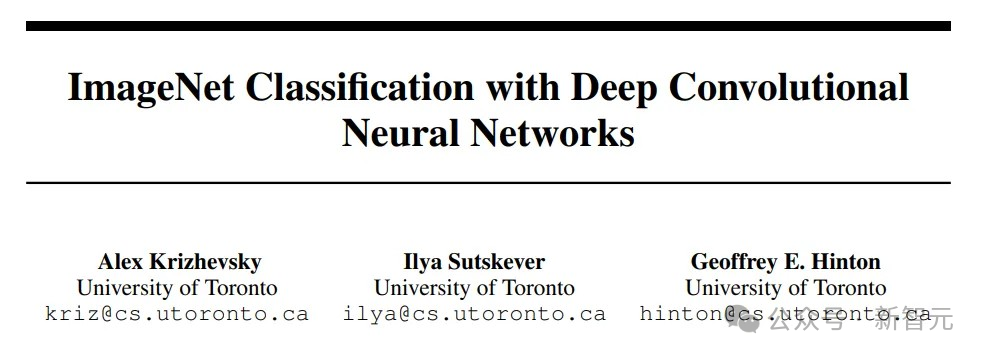

这一全新的概念经历了此后 6 年的储备,终于在 2012 年点燃全世界。2012 年,在华裔科学家李飞飞举办的 ImageNet 图像识别竞赛中,辛顿和学生伊利亚(Ilya Sutskever,前 OpenAI 首席科学家)和亚历克斯(Alex Krizhevsky)组成团队,设计了名为 “AlexNet” 的卷积深度网络程序,一举夺冠。

这次夺冠并非只是拿到冠军那么简单。辛顿和学生以全场都没有用过的方式,取得了颠覆性的胜利。

4 “快乐和悲伤交织”

后来的故事更为人所知。2012 年一举成名后,辛顿收到了来自百度、谷歌、微软以及 DeepMind 等巨头的千万美元年薪橄榄枝。他于是听从律师建议,在美国华达州的哈拉斯赌场,对着争相而来的科技巨头,举行了一场邮件竞拍。

最终,他在身价被提高到了 4400 万美元时,叫停了拍卖,选择加入谷歌。

杰弗里・辛顿在谷歌总部外

失败的百度从此决心向深度学习上储备人才,先后建立了深度学习研究院和自动驾驶研究院。主导百度参与辛顿竞拍的负责人、现地平线创始人余凯回忆:“尽管竞拍失败,但我还是很开心的。我想我的目的也达到了,因为李彦宏亲眼见证了国际巨头不惜花费巨资来投资深度学习研发,这让他下定决心自己把深度学习做起来。”

进入 21 世纪的第二个十年,大模型、AI 视觉、AIGC 等多个应用,终于迎来大爆发。辛顿等到了盼望已久深度神经网络引发的人工智能浪潮。

这是属于他引领的时代。

他却自述过往,认为他的人生与 AI 浪潮一样,徘徊在反反复复的起伏里。“我经常会告诉大家,我弄清大脑的工作机制了,可过段时间,我又失望地发现之前的结论是错误的。”

“但事情就应该是这样发展的。正如(英国)诗人威廉・布莱克的两句诗,‘将快乐和忧伤编织,披在我神圣的心上’。”

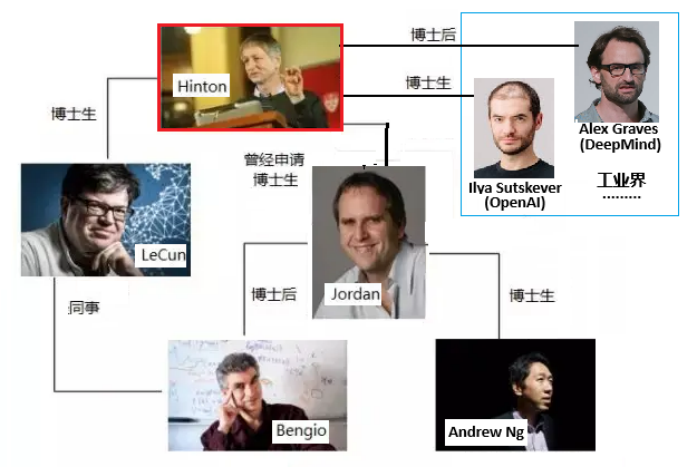

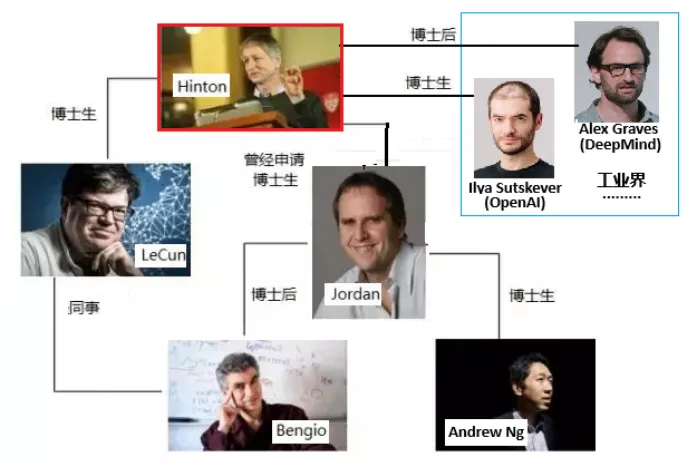

2023 年,离开谷歌的辛顿越来越活跃于媒体之中。他近年因为大模型的热潮早已荣誉加身,人们喊他教父,对他进行膜拜。连他的很多早期追随者,如今也成为了科技巨头。例如学生伊利亚,与奥特曼一起创立 OpenAI,是 AI 浪潮的引领者之一。

看上去,辛顿没有什么烦恼可言了。

《终结者 5》剧照

但他却表现得越来越忧心忡忡,担心 AI 有一天会掌控人类社会。2024 年,他在诺贝尔奖颁布的现场连线时说:“我感到愧疚和后悔。”

“后悔有两种。一种是因为你做了一些明知不该做的事情而感到内疚;另一种是你做了一些在同样情况下会再次做的事情,但最终结果可能并不好。我的遗憾是第二种。我担心这种做法的后果是,比我们更聪明的系统最终会掌控一切。”

-END-

值班主编 | 黄茗婷

排版 | 八斤

诺贝尔物理学奖罕见一幕!“AI 教父” 意外获奖,物理圈傻眼

原创 李水青 程茜 智东西 2024 年 10 月 08 日 20:18 浙江

诺奖!颁给了俩 AI 圈大佬,91 岁和 77 岁。

作者 | 李水青 程茜

编辑 | 漠影

智东西 10 月 8 日消息,今日,瑞典皇家科学院宣布,将 2024 年诺贝尔物理学奖授予约翰・霍普菲尔德(John J. Hopfield)和杰弗里・辛顿(Geoffrey E. Hinton),以表彰他们推动利用人工神经网络进行机器学习的基础性发现和发明。

▲瑞典皇家科学院公告截图

其中,出生于 1933 年、现年 91 岁的 Hopfield 是美国著名的物理学家、生物学家和神经科学家。他发明了一种具有联想记忆功能的神经网络模型,可以存储和重建图像及其他类型的数据,对人工智能和神经网络发展具有奠基作用。

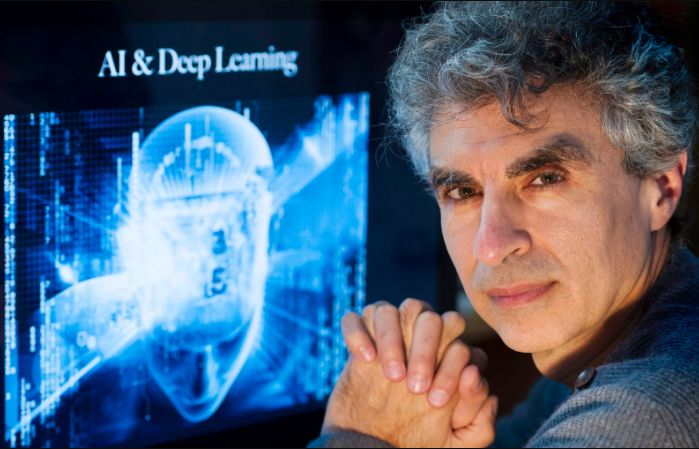

▲约翰・霍普菲尔德(John J. Hopfield)

出生于 1947 年、现年 77 岁的 Hinton 是图灵奖得主、“深度学习之父”,他在 Hopfield 研究基础上,发明了一种可以自主查找数据属性的方法,从而执行识别图片中特定元素等任务。他凭借玻尔兹曼机以及反向传播算法、分布式表示等研究被业内誉为 “AI 先驱”。

▲杰弗里・辛顿(Geoffrey E. Hinton)

Hinton 今日在诺贝尔物理学奖颁布时线上接受媒体采访,被问及现在的感受时说:“我大吃一惊,不知道会发生这种事。”

“获奖者的工作已经产生了巨大的效益。在物理学领域,我们将人工神经网络应用于广泛的领域,例如开发具有特定属性的新材料等。” 诺贝尔物理学奖委员会主席 Ellen Moons 说。

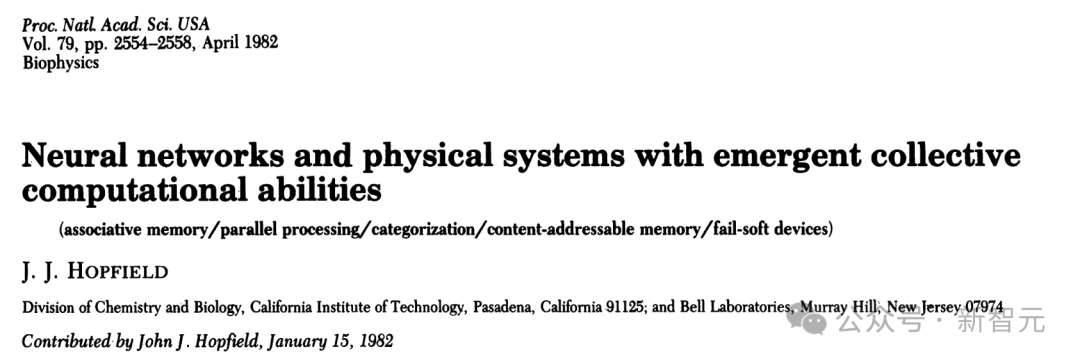

01. John J. Hopfield:用物理学训练人工神经网络,42 年前论文为 AI 奠基

根据瑞典皇家科学院公告,Hopfield 的主要贡献如下:

“John J. Hopfield 发明了一种使用保存和重现模式方法的网络 ——霍普菲尔德网络(Hopfield Network)。

我们可以将节点想象成像素。霍普菲尔德网络利用物理学来描述材料由于原子自旋而产生的特性,这种特性使每个原子都成为一个微小的磁铁。整个网络的描述方式相当于物理学中自旋系统的能量,并通过寻找节点之间连接的值来进行训练,以便保存的图像具有较低的能量。

当霍普菲尔德网络被输入扭曲或不完整的图像时,它会有条不紊地处理节点并更新它们的值,从而降低网络的能量。

因此,网络逐步找到与输入的不完美图像最相似的保存图像。”

出生于 1933 年、现年 91 岁的 Hopfield 是美国著名的物理学家、生物学家和神经科学家,1958 年获得美国纽约州伊萨卡康奈尔大学博士学位,现任美国新泽西州普林斯顿大学教授。

他曾在贝尔实验室做过技术人员,1982 年发表了 “Neural networks and physical systems with emergent collective computational abilities”(《具有涌现集体计算能力的神经网络和物理系统》)论文,是他被引用次数最多的论文,1986 年参与创立了加州理工学院的计算与神经系统博士项目。

Hopfield 提出的霍普菲尔德网络是一种具有联想记忆功能的神经网络模型,在当时使得遭受质疑而陷入停滞的神经网络重新成为 AI 重要研究方向,为后续神经网络的蓬勃发展奠基。

02. Geoffrey E. Hinton:“深度学习之父”将深度学习推向主流

根据瑞典皇家科学院公告,Hinton 的主要贡献如下:

“Hinton 以霍普菲尔德网络为基础,发明了一个采用不同方法的新网络:玻尔兹曼机(the Boltzmann machine)。

它是一种基于统计物理学的网络,可以学习识别给定类型数据中的特征元素。

Hinton 使用了统计物理学的工具,通过输入机器运行时很可能出现的示例来训练机器。玻尔兹曼机可用于对图像进行分类,或创建训练模式类型的新示例。Hinton 在此基础上继续发展,帮助开启了机器学习的爆炸式发展。”

出生于 1947 年、现年 77 岁的 AI 先驱 Hinton 是一位英裔计算机科学家,1978 年在英国爱丁堡大学获得博士学位,现任加拿大多伦多大学教授。

2012 年,Hinton 联合其学生构建了一个神经网络,可以分析数千张照片,并自学识别花、狗和汽车等常见物体。Hinton 与学生研发的神经网络在当年 ImageNet 大规模视觉识别挑战赛中以巨大优势夺冠,从而将深度学习推向主流。

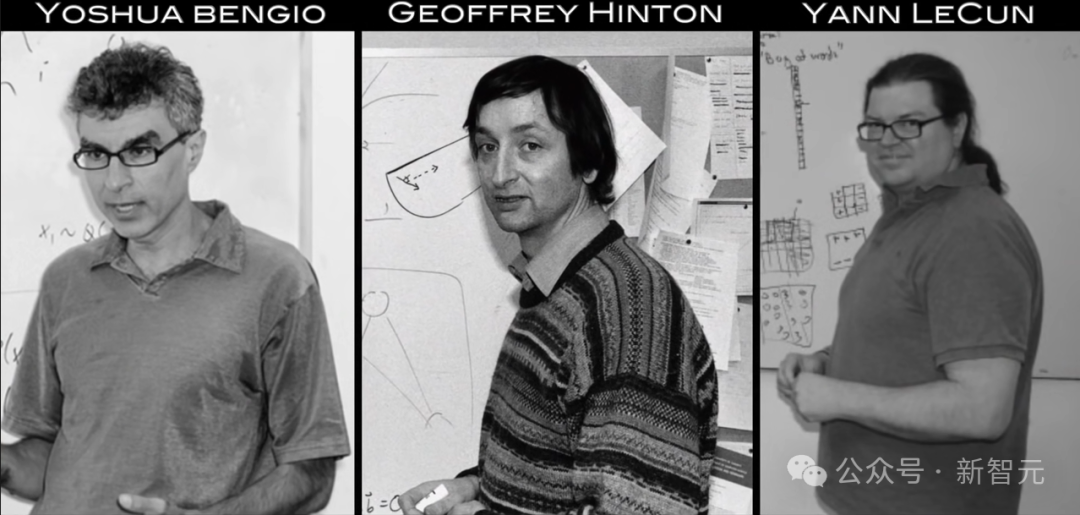

2018 年,Hinton 与 Yoshua Bengio(约书亚・本吉奥)和 Yann LeCun(杨立昆)一起获得了 2018 年图灵奖,自此,他们三人经常被合称为 “深度学习之父”。

▲三人并称 “深度学习之父”

Hinton 当下非常关注 AI 未来的巨大不确定性,并强调负责任监管 AI 的重要性。他在谷歌工作了十年,由于担心 AI 的风险而于去年 5 月离职,辞去谷歌副总裁和工程研究员职务。

03. 融合物理学背景为机器学习革命奠定基础

Hopfield 和 Hinton 从 1980 年代开始的工作,为 2010 年左右开始的机器学习革命奠定了基础。

1982 年,Hopfield 发明了联想记忆,这类似于人们在相似单词中搜索不常使用单词的过程。他构建的网络可以基于存储信息重新创建模式,当为网络提供的是不完整或略微扭曲的模式时,这一网络可以找到最相似的存储模式。

当时,Hopfield 利用了他的物理学背景来探索分子生物学的理论问题,在南加州帕萨迪纳加州理工学院,他找到了构建具有许多小组件协同工作系统的灵感。受益于了解磁性材料的物理学原理,他能够使用描述自旋相互影响时材料的物理学特性,来构建具有节点和连接的示例网络。

他构建的网络具有以不同强度连接在一起的节点,每个节点都可以存储一个单独的值,在第一项工作中该值可以是 0 或 1,就像黑白图片中的像素一样。这一方法很特殊,其网络可以同时保存多张图片并且进行区分。

同时,如下图所示,霍普菲尔德网络可用于重新创建包含噪声或已部分擦除的数据。

这之后,Hopfield 和其他人继续开发这一网络如何运作的相关细节,包括可以存储任何值的节点不仅仅是 0 或 1。

但存储图像是一回事,想要解释它所描绘的内容是另一回事。

Hinton 在美国匹兹堡卡内基梅隆大学工作时,就和同事一起利用统计物理学的思想对霍普菲尔德网络进行扩展,并构建新的东西。

1990 年代,许多研究人员对人工神经网络失去了兴趣,但 Hinton 仍没有放弃,并开启了这一研究领域的新一轮爆发式增长。2006 年,他和同事开发了一种预训练网络的方法,该方法将一系列玻尔兹曼机分层,一个在另一个上面。这种预训练为网络中的连接提供了一个更好的起点,从而优化了其训练以识别图片中的元素。

Hopfield 和 Hinton 开发的开创性方法和概念是有助于塑造人工神经网络领域。此外,Hinton 在这项工作中发挥了主导作用将方法扩展到深度和密集的 ANN。

当下机器学习的发展是基于大量数据以及计算能力的巨大提高而实现的。1982 年,Hopfield 发布关于联想记忆的文章,就为这一发展提供了支持。他使用了具有 30 个节点的网络,如果所有节点都相互连接,就有 435 个连接。与今天的大型语言模型进行比较,这些模型被构建为可以包含超过 1 万亿个参数(100 万万个)的网络。

许多研究人员现在正在研发机器学习的相关应用,但哪一个方法更可行还有待观察,同时围绕这项技术的开发和使用的道德问题也存在广泛的讨论。不过,由于物理学为机器学习的发展提供了工具,因此看到物理学作为一个研究领域如何从人工神经网络中受益是很有趣的。

同时,机器学习长期以来一直被用于诺贝尔物理学奖中熟悉的领域,包括使用机器学习来筛选和处理发现希格斯粒子所需的大量数据、减少测量碰撞黑洞引力波的噪声、寻找系外行星等。

04.结语:神经网络基础研究助 AI 爆发式发展

今年的两位诺贝尔物理学奖得主,利用物理学工具开发出的方法,为当今强大的机器学习奠定了基础。

他们从 1980 年代开始就对人工神经网络进行了重要的研究。AI 领域基础研究在当下节点上获得国际重量级的诺贝尔奖,体现了 AI 的巨大效益和对人类发展的深刻影响日益显著。

AI 教父 Hinton 获诺奖后:谷歌 CEO 办庆功宴,奖金计划捐出,还 Diss 了一把阿尔特曼

原创 程 茜 智东西 2024 年 10 月 09 日 19:10 北京

Hinton:物理学是神经网络早期灵感缪斯,现阶段研究关系不大。

作者 | 程茜

编辑 | 李水青

智东西 10 月 9 日消息,昨天,诺贝尔物理学奖授予了推动人工神经网络发展的约翰・J・霍普菲尔德(John J. Hopfield)和杰弗里・E・辛顿(Geoffrey E. Hinton)。诺奖罕见地颁给了 AI 专家,作为图灵奖得主、“深度学习之父” 的辛顿本人也表示大吃一惊。

就在今天,辛顿前东家谷歌为其举办了庆功宴,**谷歌 CEO 桑达尔・皮查伊(Sundar Pichai)、谷歌首席科学家杰夫・迪恩(Jeff Denn)、OpenAI 前联合创始人伊利亚・苏茨克维(Ilya Sutskeve)**等 AI 圈大佬悉数到场。实属罕见,一个诺贝尔物理学奖的庆功宴竟然不见物理学大牛。

▲部分参与庆功宴人士合影(左图:左四为杰弗里・辛顿,右一为伊尔亚・苏茨克维;右图右二为桑达尔・皮查伊)(图源 X)

辛顿如何看待这次获奖?为什么诺贝尔物理学奖颁给了 AI 专家?这又将对未来 AI 发展有什么影响?

诺贝尔物理学奖公布不久,辛顿接受了《纽约时报》、瑞典电视台、每日新闻、瑞典电视频道 TV4、瑞典报纸等多家媒体以及多伦多大学新闻发布会的采访,针对上述问题进行了回应。

对于惊讶自己获得诺奖的原因,辛顿提到,神经网络发展的前期阶段很大程度上依赖于物理学的想法,他研发的玻尔兹曼机就是在早期阶段帮助 AI 研究克服了 “训练深度神经网络” 的障碍。但 “最近(AI)这项工作与物理学的关系较少”。

辛顿目前最常用的 AI 工具是GPT-4,但他不会完全信任它。伴随着 AI 的发展,他认为在未来 20 年的某个时候,AI 将比人类更聪明。同时辛顿也看好机器人技术的发展前景,“让 AI 能够熟练地操纵事物,目前我们在这方面比计算机或人工神经网络好得多”。

他还呼吁加强对 AI 安全以及由好奇心驱使的基础研究的支持。辛顿称,他已经 76 岁,不会再进行前沿研究,将花时间倡导人们从事安全工作。他还特别自豪:“我的一个学生解雇了 Sam Altman。” 他认为:“OpenAI CEO 萨姆・阿尔特曼(Sam Altman)现在更关心利润,而不是安全,我认为这很不幸。”

关于诺奖奖金的使用,辛顿说要将其全部捐给慈善机构,他将获得550 万瑞典克朗(折合约 375 万人民币)。

该奖项授予了霍普菲尔德于 20 世纪 80 年代初开发的一种名为霍普菲尔德网络的技术,以及随后几年由辛顿协助开发的一种名为玻尔兹曼机的相关技术。这也使辛顿成为历史上首个同时获得 “计算机界的诺贝尔奖” 图灵奖和诺贝尔物理学奖的科学家。

上述采访累计超过 40 分钟,智东西在不改变原意的情况下进行了整理编辑。

01. 今天 AI 模型与物理关系不大,玻尔兹曼机的作用像 “酶”

在得知辛顿博士获得诺贝尔物理学奖后不久,《纽约时报》通过电话联系到了他。

《纽约时报》:当您听到今天早上的新闻时,您的反应是什么?

辛顿:我非常震惊,我从来没有想到过这一点。

《纽约时报》:神经网络是计算机技术,这与物理学有何关系?

辛顿: 霍普菲尔德网络及其进一步发展的玻尔兹曼机是基于物理学的。霍普菲尔德网络使用能量函数,玻尔兹曼机使用统计物理学的思想。因此,神经网络发展的那个阶段确实在很大程度上依赖于物理学的想法。

但用于构建今天使用的 AI 模型的实际上是一种不同的技术,称为反向传播(Back Propagation),这与物理学关系不大。

《纽约时报》:玻尔兹曼机和反向传播之间有什么关系?

辛顿: 现在没有太多联系,它们是我们如何让神经网络运行的两种替代理论。早期,我使用玻尔兹曼机 “预训练” 反向传播网络来设法将它们结合起来。但现在人们不这样做了。

《纽约时报》:预训练是什么意思?您能用读者能够理解的语言进行解释吗?

辛顿: 我想起了物理学家理查德・费曼获得诺贝尔奖时所说的话。一位记者问他:“费曼教授,您能用几分钟解释一下您为何获得诺贝尔奖吗?” 费曼回答道:“听着,伙计,如果我能在几分钟内解释清楚,那就不值得获得诺贝尔奖了。”

《纽约时报》:可以肯定地说,玻尔兹曼机器对于 AI 研究来说是一条死胡同,研究将往什么方向发展?

辛顿: 我认为这个想法就像一种酶,酶可以帮助人跨越障碍 —— 即使它不是最终解决方案的一部分。玻尔兹曼机就像一种酶,它让我们克服了 “如何训练深度神经网络?” 的障碍。这使得训练他们变得更容易。一旦我们学会了如何做到这一点,我们就不再需要玻尔兹曼机了。

《纽约时报》:您是否直接与约翰・霍普菲尔德就这些想法进行过合作?

辛顿: 不,我读过他的论文。但我的主要合作者之一特里・塞诺夫斯基(Terry Sejnowski)与霍普菲尔德一起工作并获得了博士学位。

《纽约时报》:您获得这个物理学奖是不是很奇怪?

辛顿: 如果计算机科学有诺贝尔奖,我们的工作显然会更合适,但没有。

《纽约时报》:这是一个很好的表达方式。

辛顿: 这也是一种暗示。

《纽约时报》: 是的,也许我们需要计算机科学领域的诺贝尔奖。无论如何,你因帮助创造了一项你现在担心会给人类带来严重危险的技术而获得了诺贝尔奖。你对此有何感想?

辛顿: 获得诺贝尔奖可能意味着人们会更认真地对待我。

《纽约时报》:当您警告未来的危险时,会更加认真地对待您吗?

辛顿: 是的。

02. 经常使用 GPT-4

接到获奖电话取消核磁共振扫描

诺贝尔物理学奖宣布时,辛顿接受了几家媒体的线上采访。

主持人: 早上好,辛顿教授。请接受我们对您获得诺贝尔物理学奖的最热烈祝贺。你现在感觉怎么样?

辛顿: 非常感谢。我惊呆了,我没想到会发生这种事。

▲Hinton 在诺贝尔物理学奖颁布时线上接受媒体采访

瑞典电视台:您还记得您意识到自己取得突破时的情景吗?这些发现的缘由或灵感是什么?

辛顿: 我记得与我的两位导师有过几次合作,因此我非常感谢大卫・格拉梅尔哈特(David Rommelhart)和特里・萨诺夫斯基(Terry Sanofsky)。在格拉梅尔哈特的帮助下,我们重新发现了反向传播算法,那是在 1982 年初。在萨诺夫斯基的帮助下,他和我发现了一种用于具有隐藏单元的霍普菲尔德网络的学习算法。我记得很清楚,我们参加了在罗切斯特举行的一次会议,霍普菲尔德发表了演讲,我第一次了解到神经网络的霍普菲尔德能量函数。

之后,萨诺夫斯基和我开始研究如何将神经网络推广到具有隐藏单元的霍普菲尔德网络。1982 年初,我们成功提出了一种适用于具有隐藏单元的霍普菲尔德网络的学习算法。所以对于我而言,最激动人心的时刻就是与格拉梅尔哈特一起研究反向传播算法,与萨诺夫斯基一起研究玻尔兹曼机。

波兰电视台:神经网络和机器学习未来能做什么?您如何预测这项技术将对我们的文明产生多大的影响?

辛顿:我认为它将产生巨大的影响。它将与工业革命相媲美,但不会在体力上超越人类,而是在智力上超越人类。我们还没有体验过拥有比我们更聪明的东西会是什么样子。

在许多方面,AI 都大有裨益。在医疗保健等领域,AI 将为我们提供更好的医疗保健服务。在几乎所有行业,AI 都将提高工作效率。人们将能够在更短的时间内利用 AI 助手完成相同的工作量。这意味着生产力将大幅提高,但我们也必须担心一些可能的不良后果,尤其是这些事情失控的威胁。

《每日新闻》:去年你在接受《纽约时报》采访时说,你对部分工作感到后悔,因为 AI 存在风险。你现在对此有何感想?

辛顿: 后悔有两种意思。后悔是因为你做了一些明知不该做的事,所以感到内疚。还有一种后悔是因为你做了一些事,如果在同样的情形下,你会再做,但结果可能并不好。我有第二种后悔。如果在同样的情形下,我会再做同样的事。但我担心,这种情况的总体后果可能是比我们更聪明的系统最终会掌控一切。

瑞典电视频道 TV4:我想知道玻尔兹曼机会产生什么类型的 AI?你研究什么样的人工智能?

辛顿: 我参与了两种不同的学习算法,一种是玻尔兹曼机,这是一种带有隐藏单元的霍普菲尔德网络的学习算法。我们最终找到了一个实用的版本,但这并不是目前神经网络取得主要进展的原因。另一种是反向传播算法,这是一种让神经网络学习任何东西的方法。反向传播算法带来了 AI 应用的激增,以及识别图像、理解语音和处理自然语言的能力。这不是玻尔兹曼机做的,而是反向传播算法。

瑞典报纸:你有最喜欢的 AI 工具吗?

辛顿: 我实际上经常使用GPT-4。每当我想知道任何事情的答案时,我都会去问 GPT-4。我并不完全信任它,因为它会产生幻觉,几乎所有事情上它都不是很好的专家,但这非常有用。

半岛电视台英语频道:你接到诺奖电话时在哪里?它对你有什么影响?

辛顿: 我在加州一家廉价酒店,没有互联网连接,电话信号也不太好。我本来今天要做核磁共振扫描,但我想我得取消了。

03. 支持伊利亚离开 OpenAI 阿尔特曼更关心利润

今天,多伦多大学还在线上举办了表彰和庆祝 2024 年诺贝尔物理学奖获得者杰弗里・辛顿的活动。

辛顿在多伦多大学度过了大约三十年的出色学术生涯,其多学科研究项目不仅与 AI 和机器学习相关,还与物理学、认知心理学、神经生物学、数学优化和信息论相关。

表彰活动上,辛顿首先提及了一起进行研究的两位导师和许多学生,并自豪地称:“我的一个学生解雇了 Sam Altman”。

问题:现在加拿大的研究格局与刚开始时有何不同?今天在加拿大取得更多研究突破的最大瓶颈是什么?

辛顿:一个很大的区别是,人们现在认识到神经网络实际上是有效的,但大部分情况是相似的,加拿大有名为加拿大高级研究所的实力雄厚的组织, 这对进行研究的人们有很大帮助。我认为加拿大的主要问题是做研究没有美国那么多资金,但它使用资金的方式相当明智,特别是此类研究的主要资助委员会,他们将资金用于好奇心驱动的研究以及所有先进的神经网络研究,不是为了在应用问题上投入金钱,而是为了让科学家跟随他们的好奇心去尝试和理解事物,加拿大在这方面非常擅长。

问题:你此前警告了不受控制的人工智能的危险,并且我们对它现在的工作原理了解不够,我们如何避免灾难?

辛顿:我们目前不知道如何避免这一切,这就是为什么我们迫切需要更多的研究,所以我提倡最优秀的年轻研究人员应该致力于人工智能安全,政府应该迫使大公司提供相应的计算设施。

问题:你能详细说明一下你对人工智能的担忧吗?你是否相信它可能会变得比人类更聪明?你为什么相信这会发生以及多快会发生?

辛顿:我认识的大多数顶尖研究人员都相信 AI 将变得比人类更聪明。对于这一预期的时间维度有所不同,很多人相信这将在未来 20 年的某个时候发生,有些人相信这会发生得更快,有些人认为这需要更长的时间,但相当多的人相信,在未来 20 年的某个时候,AI 将比我们更聪明,我们需要认真思考会发生什么。

问题:当你刚得知自己获奖时,你第一个打给了谁?她的反应是什么?

辛顿:我的姐姐,她在澳大利亚。她说:“我的天。”

问题:今天早上得知诺贝尔奖得主的消息时,你感到大吃一惊,这一天你过得怎么样?

辛顿:我睡得很少,当时是加利福尼亚州的凌晨 1 点,电话接通时,我已经睡了大约一个小时,挂了电话后,我可能又睡了大约一个小时,所以我现在睡眠不足。并且有很多人试图联系我,还收到了很多年前老朋友的留言。

问题:当你得知这个奖项时你用了 “大吃一惊” 这个词,为什么你这么惊讶?

辛顿:我完全不知道我被提名了,我不是物理学家。所以获得物理学奖对我来说非常令人惊讶, 我很高兴诺贝尔委员会认识到人工神经网络领域取得的巨大进步。霍普菲尔德的工作与物理学密切相关,我和特里・辛诺夫斯基在玻尔兹曼机上所做的一些早期工作受到了统计物理学的启发,但最近这项工作与物理学的关系较少, 所以我很惊讶。

问题:你能否详细说明之前在电话会议上关于萨姆・阿尔特曼(Sam Altman)的评论?

辛顿:OpenAI 建立之初非常强调安全性,主要目标是开发通用人工智能并确保它是安全的,随着时间的推移,事实证明,阿尔特曼更关心利润,而不是安全,我认为这很不幸。

问题:你如何看待人工智能的不确定未来以及如何更好地了解其潜在机遇和风险?政府会考虑介入吗?为了更严格地监管人工智能,政府如何更好地支持人工智能研究?

辛顿:我认为政府可以鼓励大公司在安全研究上花费更多的资源,目前几乎所有的资源都用于使模型更好,并且正在进行一场激烈的竞争。一方面,模型变得越来越好,但我们需要在 AI 安全方面做出类似的努力,这部分努力需要超过 1%,可能需要三分之一。

问题:关于诺贝尔奖金有哪些计划?

辛顿:我没有具体计划,打算把它捐给慈善机构,我会捐一些给神经多样性年轻人(孤独症或阿斯伯格)提供工作,我会再捐给其他一些慈善机构。

问题:尽管很难预测会发生什么,但如果你必须在一些粗略的关注领域进行冒险,那会是什么?

辛顿:AI 有很多不同的风险 ,他们都有不同的解决方案,直接的风险是诸如虚假视频破坏选举之类的事情,我们已经看到了政客要么指责其他人使用虚假视频,要么自己使用虚假视频和虚假图像,这是一个迫在眉睫的危险;网络攻击等事件也会带来非常直接的危险,例如去年钓鱼攻击的数量增加了 1200%,因为大型语言模型使得钓鱼攻击变得非常容易,而且你无法再通过拼写错误和语法奇怪的事实来识别它们。

问题:人工智能领域令人兴奋的下一个前沿技术是什么?

辛顿:我已经 76 岁了,我不会做更多的前沿研究,我会花时间倡导人们从事安全工作。我认为机器人技术中有非常令人兴奋的前景, 让 AI 能够熟练地操纵事物,目前我们在这方面比计算机或人工神经网络好得多。我也认为大型语言模型在推理方面会变得更好, OpenAI 和谷歌的最新模型在推理方面变得更好。

问题:我们很好奇在今天的新闻发布会上,还有什么我们没有提到您想提及的问题?

辛顿:我们简单提到了一件事,那就是好奇心驱动的基础研究的作用,所以人工神经网络的基础工作都是由大学研究人员完成的, 研究人员只是追随他们的好奇心并资助这种研究非常重要,它不像其他类型的研究那么昂贵, 但是它为后来非常昂贵并且涉及大量 技术的事情奠定了基础。

04. 结语:机器学习、物理学研究相辅相成

尽管人工神经网络是以生物神经网络为模型的,但今年的两位诺贝尔物理学奖获得者的工作都借鉴了统计物理学,利用物理学训练人工神经网络,为当今强大的机器学习奠定了基础。

此次诺贝尔物理学奖的颁布表明物理学理念正在推动深度学习革命的兴起。如今,深度学习开始回报物理学,它能够准确、快速地模拟从分子和材料到整个地球气候的各种系统。通过将诺贝尔物理学奖授予霍普菲尔德和辛顿,也表明了诺贝尔奖委员会对人类利用这些进步来促进人类福祉和建立可持续发展的世界的期望。

与此同时,正如辛顿所言,此次获得诺贝尔物理学奖也在一定程度上,能使整个 AI 行业未来更重视他对 AI 风险的观点。

来源:纽约时报、诺贝尔奖委员会、多伦多大学

参考链接:

https://www.nobelprize.org/uploads/2024/09/advanced-physicsprize2024.pdf

https://www.nytimes.com/2024/10/08/technology/nobel-prize-geoffrey-hinton-ai.html

解密诺贝尔物理学奖为啥颁给 AI?Hinton 和 Ilya 12 年前对话,竟引发物理诺奖 AI 风暴!

新智元 2024 年 10 月 09 日 13:16 北京 标题已修改

新智元报道

编辑:编辑部 HYZ

**【新智元导读】**诺贝尔物理学奖公布第二天,争议依然未平息。诺奖官号都被愤怒的网友冲了:AI 不是物理学!Hopfield 网络和反向传播算法究竟与物理学有何关系?这要从 Hinton 和 Ilya 12 年前的那件事说起。

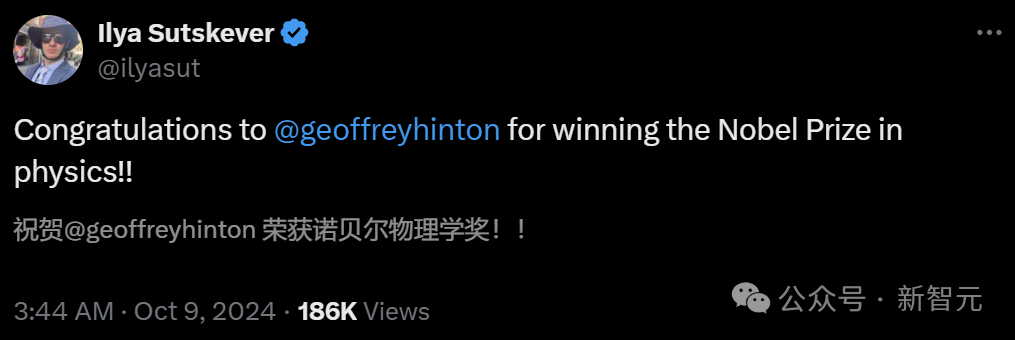

昨天的诺贝尔物理学奖一公布,瞬间炸翻了物理圈和 AI 圈。

Hinton 的第一反应更是有趣:这不会是个诈骗电话吧?

如此出乎意料的结果,让各路针对诺奖物理学奖的严肃预测,都仿佛成了笑话。

而诺贝尔奖的官方账号,也被网友们给冲爆了。

他们纷纷高呼:这不是物理学!

「数据科学或神经网络是『用于』物理学,但绝对不『是』物理学。」

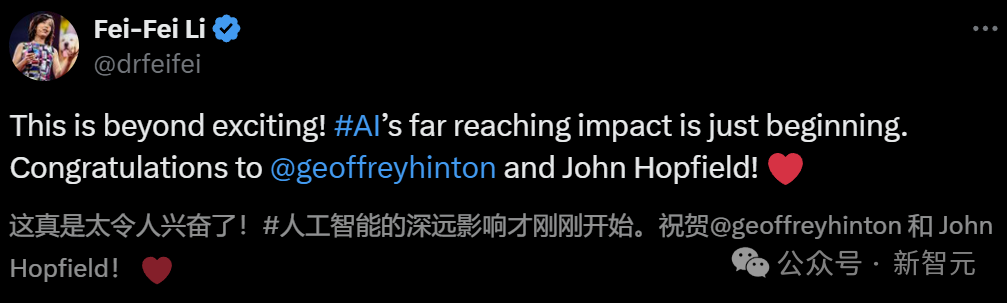

相比之下,AI 圈则是一片其乐融融的景象。大佬们都开心地给 Hinton 送去了祝福。

AI 教母李飞飞:AI 的深远影响,如今才刚刚开始

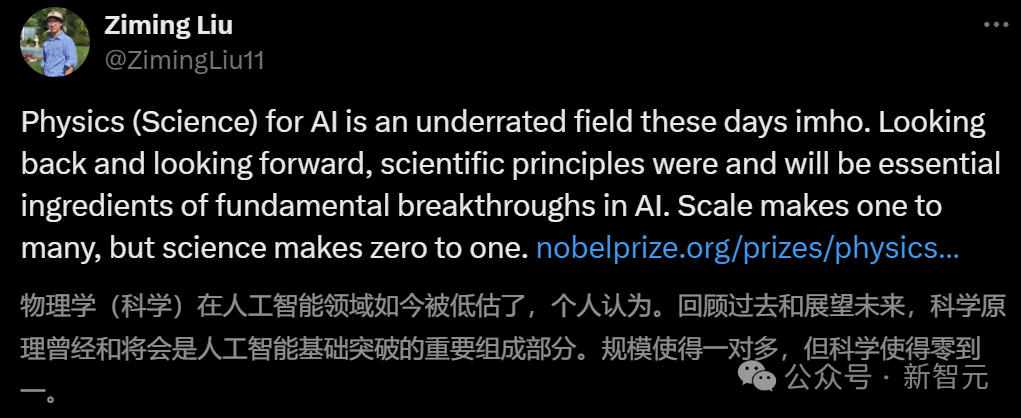

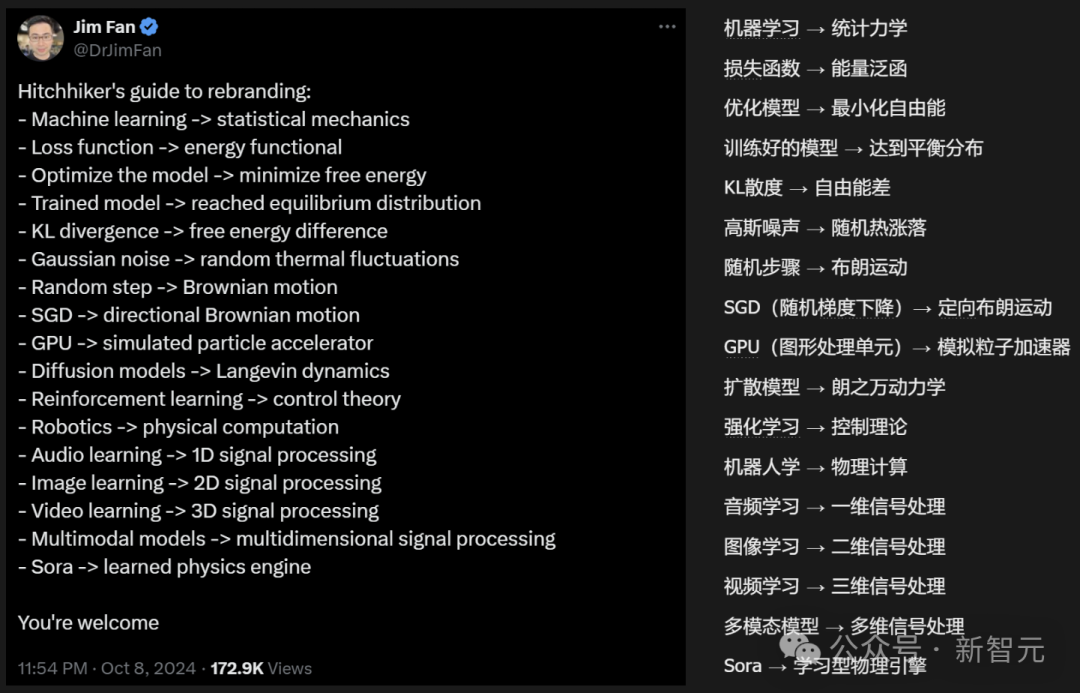

MIT 博士生 Ziming Liu 直言:「Physics (Science) for AI」是一个被严重低估的领域。规模化可以实现一对多的效果,但唯有科学才能带来从无到有的突破。

Jim Fan 则做了一个非常有趣的「AI - 物理学对照表」:

言归正传,诺贝尔物理学奖,为何要颁给 AI 学者?

这就要从深度学习爆发的那一年讲起。

Geoffrey Hinton:2012 年,深度学习的惊人革命

早在 1986 年,Geoffrey Hinton 等人在 Nature 上发表的论文,就让训练多层神经网络的「反向传播算法」广为人知。

当时我们很多人都相信这一定是人工智能的未来。我们成功地证明了我们一直相信的东西是正确的。

可以说,神经网络在经历第一波寒冬之后,自此开始重新走向 AI 舞台。

1989 年,LeCun 率先使用了反向传播和卷积神经网络。他也同意 Hinton 的看法。

我毫不怀疑,最终我们在上世纪 80-90 年代开发的技术将被采用。

早期的图灵三巨头

不过,反向传播算法引发的热潮,随后又在 1995 年被统计机器学习盖过去了。

统计机器学习的风头兴盛了很多年,即使 2006 年 Hinton 在 Science 上首次提出「深度学习」,业内也响应寥寥。

直到 2012 年 9 月,一篇题为「用深度卷积神经网络进行 ImageNet 图像分类」的论文,让此前沉寂多年的 AI 领域热度骤起。

文中提出的 AlexNet 深度卷积神经网络,在当年的 ImageNet 比赛上以碾压之势夺冠,一举将 top-5 错误率降低到了 15.3%,比身后的第二名(26.2%)足足高出 10 多个百分点。

ImageNet 数据集,正是由斯坦福李飞飞团队在 2007 年创建。

AlexNet 摧枯拉朽般的大胜,让研究人员惊叹于大型卷积深度神经网络架构的神奇威力,这篇论文也成为深度学习和人工智能自「AI 寒冬」后重新成为热门领域的重要里程碑。

后来人们所讲的「深度学习革命」,也借此文以发端,直到十二年后的今天。

事后李飞飞这样回顾:自 2012 年以来,深度学习的发展堪称「一场惊人的革命,令人做梦都没想到」。

自此,人们开始相信:大数据、算力、深度模型,是走向通用人工智能的关键三要素。

而深度模型也从最早的卷积神经网络,迭代为递归神经网络、Transformer、扩散模型,直至今天的 GPT。

从生理学、哲学到 AI:大脑究竟如何思考

在年轻时,为了弄清楚人类的大脑如何工作,Hinton 首先来到剑桥学习生理学,而后又转向哲学,但最终也没有得到想要的答案。

于是,Hinton 去了爱丁堡,开始研究 AI,通过模拟事物的运行,来测试理论。

「在我看来,必须有一种大脑学习的方式,显然不是通过将各种事物编程到大脑中,然后使用逻辑推理。我们必须弄清楚大脑如何学会修改神经网络中的连接,以便它可以做复杂的事情。」

「我总是受到关于大脑工作原理的启发:有一堆神经元,它们执行相对简单的操作,它们是非线性的,它们收集输入,进行加权,然后根据加权输入给出输出。问题是,如何改变这些权重以使整个事情做得很好?」

某个周日,Hinton 坐在办公室,突然有人敲门。AI 命运的齿轮从此转动。

敲门的正是 Ilya。

当年青涩的 Ilya

Hinton 给了 Ilya 一篇关于反向传播的论文,约定两人一周后讨论。

Ilya:I didn’t understand it.

Hinton:这不就是链式法则吗?

Ilya:不是,我不明白你为啥不用个更好的优化器来处理梯度?

——Hinton 的眼睛亮了一下,这是他们花了好几年时间在思考的问题。

Ilya 很早就有一种直觉:只要把神经网络模型做大一点,就会得到更好的效果。Hinton 认为这是一种逃避,必须有新的想法或者算法才行。

但事实证明,Ilya 是对的。

新的想法确实重要,比如像 Transformer 这样的新架构。但实际上,当今 AI 的发展主要源于数据的规模和计算的规模。

2011 年,Hinton 带领 Ilya 和另一名研究生 James Martins,发表了一篇字符级预测的论文。他们使用维基百科训练模型,尝试预测下一个 HTML 字符。

模型首次采用了嵌入(embedding)和反向传播,将每个符号转换为嵌入,然后让嵌入相互作用以预测下一个符号的嵌入,并通过反向传播来学习数据的三元组。

当时的人们不相信模型能够理解任何东西,但实验结果令人震惊,模型仿佛已经学会了思考 —— 所有信息都被压缩到了模型权重中。

AI 如何「蹭」上物理学

讲到这里,你可能有一个疑问:这些跟物理学有什么关系呢?

诺奖委员会的解释是,人工神经网络是用物理学工具训练的。

Geoffrey Hinton 曾以 Hopfield 网络为基础,创建了一个使用不同方法的新网络:玻尔兹曼机。在这个过程中,Hinton 使用的是统计物理学的工具,来学习和识别数据中的模式。

就这样,AI 跟物理学联系上了。

如果讲到此次另一位获奖者 John Hopfield,倒是和物理学的关系更紧密一些。

一言以蔽之,Hopfield 网络是按物理学上能量函数最小化来构建的,可以看作是物理学中「自旋玻璃模型」的扩展。

Hopfield 网络利用了材料由于其原子自旋而具有特性的物理学 —— 这种特性使每个原子成为一个微小的磁铁。整个网络的描述方式等同于物理学中发现的自旋系统中的能量,并通过找到节点之间连接的值来训练,使保存的图像具有低能量。

另外,Hopfield Network 和玻尔兹曼机都是基于能量的模型。

统计力学原理,便是这两者的核心。它们都使用来自统计力学的能量函数,来建模和解决与模式识别和数据分类相关的问题。

在前者当中,能量函数被用来寻找与所存储的模式相对应的最稳定状态。后者中,能量函数通过调整节点之间连接的权重来帮助学习数据的分布。

至此,诺奖委员会就自圆其说了。

John Hopfield:一个想法,波及三大学科

20 世纪 80 年代初,John Hopfield 在加州理工学院创建了一个简单的计算机模型 ——Hopfield Network。

其行为方式不太像当时的计算机,而更像人脑。

这是因为,Hopfield Network 模仿了人脑储存信息的结构。它由相互连接的节点组成,正如人脑中的神经元一样。

节点中的连接强度具有可塑性,可强可弱,而强连接进而形成了我们所说的「记忆」。

Hopfield 学生,现 Caltech 计算机科学、计算与神经系统以及生物工程教授 Erik Winfree 解释道:

Hopfield Network 是物理学中「自旋玻璃模型」(the spin glass model)的扩展。自旋玻璃有两种磁化状态,可以称之为它的「记忆」。

Hopfield 扩展了这一模型,让其有了更复杂的连接模式。

简言之,他使用一个简单的规则,让每对单元(每个节点)之间有不同的连接强度,而不再局限于两种状态。

他的工作证明了,这种网络可以储存多种复杂的模式(记忆),而且比之前的方法更接近大脑运作方式。

Hopfield 以一种跨学科的视角阐述这个模型,解释了人工神经网络与物理学之间的联系。

复旦大学计算机科学教授张军平认为,Hopfield Network 与物理学领域的关联是,它的设计思路模拟了电路结构。

「假设网络每个单元均由运算放大器和电容电阻组成,而每个单元就代表着一个神经元」。

在普林斯顿大学新闻发布会上,Hopfield 表达了同样的观点。他认为,长远来看,新科学领域通常产生于,大量科学知识的交叉点上。

你必须愿意在这些「缝隙」中工作,找出你的知识局限性,以及让这些学科更丰富、更深入、更好被理解而采取的行动。

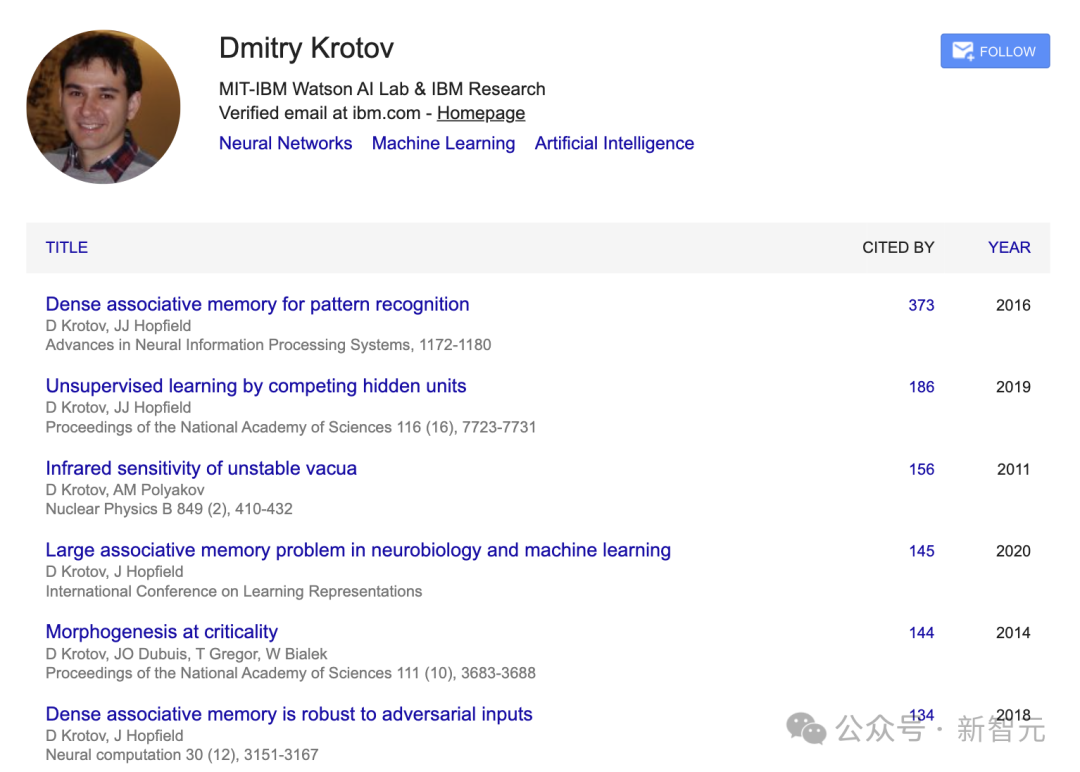

来自 MIT-IBM 实验室物理学家 Dmitry Krotov 分享了,Hopfield Network 一个想法至少对三大学科产生了巨大的影响。

它们分别是,统计物理学、计算机科学和人工智能、神经科学。

2023 年,他曾发表了一篇 Nature 论文,对 Hopfield Network 在统计物理、神经科学和机器学习等多个学科中,进行了分析。

论文地址:https://www.nature.com/articles/s42254-023-00595-y

Krotov 本人也与 Hopfield 合作过多篇研究,因此他对 Hopfield Network 工作的了解再熟悉不过了。

###统计物理学

在统计物理学中,Hopfield Model 成为最常被研究的哈密顿量(Hamiltonian)之一。哈密顿量在物理学中,描述了系统的总能量,是理解系统行为的关键。

这一模型已经催生了数以万计的论文、几本书籍。它为数百名物理学家进入神经科学和人工智能,提供了切入点。

就连诺贝尔奖官方给出了解释,机器学习模型,是基于物理方程式。

###计算机科学和 AI

在计算机科学中,Hopfield Network 终结了 AI 寒冬(1974-1981),并开启了人工神经网络的复兴。

Hopfield 在 1982 年发表的论文,标志着现代神经网络的开始。

论文地址:https://www.pnas.org/doi/10.1073/pnas.79.8.2554

就连如今的顶会 NeurIPS,起源可以追溯到 1984-1986 年在加州理工学院举行的被称为「Hopfests」的会议。

这个名字直接致敬了 Hopfield,彰显了他的早期工作在神经网络研究中的核心地位。

John Moody 在 1991 年的 NeurIPS 论文集中记录了这段历史。

另外,Hopfield Network 成为限制玻尔兹曼机(Restricted Boltzmann Machine)发展的主要灵感来源。RBM 在早期深度学习中,发挥着重要的作用。

还有基于能量的模型(Energy Based Model),代表着人工智能领域中一个重要的范式。

它也是从 Hopfield 基于能量和记忆的模型发展而来。

###神经科学

在神经科学领域,Hopfield Network 成为后来许多计算记忆模型的基础。

它将记忆回忆概念化,即能量景观中滚下山坡的想法,已成为神经科学中的经典隐喻。

这次「诺奖风波」后,许多人也对如今的学科分类有了全新的思考。

不可否认的是,AI 已经融入了全学科、全领域。

而这次诺贝尔物理学奖颁给 AI,也是 AI 大爆发对于人类社会颠覆影响的一个真实写照。

参考资料:

https://x.com/Caltech/status/1843764971022495942

https://x.com/DimaKrotov/status/1843682498825564463

https://cacm.acm.org/opinion/between-the-booms-ai-in-winter/

https://x.com/DrJimFan/status/1843681423443800315

2024 诺贝尔物理奖给了 AI 教父辛顿,本人回应 “没有想到”

原创 知识分子 The Intellectual 2024 年 10 月 08 日 18:15 江苏

导 读

2024 年诺贝尔物理学奖授予了约翰 - 霍普菲尔德(John J. Hopfield)和图灵奖得主、AI 教父杰弗里 - 辛顿(Geoffrey E. Hinton),“以表彰他们利用人工神经网络进行机器学习的奠基性发现和发明”。 辛顿在接受电话采访时表示,我没有想到(I have no idea that will happen)。

撰文|张天蓉 .

● ● ●

约翰・J・霍普菲尔德 (John J. Hopfield )

约翰・J・霍普菲尔德 (John J. Hopfield ) 1933 年出生于美国伊利诺伊州芝加哥。他于 1954 年获得斯沃斯莫尔学院学士学位,1958 年获得康奈尔大学物理学博士学位(导师为 Albert Overhauser)。他在贝尔实验室理论组工作了两年,随后在加利福尼亚大学伯克利分校(物理学)、普林斯顿大学(物理学)、加州理工学院(化学和生物学)和普林斯顿大学任教,现在是霍华德 - 普莱尔分子生物学名誉教授。35 年来,他一直与贝尔实验室保持着密切联系。

1986 年,他成为加州理工学院计算与神经系统博士项目的创始人之一。他获得了 2024 年诺贝尔物理学奖。

他最有影响力的论文包括:描述极化子的 “The Contribution of Excitons to the Complex Dielectric Constant of Crystals”(1958 年);描述长程电子转移量子力学的 “Electron transfer between biological molecules by thermally activated tunneling”(1974 年);"Kinetic Proofreading:1974 年);“神经网络和具有突发性集体计算能力的物理系统”(1982 年)(被称为 Hopfield 网络),以及与 D. W. Tank 合著的 “优化问题中决策的神经计算”(1985 年)。他目前的研究和近期发表的论文主要集中在如何将动作电位定时和同步用于神经生物学计算。

杰弗里・辛顿(Geoffrey E. Hinton)

杰弗里・埃弗里斯特・辛顿,英国出生的加拿大计算机学家和心理学家,多伦多大学教授。以其在类神经网络方面的贡献闻名。辛顿是反向传播算法和对比散度算法 (Contrastive Divergence) 的发明人之一,也是深度学习的积极推动者,被誉为 “深度学习教父”。辛顿因在深度学习方面的贡献与约书亚・本希奥和杨立昆一同被授予了 2018 年的图灵奖。

1985 年,在奥地利阿尔卑斯山奥伯莱赫(Oberlech)的一个研讨会

他曾花了小半个世纪的时间开发神经网络,让机器拥有了深度学习的能力,如今,他的愿望实现了:人工智能之浪潮汹涌澎湃滚滚而来。然而,这位 AI 大神却退缩了,他对他教会它学习的机器产生了怀疑,甚至愤怒。他担心他毕生的工作可能导致人类的终结,他认为他的最终使命是警告世界!

他,就是如今被誉为 “AI 教父” 的杰佛里・埃佛勒斯・辛顿(Geoffrey Everest Hinton,1947-)[1]。

家族传奇

辛顿可以算是学界少有的传奇人物,其传奇之一,是他显赫的家庭背景。我们从他的一位 “玄祖父” 布尔说起……

英国数学家乔治・布尔(George Boole,1815 年 —1864),无疑是计算机科学的前辈之一,一位大师级人物。大家都知道的布尔代数、布尔逻辑,便是以他命名的。布尔出生贫困,但他的整个后代,以及连带的 3 个家族可了不得,每一个都值得惊叹一声:好一个 “科学世家”!

布尔的夫人玛丽是一位女权主义哲学家,也是自学成才的数学爱好者,特别喜欢代数。玛丽夫人的娘家姓氏(Everest)中,也出了好几位科学名人,实际上,Everest 是西方对珠穆朗玛峰的称呼,这来源于玛丽的叔叔乔治・埃佛勒斯(George Everest),他勘察印度时发现了这座山,珠穆朗玛峰便以他的名字命名。而且,杰佛里・辛顿的中间名便取为 Everest,即珠穆朗玛峰的英文名。

布尔和玛丽,这对珠联璧合的伉俪育有五个女儿,她们本人、配偶及后代,都有不凡的成就。非常有趣的是,布尔女儿中的老大和老小,都与中国有渊源。所以,首先简要介绍中间 3 个女儿:老二嫁给了艺术家爱德华・泰勒,他们的儿子杰弗里・泰勒,是著名物理学家和数学家,二战时曼哈顿计划的核心成员之一;三女儿继承了父亲的数学天赋,对四维几何深感兴趣独立钻研,颇有成果;四女儿是英国史上第一位研究药学的女性和女化学教授。

布尔第五个女儿,艾捷尔・丽莲・伏尼契,为中国人所熟悉是因为她是《牛虻》一书的作者。

布尔的大女儿玛丽,嫁给了数学家和作家查理斯・辛顿,生了四个儿子。其中小儿子的孙辈中,韩丁是 “中国人民的好朋友”,写了一本有关中国土地改革的长篇作品《翻身》。韩丁的妹妹寒春,是参与了曼哈顿计划的女核物理学家,她的丈夫阳早,是美国养牛专家,夫妻俩长年定居中国。

图 1:杰弗里・辛顿(8 岁时抱着动物园的蟒蛇、中学、近年)

就是布尔的这位大女儿,联姻了 “辛顿” 的家族,这个辛顿家族中科学界名人和教授也是难以数清,我们就不一一列举了。总之,这对 “布尔 + 辛顿” 生下了一个曾孙,便正是我们本文的主角:杰弗里・辛顿。

所以,辛顿是逻辑大师布尔的玄孙,短短的计算科学史中,玄祖玄孙皆大师,不是传奇是什么?

辛顿出生于英国,父亲是剑桥大学教授,是著名的昆虫学家,研究甲虫的权威。辛顿和他的三个兄弟姐妹在一所充满动物的大房子里长大,父亲还曾经将毒蛇关在车库的坑里。

严厉的父亲自视甚高,似乎认为儿子永远无法攀登自己的顶峰。但父亲早已于 70 年代过世,没有来得及看到儿子的学术引用已经远远超过了他。

求学传奇

尽管杰弗里・辛顿的周围环境中,不乏杰出的科学家、学者和教授,但与大多数成功人士一样,他的求学生涯却并不总是那么顺利。也许是因为这类年轻人心里有太多自己的想法和主张的缘故。

辛顿高中时,进入了他口中的 “二流公立学校”,克里夫顿学院,不过,辛顿在那儿碰到一位十分聪明的同学,这位朋友对他说:“你知道吗?大脑的记忆并不是储存在某个特定的地方,而是分布在整个大脑,在整个神经网络里传播。“,朋友又解释道:” 大脑使用全息图,在全息图中,你可以砍掉一半,但你仍然可以获得整个图片,所以……”

朋友的话使辛顿兴奋,也正是从这个时候起,辛顿开始对大脑的运作深深着迷,这是他人生的关键起点。从此后,辛顿将一个目标放在了他的潜意识里:想了解大脑是如何工作的?

一开始,18 岁的辛顿进入剑桥大学国王学院学习物理、化学和数学,但于一个月后就退学了。辛顿去伦敦工作了一年,做了各种各样的事情。第二年,他改修建筑学,但这次坚持的时间更短:一天!后来,辛顿也尝试过转向哲学,不过也是半途而终。

再后来,辛顿转而研究物理和生理学,成为当年剑桥大学唯一一个同时学习物理和生理学的学生。然而,因为他没有任何生物学背景,所以学习生理学非常困难。但辛顿有所期待,因为据说在第三学期,生理学教授将告诉学生大脑是如何工作的,这正是辛顿学习生理学的原因。终于到了第三学期,由像赫胥黎这样非常杰出的学者教授这门课。不过,结果并不是辛顿所期待的。生理学教授认为大脑是如何工作的呢?他们的想法是,有神经元,有沿着轴突和神经元传播的动作电位。但仅此而已,他们实际上并没有说出大脑是如何运作的,因为他们并不知道啊。并且,辛顿觉得心理学理论似乎太简单了,不可能用以解释大脑。

1970 年获得实验心理学学士学位后,对大学本科学习颇感失望的辛顿放弃了剑桥大学,成了一名木匠。他一边做书架、木门,一边思考人类大脑的运作原理,自认为这是他喜欢的生活方式。作了一年多之后又有新想法了,因为靠木匠谋生并不是件容易的事情,对了解大脑也无帮助,所以,辛顿又考虑回归学术界,并决定尝试一个新方向:人工智能。

对如此奇特多变的求学经历,辛顿谑称自己患上了 “学习上的过动症”,在一个专业上无法稳定下来。但其实不然,辛顿始终都在寻求自己的方向。前一段,是多次缀学的 “传奇”,后面的经历,便说明了辛顿认定方向后坚持不懈的 “传奇” 精神。

他 1972 年去了爱丁堡,进入苏格兰爱丁堡大学攻读博士,这次可能算是走对路了,因为那儿有一位非常聪明的叫希金斯(Christopher Higgins,1923 – 2004)的教授,正在研究神经网络,这是辛顿长年累月思考认为可以用机器实现大脑功能的方向。

但是,辛顿好像总是运气不佳,就在他开始追求这个目标时,希金斯教授改变了他的学术初衷,“叛变” 到了 AI 的符号主义一边,认为联结主义的神经网络是无稽之谈。这显然是受了 MIT 的 AI 大佬闵斯基的影响。闵斯基的《Perceptron》一书于 69 年出版,几乎摧毁了神经网络领域,使得 1972 年成为神经网络有史以来最低潮的时期。

因此,希金斯试图说服辛顿停止做神经网络,转做符号人工智能。于是辛顿说,再给我六个月,我会证明这是有效的;然后每六个月之后,辛顿再跟希金斯说与上次一模一样的话。两人磨磨唧唧地争论了五年,辛顿终于坚持研究备受冷落的神经网络并熬到了博士毕业。

职场传奇

辛顿的观点总是与众不同别出一格,闵斯基在《感知器》中,详尽说明了单层神经网络的限制以及功能不足之处,使得几乎所有的学者都相信这是个没有未来、注定失败的一条路,但辛顿却始终坚持神经网络研究,认为闵斯基提出感知机的缺点是件大好事,发现神经网络的问题,是解决其问题的开始,并不一定要放弃。

辛顿坚信大脑绝对不是通过人类编写的 “智能程序” 来工作的。例如,你可以尝试给小孩子编个程序,让他照此步骤一步一步地从语法开始学习语言,但这并不会真正起作用,孩子们会从经验中学习而不会按照你给他编的程序来做。

作为一名年轻的研究生,辛顿对自己认定的目标如此自信,令人刮目相看。辛顿将此归结为少年时经历的环境所致。他的父母是无神论者,却将儿子送去了一所宗教学校。在那儿,辛顿周围的每个人都相信上帝,除了他之外。因此,他已经习以为常总是与别人的不一样。辛顿在一次访谈中表示,这对科学家是非常好的训练,让你对自己的观点充满信心,至少给你一个合理的理论,即每个人都可能是错的,你需要坚持自己的主张,直到实现它或者否定它,做科学就需要这样的精神。

博士毕业几年之后,辛顿去了美国作博士后。他高兴地在加利福尼亚找到了几个神经网络的支持者。20 世纪 70 年代末,在加利福尼亚州,圣地亚哥有一个团体,特别是 David Rumelhart 等,他们认为神经网络非常有趣。

图 2:辛顿 1986 年有关 “反向传播” 的论文

1986 年,辛顿与 David Rumelhart 和 Ronald Williams 共同发表了一篇题为 “通过反向传播误差来学习”(Learning representations by back-propagating errors)的论文 [2]。

三位科学家并不是第一个提出这种 “反向传播” 方法的人。但他们将反向传播算法应用于多层神经网络并且证明了这种方法对机器学习行之有效。他们的论文也证明了,神经网络中的多个隐藏层可以学习任何函数,从而解决了闵斯基等书中提出的单层感知机存在的问题。

同一时期,辛顿与 David Ackley 和 Terry Sejnowski 共同发明了玻尔兹曼机。

之后,辛顿在匹兹堡的卡内基梅隆大学找到了一份工作,但他对里根领导下的美国外交政策,特别是对中美洲的干涉越来越感到不安。他和他的妻子罗斯收养了来自南美的一男一女,却不太喜欢在美国抚养他们。另外,美国的大多数人工智能研究都是由国防部资助的,这也让辛顿不满意,因此他接受了加拿大高级研究所的邀请,以及多伦多大学计算机科学领域的职位,并在加拿大启动了 “机器和大脑学习” 项目。

图 3:辛顿著名的 “徒子徒孙” 们

辛顿 1986 年有关反向传播算法和波尔兹曼机的两篇重要文章,抵不过当年 “人工智能的寒冬”,似乎反响不大,但辛顿在加拿大多伦多大学,毕竟有了稳定的位置以及还算充裕的支持神经网络的研究经费,使他能在这个冷门领域里坚持耕耘三十余年无怨无悔。更为重要的是,随着时间的推移,一些深度学习的信徒们被辛顿所吸引。他培养了不少学生,学生又有学生,加上博士后及合作者,研究神经网络深度学习的人才济济群星闪烁,尽管寒冬期间工作机会少,资金仍然稀缺,但研究者们兴趣盎然,他们凭借自身的信念,排除嘈杂的干扰而自得其乐,江湖貌似平静但暗流涌动,为人工智能春天之到来做好了准备。正是应了一句名言:“大隐隐于市”。

他长久的在这个冷门的领域耕耘,让他最终迎来了春天,不但为他赢得了 2018 年的图灵奖,也为人工智能领域带来了革命性的突破。

参考资料:

[1] Home Page of Geoffrey Hinton,https://www.cs.toronto.edu/~hinton/

[2] David E. Rumelhart, Geoffrey E. Hinton und Ronald J. Williams. Learning representations by back-propagating errors., Nature (London) 323, S. 533-536,http://www.cs.utoronto.ca/~hinton/absps/naturebp.pdf

诺贝尔物理学奖得主辛顿:旧的想法也是新的

赛先生 2024 年 10 月 08 日 20:11 河北

2024 年诺贝尔物理学奖授予了约翰 - 霍普菲尔德(John J. Hopfield)和图灵奖得主、AI 教父杰弗里 - 辛顿(Geoffrey E. Hinton),“以表彰他们利用人工神经网络进行机器学习的奠基性发现和发明”。

导读:

2024 年诺贝尔物理学奖得主杰弗里・辛顿是神经网络研究的先锋。20 世纪 80 年代,辛顿在麻省理工学院展示了一种新的神经网络模型 “玻尔兹曼机”,试图解决感知机的缺陷。

“旧的想法也是新的”,这是辛顿常常说的一句话。他认为科学家永远不应该放弃一个想法,除非有人证明了它行不通。尽管外界对他的想法反应冷淡,辛顿坚持自己的研究方向,并将反向传播算法引入多层神经网络训练,最终开启了机器学习的爆炸式发展。

[美] 凯德・梅茨 | 撰文

- 旧的想法也是新的。*

20 世纪 80 年代中期的一个下午,大约 20 名学者聚集在波士顿郊外的一个古老的法国庄园式建筑里,这里是麻省理工学院教授和学生的静修所,马文・明斯基在这所大学仍然统治着国际人工智能研究员群体。这些学者坐在房间中央的一张大木桌旁,杰夫・辛顿绕着桌子踱步,递给现场每个人一份长长的、夸张的、满是数学公式的学术论文,其中描述了一个他称之为 “玻尔兹曼机” 的东西。这个以奥地利著名物理学家和哲学家名字命名的东西是一种新的神经网络,它克服了明斯基 15 年前指出的感知机的缺陷。明斯基取掉订书钉,在面前的桌子上把论文打印件一页一页依次展开,低头看着这一长串的论文页。辛顿走到房间的前面,发表了一场简短的演讲,解释他最新的数学创造。明斯基没有说话,只是看了看。然后,当演讲结束时,他站起身来走出房间,留下那些论文页整齐地排列在桌子上。

对辛顿来说,明斯基的反应是他的典型风格。辛顿第一次见到这位麻省理工学院的教授是在 5 年前,在他看来,这位教授非常好奇且富有创造力,但同时也有着奇怪的童真,而且有点儿不负责任。辛顿经常讲述明斯基教他如何制作 “完美的黑色”—— 一种完全没有颜色的颜色。明斯基解释说,用颜料不可能做出完美的黑色,因为颜料总是会反射光线。但是,你可以用排列成 V 形的几层剃须刀片来实现,这样光线就会进入 V 形结构,在刀片之间无休止地反射,永远不会逃脱出来。明斯基实际上并没有演示过这个技巧,辛顿也从未尝试过。这就是经典的明斯基的风格 —— 引人入胜,发人深省,但看似随意,且未经验证。这表明,他并非一直说那些自己相信的事情。当然,当谈到神经网络时,明斯基可能会抨击其严重不足之处,并且写了一本书,很多人认为这本书证明了神经网络是一条死胡同,但他的真实立场不一定如此明确。辛顿认为,明斯基是一名 “失落的神经网络追随者”,这种人曾经认同机器的行为像大脑中的神经元网络,但当这个想法没有达到他的期望时,他的幻想破灭了,但他仍然至少会对它实现预期抱有一些希望。在明斯基离开波士顿的那场演讲后,辛顿将他放置在桌子上的论文页收了起来,并把它们邮寄到明斯基的办公室,辛顿还留下了一个简短的便条,上面写着:“你可能是不小心把这些东西落下的。”

杰夫・辛顿出生于第二次世界大战刚结束时的英国温布尔登。他是 19 世纪英国数学家和哲学家乔治・布尔 (George Boole) 和 19 世纪书写美国历史的外科医生詹姆斯・辛顿 (James Hinton) 的玄孙,前者提出的 “布尔逻辑” 为每一台现代计算机提供了数学基础。他的曾祖父是数学家兼奇幻作家查尔斯・霍华德・辛顿 (Charles Howard Hinton),他提出的 “第四维度” 的概念,包括他所谓的 “宇宙魔方”,贯穿了随后 130 年的流行科幻小说,并在 21 世纪的第一个十年的漫威超级英雄电影中达到了流行文化的顶峰。他的叔祖父塞巴斯蒂安・辛顿 (Sebastian Hinton) 发明了攀爬架。他的堂姐、核物理学家琼安・辛顿 (Joan Hinton) 是曼哈顿计划中为数不多的女性成员之一。在伦敦和后来的布里斯托,伴随他一起长大的是三个兄弟姐妹、一只猫鼬、十几只中国龟,还有生活在车库后面土坑里的两条毒蛇。他的父亲是英国皇家学会会员、昆虫学家霍华德・埃佛勒斯・辛顿 (Howard Everest Hinton),他对野生动物的兴趣超越了昆虫的范畴。和他的父亲一样,他的中间名也源于另一位亲戚乔治・埃佛勒斯爵士 (Sir George Everest),一位印度的测绘总长,其名字取自世界最高的山峰。大家都期望有一天,杰夫・辛顿会跟随父亲的脚步进入学术界,尽管不太清楚他将来会研究什么。

他想研究大脑。他经常说,他的兴趣是在十几岁的时候被激发出来的,当时一位朋友告诉他,大脑像全息图一样工作,通过神经元网络存储记忆的片段,就像全息图在一段胶片上存储三维图像的片段一样。这是一个简单的类比,但这个想法吸引了他。作为剑桥大学国王学院的本科生,他想要更好地了解大脑。他很快就意识到,问题在于没有人对大脑的了解比他多多少。科学家了解大脑的某些部分,但他们对所有这些部分如何结合在一起,并最终提供视觉、听觉、记忆、学习和思考的能力知之甚少。辛顿尝试去研究生理学和化学、物理学和心理学,但没有人能提供他想要的答案。他攻读了物理学学位,但辍学了,因为他认为自己的数学能力不够强,于是他转而去攻读哲学。之后他放弃了哲学,选择了实验心理学。最终,尽管承担着继续学业的压力,或者可能是来自父亲的压力,但辛顿完全离开了学术界。当他还是个孩子的时候,他就认为自己的父亲是一位不妥协的知识分子,也是一个力量巨大的人 —— 一位英国皇家学会的会员,能用一只胳膊做引体向上。“只要工作得足够努力,也许当你的年纪是我现在年龄的两倍时,你就能实现我一半的成就了。” 他的父亲经常对他这么说,但没有讽刺的意味。从剑桥大学毕业后,辛顿心中总是萦绕着父亲的看法,于是他搬到了伦敦,成了一名木匠。他说:“我不是做一些花哨的木工活儿,而是以木工为生。”

那一年,他读了加拿大心理学家唐纳德・赫布 (Donald Hebb) 的《行为组织》(The Organization of Behavior) 一书,这本书解释了让大脑进行学习的基本生物过程。赫布认为,学习是沿着一系列神经元发射微小电信号的结果,这些电信号引起了物理变化,以一种新的方式将这些神经元连接在一起。正如他的追随者所说的那样:“神经元一起发射,并连接在一起。” 这一理论被称为 “赫布定律”,它激发了弗兰克・罗森布拉特等科学家在 20 世纪 50 年代开发出了人工神经网络,也激发了杰夫・辛顿。每周六,辛顿都会带着一个笔记本去伦敦北部伊斯灵顿的公共图书馆,用一上午的时间在赫布提出的想法的基础上,将自己关于大脑应该如何工作的想法写在笔记本上。他在周六上午记录下来的这些潦草的内容,除了对他自己有意义之外,对谁都没有意义,但它们最终将他带回了学术界。这些内容恰好与英国政府对人工智能的第一波大投资和爱丁堡大学研究生项目的兴起相吻合。

在这些年里,一个冰冷的现实是,神经科学家和心理学家对大脑的工作原理知之甚少,而计算机科学家根本无法模仿大脑的行为。但就像辛顿之前的弗兰克・罗森布拉特一样,辛顿开始相信,生物和人工双方都可以帮助对方前进。他将人工智能视为测试他所提出的关于大脑如何工作的理论的一种方式,并希望最终理解其奥秘。他如果能理解这些奥秘,就能反过来打造更为强大的人工智能。在伦敦做了一年木匠之后,他在父亲任教的布里斯托大学接受了一份心理学方面的短期工作,并以此为跳板进入爱丁堡大学的人工智能项目。几年后,一位同事在一次学术会议上介绍他时,说他物理不及格,还从心理学专业退学,然后进入了一个完全没有标准的领域:人工智能。这是辛顿常常重复讲述的一个故事,但有一个附加说明。他会说:“我并非物理不及格,也不是从心理学专业退学。我是心理学不及格,从物理专业退学 —— 这样讲更有利于维护声誉。”

在爱丁堡大学,他在一间实验室里赢得了一个学习机会,这间实验室由研究员克里斯托弗・朗吉特 —— 希金斯 (Christopher Longuet-Higgins) 负责。朗吉特 —— 希金斯曾是剑桥大学的理论化学家,也是该领域的后起之秀,但在 20 世纪 60 年代末,他被人工智能的理念吸引了。因此,他离开剑桥前往爱丁堡,并接受了一种与支撑感知机的方法相同的人工智能。他提出的连接主义方法与辛顿在伊斯灵顿图书馆记录在笔记本中的理论相吻合。但这种智识上的和谐转瞬即逝,在辛顿接受实验室的职位但还未到岗时,朗吉特 —— 希金斯又改变了主意。在阅读了明斯基和佩珀特关于感知机的书,以及明斯基在麻省理工学院的一名学生关于自然语言系统的一篇论文之后,他放弃了类似大脑的架构,并转向了符号人工智能 —— 这也是整个领域发生转变的体现。这意味着,辛顿在研究生期间的研究领域不仅被他的同事忽视,也被他自己的导师忽视。辛顿说:“我们每周见一次面,有时会以一场大喊大叫的争论结束。”

辛顿在计算机科学方面几乎没有经验,他对数学也不感兴趣,包括驱动神经网络的线性代数。他有时会实践自己所谓的 “基于信仰的差异化”。他会想出一个创意,包括支撑的微分方程,并直接假设数学相关的部分是正确的,而让其他人去辛苦完成所需的计算,以确保它确实是正确的,或者在绝对必要的时候自己来求解方程。但是,对于大脑如何工作以及机器如何模仿大脑,他有着明确的信念。当他告诉这个领域的任何人他正在研究神经网络时,他们不可避免地会提到明斯基和佩珀特。“神经网络已经被证明是错误的,” 他们会说,“你应该做点儿别的研究。” 但是,尽管明斯基和佩珀特的书将大多数研究人员推离了连接主义,但它拉近了连接主义与辛顿的距离。他在爱丁堡大学的第一年就读了那本书。他觉得明斯基和佩珀特描述的感知机几乎是对罗森布拉特工作的讽刺漫画。他们从未完全认识到,罗森布拉特在技术中也看到了他们所看到的缺陷,而他们描述这些不足的诀窍,是罗森布拉特所缺少的,也许正因为如此,他才不知道如何解决这些问题。他不会因为无法证明自己的理论而放慢脚步。辛顿认为,对于具有超越罗森布拉特的复杂性的神经网络,通过精确定位其局限性,明斯基和佩珀特最终使解决这些问题变得更加容易。但这还需要 10 年的时间。

辛顿进入爱丁堡大学的那一年,即 1971 年,英国政府进行了一项关于人工智能进展的研究。事实证明,这非常糟糕。“大多数人工智能研究和相关领域的工作人员承认,他们对过去 25 年取得的成就感到非常失望,” 报告称,“迄今为止,在该领域的任何地方取得的成果,都没有实现它当初承诺的重大影响。” 因此,政府对该领域的资金投入被削减,该领域迎来了研究人员后来所说的 “人工智能的寒冬”。此时,建立在高姿态人工智能概念背后的大肆宣传与该领域有限的技术进步之间产生了冲突,这导致相关政府官员开始缩减额外投资,进一步放缓了研究的进展。可以与此类比的是核冬天,即核战之后,烟尘覆盖天空,连续多年阻挡阳光。到辛顿完成其论文时,他的研究已经处于一个不断缩小的领域的边缘。后来他的父亲去世了。“这个老家伙在我取得成功之前就死了,” 辛顿说,“不仅如此,他还得了一种具有高度遗传性的癌症。他做的最后一件事情,就是增加我的死亡概率。”

完成论文之后,随着人工智能的寒冬越来越冷,辛顿艰难地寻找工作。只有一所大学给他提供了面试机会。他别无选择,只能放眼国外,包括美国。美国的人工智能研究也在减少,因为美国的政府机构也得出了与英国相同的结论,减少了对大型大学的资助。但是,在加利福尼亚州的南部,令他非常惊讶的是,他发现了一小群与他相信同样想法的人。

他们被称为 PDP 小组。PDP 是 “并行分布式处理”(parallel distributed processing) 的缩写,是 “感知机”、“神经网络” 或 “连接主义” 的另一种说法。这也算是一个双关语。在 20 世纪 70 年代末的那些年,PDP 是一种计算机芯片,被用在一些产业上最强大的机器上。但是,PDP 小组的学者不是计算机科学家,他们甚至不认为自己是人工智能研究人员。这个小组里有加州大学圣迭戈分校心理学系的几位学者,以及至少一位神经科学家 —— 来自街对面的生物研究中心索尔克研究所的弗朗西斯・克里克 (Francis Crick)。在将注意力转向大脑之前,克里克因为发现了 DNA(脱氧核糖核酸)分子结构而获得了诺贝尔奖。1979 年秋天,他在《科学美国人》杂志上发表了一篇呼吁文章,竭力建议更大范围的科学界至少应该尝试理解大脑是如何工作的。辛顿当时正在大学从事博士后研究,他经历了一种学术文化冲击。在英国,学术界秉持一种知识上的单一文化;在美国,学术界的格局足够丰富,可以容纳一些不同意见。“这里的学术界可能会有不同的观点,” 辛顿说,“但这些观点都可以存在。” 在这里,如果他告诉其他研究人员他正在研究神经网络,他们会听。

从弗兰克・罗森布拉特到南加州正在进行的研究,这两者之间有一条直线。20 世纪 60 年代,罗森布拉特和其他科学家希望开发一种新的神经网络,一个跨越多层神经元的系统。在 20 世纪 80 年代初,这也是加州大学圣迭戈分校的希望。感知机是一个单层网络,这意味着在网络接收的东西(印在纸板上方格内的大写字母的图像)和输出的东西(它在图像中找到的 A)之间只有一层神经元。但是罗森布拉特认为,如果研究人员能够建立一个多层的网络,每一层都向下一层提供信息,这个系统就可以学习感知机无法学习的复杂图形。换句话说,一个更像大脑的系统就会出现。当感知机分析印有字母 A 的卡片时,每个神经元检查卡片上的一个点,并判断这个特定的点是否属于定义字母 A 的三条黑线的典型组成部分。但是对多层网络来说,这只是一个起点。给这个更复杂的系统一张照片,比如一只小狗的照片,随后它会开启一个更为复杂的分析过程。第一层神经元会检查每个像素:它是黑色还是白色,棕色还是黄色?然后,第一层会把学到的东西输入第二层,这一层的另一组神经元将在这些像素中寻找图形,比如一小条直线或一小条弧线。第三层将在图形中寻找图像。它可能会把几条线拼在一起,找到一只耳朵或一颗牙齿的图像,或者把这些微小的弧线组合起来,找到一只眼睛或一个鼻孔的图像。最终,这个多层的网络可以拼出一只小狗的图像。这至少是个想法,实际上,当时还没有人实现。他们在圣迭戈正在为此努力。

加州大学圣迭戈分校的一位名叫戴维・鲁梅尔哈特 (David Rumelhart) 的教授是 PDP 小组的主要人物之一,他拥有心理学和数学学位。当被问及鲁梅尔哈特时,辛顿常常回忆他们被迫听双方都毫无兴趣的一场讲座的时光。讲座结束时,辛顿抱怨说他刚刚浪费了一个小时的生命,鲁梅尔哈特说他并不介意。鲁梅尔哈特说,如果可以忽略台上的讲座,他就有 60 分钟不间断的时间来思考自己的研究了。对辛顿来说,这就是他长期合作者的缩影。

鲁梅尔哈特给自己设定了一个非常特殊但又核心的挑战。要打造一个多层的神经网络,其中的一个大问题是,你很难确定每个神经元对整体计算的相对重要性(权重)。对于感知机这样的单层网络,这至少是可行的:系统可以自动设置其单层神经元的权重。但是对于多层网络,这种方法根本行不通。神经元之间的关系过于广泛和复杂。改变一个神经元的权重,就意味着要改变其他所有依赖于其行为的神经元。人们需要一种更强大的数学方法,将每个权重的设定与其他所有权重结合起来。鲁梅尔哈特认为,答案是一个叫 “反向传播”(backpropation) 的过程。这本质上是一种基于微分的算法,当神经元能够分析更多数据并更好地理解每个权重是什么的时候,它就会发送一种数学反馈,沿着神经元的层次结构向下传递。

辛顿刚拿到博士学位并到达圣迭戈时,他们讨论了这个想法,他告诉鲁梅尔哈特,这个数学把戏永远不会成功。他说,毕竟,设计感知机的弗兰克・罗森布拉特已经证明了它永远不会有效。如果你打造了一个神经网络,并将所有的权重设置为零,系统就可以学会自己调整权重,将变动往下串联多层。但最终,每一个权重都会和其他权重一样落在同一个地方。无论你如何努力地让系统采用相对权重,它的自然趋势都是不断校平。正如弗兰克・罗森布拉特所展示的,这只是数学的运行方式。用数学术语来说,这个系统无法 “打破对称性”。一个神经元永远不会比其他任何神经元更重要,这是一个问题。这意味着这个神经网络并不比感知机好多少。

鲁梅尔哈特听取了辛顿的反对意见,然后提了一个建议。“如果没有将权重设置为零呢?” 他问道,“如果数字是随机的呢?” 他建议,如果在开始时将所有的权重设置为不同的数值,那么数学的运行情况会有差异,不会将所有的权重校平。它会找到对应的权重,让系统真正识别出复杂的图形,比如一张小狗的照片。

辛顿常常说 “旧的想法也是新的”,他认为科学家永远不应该放弃一个想法,除非有人证明了它行不通。20 年前,罗森布拉特已经证明了反向传播是行不通的,所以辛顿放弃了。然后,鲁梅尔哈特提出了这个小建议。在接下来的几个星期里,他们两人开始着手打造一个从随机权重开始的系统,这个系统可能会打破对称性。它给每个神经元分配不同的权重,通过设置这些权重,系统实际上可以识别图像中的图形。这些都是简单的图像,该系统无法识别狗、猫或汽车,但由于反向传播,它现在可以处理被称为 “异或” 的事情了,这弥补了 10 多年前马文・明斯基所指出的神经网络的缺陷。系统可以检查一张纸板上的两个点,并回答那个难懂的问题:“它们是两种不同的颜色吗?” 但他们的系统也仅限于此,他们再次将这个想法搁置一边。然而,他们找到了绕过罗森布拉特的证明的方法。

在随后的几年里,辛顿与特里・谢诺夫斯基建立了单独的合作关系,后者当时是普林斯顿大学生物系的博士后。他们通过第二个(未命名的)连接主义者小组会面,这个小组每年在全美各地召开一次会议,讨论的很多话题与在圣迭戈讨论的相同,反向传播就是其中之一,玻尔兹曼机也是。多年之后,当有人让辛顿给那些对数学或科学知之甚少的普通人解释玻尔兹曼机时,他拒绝了。他说,这就像让诺贝尔奖得主、物理学家理查德・费曼 (Richard Feynman) 解释他在量子电动力学方面的工作。当任何人要求费曼用外行人能理解的语言解释他赢得诺贝尔奖的工作时,他都会拒绝。他会说:“如果我能向普通人解释,那它就不值得赢得诺贝尔奖了。” 玻尔兹曼机当然也很难解释,部分原因在于,它是一个数学系统,基于奥地利物理学家路德维希・玻尔兹曼 (Ludwig Boltzmann) 的一条百年理论,涉及一个似乎与人工智能完全无关的现象(加热气体中粒子的平衡)。但其目标很简单,它是一种打造更好的神经网络的方式。

和感知机一样,玻尔兹曼机通过分析数据,包括声音和图像数据来学习。但它增加了一个新的变化,就是会创造自己的声音和图像,然后通过对比自己创造的数据与分析的数据,来进行学习。这有点儿像人类的思维方式,因为人类可以想象图像、声音和文字。人们会做梦,夜晚和白天都会,然后在现实世界中运用这些想法和幻象。借助玻尔兹曼机,辛顿和谢诺夫斯基希望用数字技术重新创造这一人类现象。“这是我一生之中最激动人心的时刻,” 谢诺夫斯基说,“我们确信我们已经弄清楚了大脑是如何工作的。” 但是,与反向传播一样,玻尔兹曼机也是一项正在进行中的研究,它没有做任何有用的事情。多年来,它也徘徊在学术界的边缘。

辛顿对各种不受欢迎的想法都抱有宗教般的信仰,这可能让他脱离了主流,但也确实给他带来了一份新工作。一位名叫斯科特・法尔曼 (Scott Fahlman) 的卡内基 —— 梅隆大学教授与辛顿和谢诺夫斯基一起参加了年度连接主义者大会,法尔曼开始认识到,招募辛顿可以成为该大学对冲其在人工智能领域押注的一种方式。与麻省理工学院、斯坦福大学和世界上大多数其他实验室一样,卡内基 —— 梅隆大学专注于符号人工智能研究。法尔曼认为,神经网络是一个 “疯狂的想法”,但他也承认大学里正在开发的其他想法可能同样疯狂。1981 年,在法尔曼的保荐下,辛顿去卡内基 —— 梅隆大学面试了,他做了两场讲座:一场在心理学系,一场在计算机科学系。他的讲座就像一条信息的消防水带,信息极度密集,他根本没有给不熟悉该领域的人多少停顿的时间,因为他在讲每句话时都挥动手臂,将双手分开,然后在表明自己的观点时又将双手合在一起。他在讲座中并没有强调数学或计算机科学,仅仅是因为他对数学或计算机科学没那么感兴趣。他更多的是强调想法,那些有兴趣并且能够跟上他思路的人感到莫名地兴奋。那一天,他的讲座引起了人工智能运动的开创者之一艾伦・纽厄尔的注意,纽厄尔是数十年来推动符号方法的领军人物,是卡内基 —— 梅隆大学计算机科学系主任。第二天下午,纽厄尔给了辛顿一份该系的工作,但辛顿在接受之前推辞了一下。

“有些事你应该知道。” 辛顿说。

“什么事?” 纽厄尔问。

“实际上,我对计算机科学一无所知。”

“没事。我们这里有人懂这个。”

“既然如此,我接受这份工作。”

“工资呢?” 纽厄尔问。

“哦,我不在乎,” 辛顿说,“我做这些不是为了钱。”

后来,辛顿发现他的工资仅仅是同事工资的大约 3/4(2.6 万美元对 3.5 万美元),但他为自己的非正统研究找到了归宿。他继续研究玻尔兹曼机,还经常在周末开车去巴尔的摩,这样他就可以与约翰斯・霍普金斯大学实验室里的谢诺夫斯基合作了。在此过程中,他还开始完善反向传播的研究,认为它会产生有用的比较。他觉得自己需要一些可以与玻尔兹曼机做对比的东西,而反向传播就是不错的选择。在卡内基 —— 梅隆大学,他不仅有机会探索这两个项目,还能使用更好、更快的计算机硬件。这推动了研究工作向前发展,使这些数学系统能够从更多的数据中学到更多的东西。1985 年,也就是他在波士顿向明斯基演讲的一年之后,突破性工作出现了。但产生突破的不是玻尔兹曼机,而是反向传播。

在加州大学圣迭戈分校,辛顿和鲁梅尔哈特证明了多层神经网络可以调整自身的权重。然后,在卡内基 —— 梅隆大学,辛顿证明了这个神经网络实际上可以做的事情不仅仅是给数学家留下深刻的印象。当他输入家谱的碎片信息时,它可以学会识别家庭成员之间的各种关系,这项小技能表明它能够做到更多。如果他告诉这个神经网络,约翰的母亲是维多利亚,维多利亚的丈夫是比尔,它就可以推断出比尔是约翰的父亲。辛顿不知道的是,在完全独立的领域,其他人已经设计出了类似于反向传播的数学技术。但与之前的人不同的是,辛顿展示出的这种数学想法具有前景,它不仅可以用于图像,还可以用于文字。它也比其他人工智能技术更有潜力,因为它可以自己学习。

第二年,辛顿与一位名叫罗莎琳德・扎林 (Rosalind Zalin) 的英国学者结婚了,这是他在英国萨塞克斯大学做博士后研究时认识的一位分子生物学家。她相信顺势疗法,这将成为他们两人关系紧张的根源。“对一位分子生物学家来说,相信顺势疗法是不光彩的。所以,生活很艰难,” 辛顿说,“我们不得不达成一致,不谈论这个。” 她是一名坚定的社会主义者,不喜欢匹兹堡或罗纳德・里根的美国政治。但对辛顿来说,在这段时期,他自己的研究富有成果。婚礼当天早上,他消失了半个小时,给世界领先的科学期刊《自然》的编辑寄去了一个包裹。包裹里有一篇描述反向传播的研究论文,作者是鲁梅尔哈特和一位名叫罗纳德・威廉姆斯 (Ronald Williams) 的美国东北大学教授。这篇论文在当年年底发表了。

这是被整个世界忽视的那种学术时刻,但在这篇论文发表之后,神经网络进入了一个乐观和进步的新时代。随着该领域走出第一个漫长的寒冬,并乘着更大的人工智能投资的浪潮前进,研究人员所说的反向传播不再仅仅是一个想法了。

第一次实际应用发生在 1987 年。卡内基 —— 梅隆人工智能实验室的研究人员正试图制造一种可以自动驾驶的卡车。他们以一辆形似救护车的宝蓝色雪佛兰汽车为基础,在车顶安装了一个手提箱大小的摄像机,并在后备厢里装上了当时被称为 “超级计算机” 的东西 —— 这种机器处理数据的速度比当时典型的商用计算机快 100 倍。整体的思路是,这台包括几块电路板、一些电线和硅芯片的机器,将读取车顶摄像头传来的图像,并决定卡车在前方道路上应该如何行驶。但这需要一些努力。几名研究生正在为所有的驾驶行为人工编写代码,一次一行软件代码,为卡车在道路上遇到的各种情况编写详细的指令。这是一项徒劳的工作。到了那年秋天,也就是该项目启动几年之后,这辆车的速度只有每秒几英寸。

然后,在 1987 年,一位名叫迪安・波默洛 (Dean Pomerleau) 的一年级博士生将所有的代码丢到一边,用鲁梅尔哈特和辛顿提出的想法重建了软件。

他称自己的系统为 ALVINN。两个 N 代表 “神经网络”。在他完成后,卡车能以一种全新的方式运行了,它可以通过观察人类如何在道路上行进来学习行驶。当波默洛和他的同事驾驶卡车穿过匹兹堡的申利公园,沿着沥青自行车道蜿蜒前行时,卡车利用车顶摄像头拍摄的图像来跟踪司机们在做什么。正如弗兰克・罗森布拉特的感知机可以通过分析纸板上的方格来学习识别字母一样,这辆卡车可以通过分析人类如何处理道路上的每个转弯来学习行驶。很快,它就独自在申利公园行驶了。起初,这辆加大马力的宝蓝色雪佛兰汽车载着几百斤的计算机硬件和电气设备,以每小时 9~10 英里或更慢的速度行驶。但随着它继续与波默洛和其他研究人员一起学习,在更高的速度下分析更多道路上的更多图像,它继续得到改进。美国中产阶级家庭往往在他们的车窗上贴着 “车上有婴儿” 或 “车上有奶奶” 的标志,于是波默洛和他的研究伙伴给 ALVINN 贴上了一个写着 “车上没有人” 的标志。这是真的,至少在精神上如此。1991 年一个星期天的清晨,ALVINN 以接近 60 英里的时速从匹兹堡开到宾夕法尼亚州的伊利市。在明斯基和佩珀特的《感知机》一书出版 20 多年后,ALVINN 做到了他们说神经网络做不到的事情。

辛顿没有去现场见证。1987 年,也就是波默洛来到卡内基 —— 梅隆大学的那一年,辛顿和妻子离开美国,前往加拿大。他愿意说的理由是罗纳德・里根。在美国,人工智能研究的大部分经费来自军事和情报组织,其中最著名的是美国国防部高级研究计划局 (DARPA),这是美国国防部中专门研究新兴技术的部门。它创建于 1958 年,是为了回应苏联发射人造卫星而设立的,从人工智能最早的时候起,它就一直资助该领域的研究。这是在《感知机》一书出版后,明斯基从罗森布拉特和其他连接主义者那里撤出的赞助资金的主要来源,它也资助了波默洛对 ALVINN 的研究。但在当时的美国政治环境中,围绕着伊朗门事件的争议频发,里根政府官员秘密向伊朗出售武器,以资助反对尼加拉瓜社会主义政府的行动。辛顿逐渐对依赖美国国防部高级研究计划局的资金感到不满,同时他的妻子怂恿他搬到加拿大,她说自己不能继续在美国生活了。在神经网络研究复兴的高峰时期,辛顿离开了卡内基 —— 梅隆大学,到多伦多大学担任教授。

在这次搬家几年之后,当辛顿大费周章地为自己的研究寻找新的资金时,他怀疑自己是否做出了正确的决定。

“我本应该去伯克利的。” 他对妻子说。

“伯克利?” 他的妻子说,“我愿意去伯克利。”

“但你说过你不会住在美国。”

“那不是美国,是加州。”

但是,他们已经做出了决定,他到了多伦多。这次搬家改变了人工智能的未来,更不用说地缘政治的格局了。

本文摘自《深度学习革命》,作者为《连线》杂志和《纽约时报》的知名记者凯德・梅茨(Cade Metz),中信出版社于 2023 年 1 月出版,《赛先生》获授权转载。

物理诺奖得主 Hopfield:不妨称物理学为 “接受物理学训练者的所作所为”

John Hopfield 返朴 2024 年 10 月 10 日 12:21 北京

10 月 8 日,2024 年诺贝尔物理学奖非常出人意料地颁发给美国科学家 John J. Hopfield 和有 “神经网络之父” 之称的加拿大科学家 Geoffrey E. Hinton,表彰他们 “通过人工神经网络实现机器学习的基础性发现和发明”。奖项公布后,物理学和神经网络的关系成为人们关注和讨论的焦点。

本文是 Hopfield 的人生自述,原题为《在科学中成长》,节选自《成为科学家的 100 个理由》。Hopfield 在 12 岁之前没有学过任何科学课程,但他自幼成长在一个鼓励他自由探索的家庭,中学里遇到了优秀的科学教师,从此自由徜徉在科学之海。

《成为科学家的 100 个理由》是一本近百位世界著名科学家(其中诺贝尔奖得主 30 位)畅谈人生的文集。他们讲述自己成长的经历,倾吐对科学、对知识的热爱与追求,也向年轻一代道出了殷切的期盼。从收录的近百篇文章能够领略他们睿智的科学见解,品味他们多角度的人生心得,还可一瞥他们平凡而又充实的生活。

本书现已绝版,《成为科学家的 100 个理由(20 周年纪念版)》近期将由上海科学技术出版社出版。

撰文 | John Hopfield

儿童天性好奇。他会戳戳甲虫看它们的反应,扔根树枝在小河中观察它漂多远才沉没;他喜欢拆开玩具看个究竟,也会对水流进排水沟便不见踪影感到惊奇。我生长在一个不但宽容、而且鼓励孩子大胆探索的家庭,所能记得的最早活动是在厨房的地板上玩锅盖,把它们上面没有拧紧的部分全都卸下来。在我心目中,父亲能修好一切东西 —— 屋顶、收音机、水管、电线、自行车,也能给钢琴调音和干园艺活。孩提时代,只要父亲做这些事情,我就会守在旁边看。父亲也会向我讲解问题可能出在哪里,如何才能修好。母亲有一台老式 “歌手牌” 缝纫机,小抽屉里放了一把调整机器用的螺丝刀。母亲允许我用它,只要摆弄完之后放回去就行了。我用它到处鼓捣,自得其乐。很多年后,母亲给我讲了当时的一件趣事。一位到我家给妹妹看病的医生一进门,就看见我正把一台带手柄的老式留声机拆得七零八落,他立刻出声制止我。听到医生的声音,母亲毫不在意地对他说:“没关系,要是他装不回去的话,他爸爸会帮他的!” 一句话,当时我在家里很少受到严格的管束,甚至有些 “胆大妄为”。至今我还记得,那真是一把漂亮的螺丝刀!另一件让我着迷的工具是放大镜,我用它观察蚂蚁,或者把阳光聚焦在纸上烧孔。

稍后,母亲开始鼓励我在厨房里做化学实验。我得到了几个试管、软木塞,以及儿童化学实验指南。这些书教孩子们如何用旧电池的锌皮制作氢气,如何让醋和发酵粉在试管中反应而射出软木塞。书中还描述了硫被加热熔化后表现出不同的性质,氢气用火柴点燃时应当发出 “嘭” 的声音。我制成的晶体总不如书上看到的那么漂亮,但晶体的对称结构还是清楚的。通过动手制作,我还明白了它们的成因。无影墨水是我能在厨房中制造的另一种奇妙东西。与大多数学生初次见到酸性试剂是在化学实验室不同,父亲用红色洋白菜作试剂,向我展示了它如何随着溶液酸度的不同而变红或变蓝。

我的电气设计开始于一对电池、几根导线和几个灯泡,印象最深的是在一把钉子上缠绕电线做成电磁铁,以及自制可在卧室和厨房之间传递信号的简易电报机。

后来,还改造过结构式套装玩具。与发明创造的雄心相比,笨拙的手指时常令我感到力不从心,而且手头可资利用的废旧零部件也太少。有一次,我找到了一副老式的头戴耳机,以及一本美国农业部编制的《简易晶体管收音机制作手册》。根据手册,我用头戴耳机、一块方铅矿石(硫化铅)和在纸板筒上绕成的线圈自制了一台收音机。它可以接收远至 75 公里发射台的信号,而且不需要电池。该手册发表于 1930 年,用以指导尚未通电地区的农民制作简易收音机,以便在农村收听无线电广播。后来,我得知单真空管收音机可以收到更远距离的信号,于是用零花钱买来真空管,组装了 “更高级” 的收音机。可以说,我是在亲手制作、改进和维修简易电子装置的过程中,了解电子学和掌握其基本原理的。而且,大多数制作只是修旧利废,花钱其实很少。晶体管收音机最令我着迷的地方是,一些与方铅矿石晶体相连的电线,竟能将无线电信号整流为可听到的声音。这个问题直到 12 年后我上了大学才真正弄清楚。

一辆自行车也能提供学习的好机会。轮辐断了、脚刹车无法再调整了,没关系,我拆开修理修理。装不回去了,父亲总会救我,他会带我到修车店去。当然,可不是去请人修理 —— 那 “太奢侈了”,只是去学点技术和买些必要的零件,回来继续自己修。

我还用一套组合工具自制过模型飞机。先是做橡筋弹射飞机,后来又把微型汽油发动机装上了模型飞机。我从改装中学到了不少东西,后来甚至在修理我得到的第一辆旧汽车时派上了用场。我喜欢阅读杂志的科学栏目。偶然读到一本关于天文学的书,便梦想着能够作出解释宇宙运行的科学发现。

在中学接受的科学教育非常糟糕,完全是照本宣科,为教而教。我 12 岁之前没有学过任何科学课程。之后的科学教育,老师们强调的只是记忆现成知识,而不带领我们去实际动手,加深理解。我的这些科目成绩都很差。幸运的是,我遇到了两位真正优秀的老师。一位是生物老师,另一位是化学老师。生物老师要求我们注意事实的组织,而不是死记硬背无关联的内容。他鼓励我们寻求生物体之间的联系,教导学生如何观察和思考。应当说,这是我第一次真正感受到科学的魅力。高中化学老师则将我们这些十几岁的学生当作成年人,为我们开设真正的科学讲座,指导我们像搞科研那样做实验。跟着这些老师,我做了许多儿时在书本上读到、并一直期盼着能亲自动手完成的实验。猛然间,我成了班上最好的学生。

物理学是探索未知事物及其成因的学科,它寻求关于世界的基本原理、事实和定量描述。一些人沉醉于探究宇宙起源的奥秘,或者极微观事物的性质。我是在一个对周围世界充满好奇的环境里长大的,所以热切地想理解和影响自然。最有意思的物理学莫过于按人的尺度去关注事物的性质,并在更微观的层面上探索事物的结构与属性。

依据上述背景,我进大学后很自然会主修凝聚态物理。我科学生涯的第一个十年,主要研究结晶固体的光相互作用,及其与固体的电子结构和光的量子特性之间的联系。那是一个激动人心的时代,许多领域还是完全未开垦的处女地,相关的实验一个接着一个完成,新的理论很快便能得到验证。我由此获得了极好的基础训练,特别是在广泛运用数学模型方面。

随着对固体物理的理解加深,我转向了以物理术语描述生态系统的研究。事实上,当时这又是一个几乎无人涉足的领域。渐渐地,建立于物理学之上的关于生命系统的实验事实多了起来。我以一种不同寻常的提问方式,为此新兴学科作出了开创性的贡献。我本人也以理论生物物理学研究而引人注目。不过,该领域最重要思想之数学意蕴尚有待进一步阐释和挖掘。我所做的只是找出其中相对简单的问题,清楚地加以表达和陈述,并采用便于理解及物理观察的方式来描述可能的解决路径。

我发表的首篇关于大脑工作机制的文章,后来成为引用率极高的论文。通过对相互联结的神经元网络行为作物理类型的抽象,而将磁性和自旋玻璃这一著名物理主题与联想记忆心理现象联系了起来。由此,在神经生物学中引入了计算的概念,并借助于趋向某一不动点的多自由度系统的动态轨迹来进行计算。上述思想如今被称作 “霍普菲尔德模型” (Hopfield model),它已激发了许多物理学家进入神经生物学领域。研究者们的工作表明,神经生物学与物理学关系极为密切,相关的物理模型可以有效地迁移至神经生物学的研究。两年间,我在参加了多种神经生物学研讨会后,把握住了关键问题。我在分子生物学领域得到最多引用的论文,涉及 “动态校对”,后者是在分子水平上一般通用的校对方法。同时我还率先提出了 tRNA 和蛋白质合成中的动态校对控制机制。在此,我又提出了一个正确的问题。生物学家可能会问:预期的反应是如何发生的?而我则这样问:在预期反应与非预期反应非常相似的情况下,为什么 “非预期的” 和 “不想要的” 反应不会发生?由此发现了新的生物物理规则。

我现在的科学兴趣转向了探讨 “我们人类如何思考” 的问题,这是我常用的提问方式。不过岁月不饶人,我恐怕很难圆满解答以上疑问了。也许有人会说,那是生物学问题还是物理学问题?我想,如此区分其实并无太大意义。就实际研究而言,不妨将物理学定义为 “接受物理学训练者的所作所为”。

苦撑 30 年,离职时 75 岁!看完老爷子的简历,我失眠了……

原创 CodeSheep 2024 年 10 月 11 日 08:53 江苏

0x01

这两天,科技圈又一个爆款新闻相信不少同学都已经看到了。

那就是 76 岁的计算机科学家,同时也是享誉全球的人工智能专家 Geoffrey Hinton 和 John J. Hopfield 一起,拿到了 2024 年诺贝尔物理学奖,以表彰他们通过人工神经网络实现机器学习的奠基性发现和发明。

而上一次 Hinton 站在聚光灯下则是去年 5 月份,彼时 75 岁的 Hinton 正式宣布从谷歌离职。

而这次消息一出,同样又是在科技届引起了一阵关注和讨论,以至于不少同学都发出感叹,“AI 法力无边”、“人工智能终于不止是技术,而是科学了”。

那提到Hinton这个名字,对于学习和从事 AI 和机器学习等领域的同学来说,应该都非常熟悉了。

Hinton 是一位享誉全球的人工智能专家,被誉为 “神经网络之父”、“深度学习的鼻祖”、“人工智能教父” 等等,在这个领域一直以来都是最受尊崇的泰斗之一。

5 年前,Hinton 曾拿下2018 年度图灵奖。

至此,AI 教父 Hinton 也成为了图灵奖和诺贝尔奖的双料得主!

0x02

大多人都是因为近年大火的 AI 才了解的 Hinton,但是他之前的人生经历也是相当富有戏剧性的。

1947 年,Geoffrey Hinton 出生于英国温布尔登的一个知识分子家庭。

他的父亲 Howard Everest Hinton 是一个研究甲壳虫的英国昆虫学家,而母亲 Margaret Clark 则是一名教师。

除此之外,他的高曾祖父 George Boole 还是著名的逻辑学家,也是现代计算科学的基础布尔代数的发明人,而他的叔叔 Colin Clark 则是一个著名的经济学家。

可以看到,Hinton 家庭里的很多成员都在学术和研究方面都颇有造诣。

当然,在这样的氛围下长大的 Hinton,其成长压力也是可想而知的。

1970 年,23 岁的 Hinton 获得了实验心理学的学士学位。但是,令谁也没有想到的是,毕业后这位 “学二代” 由于找不到科研的意义,他竟然先跑去当了一段时间的木匠。

不过这个经历并没有帮助他消除自己的阶段性迷茫,他一直希望真正理解大脑的运作原理,渴望更深入的理论研究,于是经历过一番思想斗争后又下决心重返学术殿堂,投身于人工智能领域。

直到 1978 年,他终于获得了爱丁堡大学人工智能学博士学位,而此时的他也 31 岁了。

那个年代做深度学习的研究可以说是妥妥的冷板凳。

要知道当时的 AI 正值理论萌芽阶段,当时的深度学习在很长一段时间里也一直不温不火,甚至几次陷入寒冬,那 Hinton 所主张和研究的深度学习派当然也很难得到关注和认可。

那面对这一系列冷漠、质疑甚至反对,唯有纯粹的相信与热爱才能将这个领域深耕了数十年,直到坚持到后来 AI 时代的来临。

而这一切,Hinton 都做到了。

0x03

Hinton 主要从事神经网络和机器学习的研究,在 AI 领域做出过许多重要贡献,其中最著名的当属他在神经网络领域所做的研究工作。

他在 20 世纪 80 年代就已经开启了反向传播算法(Back Propagation, BP 算法)的研究,并将其应用于神经网络模型的训练中。这一算法被广泛应用于语音识别、图像识别和自然语言处理等领域。

除此之外,Hinton 还在卷积神经网络(Convolutional Neural Networks,CNN)、深度置信网络(Deep Belief Networks,DBN)、递归神经网络(Recursive Neural Networks,RNN)、胶囊网络(Capsule Network)等领域做出了重要贡献。

2013 年,Hinton 加入 Google,同时把机器学习相关的很多技术带进了谷歌,同时融合到谷歌的多项业务之中。

2019 年 3 月,ACM 公布了 2018 年度的图灵奖得主。

图灵奖大家都知道,是计算机领域的国际最高奖项,也被誉为 “计算机界的诺贝尔奖”。

而 Hinton 则与蒙特利尔大学计算机科学教授 Yoshua Bengio 和 Meta 首席 AI 科学家 Yann LeCun 一起因为研究神经网络而获得了该年度的图灵奖,以表彰他们在对应领域所做的杰出贡献。

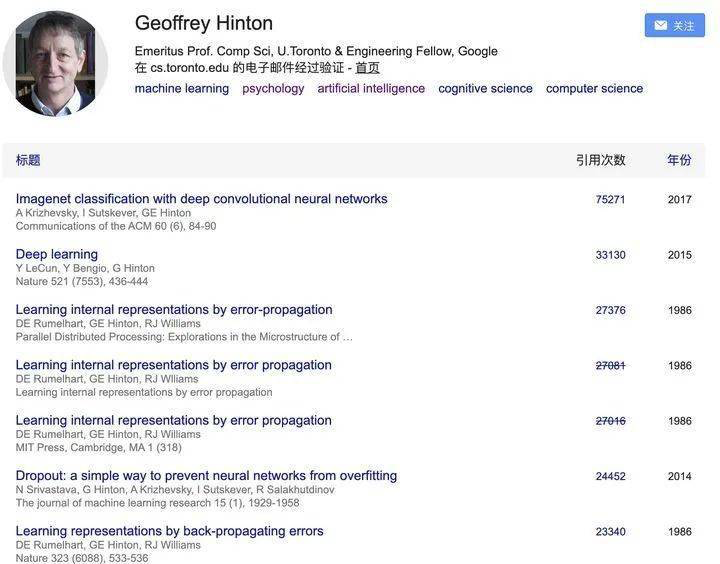

除此之外,Hinton 在他的学术生涯中发表了数百篇论文,这些论文中提出了许多重要的理论和方法,涵盖了人工智能、机器学习、神经网络、计算机视觉等多个领域。

而且他的论文被引用的次数也是惊人,这对于这些领域的研究和发展都产生了重要的影响。

0x04

除了自身在人工智能方面的造诣很高,Hinton 同时也是一个优秀的老师。

当年为了扩大深度学习的圈子,Hinton 曾在多伦多大学成立过研究中心,专门接收有兴趣从事相关研究的年轻人,以至于现如今 AI 圈 “半壁江山” 都是他的 “门生”。

Hinton 带过很多大牛学生,其中不少都被像苹果、Google 等这类硅谷科技巨头所挖走,在对应的公司里领导着人工智能相关领域的研究。

这其中最典型的就是 Ilya Sutskever,他是 Hinton 的学生,同时他也是大名鼎鼎的 OpenAI 公司的联合创始人和首席科学家。

聊到这里,不得不感叹大佬们的创造力以及对这个领域所作出的贡献,同时也期待大佬们后续给大家带来更多精彩的故事。

Geoffrey Hinton 获得 2018 年图灵奖

魁北克成就了 AI 教父!蒙特利尔将引领人工智能的未来!

发布时间:2019-04-01 作者:魁北客

2018 年 3 月 27 日,国际计算机学会(ACM)宣布,有 “深度学习三巨头” 之称的 Yoshua Bengio、Yann LeCun、Geoffrey Hinton 共同获得了 2018 年的图灵奖( Turing)。

1966 年,ACM 设立图灵奖,专门奖励对计算机事业作出重要贡献的个人。这个奖项享有 “计算机界诺贝尔奖” 之称,奖金 100 万美元。

今年是少有的同时出现三位获奖者,而且个个都可以被称作 “AI 界的资深教父”!

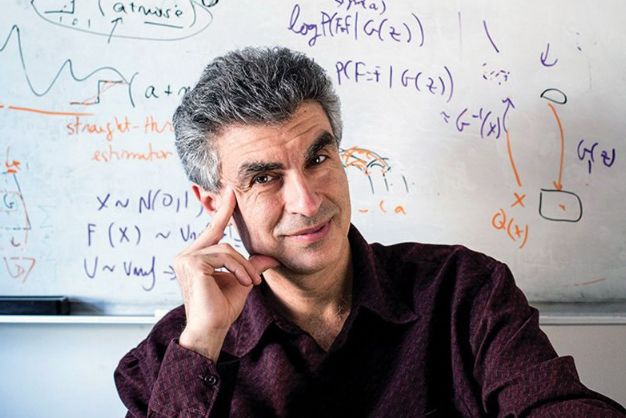

Yoshua Bengio,蒙特利尔大学教授、蒙特利尔学习算法研究院 MILA 科学主管、Element AI 创始人。

Geoffrey Hinton ,谷歌副总裁、工程研究员,也是 Vector Institute 的首席科学顾问、多伦多大学 Emeritus 荣誉教授。他开创了 “深度学习” 分支学科,现在这个分支学科已经等同于 “人工智能”。

Yann LeCun,纽约大学教授、Facebook 副总裁和首席 AI 科学家。曾在多伦多大学跟随 Geoffrey Hinton 做博士后。

这三位获奖者亦师亦友,又和加拿大多多少少有些关联,因此在 AI 界被戏称为 “加拿大三剑客”。

Hinton 和 LeCun 先后去了谷歌和 Facebook 工作。相比之下,Bengio 被认为是 “最后一个学术纯粹主义者”。

Yoshua Bengio 是谁?

Yoshua Bengio,1964 年出生在巴黎,成长在蒙特利尔。

现任蒙特利尔大学计算机科学与运筹学习终身教授、加拿大统计学习算法研究主任、蒙特利尔学习算法研究院(MILA)创始人和科学总监、蒙特利尔数据价值化研究院(IVADO)科学主任、加拿大政府牵头投资的先进科学项目研究所 CIFAR 的研究院员和项目主任。CIFAR 多年来致力于为各行各业的佼佼者提供研究资金支持。

- 1982-1991 年,麦吉尔大学计算机工程专业从本科攻读到博士学位;

研究生时期研究多层神经网络和玻尔兹曼自动语音识别机。在此期间,Bengio 读到了 Hinton 的一篇论文,找到了自己日后学习的方向;

博士时期研究递归神经网络和卷积神经网络与 HMMs 的结合及其在自动语音识别中的应用;

-

1989-1991 年,麦吉尔大学担任研究助理;

-

1991-1992 年,麻省理工学院人工智能实验室,大脑与认知科学系机器博士后研究员;

-

1992-1993 年,AT&T 贝尔实验室,机器学习研究、学习和视觉算法博士后研究员;

-

1993 年开始在蒙特利尔大学任教。

-

2016 年,Bengio 与他人合伙创立了人工智能孵化器 Element AI。促进私营企业与学术界的合作,“将全球领先的人工智能研究转化为变革性的商业应用”。

-

2017 年初,Bengio 成为微软战略顾问。因为他不希望有一家或者两家公司成为人工智能变革中的唯一大玩家,这对研究社区没有好处,对人类也没有好处。

2009-2019 年,Bengio 获得加拿大总督功勋奖、加拿大皇家学会会员、加拿大年度最佳科学家、Marie-Victorin 魁北克奖,这是魁省在科学方面的最高荣誉、加拿大 AI 协会终身成就奖、IEEE CIS 神经网络先锋奖等多个奖项和荣誉。

Bengio 凭《Learning Deep Architectures for AI》和《A neural probabilistic language model》两篇经典之作在内的 300 多篇论文,对深度学习的发展起到了巨大的推动作用。

纯粹的独行侠

1993 年,Bengio 是蒙大唯一一个做机器学习和神经网络研究的人。

Bengio 研究的神经网络,不仅要求强大的计算能力,还需要良好的数据。但在互联网崛起之前,根本没有足够的数据支持。

科罗拉多大学教授 Mozer 回忆说,“多年来,在机器学习会议上,神经网络都不受欢迎,而 Bengio 坚持与他的神经网络为伍。我当时觉得,可怜的 Bengio,他太落伍了。 ”

为了推进研究,Bengio 向学校申请研究资金,还积极利用校外的社交网络为自己拓展、构建 “学术圈”。

在教学的前 7 年,Bengio 只有两门课,所以有时间和精力去完善自己的人脉网络,去做研究。

但当他已经入选加拿大首席研究员计划,教学任务也从两门课也变成了三门课,同时还要筹建实验室的时候,他的第二个孩子出生了。

这是他第一次对家庭感到愧疚,也对教师这份工作感到不知所措。

尽管在家庭和工作的双重压力下,Bengio 和 Hinton 也从未停止对机器学的探讨研究。

同时,Bengio 也愈发坚定地认为不能忘记自己的长期目标,要保持 “中立”。选择成为一名教员就应该认准一个方向,让自己成为这个领域里的专家,成为最强大的人。

随着时代的发展,神经网络和机器学习逐渐成为了香饽饽。加拿大政府为了鼓励合作,为研究人员提供了客观的赞助经费。

但 Bengio 向加拿大自然科学和工程研究委员会(NSERC)等组织提出建议时,他发现 “金主们” 完全不关心研究人员的想法和意愿,只期待几年后的成果报告。

同时,Bengio 还被 NSERC 要求去做最 “先进” 的研究,然后不停发表引人注目的研究论文。

在 Bengio 看来,这种做法完全丧失了研究的纯粹性,只是迎合公司管理层的喜好。

显然,这段经历给 Bengio 留下了负面印象。或许这也是为什么,Bengio 至今都是一名 “学术纯粹主义者”。

MILA 创始人

1993 年,Bengio 创立了独立的非营利组织 MILA(Montreal Institute for Learning Algorithms,蒙特利尔学习算法研究院)。这是目前世界上最大的基于大学的深度学习研究中心。

许多大型实验室都普遍存在随着人数和发表的论文数量增多,教授花在学生身上的时间逐渐减少的问题。

但 Bengio 反而把学生从家里拽出来,让他们始终和同学、教师互相合作。这不仅打破了学员和教授的一对一关系,还能帮他们扩展自己的人脉圈,学到更多的东西。

在研究经费方面,Bengio 为所有的学生提供资助。让他们放下资金压力,优先把精力投入到合作和研究中。

AI 新硅谷

在 Bengio 的眼中,蒙大、MILA 和 Element AI 构建了一个具有特殊文化的 AI 生态系统。

“魁北克不同于北美的其他地区。这里并非过分强调个人主义和竞争意识。所以我们可以更好的团结协作,取得成功。”Bengio 说,“即使是在鲜有人涉足深度学习研究的时候,蒙大不仅非常肯定我的设想,还允许我在一个还未受到大众欢迎的领域继续聘请更多教授。“

重视人才,渴求人才,因此把人才视若珍宝。充分给予研究员自由,让他们找到自己的位置,不断激发他们的潜能。

加拿大各地的研究学院相互之间也建立了合作关系,努力打造加拿大的 AI 联盟。加拿大政府也通过一些有趣且新颖的 AI 招聘计划吸引了不少人才的到来。

之后就是滚雪球般的良性发展。

研究院一代比一代优秀,论文质量越来越高,在国际上获得的关注不断增加,聘请到的优秀研究员也随之增长。

同时,深度学习的商业价值越高,吸引的公司和投资者越多。这也加速了相关领域的发展。

包括 Microsoft、Google、Facebook 在内的大大小小的公司相继入驻蒙特利尔,使得蒙特利尔在科学界和投资界变得更加引人注目。

“以前,投资者会要求这些企业家搬到硅谷,但现在,他们很乐意看到这些企业家留在加拿大。”

“我永远感激魁北克给了我一个发展和繁荣的环境,”Bengio 说,“我在这里扎了根,我希望我们在研究中所做的事情,在某种程度上能回馈到社区和那些创造了我非常喜欢的社会的人身上。”

诺奖&图灵奖双料得主 Geoffery Hinton:“AI 质疑者一错再错,未来还会继续被打脸”…

AI科技大本营已于 2024-12-16 10:12:45 修改

“如果你为富有创造力的研究人员提供充足的基础研究经费,他们实际上会更愿意从事基础科研,而不是去银行赚大钱。”

作者 | Eric Harrington

出品丨AI 科技大本营(ID:rgznai100)

前段时间,韩国公共广播电视台 KBS 专访了人工智能领域的泰斗级人物杰弗里·辛顿(Geoffrey Hinton)教授。作为 2024 年诺贝尔物理学奖得主,这位被誉为“深度学习之父”“AI 三教父”的科学家,深入探讨了 AI 技术的演进历程和未来发展方向。

顺带一提,韩媒给辛顿教授的绰号是“AI 四大天王”,应该是在 Geoffery Hinton、Yoshua Bengio、Yann LeCun 三位图灵奖得主的基础上,又算上了“强化学习之父” Rich Sutton。

在这场长达 17 分钟的对话中,辛顿教授分享了多个引人深思的观点:

- “长期以来,我们的主要局限是体力。工业革命消除了这个局限。而现在,我们的主要局限是智力,而 AI 将消除这个局限。”

- “在北美,每年约有 20 万人死于误诊。而如果医生与 AI 系统合作,正确诊断率可从 40% 提升至 60%。”

- “自主致命武器可能在两到三年内出现。所有的 AI 监管法规都有一条:这些规定不适用于 AI 的军事用途。”

- “如果你为富有创造力的研究人员提供充足的基础研究经费,他们实际上会更愿意从事基础科研,而不是去银行赚大钱。”

在专访最后,老教授强调了基础研究投入的重要性,并用一句格外犀利的话结尾:“每隔几年,就会有人说「神经网络被高估了,这一切马上就会崩溃和停止。」但他们每次都错了,我认为他们还会继续犯这样的错误。”

以下是采访全文翻译(皆为 Hinton 的第一人称发言)和中英双语字幕视频:

01 深度学习之路:从神经元到 ChatGPT

人类的发展史上存在两个重要的局限:体力和智力。工业革命突破了人类的体力局限,而如今,人工智能正在突破人类的智力局限。

深度学习(Deep Learning)的设计灵感来自人脑的工作机制。尽管我们还没有完全破解大脑的运作原理,但已经掌握了相当多的知识。人脑中有大量的神经元细胞(Neurons),这些神经元之间形成了复杂的连接网络。学习的过程,本质上就是改变这些连接的强度。

神经元通过发出“ping”的信号与其他神经元通信。每个神经元的任务很简单:决定何时发出“ping”信号。它通过接收来自其他神经元的输入来做出这个决定,这些输入可能来自感知神经元,比如视网膜中的神经元。当输入达到一定阈值时,神经元就会发出信号,而达到阈值的难易程度取决于神经元之间连接的权重(Weight)。如果连接的权重较小,一个神经元向另一个神经元发送的信号影响就小;如果权重较大,这个信号就更可能触发接收神经元发出“ping”。

学习的核心就在于改变这些连接的强度。而关键问题是:大脑用什么原理来调整这些连接的强度?

20 世纪 80 年代,科学家们提出了反向传播(Backpropagation)算法,这是一种决定如何调整连接强度的方法。当时这种方法效果一般,我们没有预见到,只要提供足够的数据和计算力,它就能发挥出惊人的效果。如今的大型聊天机器人正是使用反向传播来调整其模拟神经网络中的连接强度。

这就是深度学习的基本原理。以识别鸟类的神经网络为例:第一层的神经元可能负责识别边缘特征,第二层的神经元则可能识别特定的边缘组合,比如以特定角度相交的两条边可能代表鸟喙。再往上一层的神经元可能会识别鸟喙和眼睛的组合特征,如果这些特征的空间关系正确,网络就会将其判断为鸟头。这种层层递进的特征检测方式最终让网络能够判断:如果同时看到疑似鸟头、鸟脚和翅膀尖等特征,那么这个物体很可能就是一只鸟。而所有这些特征检测所需的权重,都是神经网络通过学习获得的。

从 20 世纪 50 年代人工智能诞生之初,就存在两种不同的研究路线:一种基于逻辑(Logic-based),另一种基于生物学(Biology-based)。基于生物学的方法试图模拟大脑中的神经网络,而基于逻辑的方法则尝试通过模拟逻辑来实现推理。直到最近,基于生物学的神经网络方法才真正超越了逻辑方法。

在人工智能发展的前 50 年,几乎所有人都相信逻辑方法才是正确的道路,但这条路并没有取得实质性突破。直到本世纪,大约在 2009 年左右,模拟生物学的神经网络方法突然开始展现出惊人的效果。这个转变具有划时代的意义。2012 年,神经网络在物体识别领域取得重大突破,这标志着生物学方法的胜利。

神经网络能够取得如此显著的成功,主要得益于三个关键因素:

-

第一是算力的突破

比如英伟达(NVIDIA)为游戏开发的芯片提供了巨大的计算能力。

-

第二是数据量的爆发

互联网为我们提供了海量的训练数据。

-

第三是技术的进步

例如,2017 年谷歌推出的 Transformer 架构大幅提升了语言模型的性能。

这些突破引发了人们对神经网络的极大兴趣。而当 ChatGPT 发布后,人们看到神经网络真的能够理解人类的表达并做出合理的回答,这又掀起了一波更大的关注热潮。

02 AI 改变世界的三大领域

我认为人工智能将在所有行业领域得到应用。在某些领域,比如医疗保健,AI的影响显然会带来巨大的积极改变。

以就医为例,目前如果我出现某些症状,我会去看家庭医生。但如果我患有某种罕见疾病,我的家庭医生可能从未见过类似病例。相比之下,我更愿意去找一位“见过”上亿病人的医生,这位医生不仅了解我的全部基因组信息,还掌握了我完整的病史和所有医疗检查结果。这样的 AI 医生即将成为现实,它们的诊疗水平将远超普通医生。AI 在医学影像读取方面也将表现出色。

AI 能够利用更全面的信息来辅助诊断。现有的数据显示,对于疑难病例,人类医生的正确诊断率约为 40%,AI 系统能达到 50%,而医生与 AI 系统合作则能达到 60% 的正确率。在北美,每年约有 20 万人死于误诊。因此,AI 的应用将挽救大量生命。

在教育领域,研究表明,一对一私教的学习效率是课堂教学的两倍。有了 AI,每个孩子都能拥有自己的私教,这将使学习效率提高一倍。这必将对教育产生巨大影响,尽管这对大学教育可能不是个好消息。

实际上,只要有数据的地方,AI 就能发挥作用。让我举个例子:我有一个邻居为一家矿业公司开发了 AI 系统。这家公司拥有约 100 亿个数据点,记录了在不同情况下完成特定操作(如挖掘特定长度的矿井)所需的时间。现在这些数据被输入到 AI 系统中,可以快速回答各种问题。

比如,如果承包商声称能在指定时间内完成某项工作,公司想知道他实现这一承诺的概率有多大。在过去,要得到这个答案,公司需要聘请大型咨询公司撰写报告,三周后才能得到结果。而现在,他的系统只需 4 秒就能给出答案。这只是一个例子,但在所有拥有大量数据的行业都会出现类似的情况。企业将能够更快速、更有效地利用自己掌握的数据。

如今当我遇到新问题时,我会寻求 GPT-4 的帮助。比如有一次,我的度假小屋遭到某种蚂蚁的侵扰。我向 GPT-4 咨询,它告诉了我可能是哪些种类的蚂蚁,以及相应的处理方法。这种体验就像有一个知识渊博且极其耐心的朋友。

当然,我们也注意到了 AI 的“幻觉”(Hallucination)现象,有时它会产生错误的信息。但人类不也是如此吗?当人类出现类似现象时,我们称之为“虚构”(Confabulation)。人们总是在虚构。比如当人们回忆很久以前发生的事情时,他们往往无法准确记住细节。他们可能很自信,但细节却是错误的。从这个角度看,人类和这些大型聊天机器人很相似,都会产生虚构的内容。

在技术快速发展的时期,预测未来是非常困难的。如果你想了解十年后的情况,最好的方法可能是回顾十年前的状况。十年前,没有人能预想到会出现像 GPT-4 或谷歌的 Gemini 这样的大型聊天机器人。因此,从现在起的十年后,我们将看到许多超出人们预期的发展。

短期内,变化可能不会太戏剧性。但**在十年的跨度上,AI 的能力将发生巨大的变革。**在人类文明史上,AI 革命与之前的技术革命相比有何意义?让我们看看工业革命:在工业革命中,人类的体力不再那么重要。工业革命之前,如果要挖一条沟,你需要人力来挖。虽然也有动物和风车、水车之类的工具,但基本上还是需要人力。工业革命后,人类体力的重要性大大降低。

现在发生的情况是,人类的智力仍然很重要。但当 AI 变得比我们更聪明时,人类的智力将像工业革命后的体力一样变得不那么重要。你可以把历史看作是不断消除人类局限性的过程。长期以来,我们的主要局限是体力。现在,我们的主要局限是智力,而 AI 将消除这个局限。

03 人类与 AI 的未来:机遇与挑战

如果你问,在历史上有多少例子表明智力较低的存在能够控制智力较高的存在?我只知道一个例子,那就是母亲和婴儿的关系。进化投入了大量工作来确保婴儿能够控制母亲,这对物种的生存至关重要。但即便如此,婴儿和母亲的智力水平其实也差不多。因此,当这些 AI 系统变得比我们更智能时,我们不确定能否保持对它们的控制。

我的朋友 Yann LeCun 等人认为这不会有问题,因为这些系统是我们创造的,它们会一直按照我们的指令行事。但我并不这么认为。我觉得我们不能对此太过自信。

我相信人类本质上是物质的存在,人类的任何特质都可以在计算机中实现。 从长远来看,计算机可以拥有我们所有的感知能力。我认为人类并没有什么特别之处。我们只是非常非常复杂的存在,经过了漫长的进化。对其他人而言我们很特别,但我们身上没有什么是机器无法模拟的。

有些人担心 AI 会夺走人类的工作。事实上,AI 带来的风险有很多种,我们不应该把这些不同的风险混为一谈。不同的风险需要不同的解决方案。AI 确实会取代很多工作岗位,这是毋庸置疑的。比如法律研究助理(Paralegal),现在 AI 已经能更好地完成他们的大部分工作。很多普通的办公室工作都将需要更少的人力。

我有一位亲戚在医疗服务机构工作,负责回复投诉信。以前她要花 25 分钟写一封回复信,现在她只需要把投诉信输入 ChatGPT,它就能生成回复,她检查一下就可以发送出去,整个过程只需要 5 分钟。这意味着这类工作只需要原来五分之一的人力。这种情况在许多普通办公岗位中都很典型。

有人说 AI 会创造大量新的工作岗位。这确实是事实,但问题在于:新创造的工作岗位是否足以替代那些被 AI 取代的普通办公职位?这是一个严重的问题。政府需要认真考虑:当这些人的工作被 AI 取代后,他们该何去何从?

就短期而言,我最担心的是网络攻击和生物武器。 比如去年,网络钓鱼(Phishing)攻击增长了 1200%,这在很大程度上是因为这些聊天机器人被用于钓鱼攻击。我也担心有人利用 AI 开发新的病原体,目前这方面几乎没有任何管控。这是短期的担忧。

在中期,我非常担心就业问题和自主致命武器(Autonomous Lethal Weapons)。从长远来看,我最担心这些 AI 系统变得比我们更聪明,最终取代我们。 我认为在两到三年内,我们可能就会看到自主致命武器的出现。这将是一个糟糕的发展。所有大型国防部门都在试图开发这类武器。如果你看看目前的 AI 监管法规,它们都有一个条款,声明这些规定不适用于 AI 的军事用途。例如,欧盟的法规就明确规定不适用于 AI 的军事应用。

政府不愿意约束自己。他们正在竞相开发自主致命武器。只有在这些武器被使用并造成可怕后果之后,我们才可能像制定日内瓦公约那样达成某种协议,就像我们对化学武器所做的那样。这些公约是有效的,比如在乌克兰战争中就没有使用化学武器。但我们是在第一次世界大战看到了化学武器的可怕后果之后,才有了这些公约。

我们现在需要做的是,在技术发展过程中投入更多精力于安全研究。 而唯一拥有这些资源的是大型科技公司。因此,我们需要政府强制要求这些大公司在安全方面做出更多努力。

显然,发展 AI 需要大量的算力,也需要大量的专业人才。要留住优秀的科学家,就要为他们提供能够开展研究的环境。以加拿大为例,按其经济规模来看,在 AI 领域表现相当出色。这要归功于其支持基础科研的政策。像我、Yoshua Bengio 和 Rich Sutton 这样的顶尖 AI 研究人员之所以来到加拿大,部分原因是这里的社会制度,但主要是因为这里愿意资助基础科学研究。因此,充分资助基础科学研究是关键。

我对韩国的建议是:如果你为富有创造力的研究人员提供充足的基础研究经费,他们实际上会更愿意从事基础科研,而不是去银行赚大钱。当然,总会有人选择去银行工作赚更多钱,这是无法避免的。但对基础科学研究的良好支持,包括对计算资源的支持,才是留住优秀研究人员的方式。

关于人形机器人(Humanoid Robot)的发展,现在确实有很多人在研究这个方向。这是可能实现的。开发人形机器人的一个原因是,工厂是为人类设计的。工厂里的所有机器都是按照人类操作的需求来设计的。因此,与其重新设计所有机器,不如重新设计一个“人”,这样就可以使用现有的机器。现在已经有人在尝试这么做了。我不知道这个方向会如何发展。

我认为我们正处在一个充满巨大不确定性的时期。在这样的时期,我们应该保持谨慎。人们问是否会出现调整期或衰退期。对此有两种不同的观点。我的观点是 AI 的发展会持续下去。有些人,特别是那些相信传统的、基于逻辑的 AI 方法,从来就不喜欢神经网络的人,一直在说这种发展即将结束。

但多年来,每当有人说神经网络被过分夸大时,神经网络都用实际成果证明了自己。现在它们确实能做出令人惊叹的事情。所以我不认为这是夸大其词。每隔几年,就会有人说:“嘿,神经网络被高估了,这一切马上就会崩溃和停止。”但他们每次都错了。我认为他们还会继续犯这样的错误。

参考链接:https://www.youtube.com/watch?v=SN-BISKo2lE

via:

-

AI 教父拿下诺奖,却很后悔 原创 朱秋雨 南风窗 2024 年 10 月 09 日 17:38 广东

https://mp.weixin.qq.com/s/e04PJlG19QKr4xWTCgaIqQ -

诺贝尔物理学奖罕见一幕!“AI 教父” 意外获奖,物理圈傻眼 原创 李水青 程茜 智东西 2024 年 10 月 08 日 20:18 浙江

https://mp.weixin.qq.com/s/S2A9sjRubOHUmJ2E93LB6A -

AI 教父 Hinton 获诺奖后:谷歌 CEO 办庆功宴,奖金计划捐出,还 Diss 了一把阿尔特曼 原创 程 茜 智东西 2024 年 10 月 09 日 19:10 北京

https://mp.weixin.qq.com/s/eAZQTuCjie13sbY4Z_GvSg -

解密诺贝尔物理学奖为啥颁给 AI?Hinton 和 Ilya 12 年前对话,竟引发物理诺奖 AI 风暴!新智元 2024 年 10 月 09 日 13:16 北京 标题已修改

https://mp.weixin.qq.com/s/cFe9plNsk8NBM1Zhi6a6BQ -

2024 诺贝尔物理奖给了 AI 教父辛顿,本人回应 “没有想到” 知识分子 2024 年 10 月 08 日 18:15 江苏

https://mp.weixin.qq.com/s/dNxu16uDCXpK9cOQ1PySjg -

诺贝尔物理学奖得主辛顿:旧的想法也是新的

https://mp.weixin.qq.com/s/ELRK5ZgMcjDhyCvmAwWm3g -

物理诺奖得主 Hopfield:不妨称物理学为 “接受物理学训练者的所作所为” JJohn Hopfield 返朴 2024 年 10 月 10 日 12:21 北京

https://mp.weixin.qq.com/s/wFsOUHJF7Jy5lrAG2PefdA -

苦撑 30 年,离职时 75 岁!看完老爷子的简历,我失眠了 CodeSheep 2024 年 10 月 11 日 08:53 江苏

https://mp.weixin.qq.com/s/sdC1qfogAUgqhd61mv61Cg -

魁北克成就了AI教父!蒙特利尔将引领人工智能的未来! - 魁北客 | 了解加拿大从《魁北客》开始!发布时间:2019-04-01 作者:魁北客

https://ohquebec.com/mcbd/201904/mcbd2473.html -

诺奖&图灵奖双料得主 Geoffery Hinton:“AI 质疑者一错再错,未来还会继续被打脸”…-CSDN博客 AI科技大本营已于 2024-12-16 10:12:45 修改

https://blog.csdn.net/dQCFKyQDXYm3F8rB0/article/details/144440012

507

507

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?