论文:《Searching for MobileNetV3》

概述:

该论文主要讲如何使用NAS搜索出适用于移动设备的轻型网络,提出了MobileNetV3-Large和MobileNetV3-Small两个模型。

基础结构:

网络结构图如下所示,主要是在点向卷积后加了一个SENet的attention模块。

激活函数:

另外用上了swish激活函数。给出了两种形式。

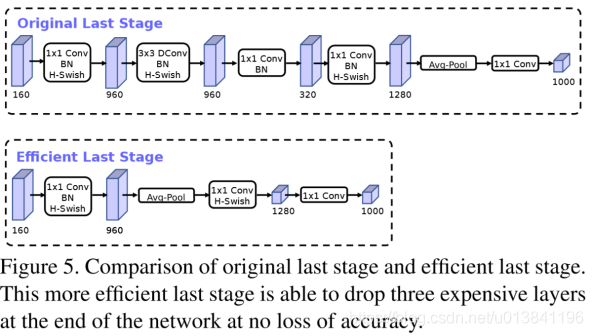

最终块的优化:

MobileNetV3的网络结构:

MobileNetV3定义了两个模型: MobileNetV3-Large和MobileNetV3-Small。V3-Large是针对高资源情况下的使用,相应的,V3-small就是针对低资源情况下的使用。两者都是基于之前的简单讨论的NAS。

《Searching for MobileNetV3》这篇论文详述了如何通过神经架构搜索(NAS)技术设计出适用于移动设备的高效模型——MobileNetV3。论文提出了两个版本的模型,即MobileNetV3-Large和MobileNetV3-Small,分别针对高资源和低资源场景。网络结构中结合了点卷积与SENet注意力模块,并引入了新的swish激活函数。MobileNetV3的优化集中在最后块的设计,旨在提高性能与效率的平衡。

《Searching for MobileNetV3》这篇论文详述了如何通过神经架构搜索(NAS)技术设计出适用于移动设备的高效模型——MobileNetV3。论文提出了两个版本的模型,即MobileNetV3-Large和MobileNetV3-Small,分别针对高资源和低资源场景。网络结构中结合了点卷积与SENet注意力模块,并引入了新的swish激活函数。MobileNetV3的优化集中在最后块的设计,旨在提高性能与效率的平衡。

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?