目录

一、池化技术架构

智能算力池化指依托云计算技术,整合 GPU/AI 芯片等异构算力资源,构建集中管理的资源池,并按上层智算业务的需求,对池化的资源进行统一调度、分配,实现智算业务生命周期管理的全套技术。为解决智算中心所面临的资源利用率低下问题,算力池化基于传统云计算技术(如 Kubernetes、OpenStack,智算中心以 Kubernetes 为 主)有针对性地增强 GPU/AI 芯片池化能力,采用软件定义的方式, 对 GPU/AI 芯片进行分时调度管理,实现按 GPU/AI 芯片的细粒度分配资源,并采用 GPU/AI 芯片 Runtime API 劫持、应用程序监视器等技术,实现资源跨节点远程调用、零散资源整合等,从而达到算力资源充分利用、碎片最小化效果,可有效提升资源效率,降低智算中心整体建设成本。

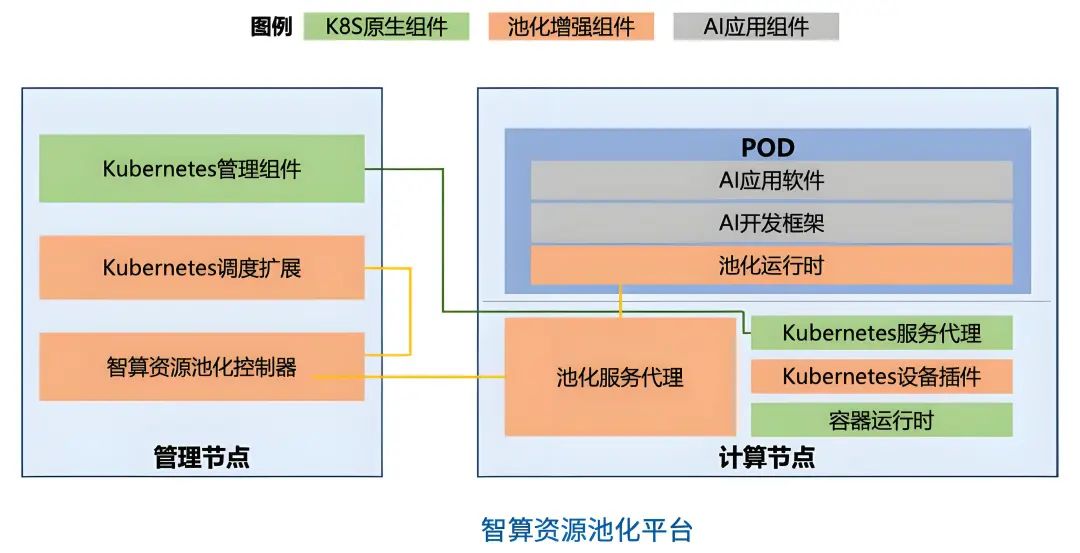

如上图,Kubernetes 作为池化平台的技术底座,主要承担 CPU 的管理调度和作为 AI 任务载体的容器 POD 的生命周期管理功能,通过对 Kubernetes 调度能力的扩展,将 GPU 等智算的管理功能转移至独立的池化控制器执行。而在业务侧,在容器 POD 内植入完全仿真 GPU 卡的原生运行时的池化运行时组件,AI 应用可以像在真实环境中一样运行无感知,通过池化运行时劫持 AI 应用对 GPU的访问 API 并转交池化服务代理执行,再由池化代理配合池化控制器实现敏捷管理功能。

算力池化平台逻辑上可分为池化资源管理、资源服务代理、池化运行时三类模块组成:

-

池化资源管理

-

Kubernetes管理组件:基于Kubernetes原生管理服务组件定制化增强,如支持分布式文件存储、支持 POD 多网络平面、支持 RoCEv2/Infiniband 网络等。

-

Kubernetes调度扩展:关联Kubernetes调度服务扩展专用的池化资源类型,对该类资源的请求转递智算资源池化控制器进行调度、分配,需配合Kubernetes设备插件使用。

-

智算资源池化控制器:对GPU、AI芯片等智算进行统一管理、调度、分配。

-

资源服务代理

-

池化服务代理:根据智算资源池化控制器的调度结果,将池化运行时对资源的访问请求重定向到实际物理位置执行,如涉及跨机访问智算资源,则需相关服务器上的池化服务代理多次重定向,跨机重定向的流量需经由高速无损网络(如参数面网络)。

-

Kubernetes服务代理:基于Kubernetes原生服务代理组件定制化增强。

-

Kubernetes 设备插件:配合Kubernetes调度扩展,为Kubernetes服务代理注册专用的池化资源类型。

-

容器运行时:基于原生容器运行时(如Dockerd、Containerd 等)定制化增强。

-

池化运行时

-

池化运行时:依托GPU、AI芯片的原生运行时(如CUDARuntime) 进行二次封装,采用 API 劫持、应用程序监视等技术,将 AI 应用软件/AI 开发框架对算力资源的访问转递至池化服务代理执行。池化运行时位于容器 POD 内,在容器运行时由自动注入。

根据上述技术架构,当AI应用编排器通过调用 Kubernetes API 创建应用时,可按新增的池化资源类型指定申请的资源数量(如 pool.kubernetes.io/gpu: 1),对该类型资源的申请会被Kubernetes调度扩展拦截、转递至智算资源池化控制器进行调度,智算资源池化控制器按申请的资源数量、资源池内空闲资源分布情况进行调度后,将调度结果响应给 Kubernetes 管理组件,然后 Kubernetes 管理组件正常执行AI应用的创建流程,由 Kubernetes 服务代理创建最终 POD 作为交付物,并通过池化服务代理配合在 POD 中自动注入池化运行时、 通过 Kubernetes 设备插件配合在 POD 中插入虚拟 GPU。

AI 应用的POD在运行的时候,通过池化运行时访问虚拟GPU、执行AI任务,池化运行时拦截对虚拟GPU的访问请求、转递给池化服务代理执行,池化服务代理通过向智算池化控制器查询虚拟GPU所对应的真实智算资源位置、规格,按查询结果分配智算资源、执行AI任务,如果真实的智算资源位于远程计算节点,则由本地池化服务代理将访问请求转递给远程计算节点上的池化服务代理处理,相关通信经由参数面网络。

二、池化核心技术

-

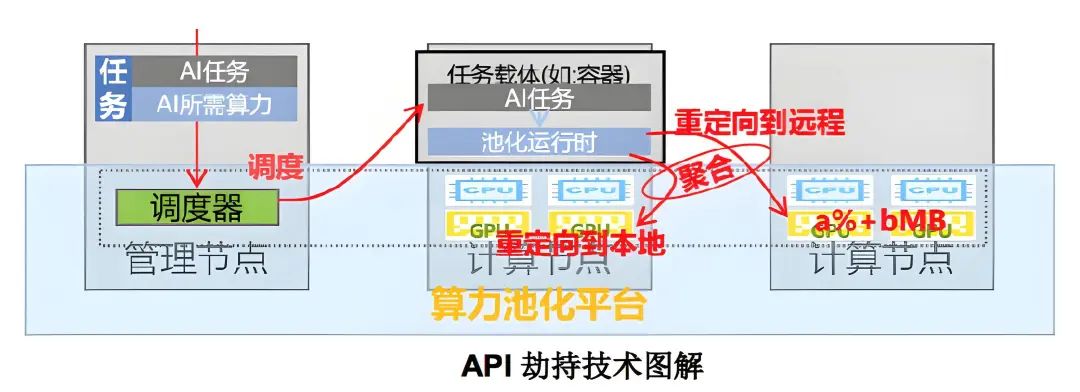

API 劫持技术

-

API 劫持技术是目前比较普遍的、针对智能算力的池化技术,它通过劫持对 Runtime API(如 CUDA API)调用实现资源调度。AI 应用的容器 POD 内运行的池化运行时并非 GPU/AI 芯片原生的运行时,而是基于原生运行时进行了一定定制化的版本,它对上层应用所提供的 API 接口完全等同于原生运行时,因此对 AI 应用来说是透明的。当 AI 应用访问池化运行时的 API 时,则被池化运行时转递至池化服务代理执行,池化服务代理则具备敏捷化的资源管理功能,比如按 1%算力、1MB 缓存的精度细粒度分配资源,实现跨节点远程调用资源等。

-

API 劫持技术的关键在于池化运行时仿真 GPU/AI 芯片的原生运行时,由于 GPU/AI 芯片种类、型号繁多,其原生运行时又相对活跃、升级频繁,仿真工作较为复杂,开发量、维护难度较大。

-

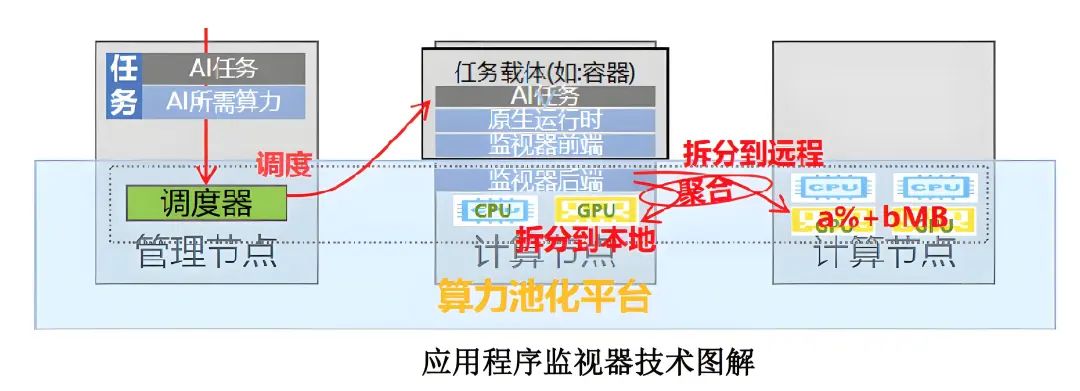

应用程序监视器技术

-

这是一种完全与 GPU/AI 芯片无关的设备虚拟化和远程处理方法, 允许在没有显式软件支持的情况下启用新的硬件体系结构。该项技术通过应用程序监视器工作,该监视器与 Hypervisor 管理虚拟机的方式类似,分为前端、后端,前端监视指定应用程序的活动,拦截至后端处理,后端可以按应用程序申请的数量分配资源,或将应用程序拆分到多台机器上运行,在保持代码、数据和执行环境一致性的前提下使用这些机器上的智算资源,从而实现资源的细粒度管理、远程调用等资源敏捷化管理功能。应用程序监视器负责维护应用程序状态(内存、文件、应用程序库的加载),以及虚拟化与系统的交互(例如系统调用和进程间通信),以确保在多个位置执行时的一致性。

-

与 API 劫持技术直接介入到 AI 应用访问资源的流程、需要仿真原生运行时的 API 接口的方式不同,应用程序监视器不介入到 AI 应用访问资源的流程,而是通过更底层的系统调用隐含而广泛的支持更多种类、型号的硬件和新的运行时功能,其实现方式与特定的运行时 API(如 CUDA)无关,具备更加强大的通用性和兼容性。该池化技术实现较为复杂,但灵活性较高,然而 GPU/AI 加速卡驱动的接口多为不透明, 对驱动调用的劫持面临一定的兼容性问题,且存在一定的法律风险。应用程序监视器技术是一种新型的池化方案,目前VMware 的 Radium、阿里云的 cGPU、腾讯云的 pGPU 等产品为典型代表。

两种方案在集成实现难度、性能表现、升级适配等方面各有优劣,项目应用落地时需根据实际应用情况选择。除此之外,其他一些大厂也有各自的池化方案。

三、展望

当大模型迈进万亿参数量规模,算力、显存和互联的需求再次升级,智算中心将真正进入超级池化时代,高速互联的百卡组成的“超级服务器(Super Server, S2)”可能将成为新的设备形态。传统以单机8卡为最小单元的智算中心设计思路需要革新,“超级服务器”内需要打造统一的协议实现 CPU、GPU、AI 芯片、显存、存储等池化资源的无缝连接,进而通过 GSE 等高性能交换网络,达到极高吞吐、极低时延的系统算力;为推动算效能力进一步提升,基于存算一体架构的大算力芯片将开始逐步应用;存储系统在“超级服务器”内支持内存池技术,对外扩展支持全局统一存储;针对日益割裂的智算生态,需要构建基于算力原生平台的跨架构开发、编译、优化环境,屏蔽底层硬件差异,从软件层面最大化使能异构算力融通。

往期推荐

AIDC智算中心建设:计算力核心技术解析-CSDN博客文章浏览阅读880次,点赞24次,收藏9次。智算中心是人工智能发展的关键基础设施,基于人工智能计算架构,提供人工智能应用所需算力服务、数据服务和算法服务的算力基础设施,融合高性能计算设备、高速网络以及先进的软件系统,为人工智能训练和推理提供高效、稳定的计算环境。智算中心的主要功能包括:提供强大的计算能力:智算中心采用专门的AI算力硬件,如GPU、NPU、TPU等,以支持高校的AI计算任务。高效的数据处理:智算中心融合了高性能计算设备和高速网络,能够处理大规模的数据集和复杂的计算任务。https://blog.csdn.net/u013891230/article/details/147703920?spm=1011.2415.3001.5331一文解读DeepSeek在保险业的应用_deepseek 保险行业应用-CSDN博客文章浏览阅读1k次,点赞44次,收藏29次。随着人工智能技术的深度渗透,保险行业正经历从传统经验驱动向数据智能驱动的转型。作为国产高性能开源大模型的代表,DeepSeek 凭借其低成本、高推理效率及跨模态处理能力,已成为保险机构突破服务瓶颈、重构业务逻辑的核心工具。截止目前,已有超过 20 家保险公司完成 DeepSeek 本地化部署,覆盖精准营销、智能核保、客户服务、运营效率优化等核心场景,推动行业向智能化、精细化方向加速升级。_deepseek 保险行业应用

https://blog.csdn.net/u013891230/article/details/146923598?spm=1011.2415.3001.5331一文解读DeepSeek在银行业的应用_deepseek在银行的应用-CSDN博客文章浏览阅读1.5k次,点赞38次,收藏21次。随着人工智能技术的快速发展,大语言模型(LLM)已成为银行业数字化转型的核心驱动力。作为高性能开源大模型的代表,DeepSeek 凭借其低成本、高推理效率及跨场景适配能力,正加速渗透至银行核心业务场景。据不完全统计,截至 2025 年 3 月,已有包括国有大行、股份制银行及城商行在内的 20 余家银行完成 DeepSeek 本地化部署,覆盖精准营销、智能风控、客户服务、投资决策等领域,推动银行业务效率提升与服务模式重塑。_deepseek在银行的应用

https://blog.csdn.net/u013891230/article/details/146922794?spm=1011.2415.3001.5331一文解读DeepSeek大模型在政府工作中具体的场景应用_deepseek在机关工作中应用-CSDN博客文章浏览阅读1.2k次,点赞28次,收藏29次。本文以政务内部管理的视角,介绍DeepSeek大模型在政务数字化在转型中的提质增效应用!政务本是一个复杂的系统,对外要提供公共服务,对内有严格的安全管理要求。DeepSeek大模型在政务系统中的应用,对外提升服务水平,对内增强办公效率,一体两面,全力引领政务数字化加速转型!_deepseek在机关工作中应用

https://blog.csdn.net/u013891230/article/details/146712602?spm=1011.2415.3001.5331一文解读DeepSeek大模型在政务服务领域的应用_皖政通 deepseek-CSDN博客文章浏览阅读1.2k次,点赞35次,收藏10次。随着政务数字化转型的深入,以DeepSeek为代表的大模型技术正逐步成为提升政府服务效能的核心驱动力。通过自然语言处理、多模态数据融合和深度学习等技术,DeepSeek在智能问答、政策分析、城市治理等场景中展现出强大的能力。其低成本、高适配性的特点,尤其为中小城市和基层政务提供了普惠化AI解决方案。目前,全国已有超100家政府单位接入DeepSeek,覆盖民生服务、行政审批、城市管理等多个领域,显著提升了政务服务的智能化水平。_皖政通 deepseek

https://blog.csdn.net/u013891230/article/details/146572018?spm=1011.2415.3001.5331一文解读DeepSeek在工业制造领域的应用_deepseek工业应用-CSDN博客文章浏览阅读1.6k次,点赞42次,收藏16次。在当今数字化浪潮席卷全球的背景下,各个行业都在积极寻求创新与变革,工业制造领域也不例外。然而,传统工业制造在生产效率、质量控制、成本管理等方面面临着诸多挑战。在这一关键时期,人工智能技术的兴起为工业制造带来了新的机遇。DeepSeek作为一种前沿的人工智能技术,逐渐走进了工业制造领域的视野。本文将深入探讨DeepSeek在工业制造领域的应用现状、优势以及面临的挑战,旨在为相关企业和从业者提供有价值的参考,助力工业制造向智能化、高效化方向迈进。_deepseek工业应用

https://blog.csdn.net/u013891230/article/details/146513702?spm=1011.2415.3001.5331一文解读DeepSeek的安全风险、挑战与应对策略_deepseek的发展带来的风险与挑战-CSDN博客文章浏览阅读1.8k次,点赞28次,收藏22次。DeepSeek作为中国领先的AI大模型提供商,凭借其开源、低成本和高性能的优势,迅速在全球AI市场占据重要地位。然而,随着其应用范围的扩大,DeepSeek在数据安全、模型漏洞、网络攻击等方面面临严峻挑战。本文基于最新公开资料,系统分析DeepSeek的安全风险、行业影响及应对策略,为企业和政策制定者提供参考。_deepseek的发展带来的风险与挑战

https://blog.csdn.net/u013891230/article/details/146513162?spm=1011.2415.3001.5331

欢迎 点赞👍 | 收藏⭐ | 评论✍ | 关注🤗

777

777

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?