问题模型

关键词:关系思维,过程思维

在计算机软件的世界里,一切都是虚拟的。一切皆是映射关系的存在。无论 OOP、FP。

在现实世界里,是不是也是这样?现实世界真的存在吗?为何人生如梦?

物质符号网络如何共同发挥整体作用?

参与创造意义的参与者 Actors 群体既是物质的又是符号学的。

如何将不同元素一起关联到网络中,以使它们形成表面上连贯的整体?

这些网络可能是瞬态的,存在于不断的制造和再制造中。这意味着需要反复“执行”关系,否则网络将解散。他们还假设关系网络在本质上并不协调,可能确实包含冲突。社会关系,换句话说,只有曾经在过程中,必须进行持续。

这个过程,跟大型复杂软件系统的架构构建道理也是相通的。

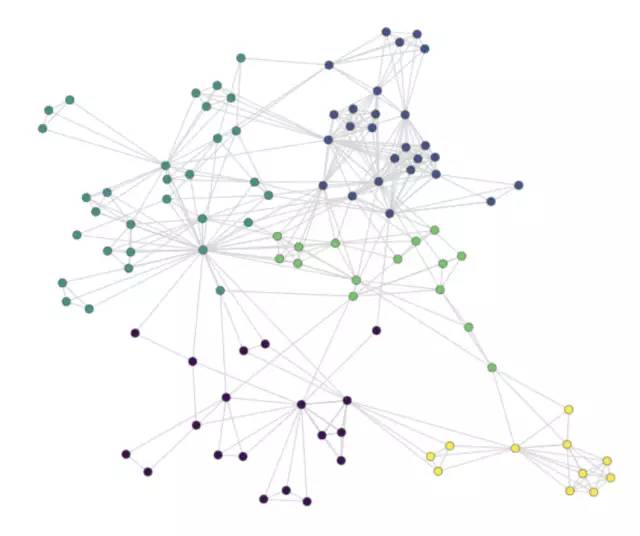

Actor 与 Actor 网络互动后,立即陷入关系网中,成为宇宙万物的一部分。在该网络中,没有所谓的中心,也没有主—客体的对立,每个结点都是一个主体,一个可以行动的行动者,

行为者网络理论(ANT)认为社会与自然世界的每个元素都存在于不断变化的关系网络中,人与非人行动者地位平等。网络中,行动者通过互动形成整体,而转译是互动的主要方式。网络效应受行动者间关系影响,而非规模大小。汽车和软件系统的例子展示了ANT理论的应用。

行为者网络理论(ANT)认为社会与自然世界的每个元素都存在于不断变化的关系网络中,人与非人行动者地位平等。网络中,行动者通过互动形成整体,而转译是互动的主要方式。网络效应受行动者间关系影响,而非规模大小。汽车和软件系统的例子展示了ANT理论的应用。

订阅专栏 解锁全文

订阅专栏 解锁全文

8942

8942

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?