主页: 元存储博客

全文 5000 字, 原创保护, 请勿转载。

前言

NVIDIA H2 上的 HBM100e。

1. JEDEC 规范

2. HBM 发展历程

2.1 产品篇

HBM roadmap

来源:CICC, Dolphin research

HBM技术曾被视为一种噱头,因为它与GDDR相比没有明显的优势。当第一代HBM问世时,与12个384位的GDDR相比,四个4096位的HBM在带宽和容量方面的差异并不大,但价格昂贵。此外,市场没有太多需要大量图形内存的游戏,并且HBM主要用于大学或公司的人工智能实验室,因此需求比普通的GDDR少。因此,三星电子在2019年认为无法销售HBM,并暂时退出了该业务。

然而,随着性能的提升,GDDR和HBM之间的技术差距也越来越大。尤其是在GDDR方面,由于故障限制导致改进速度缓慢,而HBM的技术发展相对较快,因为通过良好堆叠内存芯片,容量和带宽可以翻倍。此外,超大规模人工智能领域的需求激增,对内存要求高,为了充分利用这些需求,几乎必须采用HBM。这是因为容量很重要,但对于在短时间内处理大量模型数据也很重要。

由于基本结构的差异,HBM在带宽方面远优于GDDR。2020年2月,三星开始量产Flashbolt HBM2E,支持最高8-Hi、3.2 GT/s的速度,每个堆叠总共16GB,带宽为410GB/s。SK海力士也开发了HBM2E,支持最高8-Hi、3.6 GT/s的速度,总容量为16GB,从2020年7月开始量产。2020年11月16日,NVIDIA宣布推出升级版的A100 80GB计算卡,HBM2E的速度为3.2 Gbps,总带宽为2 TB/s。

2021年,SK海力士宣布开发HBM3,并于2022年1月27日发布JEDEC的HBM3标准规范。每个堆叠的最大速度为819GB/s,在双堆栈配置中约为1.6TB/s,而384位配置的GDDR6X SGRAM 21 Gbps规格仅超过1TB/s,因此,如果HBM3驱动的产品没有延迟交付,它们将暂时具有带宽优势。

尽管三星电子在2019年暂时退出了开发,但在2022年成功开发了第四代HBM,命名为HBM3 "Icebolt"。然而,由于比SK海力士晚一年开始开发,因此很难将其交付给NVIDIA。预计三星将在2023年底至2024年1月之间开始量产HBM3。

截至2023年,HBM在存储半导体市场的容量份额还不到1%,但销售额已达到存储市场的10%,使其成为高附加值存储器之一。随着对人工智能芯片的需求迅速增加,对于与之相匹配的处理速度的需求也在增加,HBM市场正在蓬勃发展。

2023年8月,SK海力士成功研发了HBM3E。

2023年5月,据报道,三星的下一代HBM将被命名为HBM3P "Snowbolt"。同年9月,宣布公司已同意向NVIDIA供应HBM3。然而,据了解,收到HBM3样品的NVIDIA担心产量问题,因此在没有达成最终合同的情况下签署了有条件的临时合同。特别是,由于NVIDIA已决定将其下一代HBM内存命名为"HBM3E",据报道,三星电子已要求更改名称为"HBM3P"。

2023年10月,三星电子宣布成功开发了HBM3E,也被称为"Shinebolt"。

2023年11月,NVIDIA宣布配备HBM3E的H200和B100将于2024年第二季度上市。AMD和英特尔也分别发布了配备HBM350的MI3和Gaudí 3。

SK海力士可能率先在2025年推出HBM4。https://www.eetimes.com/sk-hynix-speeds-hbm-roadmap-as-ai-demand-soars/

2.2 制程篇

关于制程了,我们经常听到台积电 28nm(当今比较主流的), 14nm(目前中高端的芯片用到), 7nm, 甚至 4nm,这些是形容半导体的制程。制程越小,单个半导体晶体管就变小,这样带来的好处非常显著, 面积减小, 功耗降低, 速度提升。

在 DDR 领域, 有专门的制程称呼。排序为1y、1z、1α、1β和1γ,从左往右, 右边制程更先进。其中 1β 是已量产产品中最先进的。用来做 HBM 的 DDR, 三星用的是 1α, SK Hynix 和 Micron 是采用 1β, 这一点上三星要落后一些 [来源]。

3. HBM 应用场景

高端AI服务器和GPU搭载HBM芯片已成为主流趋势,还可应用于高性能计算(HPC), 人工智能等领域 [参考]。

人工智能

人工智能需要深度学习, 训练需要快速计算,并处理大量数据。这也是AI 芯片需要大量 HBM 的原因。HBM 的大客户是英伟达的AI 芯片。

高性能计算(HPC)

HBM 助力 HPC 高性能计算

显卡

显卡在渲染图像和视频时需要高速处理大量数据。 HBM 克服了 GPU 性能瓶颈。

4. HBM 市场前景

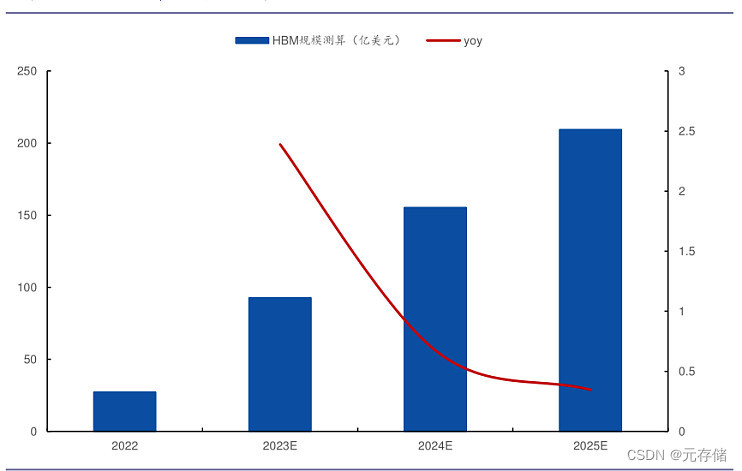

随着生成式人工智能(AI)的持续火爆,市场对于高性能AI芯片的需求,也带动了此类AI芯片内部所集成的高带宽内存(HBM)的需求爆发。预计市场规模将从2022年到2026年前增长10倍(4年复合年增长率77%),从2022年的23亿美元增长至2026年的230亿美元。

4.1 HBM市场规模增长情况

美银还指出,这种对DRAM晶圆产能的增加需求可能会导致2025年非HBM用的常规DRAM出现供应短缺[1]。

“HBM3E芯片的尺寸大约是同等容量DDR5的两倍。HBM产品包括逻辑接口芯片,并且具有更加复杂的封装堆栈,这会影响良品率。因此,HBM3和3E需求将吸收行业晶圆供应的很大一部分。”

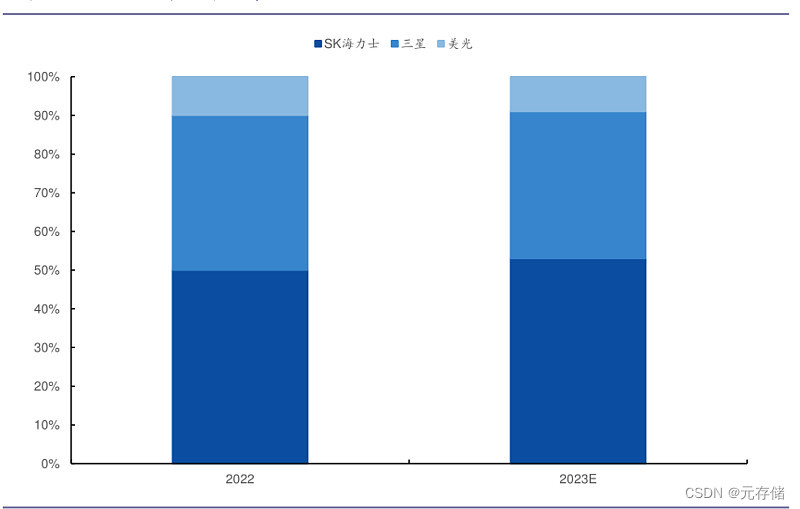

4.2 HBM市场份额

数据来源:TrendForce

截至2023年,SK海力士和三星合计占据市场份额的90%,其中SK海力士占53%,三星占38%,剩余10%由美光控制。特别是在最新的HBM3情况下,SK海力士几乎占据市场的主导地位,预计在2024年占据90%的市场份额。英伟达在通用AI芯片市场上占据80%的市场份额,在销售与其GPU配套的产品方面具有显著优势,因为它正在与SK海力士合作。

到 2024 年底,三星 HBM 产能预期达到每月 130k;海力士为每月 120-125k [来源]。

5. 发展挑战

5.1. 热挑战

“最大的挑战是热” 格林伯格说。“HBM 的位置靠近 CPU 和 GPU 会加剧发热, 它开始忘记85°C左右的东西,并且在125°C左右完全心不在焉。 [2]。

Ansys产品经理Marc Swinnen说。“功率可能是集成可实现的首要限制因素。任何人都可以设计一堆芯片并将它们全部连接起来,所有这些都可以完美地工作,但你将无法冷却它。"

5.2. HBM 和 AI

AI/ML 中存储和检索数万亿次计算需要内存。事实上,在某种程度上,添加更多的 CPU 并不能提高系统性能,因为内存带宽无法支持它们。这就是臭名昭著的“记忆墙”瓶颈。

5.3. 降低成本

虽然HBM能够提供大量内存带宽和良好的能效,但其每GB成本是DDR5或LPDDR5X的3倍以上 [来源链接]。

人工智能客正在 LPDDR5X 接口和 HBM 接口之间做出重大的基本权衡。他们真的很想去 HBM。就技术而言,这是他们内心的愿望。唯一阻碍他们的是成本。

“降低HBM成本将是一个挑战,”Objective Analysis首席分析师Jim Handy说。“由于在晶圆上放置TSV的成本很高,因此处理成本已经明显高于标准DRAM。这阻止了它拥有与标准 DRAM 一样大的市场。“ 由于市场规模较小, 像设计成本和光罩成本无法通过规模量产摊低,导致单片成本更加高。

5.4. 制造问题

“HBM 领域的很多领域实际上更多的是关于制造问题,而不是知识产权问题,”Cadence 知识产权集团产品营销总监 Marc Greenberg 说。你需要弄清楚如何构建一个带有硅中介层的系统,HBM3E 的TSV 良率依然较低,仍在 50% 左右[4]。

参考文献

[1] HBM需求有多强?美银:抢产能可能导致DRAM供应短缺

[2] https://semiengineering.com/hbms-future-necessary-but-expensive/

[3] https://semiengineering.com/choosing-the-correct-high-bandwidth-memory/

[4] https://new.qq.com/rain/a/20240618A09E9200

[5] https://finance.sina.cn/2024-04-29/detail-inatmwwm1631645.d.html

声明

本文仅为学习交流目的。

文中部分文字和图片来源于互联网,列在参考的文献,但可能有遗漏。如有侵权,请告知我删除。

本文概述了HBM(高带宽内存)的发展历程,从JEDEC规范到HBM各代技术的进步,强调了其在AI服务器GPU、高性能计算等领域的应用。随着AI需求的增长,HBM市场预计将在2022年至2026年间实现77%的年复合增长率。然而,热挑战、成本和制造问题仍是HBM发展面临的挑战。

本文概述了HBM(高带宽内存)的发展历程,从JEDEC规范到HBM各代技术的进步,强调了其在AI服务器GPU、高性能计算等领域的应用。随着AI需求的增长,HBM市场预计将在2022年至2026年间实现77%的年复合增长率。然而,热挑战、成本和制造问题仍是HBM发展面临的挑战。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?