本文是对我的大学课程——《人工智能Ⅰ》的课程知识整理,分上下两个部分,本文为下半部分,上半部分详见《人工智能Ⅰ》课程复习资料(上)

内容为速记精简版,若想进一步了解学习请参考更多资料。

目录

回归+降维

为什么要降维?

在机器学习中,如果特征值(也可称之为维度,或feature)过多,会引发维度灾难。维度灾难最直接的后果就是过拟合现象,

降维方法

特征选择

特征选择后的特征是原来特征的一个子集。

特征抽取后的新特征是原来特征的一个映射。

PCA的主要思想

将n维特征映射到k维上,这k维是全新的正交特征,也被称为主成分

LDA的基本思想:将高维的模式样本投影到最佳鉴别矢量空间,投影后保证模式样本在新的子空间有最大的类间距离和最小的类内距离,

聚类

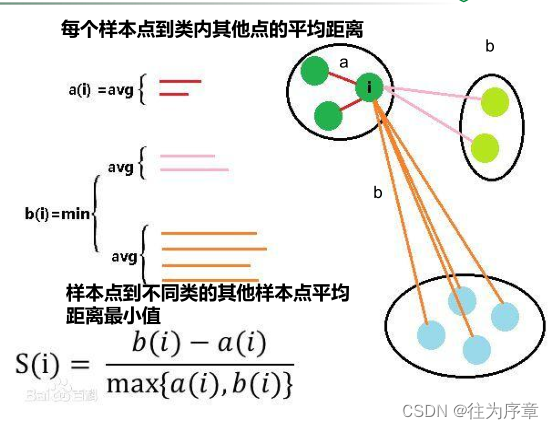

可见轮廓系数的值是介于[-1,1] ,越趋近于1代表内聚度和分离度都相对较优。负值表示

与簇外更近。

当簇内只有一个点时,定义轮廓系数为0。最大值为1,负值表示与本组不近,与组外接近

K-means(又称k-均值或k-平均)聚类算法。首先随机确定k个中心点作为聚类中心,

DBSCAN通过检查数据集中每个点的Eps邻域来搜索簇,如果点p的Eps邻域包含的点多于MinPts个,则创建一个以p为核心对象的簇;

② 然后,DBSCAN迭代地聚集从这些核心对象直接密度可达的对象,这个过程可能涉及一些密度可达簇的合并;

③ 当没有新的点添加到任何簇时,该过程结束

人工神经网络-F2

为什么引入激活函数

为了增强网络的表达能力,我们需要激活函数来将线性函数->非线

性函数

非线性的激活函数需要有连续性。因为连续非线性激活函数可以可导的,所以可以用最优化的方法来求解

激活函数应该具有什么性质?

非线性:线性激活层对于深层神经网络没有作用;仍为线性变换;

连续可微:梯度下降法要求满足连续可微;

范围最好不饱和:有饱和区间段时,系统优化时梯度近似为0,网络的学习会停止;

单调性:当激活函数单调时,单层神经网络的误差函数为凸,易优化;

原点处近似线性:当权值初始化为接近0的随机值时,网络学习较快;

激活函数

sigmoid函数 f(x) = 1/1+e-x

梯度消失

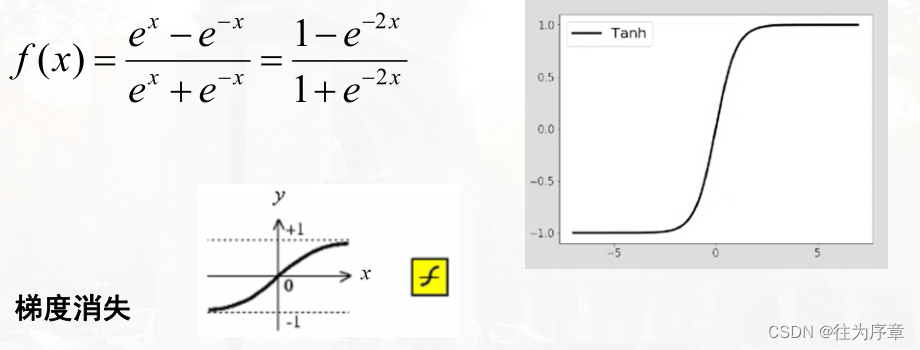

Tanh函数

梯度消失

ReLu函数

fx = x,x>=0

=0,x<0

多层感知器:单层感知器对非线性分类问题无能为力,但大量问题是非线性的,因此在输入层与输出层之间引入隐层作

训练集设计:样本的选择与组织要注意以下两点。

a.样本的选择:样本类别均衡且每类样本数量大致相等,“平均主义”。

b.样本的组织:不同类别样本交叉输入,以避免网络训练出现振荡。

支撑向量机

常见的核函数:大大减少非线性映射和特征空间确定所需要的计算量,采用不同的核函数将导致不同的支持向量机。

在支持向量机中,主要运算形式是 向量内积,其中 margin 指的是间隔 。决定分类面可以平移的范围的数据点是支持向量 。

线性支持向量机和一般线性分类器的区别在于是否确保间隔最大化

关注我,持续分享有趣有用的知识!

5447

5447

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?