💥💥💞💞欢迎来到本博客❤️❤️💥💥

🏆博主优势:🌞🌞🌞博客内容尽量做到思维缜密,逻辑清晰,为了方便读者。

⛳️座右铭:行百里者,半于九十。

📋📋📋本文目录如下:🎁🎁🎁

目录

⛳️赠与读者

👨💻做科研,涉及到一个深在的思想系统,需要科研者逻辑缜密,踏实认真,但是不能只是努力,很多时候借力比努力更重要,然后还要有仰望星空的创新点和启发点。当哲学课上老师问你什么是科学,什么是电的时候,不要觉得这些问题搞笑。哲学是科学之母,哲学就是追究终极问题,寻找那些不言自明只有小孩子会问的但是你却回答不出来的问题。建议读者按目录次序逐一浏览,免得骤然跌入幽暗的迷宫找不到来时的路,它不足为你揭示全部问题的答案,但若能让人胸中升起一朵朵疑云,也未尝不会酿成晚霞斑斓的别一番景致,万一它居然给你带来了一场精神世界的苦雨,那就借机洗刷一下原来存放在那儿的“躺平”上的尘埃吧。

或许,雨过云收,神驰的天地更清朗.......🔎🔎🔎

💥1 概述

基于分布式DDPG方法的投资组合管理的风险敏感方案研究

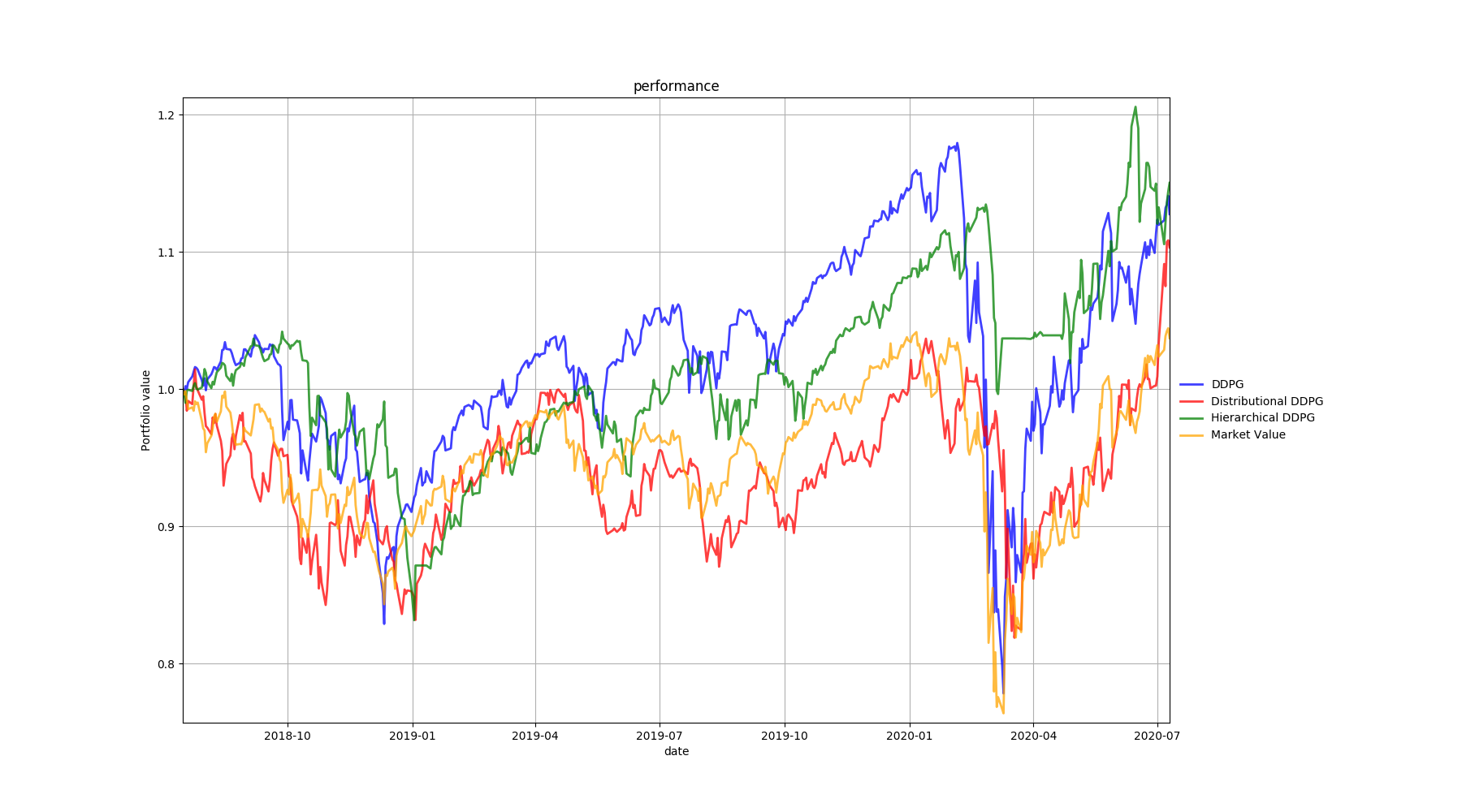

投资组合决策是金融市场的基础,但由于市场的高度不确定性和大量噪音,获得最优策略具有挑战性。Lillicrap等人(2015)提出的深度确定性策略梯度(DDPG)是一种深度强化学习(RL)算法,在金融领域取得了显著成就。尽管RL在金融交易中的应用已经非常成熟,但令人惊讶的是,大多数文献忽略了罕见灾难事件可能带来的风险,以及最坏情况对交易决策的影响。在本文中,我们首先开发了一种新的深度强化学习算法,称为分层DDPG,它将经典的DDPG算法和分层强化学习结构结合起来,以控制投资组合的风险。其次,我们将分布式DDPG方法应用于投资组合管理问题,该方法旨在基于未来收益的分布,最大化α-百分位期望。真实世界的数据集用于验证我们提出的模型的性能。实验结果表明,我们提出的模型优于市场和经典的DDPG,而且这两种方法都提供了构建风险敏感策略的有效方法,以保护投资者免受巨大损失。

摘要

本文旨在探讨投资组合管理中的风险敏感策略,利用深度强化学习(RL)中的深度确定性策略梯度(DDPG)算法,并结合分布式计算和分层强化学习结构,以应对金融市场的高度不确定性和罕见灾难事件。我们提出了一种称为分层DDPG的新算法,并将其应用于投资组合管理问题,旨在通过最大化α-百分位期望来控制风险。实验结果表明,该方法优于市场和经典DDPG算法,为投资者提供了有效的风险敏感策略。

一、引言

投资组合管理在金融市场中占据核心地位,但受市场不确定性和噪音的影响,制定最优策略极具挑战性。深度强化学习(RL)作为机器学习的一个分支,通过结合深度学习和强化学习的优点,为解决此类问题提供了新的途径。然而,尽管RL在金融交易中的应用日益成熟,但大多数研究仍忽略了罕见灾难事件可能带来的风险。本文旨在通过开发新的深度强化学习算法,以更全面地考虑风险,为投资组合管理提供有效的风险敏感策略。

二、背景与文献综述

- 深度确定性策略梯度(DDPG)算法:DDPG算法由Lillicrap等人(2015)提出,结合了深度学习和确定性策略梯度算法的优点,能够在高维状态空间和连续动作空间中学习最优策略。在金融领域,DDPG算法已被应用于股票交易、风险管理等领域,取得了显著成就。

- 分层强化学习:分层强化学习将复杂任务分解为多个子任务,每个子任务由不同的策略控制。这种结构有助于降低问题的复杂性,提高学习效率和策略的稳定性。

- 风险敏感策略:在金融市场中,风险是投资者不可忽视的重要因素。传统的投资组合管理策略往往侧重于最大化期望收益,而忽略了潜在的风险。因此,开发风险敏感策略对于保护投资者免受巨大损失具有重要意义。

三、方法

- 分层DDPG算法:本文将经典的DDPG算法与分层强化学习结构相结合,提出了一种新的分层DDPG算法。该算法将投资组合管理任务分解为多个子任务,包括资产配置、风险控制等,每个子任务由不同的策略控制。通过分层结构,算法能够更全面地考虑风险,制定更有效的投资组合策略。

- 分布式DDPG方法:为了处理大规模数据集和加速学习过程,本文将分布式计算方法应用于DDPG算法。通过并行处理多个计算节点,算法能够更快地收敛到最优策略,提高计算效率。

- α-百分位期望最大化:为了控制投资组合的风险,本文引入了α-百分位期望的概念。通过最大化α-百分位期望,算法能够在保证一定收益水平的同时,降低潜在的风险。

四、实验与结果

本文使用真实世界的数据集对提出的模型进行了验证。实验结果表明,分层DDPG算法和分布式DDPG方法均优于市场和经典的DDPG算法。通过最大化α-百分位期望,算法能够在保证一定收益的同时,有效地控制风险,为投资者提供稳健的投资组合策略。

五、结论与展望

本文提出了一种基于分层DDPG算法和分布式计算方法的投资组合管理风险敏感方案。实验结果表明,该方法优于市场和经典的DDPG算法,为投资者提供了有效的风险敏感策略。未来研究将进一步探索分层强化学习结构在投资组合管理中的应用,以及如何结合更多的金融信息和市场趋势来提高策略的稳定性和准确性。

📚2 运行结果

部分代码:

import torch

from torch.autograd import Variable

import torch.nn as nn

import torch.nn.functional as F

import numpy as np

from network.base_network import BasicNet

import logging

# from agent import ProximalPolicyOptimization, DisjointActorCriticNetdnet

from component import HighDimActionReplay, OrnsteinUhlenbeckProcess, AdaptiveParamNoiseSpec, hard_update, ddpg_distance_metric

from utils.config import Config

from utils.tf_logger import Logger

import gym

# import torchdp

from utils.normalizer import Normalizer, StaticNormalizer

import matplotlib

import matplotlib.pyplot as plt

from utils.notebook_plot import LivePlotNotebook

from window_length.ddpg_win_5 import agent as agent5

log_dir_5 = '/code/video/DDPGAgent-ddpg-cnn-agent-ETF-win7-etf_chn2.pth'

agent5.worker_network.load_state_dict(torch.load(log_dir_5))

from window_length.ddpg_win_5 import test_algo, task_fn_test, task_fn_vali

portfolio_value_51, df_v_5, actions_5 = test_algo(task_fn_vali(), agent5)

portfolio_value_52, df_t_5, act5 = test_algo(task_fn_test(), agent5)

🎉3 参考文献

文章中一些内容引自网络,会注明出处或引用为参考文献,难免有未尽之处,如有不妥,请随时联系删除。(文章内容仅供参考,具体效果以运行结果为准)

[1]范培潇,柯松,杨军,等.基于改进多智能体深度确定性策略梯度的多微网负荷频率协同控制策略[J].电网技术, 2022(009):046.

[2]周雪松,张心茹,赵浛宇,等.基于DDPG算法的微网负载端接口变换器自抗扰控制[J].电力系统保护与控制, 2023, 51(21):66-75.

[3]李建标,陈建福,高滢,等.基于RG-DDPG的直流微网能量管理策略[J].中国电力, 2023, 56(7):85-94.

🌈4 Python代码实现

资料获取,更多粉丝福利,MATLAB|Simulink|Python资源获取

1116

1116

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?