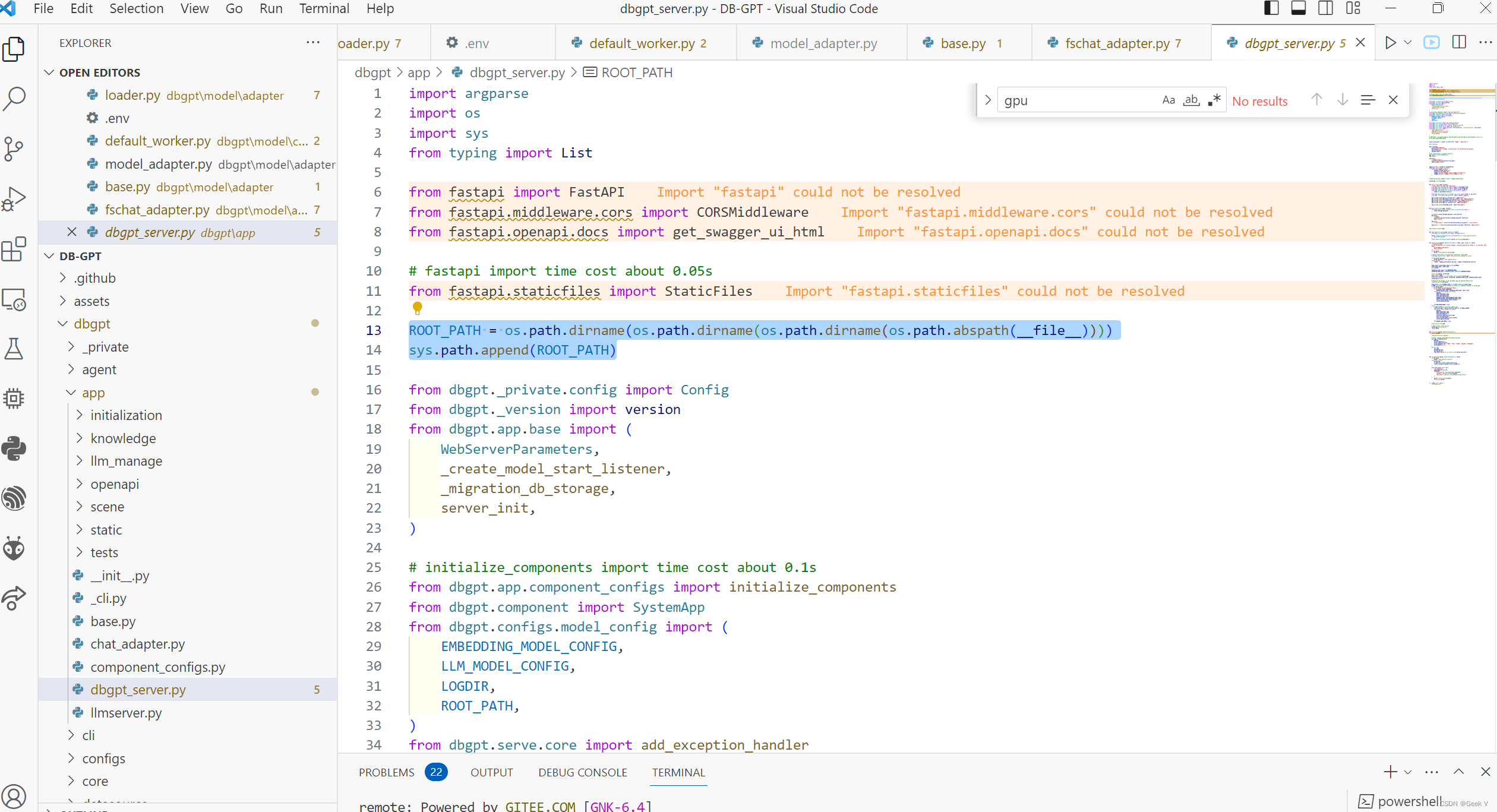

#### 源代码修改,就是把这两句代码提前到dbgpt模块导入

## 2、 数据库设置(docker + MySQL)

docker安装与mysql容器搭建就不详细说了

主要是数据迁移,有小坑

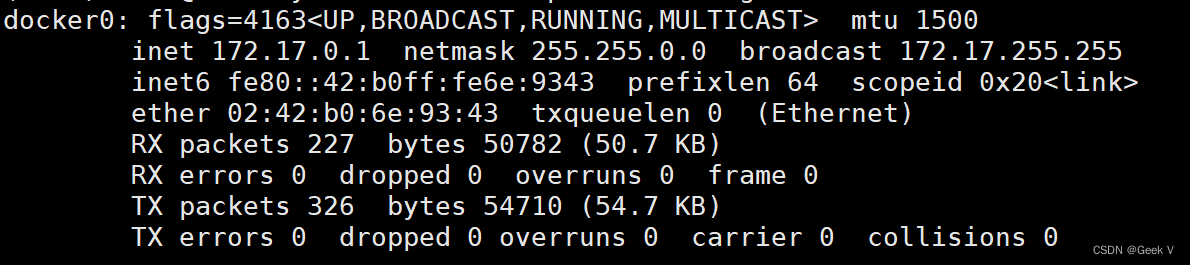

首先查看mysql服务地址

ifconfig

导入数据库

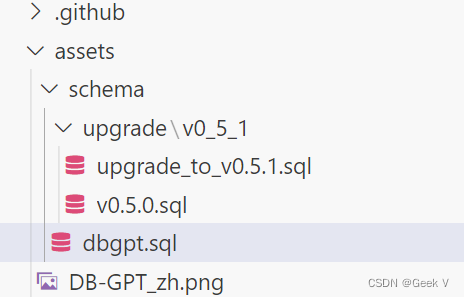

mysql -h 172.17.0.1 -u root -p < ./assets/schema/dbgpt.sql

由于代码更新需要修改数据库表结构,有一张表需要添加字段

mysql -u root -p -h 172.17.0.1

USE dbgpt;

ALTER TABLE dbgpt_serve_flow

ADD COLUMN error\_message varchar(512) null comment ‘Error message’ after state;

### 3、模型下载

请参照我的上一篇博客

[ChatGLM3-6B 多GPU、Linux环境部署遇到的问题以及解决方法]( )

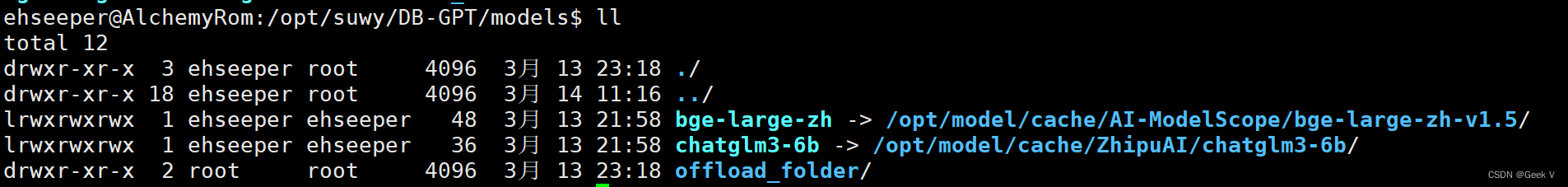

cd DB-GPT

mkdir models

ln -s /opt/model/cache/ZhipuAI/chatglm3-6b /opt/suwy/DB-GPT/models/chatglm3-6b

注意这个bge-large-zh不要加后缀,这个是写死在.env环境文件中的

ln -s /opt/model/cache/AI-ModelScope/bge-large-zh-v1.5 /opt/suwy/DB-GPT/models/bge-large-zh

### 4、.env环境文件修改

cp .env.template

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

3276

3276

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?