yolo.py:评估图像

yolo_video.py :评估视频

===============================================================

新建文件yolo_objectdetection.py

import the necessary packages

import numpy as np

import argparse

import time

import cv2

import os

image_path=‘11.jpg’

yolo=‘yolo_coco’

confidence_t=0.5

threshold=0.3

加载训练 YOLO 模型的 COCO 类标签

labelsPath = os.path.sep.join([yolo, “coco.names”])

LABELS = open(labelsPath).read().strip().split(“\n”)

初始化一个颜色列表来表示每个类标签

np.random.seed(42)

COLORS = np.random.randint(0, 255, size=(len(LABELS), 3),

dtype=“uint8”)

YOLO 对象检测

print(“[INFO] loading YOLO from disk…”)

config_path = ‘./yolo_coco/yolov3.cfg’

weights_path = ‘./yolo_coco/yolov3.weights’

net = cv2.dnn.readNetFromDarknet(config_path, weights_path)

导入包。

定义全局参数:

-

image_path:定义图片的路径。

-

yolo:定义模型存放的路径

-

confidence_t:过滤弱检测的最小概率。

-

threshold:非最大值抑制阈值。

接下来,加载了所有的类 LABELS。然后,为每个标签分配随机颜色。

加载权重文件。

加载我们的输入图像并获取其空间维度

image = cv2.imread(image_path)

(H, W) = image.shape[:2]

从输入图像构建一个blob,然后执行一个前向传播

通过 YOLO 对象检测器,输出边界框和相关概率

blob = cv2.dnn.blobFromImage(image, 1 / 255.0, (416, 416),

swapRB=True, crop=False)

net.setInput(blob)

start = time.time()

获取网络输出层信息(所有输出层的名字),设定并前向传播

outInfo = net.getUnconnectedOutLayersNames()

得到各个输出层的、各个检测框等信息,是二维结构。

layerOutputs = net.forward(outInfo)

加载输入图像并提取其尺寸。

从 YOLO 模型取出输出层名称。

构建一个 blob(第 48 和 49 行)。

cv2.dnn.blobFromImage(image[, scalefactor[, size[, mean[, swapRB[, crop[, ddepth]]]]]])

作用:

对图像进行预处理,包括减均值,比例缩放,裁剪,交换通道等,返回一个4通道的blob(blob可以简单理解为一个N维的数组,用于神经网络的输入)

参数:

- image:输入图像(1、3或者4通道)

可选参数

- scalefactor:图像各通道数值的缩放比例

- size:输出图像的空间尺寸,如size=(200,300)表示高h=300,宽w=200

- mean:用于各通道减去的值,以降低光照的影响(e.g. image为bgr3通道的图像,mean=[104.0, 177.0, 123.0],表示b通道的值-104,g-177,r-123)

- swapRB:交换RB通道,默认为False.(cv2.imread读取的是彩图是bgr通道)

- crop:图像裁剪,默认为False.当值为True时,先按比例缩放,然后从中心裁剪成size尺寸

- ddepth:输出的图像深度,可选CV_32F 或者 CV_8U.

通过我们的 YOLO 网络执行前向传递

显示 YOLO 的推理时间

接下来我们实现图像的可视化操作:

分别初始化检测到的边界框、置信度和类 ID 的列表

boxes = []

confidences = []

classIDs = []

循环输出

for output in layerOutputs:

遍历每个检测结果

for detection in output:

提取物体检测的类ID和置信度(即概率)

scores = detection[5:]

classID = np.argmax(scores)

confidence = scores[classID]

过滤精度低的结果

if confidence > confidence_t:

延展边界框坐标,计算 YOLO 边界框的中心 (x, y) 坐标,然后是框的宽度和高度

box = detection[0:4] * np.array([W, H, W, H])

(centerX, centerY, width, height) = box.astype(“int”)

使用中心 (x, y) 坐标导出边界框的上角和左角

x = int(centerX - (width / 2))

y = int(centerY - (height / 2))

更新边界框坐标、置信度和类 ID 列表

boxes.append([x, y, int(width), int(height)])

confidences.append(float(confidence))

classIDs.append(classID)

使用非极大值抑制来抑制弱的、重叠的边界框

idxs = cv2.dnn.NMSBoxes(boxes, confidences, confidence_t,

threshold)

确保至少存在一个检测

if len(idxs) > 0:

遍历我们保存的索引

for i in idxs.flatten():

提取边界框坐标

(x, y) = (boxes[i][0], boxes[i][1])

(w, h) = (boxes[i][2], boxes[i][3])

在图像上绘制一个边界框矩形和标签

color = [int© for c in COLORS[classIDs[i]]]

cv2.rectangle(image, (x, y), (x + w, y + h), color, 2)

text = “{}: {:.4f}”.format(LABELS[classIDs[i]], confidences[i])

cv2.putText(image, text, (x, y - 5), cv2.FONT_HERSHEY_SIMPLEX,

0.5, color, 2)

show the output image

cv2.imshow(“Image”, image)

cv2.waitKey(0)

初始化列表:

-

box :我们围绕对象的边界框。

-

置信度:YOLO 分配给对象的置信度值。 较低的置信度值表明对象可能不是网络认为的那样。 从上面的命令行参数中记住,我们将过滤掉不满足 0.5 阈值的对象。

-

classIDs :检测到的对象的类标签。

循环遍历每个 layerOutputs。

循环输出中的每个检测项。

提取 classID 和置信度。

过滤掉弱检测项。

到这里已经得到了高精度的检测项,然后:

延展边界框坐标,以便可以在原始图像上正确显示它们。

提取边界框的坐标和尺寸。 YOLO 以以下形式返回边界框坐标: (centerX, centerY, width, and height) 。

使用此信息计算出边界框的左上角 (x, y) 坐标。

更新 box 、 confidences 和 classIDs 列表。

然后使用NMS过滤冗余和无关的边界框。

接下主要将结果绘制到图片上。

运行结果:

===============================================================

现在我们已经学习了如何将 YOLO 对象检测器应用于单个图像,接下来尝试检测视频或者摄像头中的物体。

新建 yolo_video.py 文件并插入以下代码:

import numpy as np

import imutils

import time

import cv2

import os

yolo = ‘yolo_coco’

confidence_t = 0.5

threshold = 0.3

output = ‘output.avi’

导入需要的包

定义全局参数:

-

yolo:定义模型存放的路径

-

confidence_t:过滤弱检测的最小概率。

-

threshold:非最大值抑制阈值。

-

output:输出的视频结果

加载YOLO 模型训练的 COCO 类标签

labelsPath = os.path.sep.join([yolo, “coco.names”])

LABELS = open(labelsPath).read().strip().split(“\n”)

初始化颜色列表

np.random.seed(42)

COLORS = np.random.randint(0, 255, size=(len(LABELS), 3), dtype=“uint8”)

配置 YOLO 权重和模型配置的路径

weightsPath = os.path.sep.join([yolo, “yolov3.weights”])

configPath = os.path.sep.join([yolo, “yolov3.cfg”])

加载在 COCO 数据集(80 个类)上训练的 YOLO 对象检测,并获取YOLO输出层的名称

net = cv2.dnn.readNetFromDarknet(configPath, weightsPath)

获取网络输出层信息(所有输出层的名字),设定并前向传播

outInfo = net.getUnconnectedOutLayersNames()

初始化视频流、指向输出视频文件的指针和帧尺寸

vs = cv2.VideoCapture(0)

writer = None

(W, H) = (None, None)

获取文件的总帧数。

try:

prop = cv2.cv.CV_CAP_PROP_FRAME_COUNT if imutils.is_cv2() \

else cv2.CAP_PROP_FRAME_COUNT

total = int(vs.get(prop))

print(“[INFO] {} total frames in video”.format(total))

except:

print(“[INFO] could not determine # of frames in video”)

print(“[INFO] no approx. completion time can be provided”)

total = -1

这段代码的步骤:

读取类别。

给每个类别初始化颜色。

设置YOLO权重文件的路径。

加载YOLO权重文件。

获取输出层信息。

初始化VideoCapture对象。

初始化视频编写器和帧尺寸。

获取总帧数,以便估计处理整个视频需要多长时间。

loop over frames from the video file stream

while True:

从文件中读取下一帧

(grabbed, frame) = vs.read()

如果帧没有被抓取,那么已经到了流的末尾

if not grabbed:

break

如果框架尺寸为空,则给他们赋值

if W is None or H is None:

(H, W) = frame.shape[:2]

从输入帧构造一个 blob,然后执行 YOLO 对象检测器的前向传递,得到边界框和相关概率

blob = cv2.dnn.blobFromImage(frame, 1 / 255.0, (416, 416),

swapRB=True, crop=False)

net.setInput(blob)

start = time.time()

layerOutputs = net.forward(outInfo)

end = time.time()

分别初始化检测到的边界框、置信度和类 ID 的列表

boxes = []

confidences = []

classIDs = []

循环输出

for output in layerOutputs:

遍历每个检测结果

for detection in output:

提取物体检测的类ID和置信度(即概率)

scores = detection[5:]

classID = np.argmax(scores)

confidence = scores[classID]

过滤精度低的结果

自我介绍一下,小编13年上海交大毕业,曾经在小公司待过,也去过华为、OPPO等大厂,18年进入阿里一直到现在。

深知大多数Python工程师,想要提升技能,往往是自己摸索成长或者是报班学习,但对于培训机构动则几千的学费,着实压力不小。自己不成体系的自学效果低效又漫长,而且极易碰到天花板技术停滞不前!

因此收集整理了一份《2024年Python开发全套学习资料》,初衷也很简单,就是希望能够帮助到想自学提升又不知道该从何学起的朋友,同时减轻大家的负担。

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,基本涵盖了95%以上前端开发知识点,真正体系化!

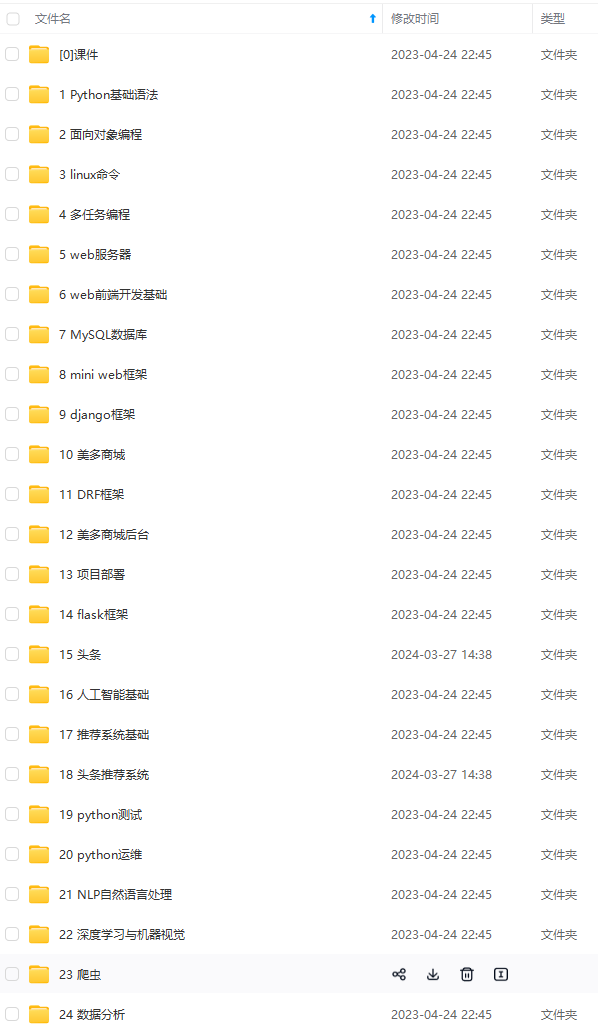

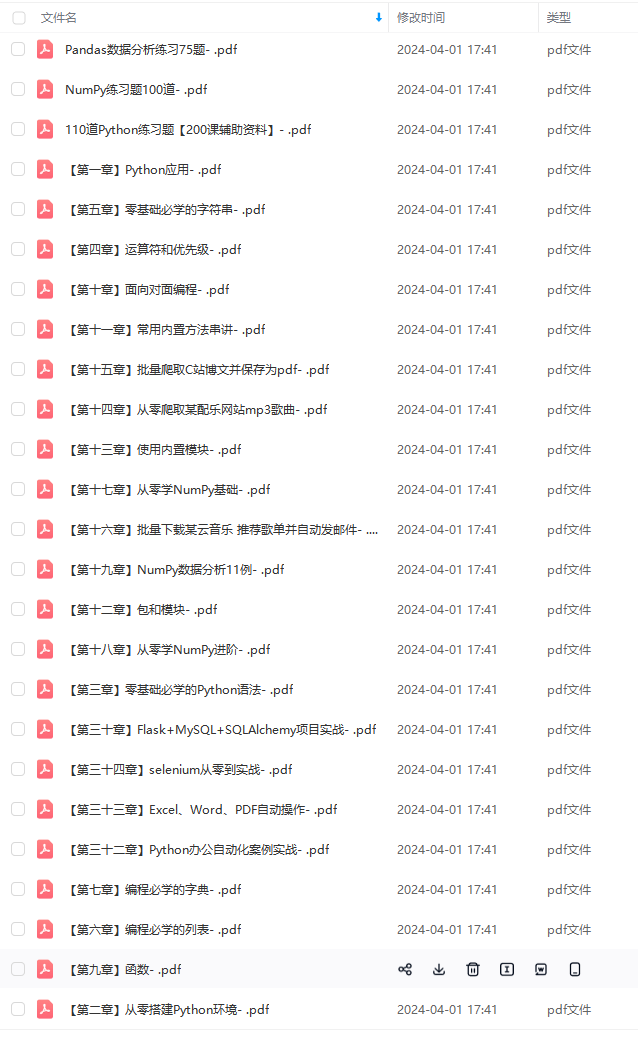

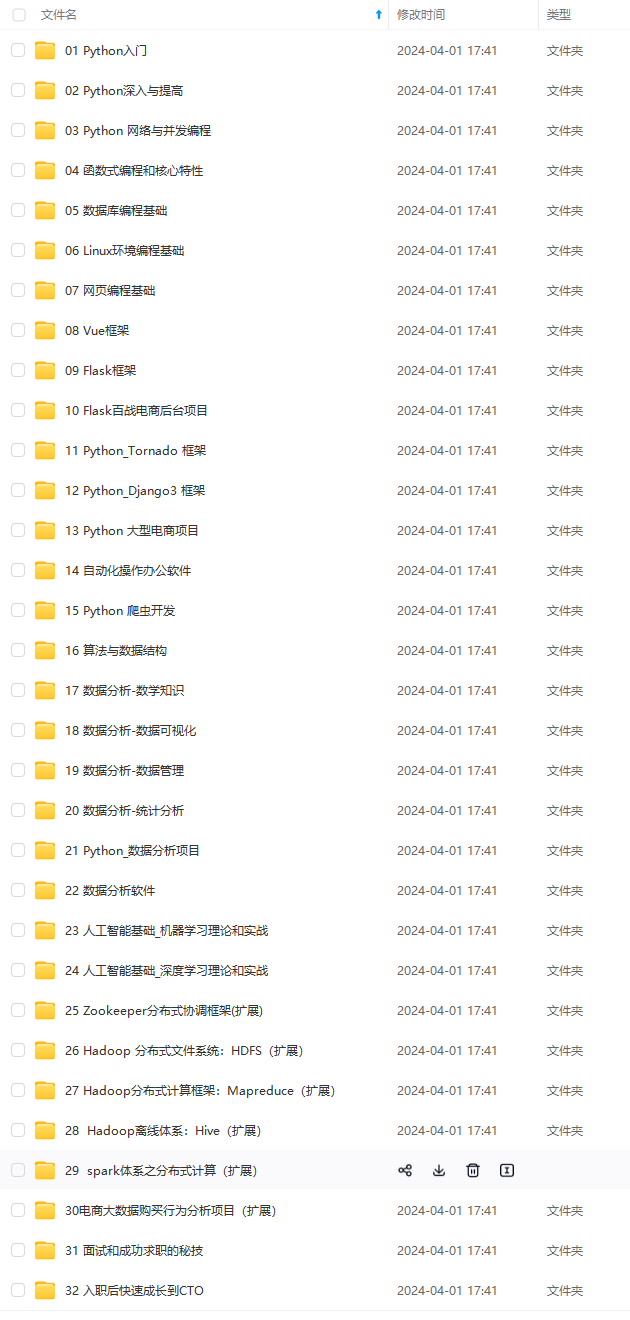

由于文件比较大,这里只是将部分目录大纲截图出来,每个节点里面都包含大厂面经、学习笔记、源码讲义、实战项目、讲解视频,并且后续会持续更新

如果你觉得这些内容对你有帮助,可以扫码获取!!!(备注:Python)

套学习资料》,初衷也很简单,就是希望能够帮助到想自学提升又不知道该从何学起的朋友,同时减轻大家的负担。**

[外链图片转存中…(img-gajgTbZ8-1713800681268)]

[外链图片转存中…(img-t3rDhFVL-1713800681269)]

[外链图片转存中…(img-AKWscmQW-1713800681270)]

[外链图片转存中…(img-flqXlm07-1713800681271)]

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,基本涵盖了95%以上前端开发知识点,真正体系化!

由于文件比较大,这里只是将部分目录大纲截图出来,每个节点里面都包含大厂面经、学习笔记、源码讲义、实战项目、讲解视频,并且后续会持续更新

如果你觉得这些内容对你有帮助,可以扫码获取!!!(备注:Python)

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?