GPT模型理解否定指令全攻略:从原理到实战(含ControlNet代码与工作流图解)

在AI生成内容(AIGC)爆发的时代,"让AI做什么"很容易,但"让AI不做什么"却成了人机协作的隐形门槛。无论是文本生成中规避冗余信息,还是图像创作中排除不想要的元素,GPT等大模型对"否定指令"的理解始终存在偏差。

本文将从实战角度,拆解GPT处理否定指令的痛点,详解ControlNet插件与脚本人设设计的解决方案,并附代码示例与可视化工作流,帮你精准控制AI生成结果。

一、为什么GPT总"听不懂"否定指令?

在实际业务中,我们常遇到这样的困境:

- 让GPT写商品描述时,反复强调"不要出现促销信息",结果依然夹杂折扣话术;

- 用Stable Diffusion生成产品图时,明确要求"不要背景杂乱",却总有多余元素干扰主体。

这并非模型能力不足,而是多数AI训练更侧重"正向指令理解"(即"要什么"),对"否定指令"(即"不要什么")的权重分配较弱。尤其在非文本生成场景(如图像)中,这种控制难题更明显——即使是Midjourney这样的优质模型,也常因无法精准识别"否定边界"导致结果可用性下降。

二、破局关键:ControlNet与脚本人设的双重控制

要让AI"听懂"否定,核心是建立"正向约束+反向排除"的双重机制。实践中,ControlNet插件和脚本人设设计是两种高效方案。

1. ControlNet:给图像生成装"刹车系统"

ControlNet是Stable Diffusion的强力插件,它能通过额外的控制参数,直接定义生成内容的"禁区"(即否定指令的具象化)。例如:

- 限制图像角度:"不要侧脸"→ 强制参数

angle: "front"; - 固定物体姿态:"不要弯腰"→ 强制参数

pose: "standing"; - 统一表情风格:"不要悲伤"→ 强制参数

expression: "neutral"。

2. 脚本人设:给GPT立"行为准则"

对于文本生成或长流程任务(如长图自动切割),通过设计脚本人设,可将否定指令转化为AI的"行为规则"。例如:

- 给GPT设定"图片切割助手"人设,明确"遇到水印必须裁剪"、“不要保留边缘模糊区域"等规则,替代模糊的"不要不好的部分”。

三、实战代码:用ControlNet参数控制生成结果

以下代码示例展示如何通过ControlNet参数,在图像生成中融入否定指令的正向转化(以Python伪代码为例):

# 图像生成函数(集成ControlNet控制逻辑)

def generate_controlled_image(prompt, control_net_constraints):

"""

prompt: 正向生成提示词(如"红色连衣裙商品图")

control_net_constraints: 否定指令转化的约束参数(如"不要杂乱背景"→"背景简洁")

"""

# 初始化Stable Diffusion生成器

generator = StableDiffusionGenerator()

# 应用ControlNet约束(核心:将否定指令转化为正向参数)

generator.set_control_net_params(

background=control_net_constraints.get("background", "simple"), # 否定"杂乱"→ 正向"简洁"

angle=control_net_constraints.get("angle", "45°俯拍"), # 否定"侧脸/仰拍"→ 正向固定角度

object_edges=control_net_constraints.get("object_edges", "clear") # 否定"模糊边缘"→ 正向"清晰"

)

# 生成并返回图像

return generator.generate(prompt)

# 实战调用:生成"无杂乱背景、边缘清晰的红色连衣裙图"

if __name__ == "__main__":

negation_to_constraints = {

"background": "simple", # 对应"不要杂乱背景"

"object_edges": "clear" # 对应"不要模糊边缘"

}

product_image = generate_controlled_image(

prompt="红色连衣裙,女性模特穿着",

control_net_constraints=negation_to_constraints

)

product_image.save("dress_clean.png")

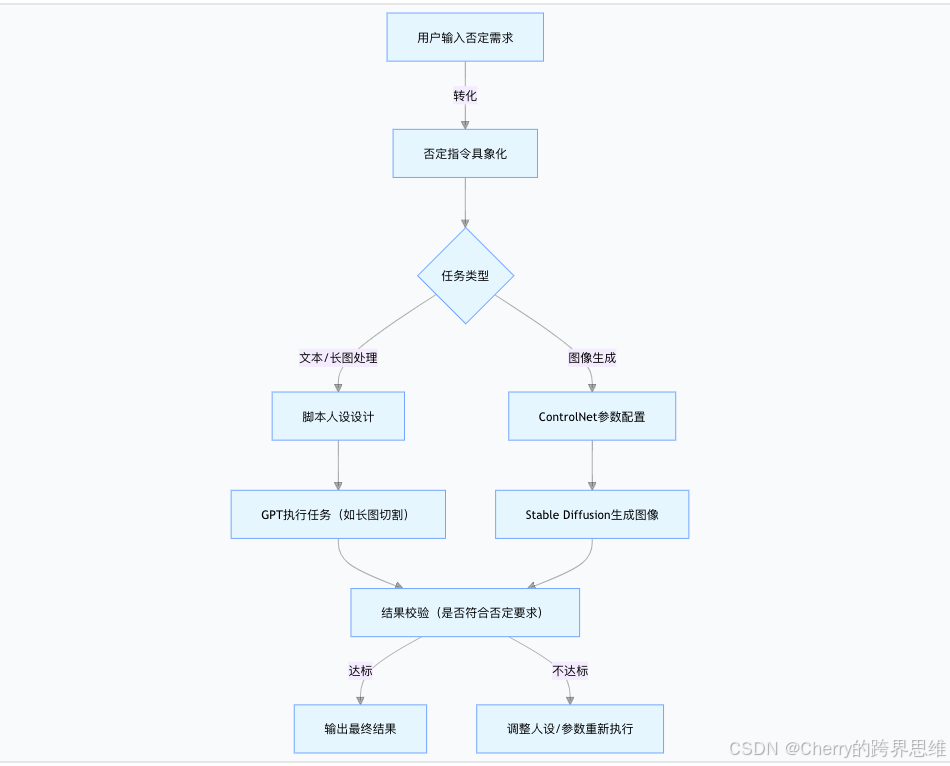

四、端到端工作流:从否定指令到精准结果

以下是"用户输入否定指令→AI生成精准结果"的完整流程(mermaid图解):

流程说明:

- 核心环节:将模糊的否定指令(如"不要乱")转化为具体约束(如"背景简洁");

- 分支处理:文本/长流程任务靠脚本人设,图像任务靠ControlNet参数;

- 闭环优化:通过结果校验反向调整约束,直到符合预期。

五、落地场景与行动建议

1. 典型应用场景

- 商品详情页自动化:用脚本人设让GPT自动切割商品图,排除水印、冗余背景;

- 邮件图片处理:通过ControlNet参数统一邮件附图的尺寸和背景,减少人工编辑;

- 文本生成优化:给GPT设定"报告撰写助手"人设,明确"不要口语化表达"等规则。

2. 行动指南

- 技术集成:在现有工作流中接入ControlNet插件(如Stable Diffusion WebUI),或用LangChain定义GPT脚本人设;

- 指令设计:避免模糊否定(如"不要错"),改用具体约束(如"数据必须与表格一致");

- 持续迭代:收集生成结果中的偏差案例,不断优化人设规则和ControlNet参数库。

总结

让AI理解否定指令,本质是从"模糊描述"到"精准控制"的跨越。通过ControlNet插件的参数约束和脚本人设的规则定义,我们能让GPT等模型既"知道要做什么",更"清楚不能做什么"。掌握这套方法,不仅能提升AIGC效率,更能解锁"人智协作"的新可能——毕竟,能精准踩刹车的AI,才是真正可控的生产力工具。

关键词:GPT否定指令处理、ControlNet插件实战、AI生成内容控制、脚本人设设计、Stable Diffusion参数优化

标签:#人工智能 #GPT调教 #AIGC实战 #ControlNet #自然语言处理

22万+

22万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?