本文提出了一个将大型模型先验集成到低级计算机视觉任务中的框架,该框架利用了灰度编码和通道扩展技术,将大模型先验知识集成到任何低级去雾网络中

Paper: https://arxiv.org/pdf/2306.15870.pdf

大型语言模型和高级视觉模型在大型数据集和模型大小上取得了令人印象深刻的性能改进。但是,低级计算机视觉任务,例如图像去雾和模糊去除,仍然依赖于少量数据集和小尺寸模型,这会导致过度拟合和局部最优。

这启发作者思考:如何将一个大型模型先验集成到低级计算机视觉任务中? 就像图像分割任务一样,雾度的降低也与纹理相关。因此,作者提出了灰度编码、网络通道扩展和预去雾三大结构的框架,以将大模型先验知识集成到任何低级去雾网络中。

通过不同的数据集和算法比较实验证明了大型模型在指导低级视觉任务方面的有效性和适用性。在不需要额外数据和训练资源的条件下,证明了大模型先验知识的集成将提高去雾性能并节省低级视觉任务的训练时间。

本文进行了如下工作:

- 作者发现大规模图像分割模型在去雾方面的能力,并证明这种能力并非来自数据集或训练过程本身,而是通过使用大规模数据集和大规模模型来实现;

- 为了加速小规模数据和小模型的低级视觉去雾任务中特定去雾结果的适应性,提出了一个新框架,该框架利用了灰度编码和通道扩展技术,将大模型先验知识集成到任何低级去雾网络中;

- 进行大量的实验,评估所提出方法的效果,并比较了不同雾场景下不同模型尺寸对最终去雾结果的影响。

背景知识

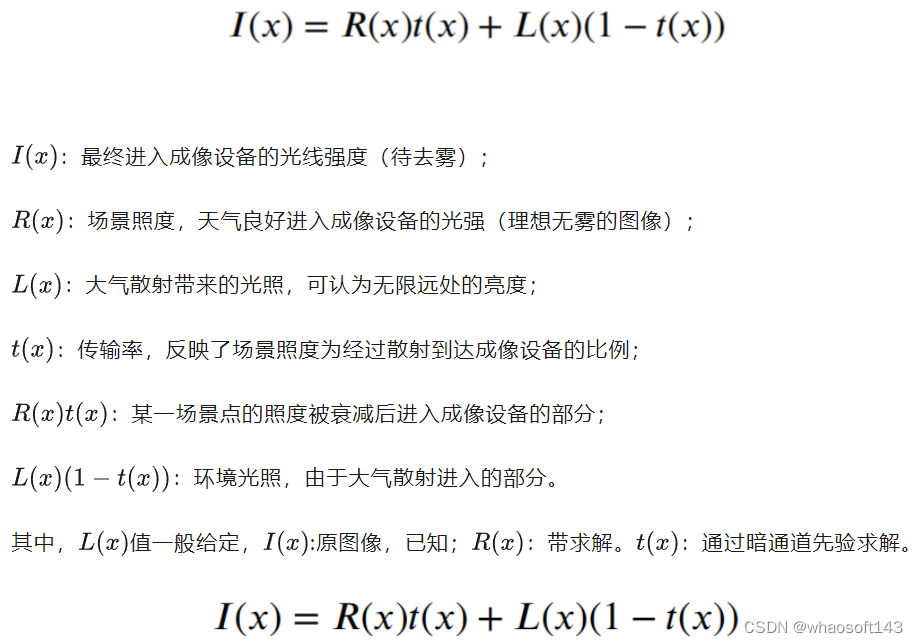

由于雾霾的形成具有一定的物理学理论基础,对图像质量的影响也是随着距离的增加而提升的。因此,传统的图像带雾模型公式如下:

求解推导示例

研究动机

去雾模型往往缺乏可靠的现实数据集,而且也很难针对不同的去雾任务单独训练不同的大型模型。作者希望能够通过大型图像分割模型来改进基于小模型和小数据的图像去雾网络,使得大型模型能够增强图像去雾的能力。

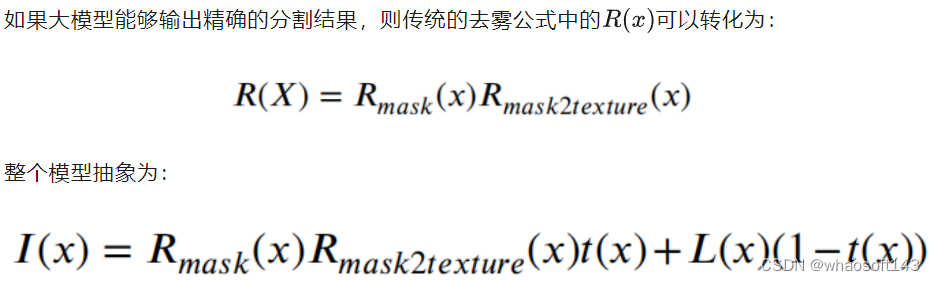

创新思路

本文方法

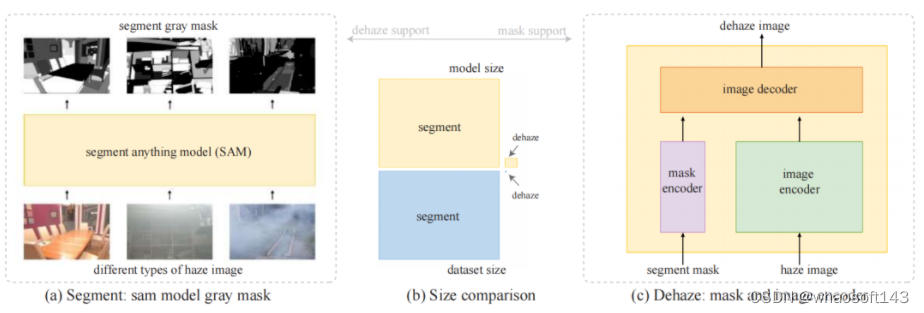

pipeline:将雾霾图像输入放入大规模分割模型中,并以灰度编码输出分割结果。通过利用大型模型的涌现能力,还可以处理以前没有训练过的雾霾图像。同时,无论是网络规模还是数据集规模,现有最大的去雾模型和分割大模型都相差几个数量级。最后,通过编码器-解码器结构将灰度编码分割掩模添加到图像去雾网络的编码器部分。

- 灰度编码

分割模型输出的是图像中每个像素的分割相对应的数字。分割一般用不同的颜色表示图像中不同类型的片段,这还需要转换为三个通道。为了增降低了后续去雾小模型的计算复杂性,作者在灰度通道上结合分割。大分割模型将图像中的所有目标分割出来,图像通常被分成许多部分。作者根据在去雾数据集上的实验,一张图像最多可以分割成130多个部分,而大多数图像的分割数在30到127之间。整个计算量非常大,对此,作者提出了一种灰度编码方法,将分割结果转换为灰度图像。优点是可以清楚地了解每个分割结果的输出顺序,较亮的区域表示分割较多,网络性能较好。

- 通道扩展

上面的操作将分割结果变为的灰度图像,而去雾图像的输入/出都是三通道的RGB图像,这里添加了一个灰度通道将分割的mask输入进去,从而将输入通道扩展到四个通道。输出通道仍然保持为三个通道。由此。网络编码器部分有一个额外的通道并且尺寸得到扩大,而解码器部分保持不变。

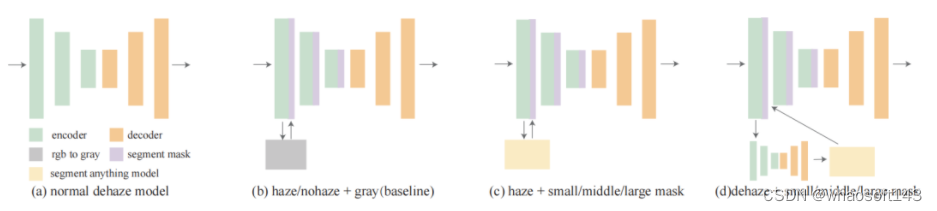

针对网络编码器的第四个通道,作者又提出了不同类型的网络结构,其中包括小型、中型和大型模型:

baseline是将带雾图像的灰度图直接作为mask然后输入到模型中,对应的理想情况是将无雾图像的灰度图作为mask输入模型。后面两个图意思是分别将有雾/无雾图像经过不同尺寸的模型分割后得到的mask输入到模型。这些情况用于评估分割网络性能、去雾训练和实际去雾测试。

关键实验结果

这里选择了涵盖室内室外、浓雾、稀雾、不均匀雾等各种场景的数据进行评估

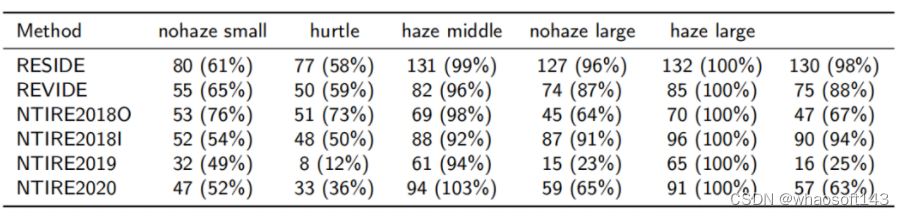

表Ⅰ

表Ⅰ比较了不同数据集下不同尺寸模型的分割性能,所有数据是分割网络对整个去雾数据集进行分割后每张图像的平均分割数,可以发现:

- 对于简单的雾场景来说,小分割模型足够;

- 中等难度的场景,增加模型尺度可以克服雾霾的副作用;

- 极其困难的雾场景,增加模型比例可以减轻雾霾的副作用。

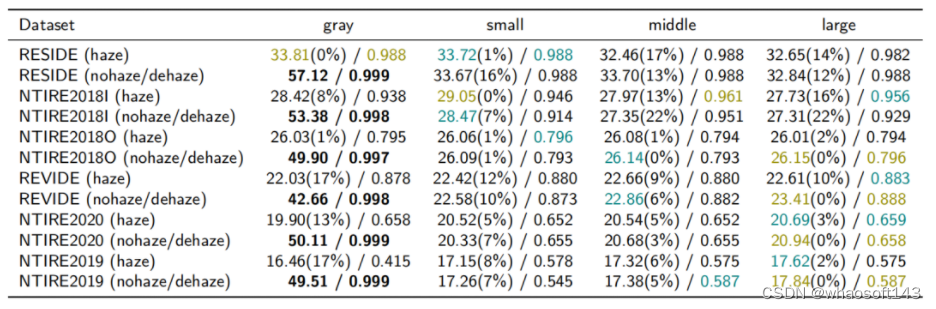

表Ⅱ

表Ⅱ比较了本文方法在不同雾度下的改进效果(数据集的难度从高到低,橄榄色代表最好的结果,青色代表第二好的结果),颜色结果呈对角分布,本文方法对于更困难的去雾数据集表现更好且改进更多,具体如下:

- 温和数据集上,本文方法可以提高1%到8%;

- 中等难度的去雾数据集,较大规模的分割网络很快会产生饱和效果,无法继续提供有效的纹理分割;

- 困难的场景中,本文方法可以提高 13% 到 17%,同时,分割模型规模的增加可以提高去雾性能。

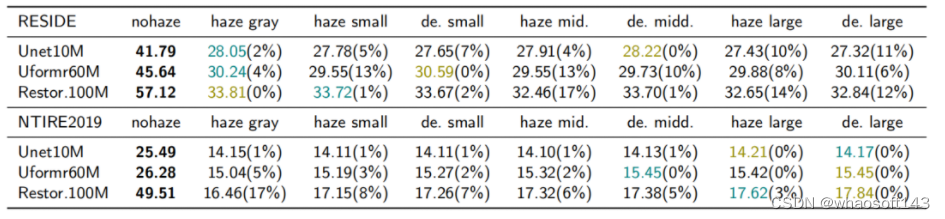

表Ⅲ

表Ⅲ探讨了不同规模模型的作用,同样有如下几点发现:

- 简单的去雾数据集:无论去雾网络的规模如何,分割掩模带来的改进并不明显;

- 复杂的雾霾场景:尺寸更大、更复杂、拟合能力更好的小尺度去雾模型往往可以学习到大规模分割网络的抗雾霾性能。更大规模的去雾模型可以更好地感知大规模分割模型的改进。

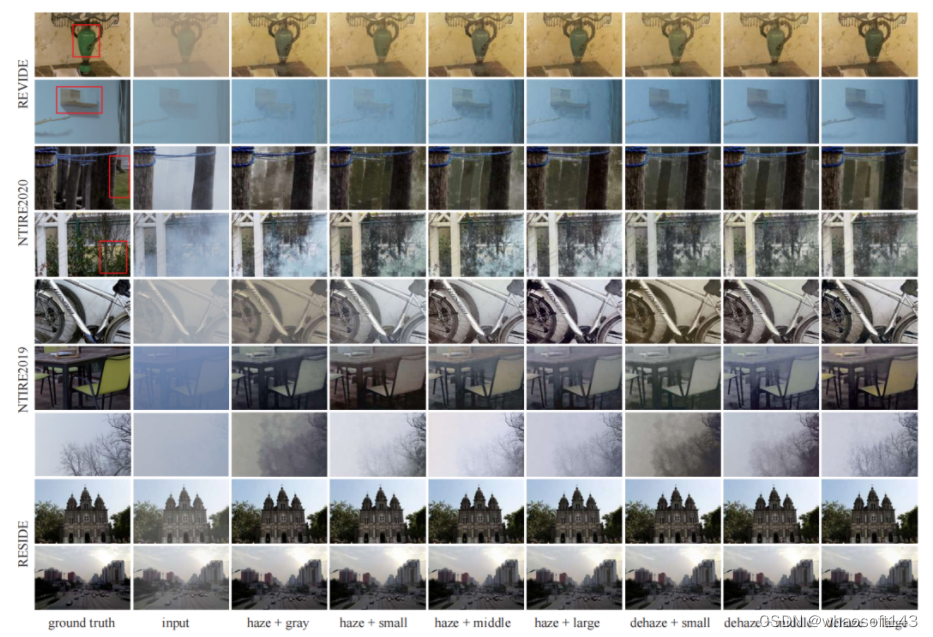

最后放上不同数据集上的去雾效果可视化对比:

本文的研究使得大型语义分割模型可以帮助小型去雾模型,即使小型模型无法进行大参数和大型模型的训练。使得小型模型能够享受大型模型的开发优势,而无需针对小型模型任务进行特定优化,是一个比较新奇的想法。更多研究细节请参阅原论文~~

1450

1450

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?