简介:该研究探讨如何通过大数据分析技术预防和管理高校学生心理危机,构建智能服务体系。通过整合学生多维度数据源,利用机器学习和自然语言处理技术识别心理风险,并实现实时监测与快速响应。研究强调隐私保护,提出建立用户反馈机制,以优化心理健康服务和提升干预效果。

1. 高校心理危机智能预警系统构建

1.1 系统构建的意义和必要性

在现代社会的快节奏背景下,高校学生的心理健康问题日益凸显,心理危机的预防和干预显得尤为重要。构建一个智能预警系统,能够实时监控学生的行为和心理状态,及时发现潜在的心理风险,并进行有效干预,对于高校维护学生心理健康、构建和谐校园环境具有重要意义。

1.2 系统的主要功能和作用

该智能预警系统主要包括数据收集、处理和分析,学生行为和心理状态的数据整合,心理风险的识别和预警,以及用户反馈和服务优化等功能。通过这些功能,系统可以对学生进行全方位的监测和评估,及时发现和预警心理风险,为高校提供科学的决策依据。

1.3 系统的技术路线和实现方式

智能预警系统的构建需要利用先进的信息技术,如数据挖掘、机器学习、自然语言处理等技术,对大量学生行为和心理状态的数据进行深度分析,发现潜在的风险。同时,还需要建立实时监测和快速响应机制,确保预警信息能及时传达给相关人员,实现对心理危机的有效预防和干预。

2. 数据收集、处理和分析的重要性

2.1 数据收集的策略和方法

2.1.1 校园网数据的采集技术

校园网数据的采集是构建高校心理危机智能预警系统的第一步,而数据的来源主要来自于学生在校园网内的各项活动记录。具体的数据采集技术包括但不限于:

- 日志记录 :记录用户访问校园网服务的详细情况,如时间戳、访问页面、操作行为等。

- 流量分析 :通过分析校园网的流量数据,了解学生网络使用习惯和偏好。

- IP追踪 :记录特定IP地址的活动,辅助构建学生的行为模式。

数据采集过程中,需确保采集工具的高效性和准确性,同时也要注意对用户隐私的保护。

import scapy.all as scapy

def capture_packets(interface):

# 使用Scapy工具捕获指定网络接口的数据包

packets = scapy.sniff(iface=interface, count=10)

# 对捕获的数据包进行处理

for packet in packets:

print(packet.summary())

capture_packets("eth0") # "eth0"为假定的网络接口名称

上述Python代码使用了Scapy库来捕获网络接口"eth0"上的数据包。在实际应用中,需要对数据包进行解析和处理,从中提取有用信息。

2.1.2 学生行为日志的获取途径

学生行为日志是了解学生日常行为的关键数据源,其获取途径包括:

- 教学管理系统 :学生登录、在线作业提交、成绩查询等行为记录。

- 图书馆借阅系统 :借阅记录、图书偏好、阅读习惯等。

- 宿舍门禁系统 :进出记录,可以反映学生的作息时间和社交活动。

这些日志数据通常以结构化的形式存储,便于后续的分析处理。

{

"student_id": "***",

"login_time": "2023-01-01T10:00:00Z",

"activity": "submitted homework",

"course_id": "CS101",

"grade": null

}

如上所示,JSON格式是存储日志数据的常见方式之一,通过解析此类数据可以对学生的日常行为进行分析。

2.2 数据处理的关键技术

2.2.1 数据清洗和预处理步骤

数据清洗和预处理是确保数据质量的重要环节,主要包括:

- 去除重复数据 :重复记录可能导致分析结果偏差。

- 填补缺失值 :缺失数据可能影响分析的准确性。

- 异常值处理 :异常数据需要特别注意,分析其原因并决定是否保留或修正。

数据清洗后,将进行预处理以适合后续的分析模型,比如:

- 数据标准化 :使数据具有相同的量纲,便于比较。

- 数据归一化 :将数据缩放到[0,1]区间,适用于某些算法。

UPDATE student_behavior_log

SET grade = NULL

WHERE grade = 'N/A'; -- 填补缺失的成绩数据

DELETE FROM student_behavior_log

WHERE timestamp < '2022-01-01'; -- 删除异常早的数据记录

数据库操作通过SQL脚本实现数据清洗和预处理。

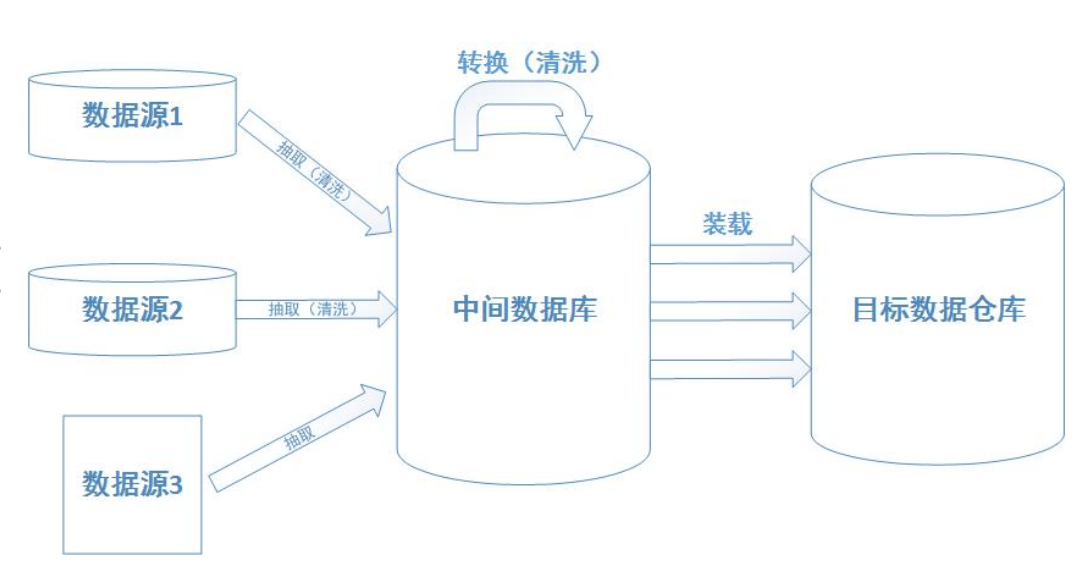

2.2.2 数据整合与格式统一

数据整合是将来自不同来源的数据融合在一起,为分析做准备。整合的过程可能包括:

- 数据合并 :将多个数据集按照共同的键值进行合并。

- 数据转换 :将数据转换为统一格式,比如日期格式、数值格式等。

数据整合后,需确保数据格式统一,以便进行有效的数据分析。

import pandas as pd

# 读取两个数据集

df1 = pd.read_csv('student_grades.csv')

df2 = pd.read_csv('student_library_usage.csv')

# 合并数据集,假设两个文件中都有student_id字段用于关联

merged_df = pd.merge(df1, df2, on='student_id')

上述代码使用Pandas库合并了两个CSV文件中的学生数据。

2.3 数据分析的理论基础和实践应用

2.3.1 数据挖掘的基本方法

数据挖掘是从大量数据中提取有用信息和知识的过程。其基本方法包括:

- 分类 :将数据分为不同的类别,比如高风险和低风险学生。

- 聚类 :将数据分为不同的群组,寻找相似的数据点。

- 关联规则挖掘 :发现不同变量之间的有趣关系。

数据挖掘方法的选择依赖于分析目标和数据特性。

from sklearn.cluster import KMeans

# 假设df是已经预处理好的学生行为数据DataFrame

kmeans = KMeans(n_clusters=3)

kmeans.fit(df)

# 将数据点分配到3个群组中

df['cluster'] = kmeans.labels_

上述代码利用了KMeans算法对数据进行聚类分析。

2.3.2 用统计学方法识别行为模式

统计学方法是数据分析中不可或缺的一部分,常见的统计学方法包括:

- 描述性统计 :通过均值、方差等描述数据集的特征。

- 推断性统计 :利用样本数据推断总体特征。

- 假设检验 :测试某些假设是否成立。

这些方法在识别学生的行为模式、心理状态等方面有重要应用。

# R语言进行描述性统计分析

summary(student_scores)

上述R代码对学生的成绩数据进行了描述性统计分析,帮助我们理解数据集的基本特征。

在后续章节中,我们将深入探讨数据整合、分析以及在此基础上构建的智能预警系统。通过这些章节的内容,我们希望为读者提供一个全面的视角,理解数据如何被收集、处理、分析,并转化为对高校心理健康工作有实际帮助的智能预警功能。

3. 学生行为和心理状态的数据整合

3.1 行为数据与心理状态的关联分析

3.1.1 学习和生活行为的量化研究

在高校心理危机智能预警系统的构建中,量化学生的学习和生活行为是至关重要的。通过收集和分析学生的在线学习行为、课后活动参与度、社交网络使用情况等数据,可以发现与心理状态有关的模式和趋势。

数据采集示例代码块 :

import pandas as pd

# 假设我们有一组学生的学习活动日志

# 日志数据包含学生ID、活动名称、活动开始时间、活动结束时间等字段

activity_log = pd.read_csv('student_activity_log.csv')

# 定义一个函数来计算学生在某段时间内的活动总量

def calculate_activity_volume(log, start_date, end_date):

filtered_log = log[(log['start_time'] >= start_date) & (log['end_time'] <= end_date)]

return filtered_log.groupby('student_id')['activity_name'].count()

# 计算某个月内学生参与活动的总数

activity_volume = calculate_activity_volume(activity_log, '2023-01-01', '2023-01-31')

参数说明 :该代码中的 calculate_activity_volume 函数计算特定时间段内每个学生参与活动的次数。输入参数 log 是学生的行为日志, start_date 和 end_date 定义了分析的时间范围。

逻辑分析 :通过对这些数据的定量分析,可以发现一些关键行为指标,如课外活动参与度高与心理压力低之间可能存在的正相关关系。这有助于构建一个更完整的模型来预测和评估学生可能面临的心理压力。

3.1.2 心理状态特征的指标体系

为了构建有效的心理状态指标体系,我们可以从多个维度进行考量,例如情绪波动、睡眠质量、社交互动等。这需要结合学生行为日志中的数据和专业的心理健康评估工具,将定量数据和定性信息相结合。

构建指标体系的表格示例 :

| 心理状态指标 | 描述 | 数据来源 | 数据类型 | | --- | --- | --- | --- | | 情绪稳定性 | 情绪波动频率和幅度 | 心理健康问卷、社交媒体分析 | 定量、定性 | | 睡眠质量 | 睡眠时长、入睡时间和起床时间 | 睡眠追踪设备、日志数据 | 定量 | | 社交互动频率 | 社交平台上的互动次数 | 社交媒体日志 | 定量 |

数据来源说明 :通过整合不同来源的数据,我们可以构建一个综合的学生心理状态指标体系。该体系可以为学生提供个性化的心理健康评估和预警。

3.2 构建学生心理档案数据库

3.2.1 电子健康记录在心理预警中的作用

电子健康记录(EHR)为学生提供了一个综合性的心理健康档案。通过整合学生的体检数据、心理测评结果和行为日志等信息,可以建立起一个全面反映学生健康状况的数据库。

电子健康记录数据表示例 :

CREATE TABLE student_ehr (

student_id INT PRIMARY KEY,

health_record_id INT,

physical_exam_date DATE,

psychological_exam_date DATE,

last_update TIMESTAMP

);

表结构说明 :这个表格设计用于存储学生的电子健康记录信息。每一行包含了学生的ID、健康记录的ID、体检日期、心理评估日期和记录的最后更新时间。这个数据库可以被用作长期跟踪学生健康状态的重要工具。

3.2.2 多维度数据的存储与管理

为了有效地存储和管理多维度的数据,系统需要一个高效的数据管理系统。数据库设计需要考虑数据的完整性、一致性和安全性。

数据管理流程图示例 (使用mermaid格式):

graph LR

A[开始] --> B[需求分析]

B --> C[数据库设计]

C --> D[数据模型建立]

D --> E[数据导入]

E --> F[数据维护]

F --> G[安全审计]

G --> H[结束]

流程图说明 :上述流程图展示了多维度数据管理的全过程。从需求分析开始,经过数据库设计、数据模型建立、数据导入和维护,再到安全审计,最终完成整个数据管理流程。

3.3 利用数据挖掘发现潜在风险

3.3.1 聚类分析在识别高风险群体中的应用

聚类分析是一种无监督学习方法,可以通过分析学生的行为数据、心理健康评估结果等信息,将学生分为不同的风险群体。

聚类分析代码块示例 :

from sklearn.cluster import KMeans

import numpy as np

# 假设我们有一个包含多个心理健康指标的数据集

mental_health_data = np.array([

[1.5, 3.5, 2.0, ...], # 学生1的数据

[1.0, 2.0, 1.5, ...], # 学生2的数据

...

])

# 应用KMeans聚类算法

kmeans = KMeans(n_clusters=3)

kmeans.fit(mental_health_data)

# 分析聚类结果

clusters = kmeans.labels_

参数说明 :在上述代码中, mental_health_data 包含了学生的多个心理健康指标, KMeans 是聚类算法, n_clusters 定义了我们期望将数据分为多少个群体。

逻辑分析 :通过聚类分析,我们可以发现学生群体中存在哪些潜在的风险群体,从而有针对性地提供干预措施。

3.3.2 关联规则挖掘技术在预测中的角色

关联规则挖掘是数据挖掘领域中的一项技术,常用于市场篮子分析等场景。在学生心理预警系统中,我们可以利用此技术发现不同心理状态指标之间的相关性。

关联规则挖掘代码块示例 :

from mlxtend.frequent_patterns import apriori

from mlxtend.preprocessing import TransactionEncoder

# 假设我们有一个包含心理评估结果的数据集

mental_assessment_data = [

['焦虑', '抑郁'],

['焦虑', '孤独'],

['孤独', '失眠'],

...

]

# 使用TransactionEncoder进行转换

te = TransactionEncoder()

te_ary = te.fit(mental_assessment_data).transform(mental_assessment_data)

df = pd.DataFrame(te_ary, columns=te.columns_)

# 应用Apriori算法找出频繁项集

frequent_itemsets = apriori(df, min_support=0.5, use_colnames=True)

参数说明 :在此代码块中, mental_assessment_data 是包含学生心理评估结果的数据集, apriori 是用于发现频繁项集的算法, min_support 定义了项集的最小支持度。

逻辑分析 :通过关联规则挖掘,我们可以发现某些心理健康指标之间的关联性,比如焦虑和抑郁经常一起出现。这样的信息对于建立有效的预警模型是非常有价值的。

通过上述三个子章节的分析和应用实例,我们可以看到学生行为和心理状态的数据整合不仅需要精确的数据收集与分析技术,还需要结合心理学的理论知识,才能更准确地识别潜在的心理风险。接下来的章节将探讨如何利用机器学习模型来进一步提高心理预警系统的准确性和效率。

4. 机器学习在识别心理风险中的应用

4.1 机器学习模型的构建与训练

4.1.1 选择合适的机器学习算法

在构建心理风险识别系统时,选择适当的机器学习算法是关键步骤。对于心理风险预测,我们需要解决的问题通常可以归类为分类问题,其中模型需要区分高风险和低风险个体。常用的算法包括:

- 逻辑回归(Logistic Regression)

- 支持向量机(Support Vector Machine, SVM)

- 决策树(Decision Trees)

- 随机森林(Random Forest)

- 梯度提升树(Gradient Boosting Trees)

- 神经网络(Neural Networks)

逻辑回归算法简单且易于实现,适用于特征数量不多的情况。SVM 在高维空间中具有良好的性能,尤其适用于非线性边界的数据。决策树是基于规则的模型,易于理解和解释。随机森林是决策树的集成方法,可以有效减少过拟合并提高准确率。梯度提升树则是通过逐步添加树来最小化损失函数。神经网络能够捕捉复杂的非线性关系,适用于大数据集。

在选择算法时,除了考虑模型的预测性能之外,还需要考虑其解释性和计算复杂度。例如,对于需要解释性较高的应用场合,决策树或逻辑回归可能更适合;而对于要求最高预测精度的应用,则可能偏向于选择集成学习方法或深度学习模型。

4.1.2 数据集的划分与模型的交叉验证

一旦选定了机器学习算法,下一步是准备数据并划分数据集。数据集通常分为训练集、验证集和测试集。训练集用于构建模型,验证集用于选择模型参数和调整模型结构,测试集用于评估模型性能。

数据划分常用的方法有:

- 单次划分(Holdout)

- k折交叉验证(k-Fold Cross-Validation)

- 留一法(Leave-One-Out Cross-Validation)

k折交叉验证是最常用的方法之一。在这种方法中,原始数据被随机分为k个子集,每个子集轮流作为验证集,其余k-1个子集作为训练集。通过k次训练和验证,最终取平均值作为评估指标,这样可以更可靠地评估模型性能。

代码示例:使用Python中的scikit-learn库进行k折交叉验证。

from sklearn.model_selection import cross_val_score

from sklearn.linear_model import LogisticRegression

from sklearn.datasets import load_iris

from sklearn.model_selection import KFold

# 加载数据集

iris = load_iris()

X, y = iris.data, iris.target

# 创建逻辑回归模型实例

logreg = LogisticRegression()

# 设置k折交叉验证的折数

kfold = KFold(n_splits=10, shuffle=True, random_state=1)

# 计算并输出交叉验证的平均准确率

cv_scores = cross_val_score(logreg, X, y, cv=kfold)

print(cv_scores.mean())

参数说明: - n_splits=10 :表示将数据集分为10份。 - shuffle=True :表示在每次划分前随机打乱数据,以减少偏差。 - random_state=1 :为随机数生成设置种子,使得结果可重复。

4.1.3 特征选择与数据降维

在机器学习中,特征选择和数据降维是提高模型性能的重要手段。好的特征不仅能提高模型的预测能力,还能减少训练时间,防止过拟合。

特征选择方法包括:

- 基于模型的特征选择(如递归特征消除)

- 基于过滤的特征选择(如使用相关系数、卡方检验等)

- 嵌入式特征选择(如使用L1正则化的线性模型)

数据降维技术主要包括主成分分析(PCA)、线性判别分析(LDA)等。它们通过映射原始数据到较低维的空间,保留最重要的信息。

4.1.4 模型训练的实现

在选择了机器学习算法并准备了数据集之后,下一步是实际训练模型。以下是一个逻辑回归模型训练的代码示例。

from sklearn.linear_model import LogisticRegression

from sklearn.model_selection import train_test_split

from sklearn.datasets import make_classification

# 创建模拟数据集

X, y = make_classification(n_samples=1000, n_features=20, n_classes=2, random_state=42)

# 划分训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

# 创建逻辑回归模型实例

model = LogisticRegression()

# 训练模型

model.fit(X_train, y_train)

# 预测测试集

predictions = model.predict(X_test)

# 计算准确率

accuracy = model.score(X_test, y_test)

print(f'Accuracy: {accuracy}')

逻辑回归模型通过 fit 方法训练,该方法接受训练集数据和标签,并进行模型优化。训练完成后,使用 predict 方法对测试集进行预测,并通过 score 方法计算准确率。

在这一小节中,我们详细讨论了构建机器学习模型的初步步骤,从选择合适的算法到数据集的划分和模型训练的实现。接下来我们将进一步探讨模型评估和优化的方法。

5. 自然语言处理技术分析学生文字情绪

在心理危机智能预警系统中,自然语言处理(NLP)技术可以扮演至关重要的角色。通过分析学生在社交媒体、论坛、作业或反馈系统中的文字,可以洞察他们的情绪状态,从而及时发现潜在的心理风险。本章节将详细探讨如何利用自然语言处理技术分析学生文字情绪,并提供应用实践与效果评估。

5.1 文字情绪分析的理论与方法

5.1.1 情绪词典和情感分析模型

情绪词典是基于预定义的情绪词汇集,每个单词都与特定的情感值相关联,通常分为正面、负面和中性。在分析学生文字时,可以使用情绪词典来判断文本的整体情感色彩。

情感分析模型(又称为情感分类模型)使用机器学习算法,通过大量的带情绪标签的文本数据进行训练。这些模型可以更精细地区分文本中的情感倾向,例如快乐、悲伤、愤怒、惊讶等。

5.1.2 深度学习在情绪识别中的应用

深度学习通过构建复杂的神经网络模型,如卷积神经网络(CNN)和循环神经网络(RNN),可以更准确地捕捉文本中的情感信号。特别是长短期记忆网络(LSTM)和Transformer架构在处理序列数据方面表现出色,对于理解情感的上下文信息和复杂表达具有优势。

5.2 文本数据的预处理与特征提取

5.2.1 分词、去停用词与词性标注

中文文本情绪分析首先需要进行分词处理,即将连续的文本分割为有意义的词汇。接着,要去除停用词,即那些对情感分析贡献较小的常用词。词性标注则帮助我们了解每个词在句子中的语法作用,这对于理解语句的情绪色彩至关重要。

5.2.2 词向量与文本特征的表示

词向量(如Word2Vec、GloVe)可以将文本中的词汇转换为数值化的向量形式,捕捉语义信息。在情感分析中,这些向量可以用来表示整个文本的特征。深度学习模型通常直接使用这些向量作为输入,来预测文本的情绪倾向。

5.3 应用实践与效果评估

5.3.1 社交媒体文本情绪分析案例

在实际应用中,可以通过社交媒体API采集学生发表的文本内容。之后,利用预先训练好的情感分析模型进行情绪分类。例如,可以对学生的推文进行正面或负面情绪的标记,并结合时间序列分析,来监控情绪的波动情况。

5.3.2 效果评估与改进策略

为了评估情绪分析的效果,可以采取多种方法。首先,通过交叉验证来估计模型的准确率、召回率和F1分数。此外,人工标注一部分数据,以此作为基线对模型的输出进行评估。还可以通过A/B测试,对比不同模型或特征处理方法的性能差异。

针对评估结果,可以不断优化模型结构和参数,或者引入新的特征,例如结合时间、地点等上下文信息。同时,也可以探索集成学习方法,通过结合多个模型的预测结果来提高整体的分析准确度。

通过上述内容,我们不仅了解了自然语言处理技术在学生文字情绪分析中的应用,还掌握了如何进行有效的文本预处理、特征提取和模型评估。随着技术的不断演进,这一领域的应用前景将更加广阔,有助于高校更加精准地实施心理危机预防和干预措施。

简介:该研究探讨如何通过大数据分析技术预防和管理高校学生心理危机,构建智能服务体系。通过整合学生多维度数据源,利用机器学习和自然语言处理技术识别心理风险,并实现实时监测与快速响应。研究强调隐私保护,提出建立用户反馈机制,以优化心理健康服务和提升干预效果。

1211

1211

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?