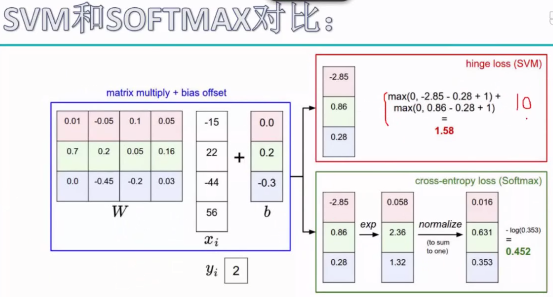

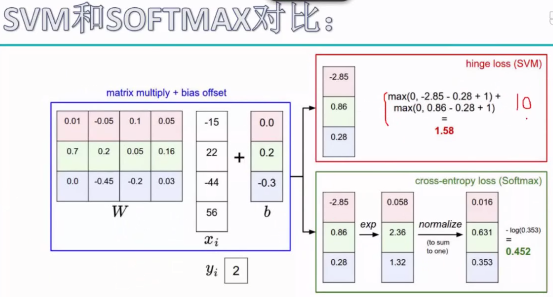

SVM输出的是一个得分值;

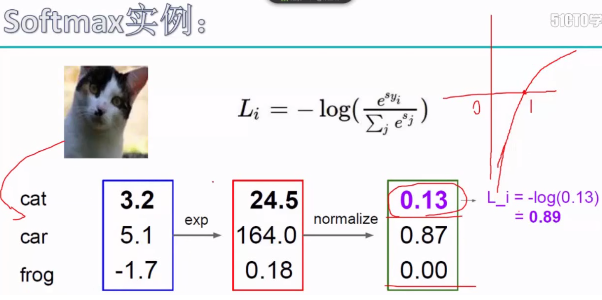

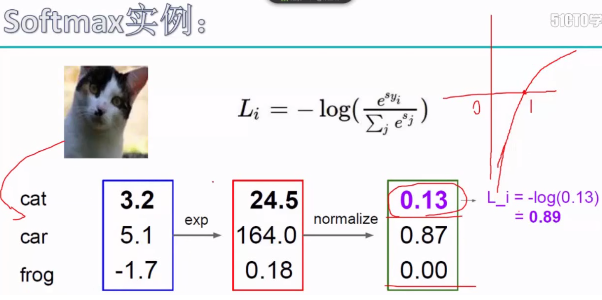

Softmax的输出是概率。

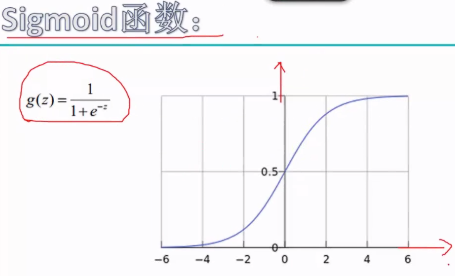

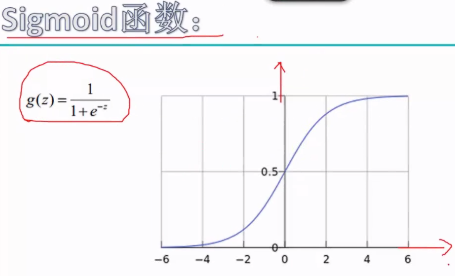

Sigmoid函数

损失函数计算的是判断正确时的概率的损失值,所以这里是0.13。

Softmax分类器对任何一个分数都可以求出一个损失值。

SVM输出的是一个得分值;

Softmax的输出是概率。

Sigmoid函数

损失函数计算的是判断正确时的概率的损失值,所以这里是0.13。

Softmax分类器对任何一个分数都可以求出一个损失值。

转载于:https://www.cnblogs.com/zzx1905/p/Softmax.html

1977

1977

1149

1149

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?