从社区拿一个模型,比如以下这个链接 https://www.modelscope.cn/models/iic/cv_mobilenet-v2_bad-image-detecting

它的代码样例如下

from modelscope.pipelines import pipeline

from modelscope.utils.constant import Tasks

from modelscope.outputs import OutputKeys

img = 'https://modelscope.oss-cn-beijing.aliyuncs.com/test/images/dogs.jpg'

test_pipeline = pipeline(Tasks.bad_image_detecting, 'damo/cv_mobilenet-v2_bad-image-detecting')

result = test_pipeline(img)

print(result)怎么在自己电脑环境中运行起来?

前期准备

首先安装一个Python环境,选最新版本安装就好了,然后把Python配置到环境变量。

按照官方文档的说法,需要安装一个conda环境,这里建议是安装一个miniconda版本,链接 Miniconda — Anaconda documentation

如果想要在cmd命令行使用,还可以将安装路径miniconda3\condabin配置到环境变量

最后在控制台输入 conda -V,能顺利显示版本号说明成功了。

C:\Users\Admin>conda -V

conda 24.5.0创建一个conda环境

注意官方文档推荐使用python版本是3.8(如果提示没有权限Permission denied,那么使用管理员身份运行)

conda create --name modelscope python==3.8通过 conda info -e检查是否存在modelscope环境

C:\Windows\System32>conda info -e

# conda environments:

#

base C:\ProgramData\miniconda3

modelscope C:\ProgramData\miniconda3\envs\modelscope在PyCharm使用conda环境

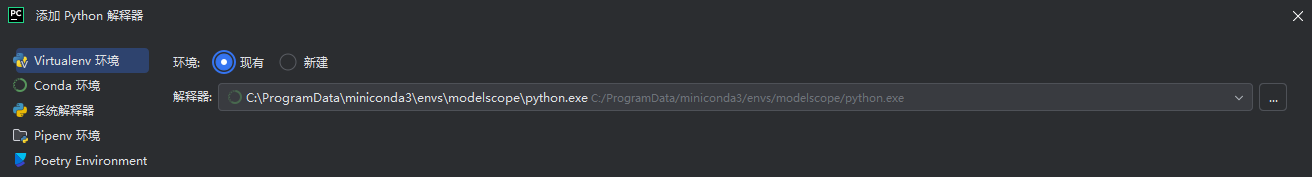

添加Python解释器 - Virtualenv环境,选择miniconda3\envs\modelscope下的Python.exe

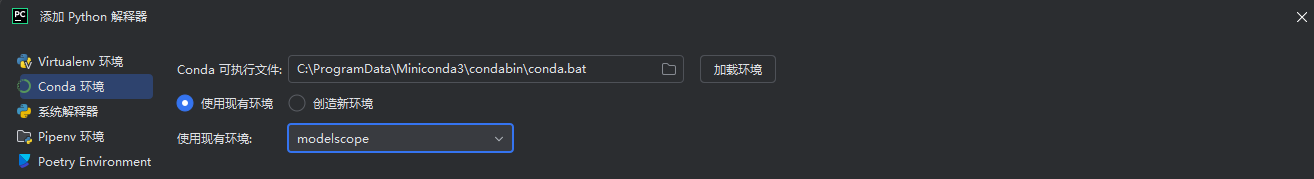

其次配置Conda环境,选择现有环境modelscope

如果以上步骤都顺利,此时在PyCharm终端看到的Python环境应该是

(modelscope) PS E:\GitHub\blogsCodeSimple\新建文件夹\modelscopeDemo> python

Python 3.8.0 (default, Nov 6 2019, 16:00:02) [MSC v.1916 64 bit (AMD64)] :: Anaconda, Inc. on win32

Type "help", "copyright", "credits" or "license" for more information.然后拉取 modelscope[framework]和 opencv-python

点击运行即可(如果提示没有权限Permission denied,那么使用管理员身份运行PyCharm)

最后输出如下

{'scores': [1.0, 2.5564614e-10, 3.6810602e-13], 'labels': ['正常', '绿屏', '花屏']}原创作者: yinghualuowu 转载于: https://www.cnblogs.com/yinghualuowu/p/18342418

537

537

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?