Abstract

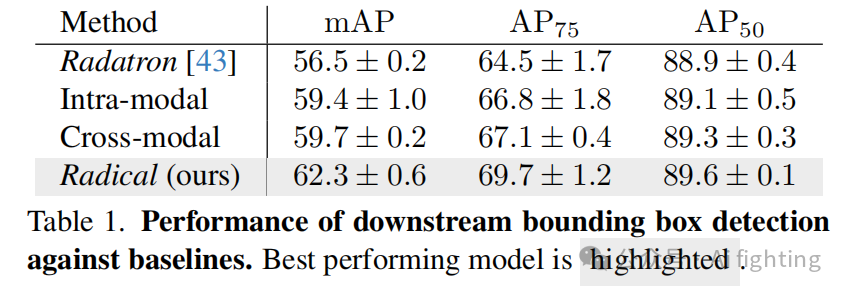

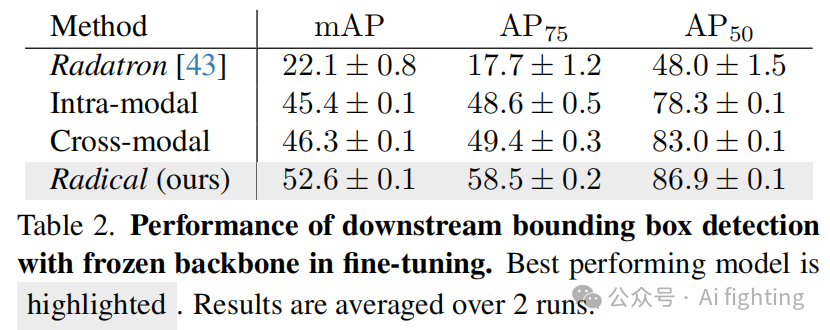

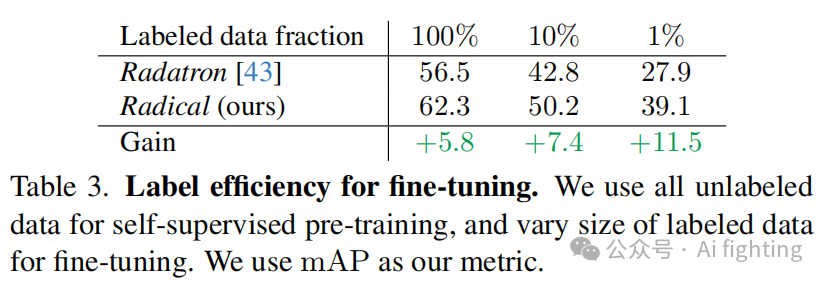

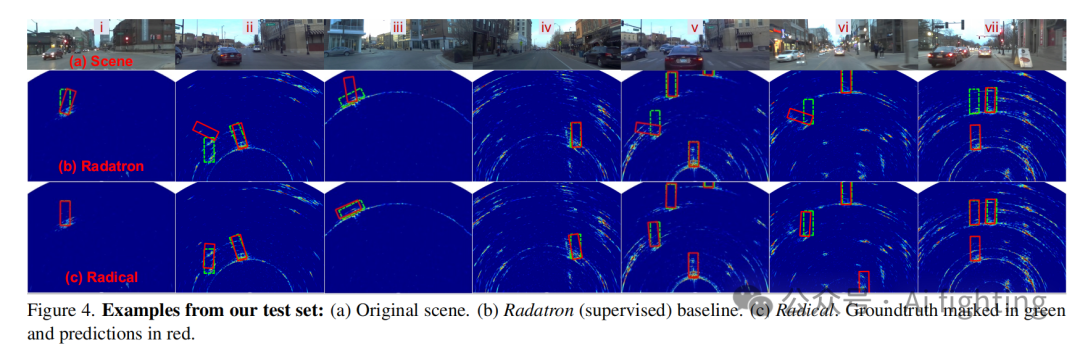

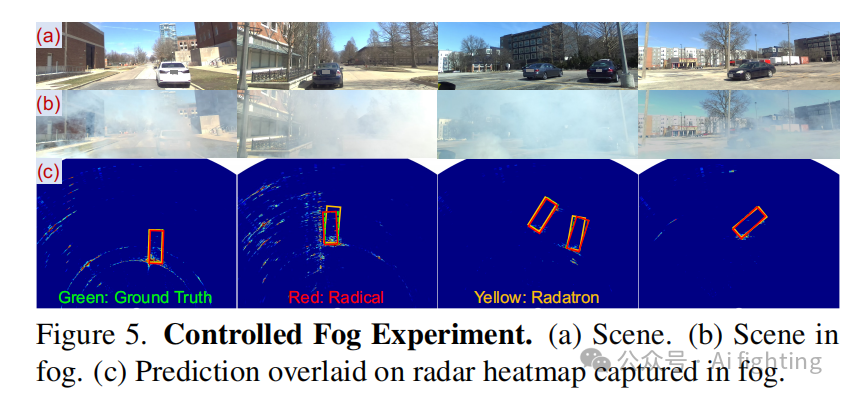

由于雷达(radar)在雾天和恶劣天气下的操作能力,自动驾驶车辆使用雷达进行感知引起了越来越多的研究兴趣。然而,训练雷达模型受到大规模雷达数据注释的成本和难度的阻碍。为了克服这一瓶颈,我们提出了一种自监督学习框架,以利用大量未标注的雷达数据,预训练用于自动驾驶感知任务的雷达嵌入。所提出的方法结合了雷达与雷达之间以及雷达与视觉之间的对比损失,从未标注的雷达热图与对应的摄像头图像配对中学习一般表示。在用于后续的目标检测任务时,我们证明了该自监督框架可以将最先进的监督基线的准确性提高5.8%的mAP。

代码可在https://github.com/yiduohao/Radical获取。

Introduction

毫米波(mmWave)雷达因其成本效益高以及在相机和激光雷达在雾霾、烟雾、暴风雪和沙尘暴等恶劣天气条件下失效时仍能正常工作的能力而在自动驾驶汽车行业中受到越来越多的关注。因此,学术界和工业界都投入了大量工作,开发基于雷达信号的语义场景理解的数据驱动方法。此外,标准商用汽车雷达的出现使得实际部署和大规模数据收集活动成为可能。

在本文中,我们旨在利用大规模未标注的雷达数据,但避开显式注释的复杂性。我们提出了一种自监督学习方法,该方法使用联合嵌入架构,通过从视觉和雷达自身中提取的蒸馏信息预训练雷达目标检测器。在我们的跨模态和内部模态目标下的学习发生在互信息层面,而不是像先前的工作那样明确地注释雷达数据。

据我们所知,这是首个在自动驾驶领域中利用自监督学习来利用大量未标注雷达数据并实现仅使用雷达进行二维边界框检测的工作。我们的发现可能在生成预训练模型方面起关键作用,避免了对大量雷达数据进行注释的需求,并使在新雷达硬件和数据集上的终身学习成为可能。

Method

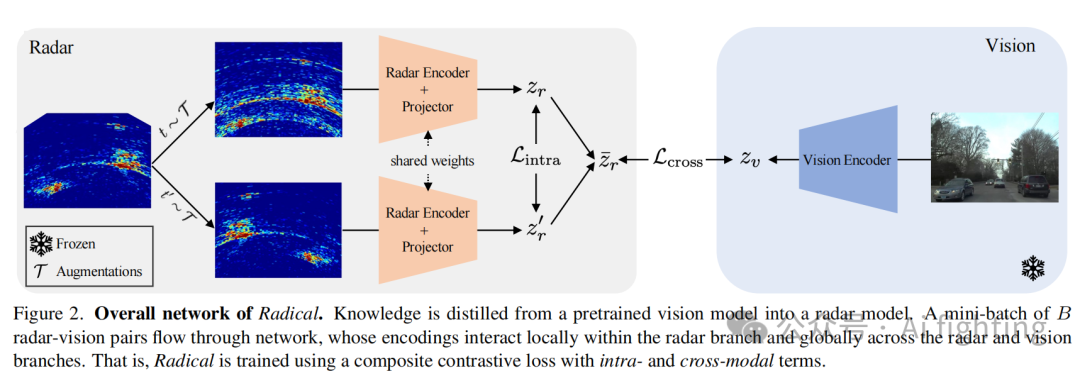

本文的主要目标是以自监督的方式在大规模数据上预训练雷达骨干网络。学习到的雷达嵌入可以用于各种下游任务。为了实现这一目标,我们构建了一个SSL(自监督学习)框架,该框架既使用独立的雷达数据,也使用雷达-视觉配对数据。具体来说,我们的Radical网络实现了一个由两部分组成的SSL损失:(a)内部模态和(b)跨模态。

1.内部模态雷达学习

为了增强雷达嵌入的辨别能力和鲁棒性,本文设计了一套数据增强方法,并制定了一个内部雷达实例辨别学习问题。具体来说,如图2的雷达分支所示,对于每个雷达数据点,我们随机获得两个通过变换产生的正视图,并对这些正视图进行编码、投影和归一化。然后,我们使用一个小批量,计算编码后的正视图相对于从小批量中提取的一组负视图的对比损失。

2.跨模态雷达-视觉学习

如图2所示,跨模态学习在一个联合嵌入架构内使用雷达和视觉。在这个架构中,预训练的视觉模型教雷达模型如何感知和特征化环境。视觉捕捉到车辆前方场景的视觉特征,而雷达数据则被预处理为二维距离-方位热图,从鸟瞰视角(BEV)表示场景。尽管雷达和视觉在不同的坐标系统中操作,它们的嵌入仍然通过对比损失进行对齐。为了实现跨模态学习,我们首先获得一个作为平均值的原型雷达向量,并对相应的视觉样本进行编码和归一化。我们通过实验证明,在冻结的视觉分支中省略MLP投影头,同时在雷达编码器后保留一个投影器是有益的。

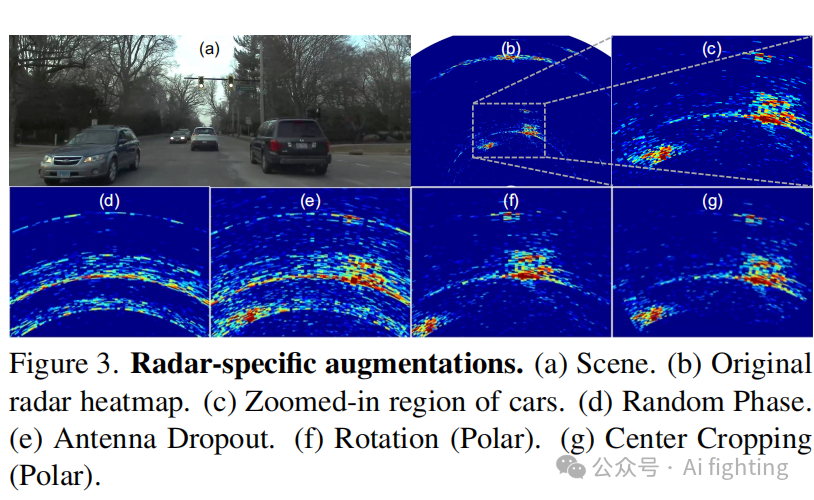

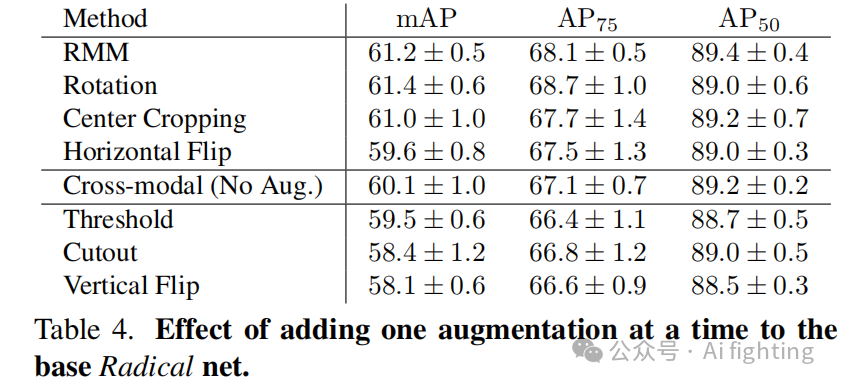

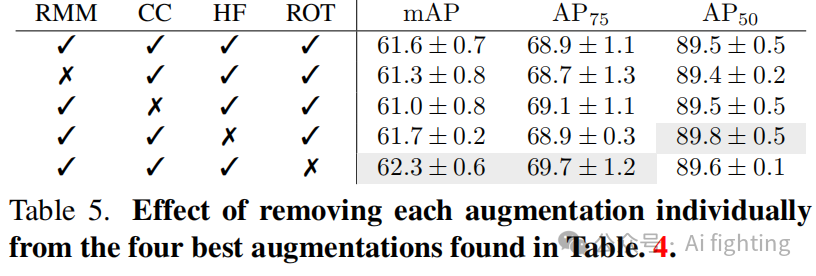

3.数据增强方法以用于内模态和跨模态学习中

一套完整的数据增强方法对我们的Radical框架至关重要。接下来,我们将这些增强方法用于内部模态和跨模态学习中。图3展示了我们在Radical中使用的所有增强方法的直观示例。

3.1 重新调整视力增强功能

我们在不同的视觉增强方法及其组合上进行了广泛的实验。我们发现水平翻转、旋转和中心裁剪也适用于雷达热图。需要注意的是,对于坐标为极坐标的雷达热图,旋转和中心裁剪应在极坐标系中进行,如图3所示。

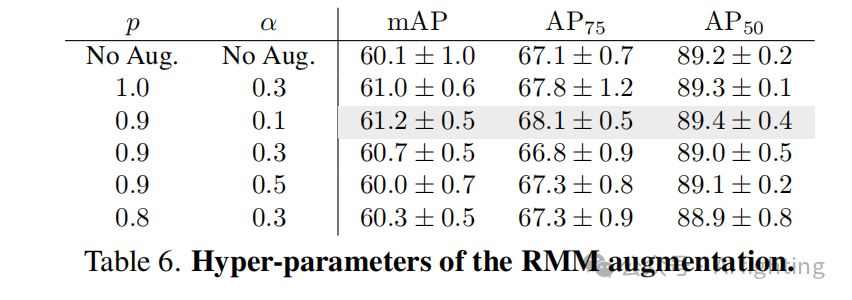

3.2 雷达特定的数据增强

除了重新利用的视觉增强子集外,我们还引入并实验了一种新的特定领域的雷达自监督学习(SSL)增强方法,称为雷达MIMO掩(RMM)。我们简要解释了在应用RMM之前如何处理原始数据。

RMM的实现: 在相关工作中,常见的雷达格式有:距离-方位热图、点云或距离-多普勒图。不同的是,Radical使用中间的三维张量来应用RMM增强方法。

天线弃用:我们利用MIMO雷达虚拟阵列的可重构性来设计这一雷达特定的增强方法。在后续信号聚合中,我们随机省略一部分虚拟天线元素。

随机相位噪声:此增强方法在信号聚合之前随机化接收到的(复数)信号的相位。

Experments

总结

文章的主要贡献:

1. 提出了一种新颖的跨模态 KD 框架,以在 BEV 特征空间中实现 LC 到 CR 的蒸馏。和从 LC 教师检测器转移的知识,CR 学生探测器的性能优于现有基线推理过程中无需额外成本。

2. 设计了四个KD模块来解决不同传感器之间的显着差异,以实现有效的跨模态 KD。当我们在 BEV 领域运营 KD 时,所提出的损失设计可以应用于其他 K配置。我们的改进还包括添加门控网络到自适应融合的基线模型。

3. 对 nuScenes进行了广泛的评估证明 CRKD 的有效性。CRKD 可以将学生探测器的 mAP 和 NDS 提高 3.5%和3.2%。由于我们的方法侧重于小说模态差距较大的KD路径,我们提供彻底的研究和分析以支持我们的设计选择。

引用CVPR2024文章:

CRKD: Enhanced Camera-Radar Object Detection with Cross-modality

Knowledge Distillation

关注我的公众号auto_driver_ai(Ai fighting), 第一时间获取更新内容。

本文通过引入Radical来解决这些挑战,这是一个基于雷达的目标检测系统,通过在预训练雷达嵌入的基础上进行微调,能够精确地从雷达数据中估计目标的边界框,例如在雪暴中当视觉和激光雷达失效时。本文的贡献可以总结为三点:

• 首先,本文提出了一种新的对比学习框架,利用雷达热图和视觉数据。它结合了跨模态(雷达到视觉)和内模态(雷达内部)对比损失项。跨模态项使我们能够从视觉中提取先验信息,如自动驾驶环境中的目标语义,而内模态项则帮助我们提取雷达结构中的先验信息,如稀疏性和反射特性。

• 其次,本文引入了一种新颖的增强技术RMM(雷达MIMO掩模),专为最先进的汽车雷达设计。RMM利用了这些雷达采用MIMO技术的特点,即多发射器和多接收器的组合。我们通过操纵来自不同发射器/接收器对的原始信号,生成新的增强雷达热图。这种增强技术保留了场景的几何结构,同时模拟了由多普勒相位扭曲引起的雷达噪声。

• 第三,本文进行了广泛的评估,并展示了在仅使用雷达进行2D边界框检测方面的显著改进。具体来说,我们的结果显示,与监督学习相比,Radical在汽车检测的平均精度(mAP)指标上提高了5.8%

引用CVPR2024文章:

Bootstrapping Autonomous Driving Radars with Self-Supervised Learning

最后别忘了,帮忙点“在看”。

您的点赞,在看,是我创作的动力。

2567

2567

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?