2023.3.17-BiFormer: Vision Transformer with Bi-Level Routing Attention

论文链接:https://arxiv.org/pdf/2303.08810.pdf

代码链接:https://github.com/rayleizhu/BiFormer

动机

- 注意力是捕捉长距离依赖性的有力工具,但它产生了巨大的计算负担和沉重的内存占用,因为要计算所有空间位置上的成对标记互动

- 一系列的工作试图缓解这个问题通过在注意力中引入手工制作的和与内容无关的稀疏性到注意力中,例如将注意力操作限制在在局部窗口、轴向条纹或扩张窗口内

方法简述

- 提出了一种新的通过双级路由的动态稀疏关注,以实现对具有内容意识的计算的更灵活分配

- 对于一个查询,不相关的键值对首先在粗略的区域层面被过滤掉,然后在剩余的候选区域(即路由区域)的union中应用细粒度的token-to-token的关注。

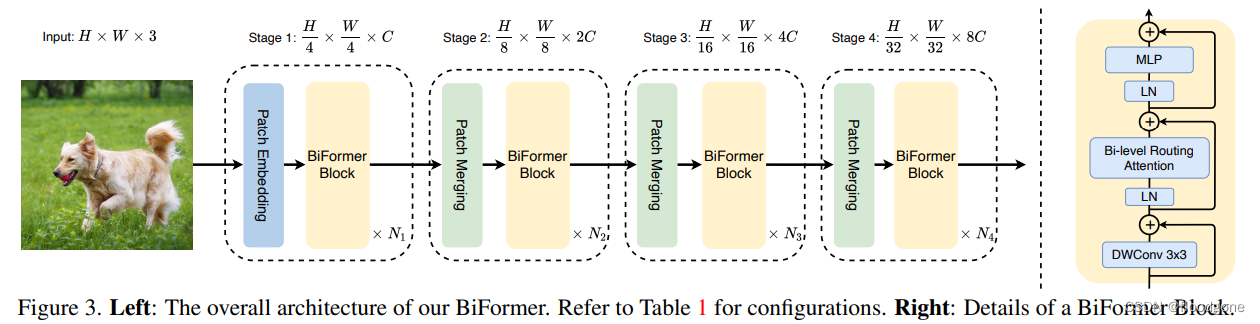

框架

2410

2410

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?