论文笔记--Cross-lingual Language Model Pretraining

1. 文章简介

- 标题:Cross-lingual Language Model Pretraining

- 作者:Guillaume Lample, Alexis Conneau

- 日期:2019

- 期刊:arxiv preprint

2. 文章导读

2.1 概括

文章给出了两种跨语言模型(XLMs)的训练方法:一种为基于单语种数据的非监督学习,一种为基于平行语料库的监督学习。文章提出的XLMs模型在多个机器翻译和文本推理任务中实现了SOTA水平,且在低资源语言任务上实现了显著的性能提升。

2.2 文章重点技术

2.2.1 Shared sub-word vocabulary

文章提出的两种方法均基于Shared sub-word vocabulary。具体来说,令所有的语言共用同一个词表,其中词表由BPE(Byte Pair Encoding)创建。这样的好处为可以使不同语言中公共的子词(包括符号、数字、字母等)对齐,从而使得不同语言表示对齐。

文章采用多项式分布进行随机采样:

q

i

=

p

i

α

∑

j

=

1

N

p

j

α

q_i = \frac {p_i^{\alpha}}{\sum_{j=1}^N p_j^{\alpha}}

qi=∑j=1Npjαpiα,其中

p

i

p_i

pi表示第

i

i

i种语言的token数占比,

N

N

N表示共考虑了

N

N

N种语言。从而1)避免数据不平衡造成的低资源语言理解能力弱 2)防止低资源语言被BPE分割成字母。

2.2.2 无监督任务

- Causal Language Modeling(CLM): 类似GPT[1],文章基于生成式任务来进行模型预训练,即在 t t t时刻最大化概率 P ( w t ∣ w 1 , … , w t − 1 , θ ) P(w_t|w_1, \dots, w_{t-1}, \theta) P(wt∣w1,…,wt−1,θ)。

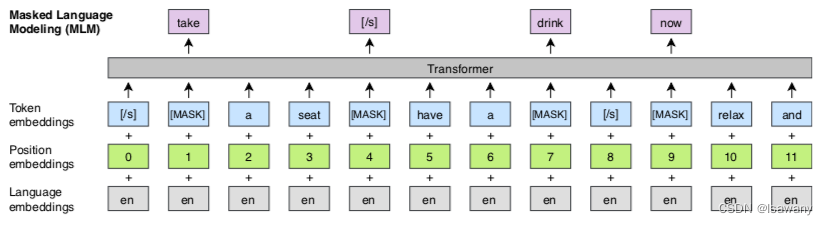

- Masked Language Modeling(MLM):类似BERT[2],文章基于完形填空式任务来进行模型预训练。随机选择词表中15%的子词,对这些词1) 80%的概率替换为[MASK] 2) 10%的概率替换为随机子词 3) 10%概率不变。文章MLM任务和BERT的区别是BERT中只能输入两个句子,即NSP任务。但文章中每个输入可以包含任意数量的句子(只要总token不超过256),用[SEP]分隔。为了处理数据不平衡问题,文章类似上一节中对token进行了多项式分布的采样,从而保证模型可以学习到稀有词。MLM的示意如下图所示。

2.2.3 监督任务-Translation Language Modeling(TLM)

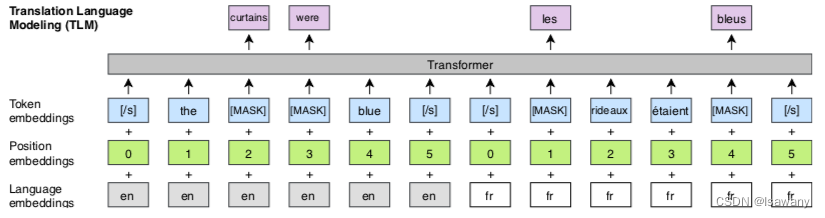

文章提出的另一种方法为基于TLM任务的监督训练。当给定平行双语语料库时,模型将两种语言对应的句子拼接,输入给模型。TLM的示意如下图所示。可以看到,英文和法语用language embeddings分隔,表示不同语种。特别注意,两个语言的position embedding分别从0开始,如下图中英文position embedding 为012345,接着法语的embedding又重置为为012…。

3. 文章亮点

文章把BERT和GPT中的MLM、CLM目标应用到机器翻译任务上,并提出TLM任务进行有监督学习。文章在跨语言分类任务、非监督和监督机器翻译等任务上测试了不同任务,证明了CLM、MLM在处理跨语言任务时的有效性,且证明了TLM可大幅提升语言模型处理机器翻译的能力,

4. 原文传送门

Cross-lingual Language Model Pretraining

代码

5. References

[1] 论文笔记–Improving Language Understanding by Generative Pre-Training

[2] 论文笔记–BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?