点击下方卡片,关注“小白玩转Python”公众号

在YOLO算法的无数应用中,我们想聚焦于一个真实的场景:道路车辆计数。这个用例对于智能城市的交通规划和决策具有重要意义。在这篇文章中,我们将带您一步步实现YOLO目标检测和计数,使用车辆跟踪作为我们的实际示例。

什么是目标计数?

目标计数是计算机视觉中的一个关键应用,旨在识别和计数图像或视频中的特定对象,如人、动物或车辆。该技术在计算机视觉中具有广泛的应用前景,例如:

交通监控:目标计数可用于测量车流量,从而做出更好的交通管理决策。

零售业:通过计数商店内的客户流量,企业可以了解客户购物行为,提升销售效率。

安全监控:目标计数可用于监控公共场所的人流,增强安全性和安保措施。

实现目标计数的四个步骤

目标计数过程通常包括四个主要步骤:

图像预处理:该步骤通过去噪、过滤和增强等技术处理输入图像或视频帧,以提高计数准确性。

目标检测:此步骤旨在识别预处理图像或视频中的特定对象。流行的目标检测算法包括Faster R-CNN、YOLO(You Only Look Once)和SSD(Single Shot MultiBox Detector)。

目标跟踪:在该步骤中,在连续图像帧序列中跟踪相同的对象。常见的目标跟踪算法包括KCF(Kernelized Correlation Filter)、TLD(Tracking, Learning, and Detection)和MOSSE(Minimum Output Sum of Squared Error)。目标跟踪确保在动态视频的连续帧中不会多次计数相同的对象。

目标计数:最后一步涉及计算检测到的和跟踪到的对象数量。

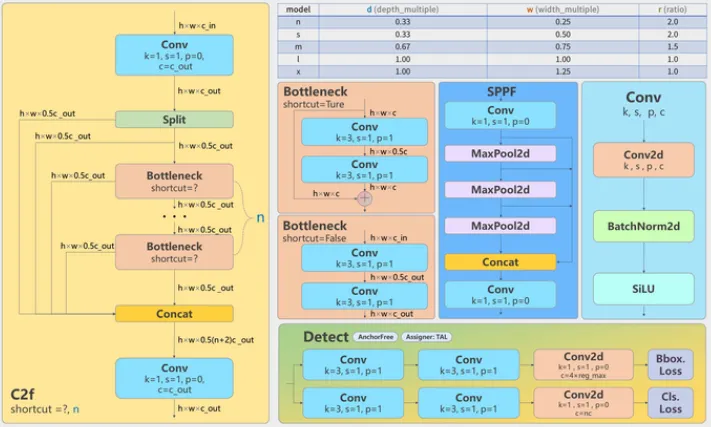

为什么YOLOv8适合目标计数?

YOLO是计算机视觉中一个强大的目标检测工具。虽然YOLO主要用于目标检测,但它也可以用于目标计数,如在实时监控视频流中计数出现的人和车。与传统的目标检测算法如R-CNN系列相比,YOLOv8提供了多项优势,使其非常适合用于目标计数应用。

实时性能

YOLOv8的主要优势之一是其实时目标检测能力。由于其“仅看一次”的特性,YOLO模型无需多次扫描图像,而是将图像一次性划分为多个网格,对每个网格进行分类和回归,从而实现目标检测。此实时性能使YOLOv8非常适合需要即时反馈的应用,如自动驾驶、视频监控和机器人视觉。

高准确性

YOLOv8的另一个优势是其高准确性。传统的目标检测算法通常依赖于多阶段处理,这可能导致每个阶段的累积误差。YOLOv8避免了这一问题,通过在一步内完成所有任务。此外,YOLOv8考虑了对象的上下文,即使在涉及遮挡或重叠的复杂场景中也能保持高准确性。

使用YOLOv8实现目标计数

要使用YOLOv8进行目标计数,我们首先需要检测视频的每一帧中的对象并获得其类别和位置。然而,为了避免在连续帧中多次计数相同的对象,我们还需要采用目标跟踪算法。

💡 目标跟踪算法旨在跨一系列视频帧跟踪一个或多个对象。有多种类型的目标跟踪算法,包括基于光流的方法、基于特征的方法和基于模型的方法。基于光流的方法特别常见,因为它们通过比较两个连续帧来估计每个像素的运动方向和距离,从而实现有效的目标跟踪。

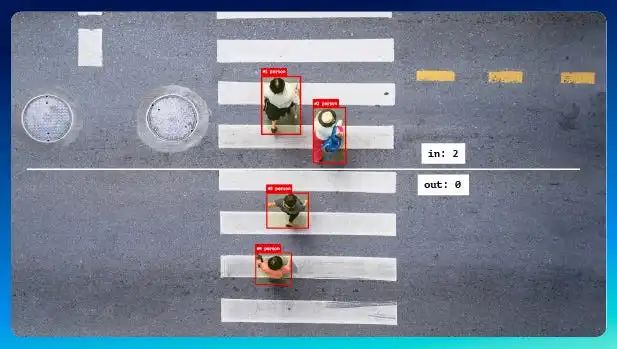

但是,这种方法有一个挑战:如何处理对象的进入和退出。例如,一个人可能从屏幕左侧进入,然后从右侧退出。在这种情况下,我们应将此人计为1,而不是2。为了解决这个问题,我们可以建立规则,例如只有当对象完全进入屏幕时才开始跟踪和计数,当对象完全离开屏幕时停止跟踪和计数。

实践操作:YOLO目标计数

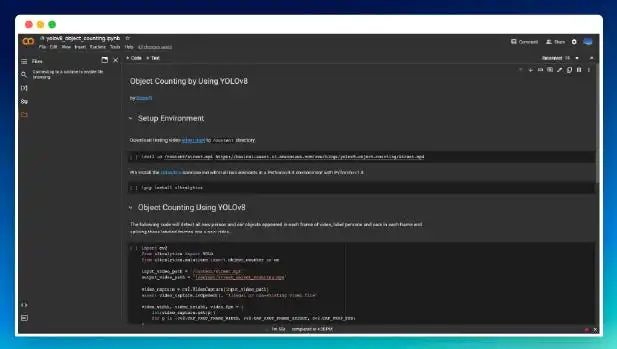

在接下来的部分中,我们将演示如何使用Ultralytics提供的YOLOv8模型,在一分钟的道路监控视频(street.mp4)中计数出现的人和车辆。

输出将是一个带有注释的视频(street_object_counting.mp4),显示每一帧中出现和消失的人和车辆。Ultralytics不仅提供YOLO模型,还在其PIP包中提供了目标计数等高级功能,使开发人员更容易利用YOLO模型。

您可以从以下链接下载完整的Google Colab Notebook代码:yolov8_object_counting.ipynb。

首先,通过下载测试视频并安装所需的PIP依赖项来设置运行环境。

$ curl -o /content/street.mp4 https://basicai-asset.s3.amazonaws.com/www/blogs/yolov8-object-counting/street.mp4

$ pip install ultralytics然后,输入以下代码片段。

import cv2

from ultralytics import YOLO

from ultralytics.solutions import object_counter as oc导入必要的Python对象,包括用于读写视频文件的cv2,YOLO用于检测和跟踪每个视频帧中的人和车辆,以及object_counter用于在每个帧中注释出现的人和车辆以生成视频结果。

input_video_path = "street.mp4"

output_video_path = "street_object_counting.mp4"

video_capture = cv2.VideoCapture(input_video_path)

assert video_capture.isOpened(), "Illegal or non-existing video file"

video_width, video_height, video_fps = (

int(video_capture.get(p))

for p in (cv2.CAP_PROP_FRAME_WIDTH, cv2.CAP_PROP_FRAME_HEIGHT, cv2.CAP_PROP_FPS)

)

video_writer = cv2.VideoWriter(

output_video_path, cv2.VideoWriter_fourcc(*"mp4v"), video_fps, (video_width, video_height)

)使用VideoCapture逐帧读取视频,并使用VideoWriter生成与源视频相同分辨率和帧率的结果视频。

yolo = YOLO("yolov8n.pt")

object_counter = oc.ObjectCounter()

object_counter.set_args(

view_img=True,

reg_pts=[(0, 540), (1280, 540)],

classes_names=yolo.names,

draw_tracks=True

)

while video_capture.isOpened():

success, frame = video_capture.read()

if not success:

break

tracks = yolo.track(frame, persist=True, show=False, classes=[0, 2])

frame = object_counter.start_counting(frame, tracks)

video_writer.write(frame)创建一个YOLO模型对象和一个ObjectCounter对象。然后,使用VideoCapture逐帧读取源视频中的所有帧。利用YOLO检测和跟踪每帧中出现的人和车辆,并使用ObjectCounter在每帧中注释出现的人和车辆。最后,使用VideoWriter将注释的帧写入输出视频流。

重要参数:

set_args.reg_pts: 计数区域或线。只有出现在指定区域内或穿过指定线的对象才会被计数。这里,我们指定了一条位于帧底部的水平线。

track.persist: 由于需要跨帧对象跟踪(避免在不同帧中多次计数同一个人或车辆),需要保留所有先前帧的检测结果。

track.classes: 指定要检测和跟踪的对象类型。0代表人,1代表车辆。

video_capture.release()

video_writer.release()

cv2.destroyAllWindows()最后,释放相关资源。查看示例视频:https://video.wixstatic.com/video/4b3c31_bdf261c811bc47d78cf59b7a37209451/720p/mp4/file.mp4

拓展问答

Q1: 我很好奇,在现实场景中实现这个过程时面临的最大难题是什么?A1: 最常见的问题之一是处理遮挡(对象被其他对象部分或完全遮挡),这会使模型难以准确检测和计数它们。另一个挑战是确保模型不会在不同帧中多次计数同一个对象。这需要一些巧妙的预处理和对YOLO模型的精细调整。拥有一个稳健的目标跟踪算法也至关重要!

Q2: 我正在做一个涉及自然栖息地中野生动物计数的项目。你认为这种基于YOLO的方法适合吗?A2: 绝对可以!YOLOv8的一个很棒的特点是它非常多才多艺。有了合适的训练数据,您可以教它检测和计数几乎任何类型的对象。无论是野生动物、生产线上产品,还是显微镜下的细胞,YOLO都能胜任。关键是要有一个与您的用例特定相关的良好标注数据集。

Q3: 我最近听说了很多关于Google Colab的事情。你能解释一下它是什么以及为什么如此受欢迎吗?A3: Google Colab是一个革命性的基于云的Jupyter笔记本环境,允许您运行Python代码并使用Google强大的计算资源(包括GPU和TPU)来训练深度学习模型,且完全免费!它非常用户友好,预装了Python库,无缝集成Google Drive,并支持Markdown和LaTeX。难怪Colab在机器学习爱好者和数据科学家中如此受欢迎。

Q4: 我一直在低光条件下尝试目标计数,但准确性无法达到要求。有何建议可以改进?A4: 低光场景确实是目标检测和计数的一个难题。有几个技巧可以尝试。考虑在预处理步骤中应用一些图像增强技术。直方图均衡化或伽马校正可以显著提高暗图像中的细节。另一个帮助方法是使用一个专门在包含低光图像的数据集上训练的YOLO模型,这样它会更好地应对这些挑战性条件。

· END ·

HAPPY LIFE

本文仅供学习交流使用,如有侵权请联系作者删除

8824

8824

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?