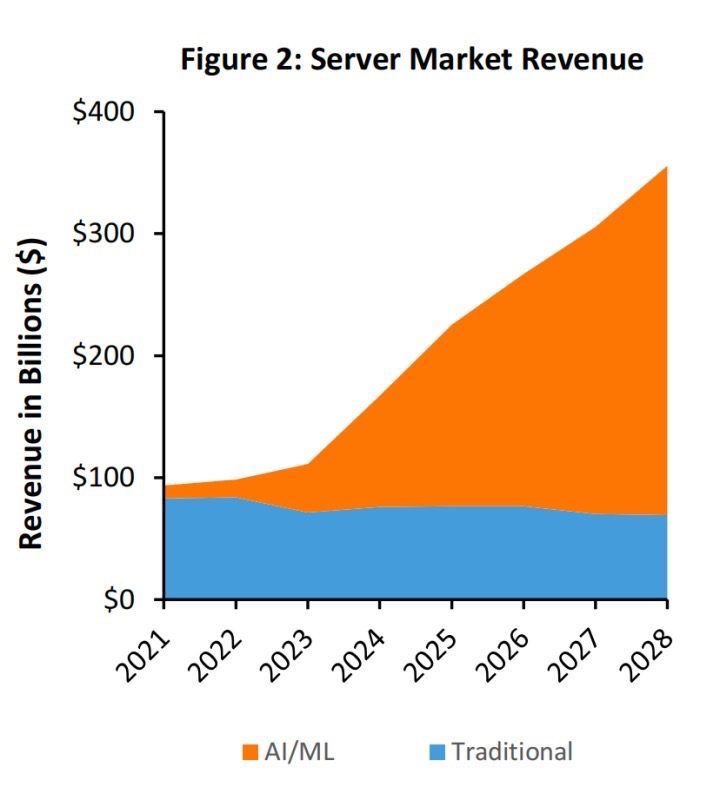

在早期RDMA的主要应用领域是高性能计算(HPC)。那时,大部分HPC建设的重点在于超级计算项目,在云计算和企业数据中心的应用并不广泛。然而,情况在2022年末发生了变化,随着AI/ML成为重点投资领域,数据中心的开支迅速向AI/ML倾斜。

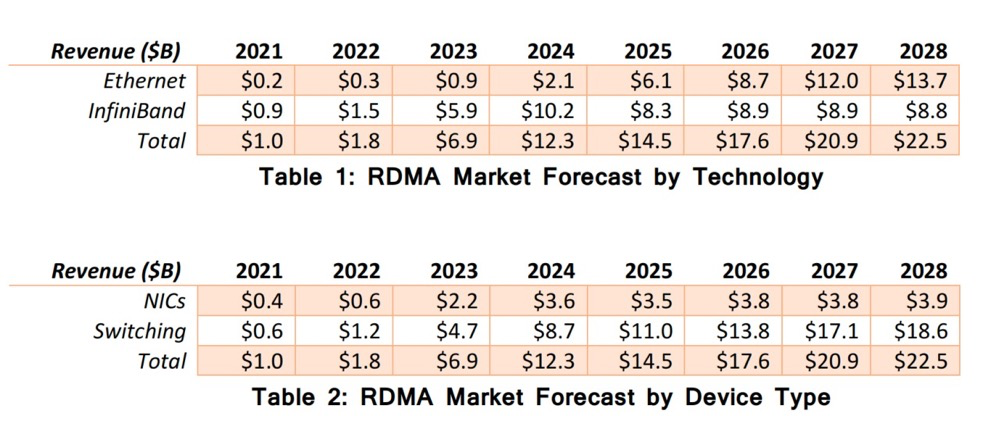

这一转变的速度和规模是前所未有的,到了2023年底,RDMA基础网络的部署速度甚至超过了2022年和2021年的总和。这次激增让RDMA技术迅速普及,成为了AI/ML领域扩张的关键支撑。650 Group预计,到 2028 年,RDMA 网络市场规模将超过 220 亿美元。

RDMA/RoCE

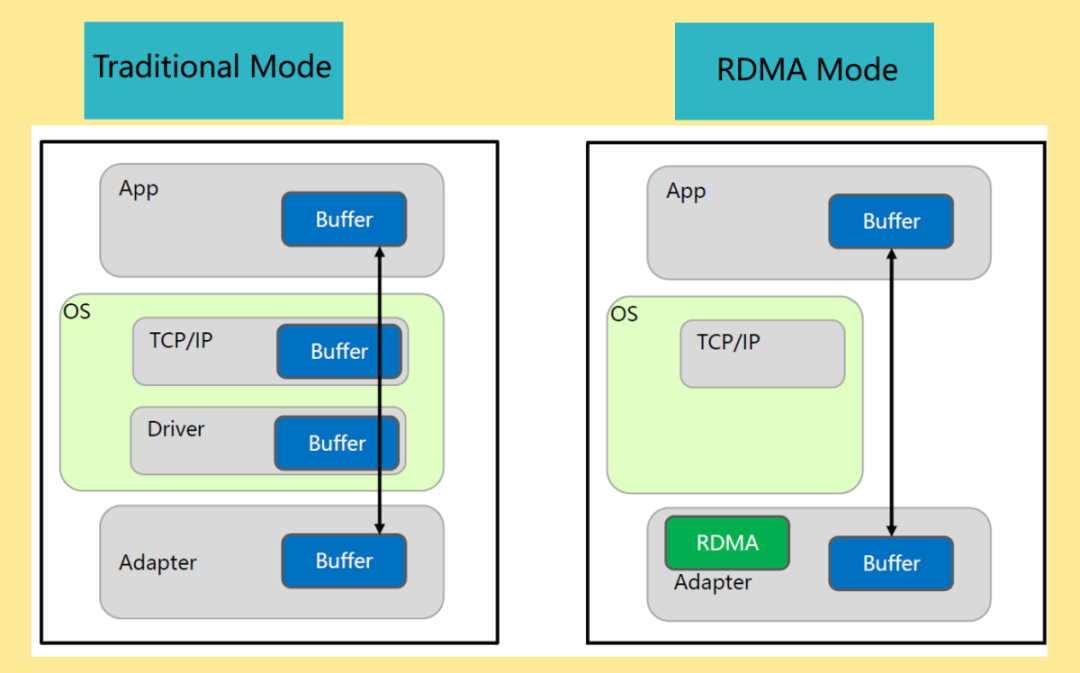

RDMA(远程直接内存访问)允许两台服务器直接读写对方的内存,而无需经过任何一台服务器的处理器、缓存或操作系统。通过绕过这些步骤,RDMA可以释放CPU,降低延迟,并提供更快的数据传输。网络、存储和计算应用均受益于此技术。

RDMA在每个服务器的网卡(NIC)中实现。通过绕过操作系统和网络内核,两台服务器之间的网络性能和数据交换会更快。RDMA最初是为用于大规模并行计算的HPC集群而设计的。大规模并行计算是AI/ML的工作方式,而RDMA是这类部署中重要的组成部分。

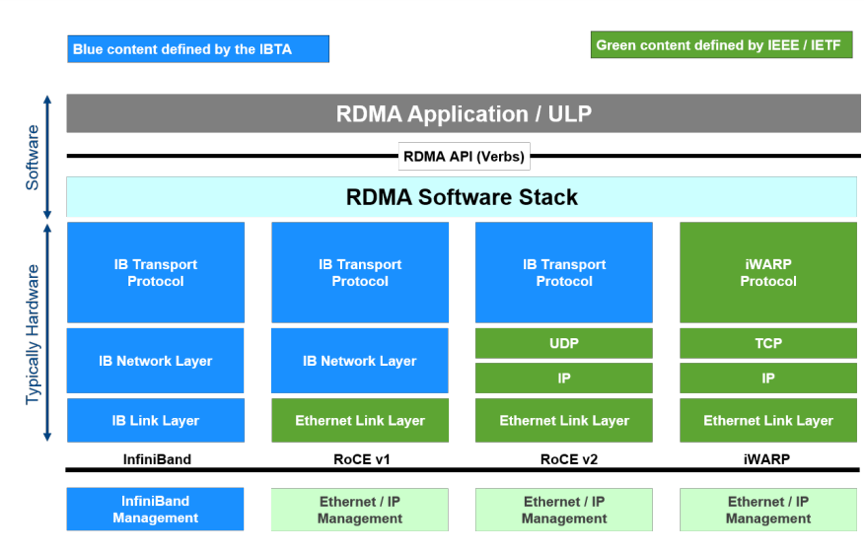

RoCEv2是基于以太网的RDMA实现,它使用了以太网的网络基础设施来传输RDMA数据。在RoCE的早期版本中,需要融合以太网,但在后来的版本中,RoCE也可以在标准的以太网上运行。在业内,人们正在投入大量精力改进以太网的拥塞控制机制,以减少数据包的丢失。

值得一提的是,数据中心中已安装的以太网交换机端口数量超过了4亿个。鉴于其广泛的存在,以太网将在AI/ML网络中发挥越来越大的作用,未来会有越来越多的RDMA操作通过以太网完成。

服务器市场的变化

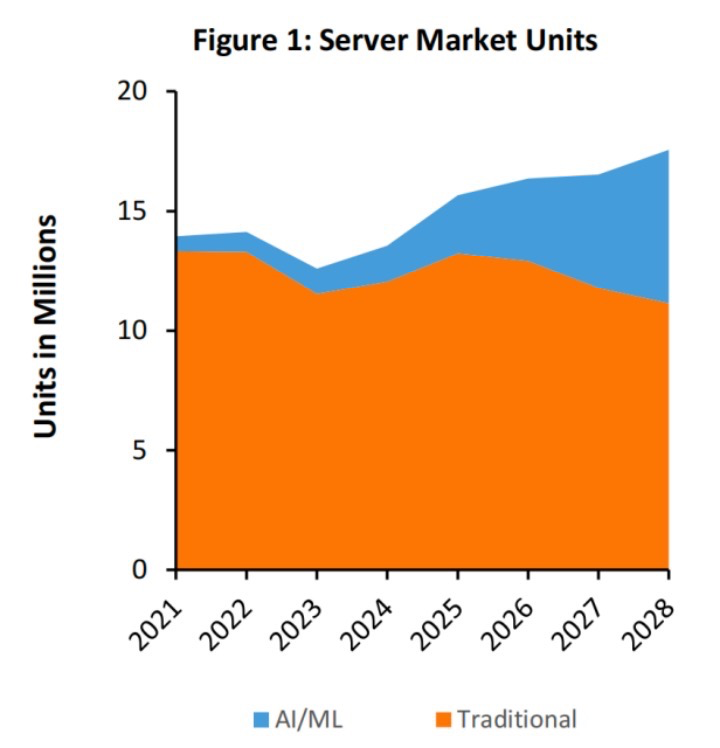

随着客户从通用服务器转向专为AI/ML设计的服务器,整个服务器市场的格局正在经历重大变革。预计到2028年,AI/ML服务器的数量将从2023年的100万台激增至600万台以上。

与此同时,AI/ML服务器的市场规模有望接近3000亿美元。数据中心市场从未见证过如此快速的转变,AI/ML的兴起将促使数据中心的总体支出翻一番。预计到2028年,这600万台AI/ML服务器中的绝大多数都将配置后端网络或AI架构,以实现计算节点间的互联。

在服务器市场中,每台服务器所搭载的GPU和AI ASIC的数量将随产品迭代而持续增长。如今,配备8个GPU的服务器最为常见。预计不久后将出现配置16个乃至32个GPU的服务器。

随着训练模型的参数规模从数十亿扩展至数万亿,单个GPU的内存容量亦将持续扩大。面对如此庞大的数据规模,提高服务器间数据传输效率成为了扩展系统能力、达成训练模型远大目标的核心要素。RDMA技术将在这些服务器中发挥关键作用,因为能否有效访问其他服务器的内存和资源,直接影响到系统的可扩展性。

JCT和性能指标

直接访问其他服务器上内存的能力有助于提高AI模型的整体性能。借助RDMA技术,数据能快速送抵GPU,从而有效缩短作业完成时间(Job Completion Time,简称JCT)。

在AI/ML集群的早期阶段,一个主要问题是GPU核心经常处于闲置状态,一旦出现数据包丢失或者数据无法及时送达GPU,整个集群就可能陷入停滞,所有计算资源都处于空闲状态。RDMA技术有效地解决了这一网络瓶颈,最终优化了AI/ML集群的JCT和各项性能指标。虽然以太网和InfiniBand之间可能存在额外的性能差异,但相比传统网络,RDMA无疑是巨大的进步。

NIC市场

所有InfiniBand NIC都支持RDMA,但目前并非所有以太网NIC都能支持RDMA/RoCE。那些希望在AI/ML领域占有一席之地的传统以太网NIC制造商,必须在其产品中加入RoCE功能,以此参与市场竞争。随着NIC速度迈入400Gbps及以上的时代,我们预计多数以太网NIC产品都将具备RoCE支持。功能的增强与端口速率的提升,将推高以太网NIC的平均售价(ASPs)。

各厂商在以太网NIC中集成的RoCE能力将存在差异,这主要取决于所采用的处理器类型、额外的卸载引擎以及研发团队的专业水平,这些因素将导致不同NIC供应商的产品性能形成多个层级。随着新一代产品的不断推出,我们预期各大厂商会对其产品线及RoCE性能指标进行持续优化,逐步缩小彼此间的性能差距。性能指标的一致性增强,将最终促进更好的设备间互操作性,同时也为用户提供更为丰富的选择空间。

AI/ML后端网络

大多数AI/ML服务器使用后端网络。后端网络独立于数据中心的其他网络,既可以选择InfiniBand,也可以选择以太网。后端网络只关注AI/ML集群,负责将集群内的每一台服务器相连。其主要关注点在于实现GPU到GPU,或是GPU到内存的高速连接。后端网络是现有网络架构的有益补充,它不仅增加了每台服务器的端口数量,还大幅提升了网络设备的市场潜力。

AI/ML应用可能涉及多个后端网络,各自针对不同的任务需求。举例来说,虽然RDMA技术既能在以太网,也能在InfiniBand上运行,但除此之外,别的GPU提供商或AI ASIC都可以使用其他网络来创建更高性能的解决方案。

市场规模

2021年之前,RDMA的市场规模每年在4亿至7亿美元之间,主要受HPC应用的驱动。2023年,由于AI/ML部署的激增,市场对RDMA的需求激增至60亿美元以上,预计到2028年这一数字将突破220亿美元。随着运营商加大对AI/ML资本支出(CAPEX)的投入,以及对未来趋势的指引,RDMA相关的项目预算在未来几年内有望进一步上调。

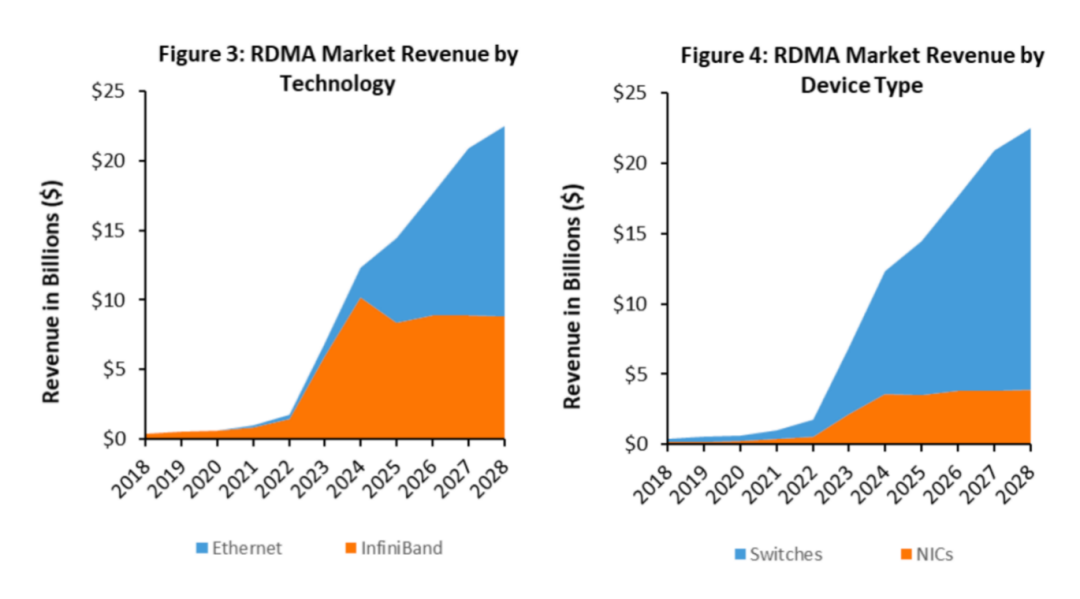

RDMA市场可以细分为两个不同的类别。

首先是技术类别。目前RDMA主要与InfiniBand技术一起部署,但随着时间推移,以太网中将出现更多RDMA网络。其次,从硬件角度看,市场关注点主要落在NIC和交换机上。在InfiniBand领域,NIC和交换机的采购通常是一体化的;而在以太网领域,交换机的采购往往由不同的团队负责,与NIC的购买节奏不同。这种服务器团队与网络团队各自为营的现象在AI/ML领域依然存在,尽管AI/ML本身具有融合性,但企业内部的组织壁垒并未消除。因此,我们预见到每个客户在其AI/ML网络中将形成对NIC和交换机供应商的独特偏好,而且潜在的AI/ML项目可能会选择与客户传统计算部署不同的NIC和交换机供应商。

总结

RDMA和RoCE在AI/ML网络中发挥着关键作用。没有它们,AI/ML的扩展速度将无法满足客户需求的快速增长。随着服务器市场迅速转向AI/ML,逐渐远离传统计算领域,RDMA与RoCE将迎来巨大的市场机遇,预计未来几年内,其市场规模将呈现爆炸性增长。

尽管在技术选择上会存在客户和供应商的偏好差异,但RDMA无疑将得到广泛应用和快速发展。以太网和InfiniBand将并存,市场与客户应避免将其看作二选一的局面。实际上,多数客户将在InfiniBand和以太网网络中同时采用RDMA技术,很少有客户只局限于单一类型的网络或供应商。

AI/ML应用场景广泛,涵盖从基础训练、强化学习到推理等多个领域。确保RDMA跨多种技术平台的兼容性,有助于客户实现业务规模的拓展,让他们能够集中精力于AI/ML工作负载本身,而非底层网络。

原文链接:

https://650group.com/blog/rdma-networks-are-a-key-enabler-to-ai-ml-deployments/

1003

1003

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?