散记知识点

——“聚类:经典的无监督学习方法”

1.基本概念和方法

(1) 聚类的基本概念

- 聚类是一个把数据对象划分成多个组或簇的过程,使得簇内的对象具有很高的相似性,但与其他簇中的对象很不相似。

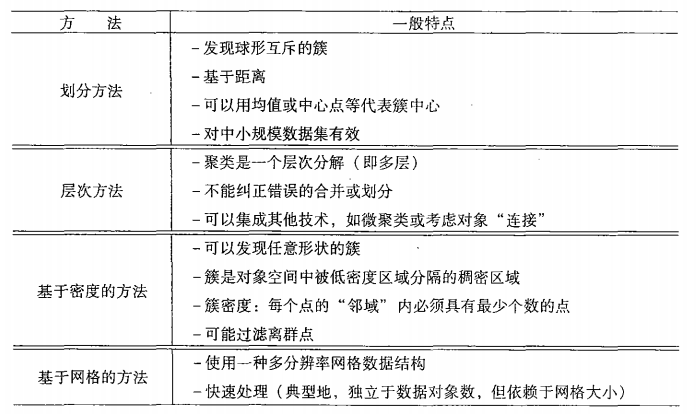

(2) 聚类的基本方法

基于距离的划分方法

给定一个 n n 个对象的集合,划分方法构建数据的 个划分。大部分的划分方法是基于距离的,首先给定要构建的分区数 k k 构建一个初始划分。通过不断迭代,使得同一簇中的对象尽可能接近,不同簇中的对象尽可能远离。最终达到稳定状态。典型的这类方法有: -均值和 k k -中心点的启发式算法,能够逼近局部最优。

基于层次的方法

层次方法分为凝聚和分裂。凝聚:自底向上,开始将每个对象作为单独的一个组,然后逐渐合并相近的组,直到所有的组合并为一个组(或者满足某个终止条件)。分裂:自顶向下,开始将所有对象置于一个簇中,每次相继迭代,划分更小的簇,最终每个对象单独在一个簇中。

基于密度的方法

考虑“邻域”中的密度(对象或数据点的数目),超过某个阈值,就继续增长给定的簇。基于密度的聚类方法,可以用来过滤噪声和离群点,能够发现任意形状的簇。

基于网格的方法

把对象空间化为有限个单元形成一个网格结构。聚类操作在网格上进行。处理速度快,因为其处理时间独立于数据对象的个数,仅依赖于量化空间每一维的单元数。

总结:

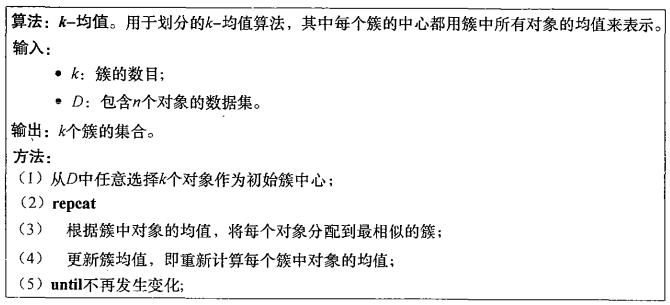

2. -均值(k-means)聚类算法

(1) 算法的主要思想和原理

算法的目标

假设数据集 D D 包含 个欧式空间中的对象。算法将 n n 个对象分配到 个簇 C1,...,Ck C 1 , . . . , C k 中,使得对于 1≤i,j≤k,Ci⊂D且Ci∩Cj=∅ 1 ≤ i , j ≤ k , C i ⊂ D 且 C i ∩ C j = ∅ 。用一个目标函数评估划分的质量,使得簇内对象相似,簇间对象相异。

评价(目标)函数

k k -means取簇 中对象的均值为中心点 ci c i 代表该簇,对象 p p 与其簇的代表 之差为 dist(p,ci) d i s t ( p , c i ) 度量,其中 dist(x,y) d i s t ( x , y ) 表示两个点之间的欧式距离。算法划分 k k 个簇的质量可用数据集中所有对象与所属簇中心的距离之和度量定义为:

其中, dist(p,ci)2 d i s t ( p , c i ) 2 表示簇 Ci C i 的质量是簇中所有对象和形心 ci c i 得误差平方和。 E E 就是我们所要优化得目标函数,试图使生成的结果簇中尽可能的紧凑和独立。算法策略

要想求出全局最优解,需要穷举出所有可能的划分,比较目标函数。即使在2维空间内,穷举法也是个N-P难问题。如果簇数为 维度为 d d ,则穷举法对 个对象求出最佳的 k k 个划分的时间复杂度为 。这个开销是很大的,为了克服这个问题,通常采用贪心算法的策略。

(2) 算法的主要过程

- 首先,在 D D 中随机选择 (预定义 k k 的大小)个对象,每个对象代表一个簇的初始均值或中心。对剩下的每个对象,根据其与各个簇中心的欧式距离,将它分配到最相似的簇。

- 然后,算法迭代地改善簇内变差(所有对象和形心 得误差平方和)。对每个簇,它使用上次迭代分配到该簇的对象,计算新的均值。

- 接着,使用更新后的均值作为新的簇中心,重新分配所有对象。迭代继续,直到分配稳定,即本轮形成的簇与前一轮形成的簇相同。

(3) 算法的评价

- k k -means不能保证能够收敛于全局最优解,结果可能受初始簇中心的选择有关。实践中,通常以不同的初始簇中心,多次运行算法,以期许达到好的结果。

- 此外,算法的复杂度为 ,其中 n n 为对象数, 为簇数, t t 为迭代次数。远远低于穷举法,因此对于处理大数据集,该算法相对可伸缩和有效的。

- -means要求事先给定簇数 k k 值,这一点很盲目,算是一个缺点。但是可以采取其他技术确定较好的 值。

- k k -means不适合发现非凸形状的簇或者大小差别很大的簇,此外, -means对噪声和离群点敏感,这些值会大大影响均值的计算。

2. k k -中心点聚类算法

(1) 算法的主要思想和原理

- 针对

-means对噪声和离群点敏感的问题, k k -中心选择实际的对象作为簇的代表。每个簇选择一个代表对象

,和 k−means k − m e a n s 同样采用误差平方和作为评价度量:

E=∑i=1k∑p∈Cidist(p,oi)2 E = ∑ i = 1 k ∑ p ∈ C i d i s t ( p , o i ) 2k-中心聚类试图最小化该绝对误差。

- 围绕中心点划分(Partition Around Medoids, PAM)算法是k-中心聚类的一种流行实现方法。采用贪心迭代的思想:初始随机选择 k k 个代表,考虑簇中一个非代表对象替换代表对象是否能够提高聚类质量。找到使得聚类质量最好的非代表对象替换代表对象。

(2) 算法的主要过程

- 初始随机选择k个数据点 作为代表对象,将每个非代表对象分配到离其最近代表对象簇中,计算误差平方和。

- 依次考虑每个非代表对象 oq o q 是否是当前代表对象的好的替代。例如:用 oq o q 替代 oj

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

2511

2511

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?