1.前言

最近在忙机器人项目的人脸识别测试,由于有其他事情,导致人脸识别测试这块弄的时间很少,遇到很多坑,特此记录,以便以后方便查看.

2.opencv2.4.9安装

一开始本来以为ros自带的opencv2.4.8能够利用上,就没再想装其他opencv版本,结果还是不行,老是报错.

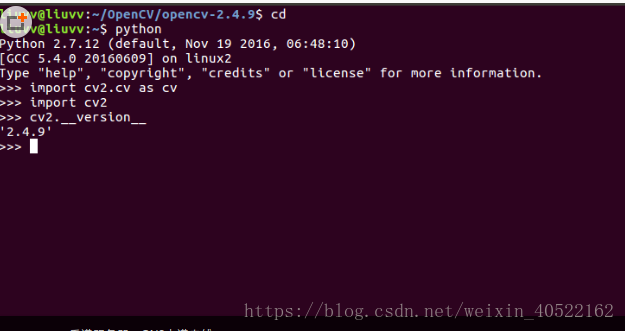

在Python的环境下输入命令:

import cv2.cv as cv会出现如下错误:

ImportError: No module named cv或者

ImportError: No module named cv2.cv找了半天网上的资料和办法,也没弄成功,应该把网上的办法都试了个便,还是不行,这时想应该是opencv缺少什么东西或者自带的库有些不全,主要是一开始装了opencv3.x的版本,导致出现各种问题,因为人脸识别测试是用的opencv2的库,因此先把opencv3.x卸载干净,然后装了一个opencv2.4.9

但是我安装opencv版本2的时候,他的下载速度实在感人,不知道是哪里的原因,于是改用weget命令下载,再此之前有一些依赖需要安装:

sudo apt-get install build-essential cmake libgtk2.0-dev pkg-config python-dev python-numpy libavcodec-dev我这里下载opencv2.4.9,有需要的可以去下载其他版本,因为使用别人的脚本下载的非常慢,所以使用weget命令下载,命令如下:

wget https://sourceforge.net/projects/opencvlibrary/files/opencv-unix/2.4.9/opencv-2.4.9.zip我放在了home文件夹下,下载完后会有一个zip文件,将其解压到本地

unzip opencv-2.4.9.zip进入到解压的文件夹下

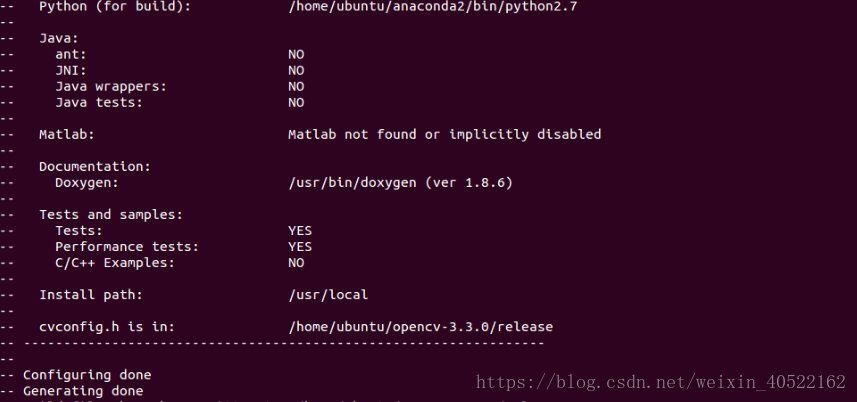

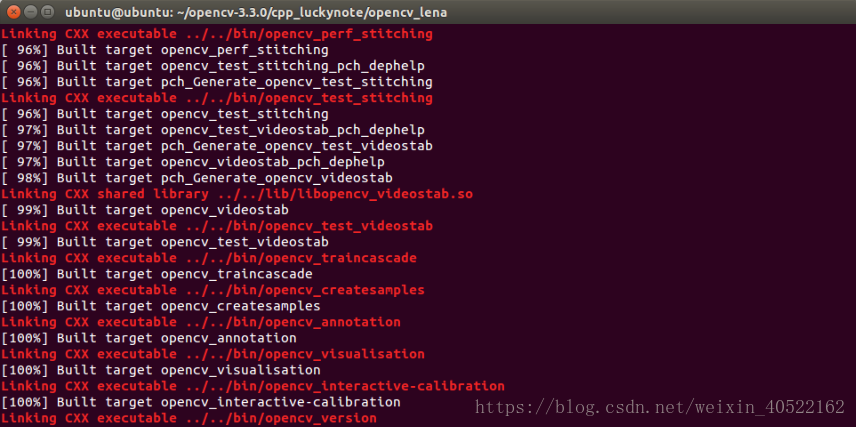

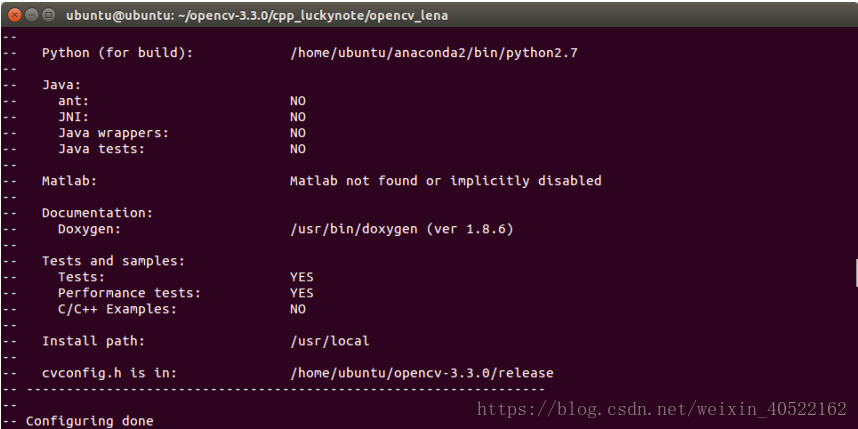

cd /opencv-2.4.9mkdir buildcd build cmake -D CMAKE_BUILD_TYPE=RELEASE -D CMAKE_INSTALL_PREFIX=/usr/local .. make -j4sudo make install (注意一定要加sudo,否则会报出permission问题) pkg-config –modversion opencv (安装结束后,可以用该条命令查看opencv版本) 至此,opencv已经安装完成了,不过不要认为这样就万事大吉了,别忘了配置环境变量

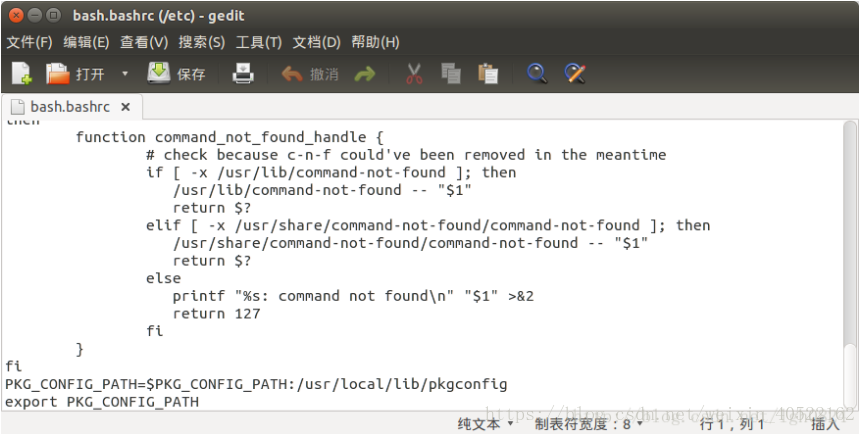

sudo gedit /etc/ld.so.conf (在弹出的窗口中复制如下一段文字:/usr/local/lib) sudo ldconfig (使得配置生效) sudo gedit /etc/bash.bashrc (在弹出的窗口中添加

PKG_CONFIG_PATH=$PKG_CONFIG_PATH:/usr/local/lib/pkgconfig

export PKG_CONFIG_PATH

)

source /etc/bash.bashrc 使得配置生效走到这里才算得上是真正安装opencv结束

3.利用rbx1中的源码进行人脸识别测试

首先下载rbx1的源码,

cd ~/catkin_ws/src

git clone https://github.com/pirobot/rbx1.git

cd rbx1

git checkout hydro-devel

cd ~/catkin_ws

catkin_make

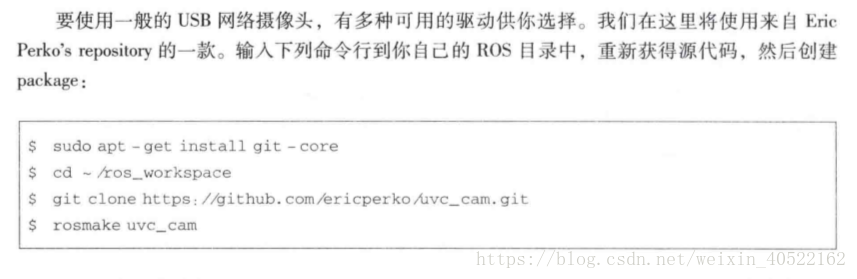

source ~/catkin_ws/devel/setup.bash安装摄像头驱动

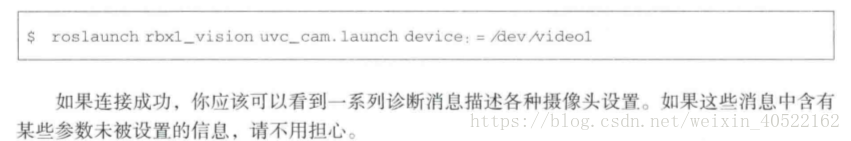

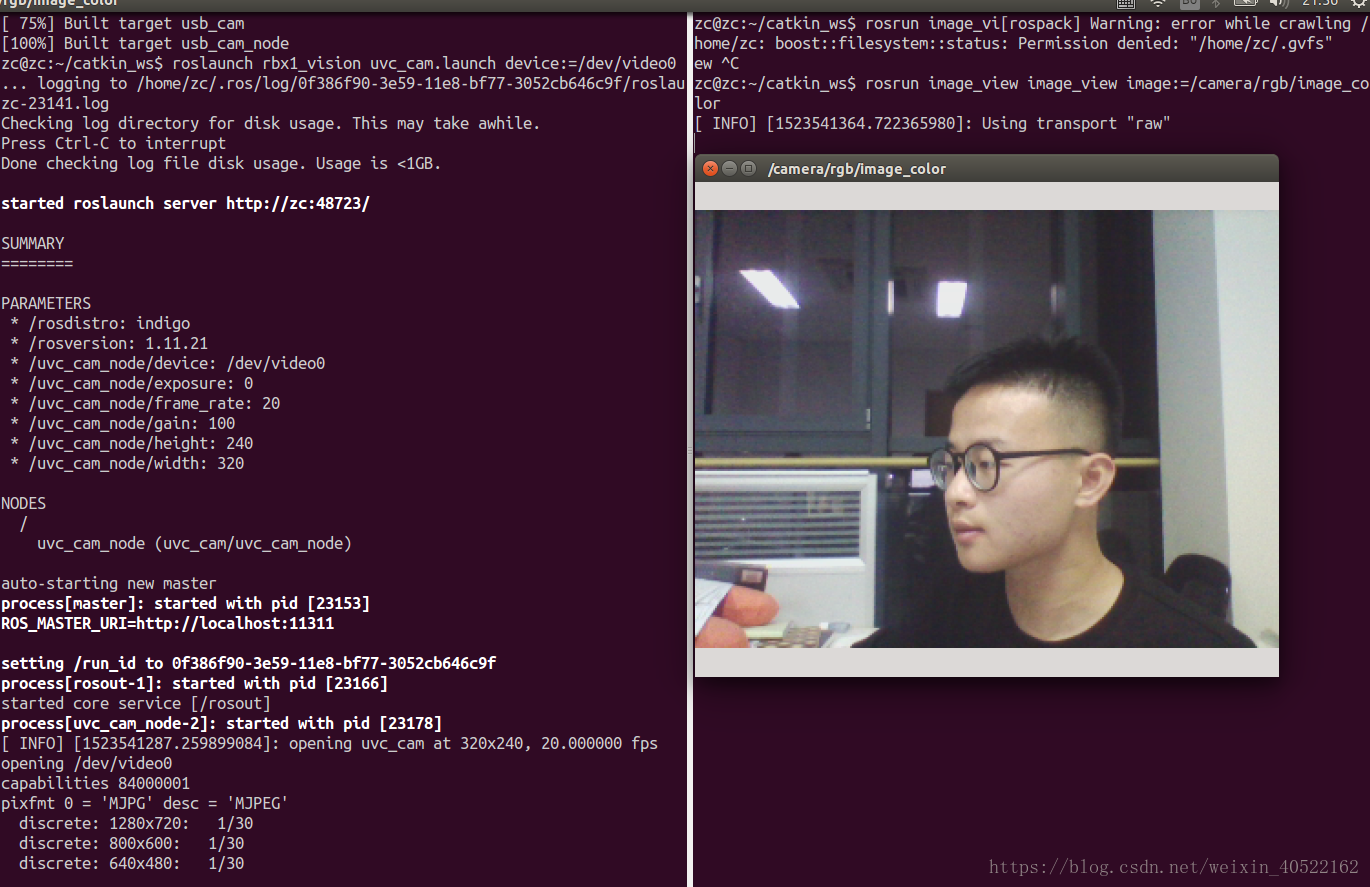

测试网络摄像头

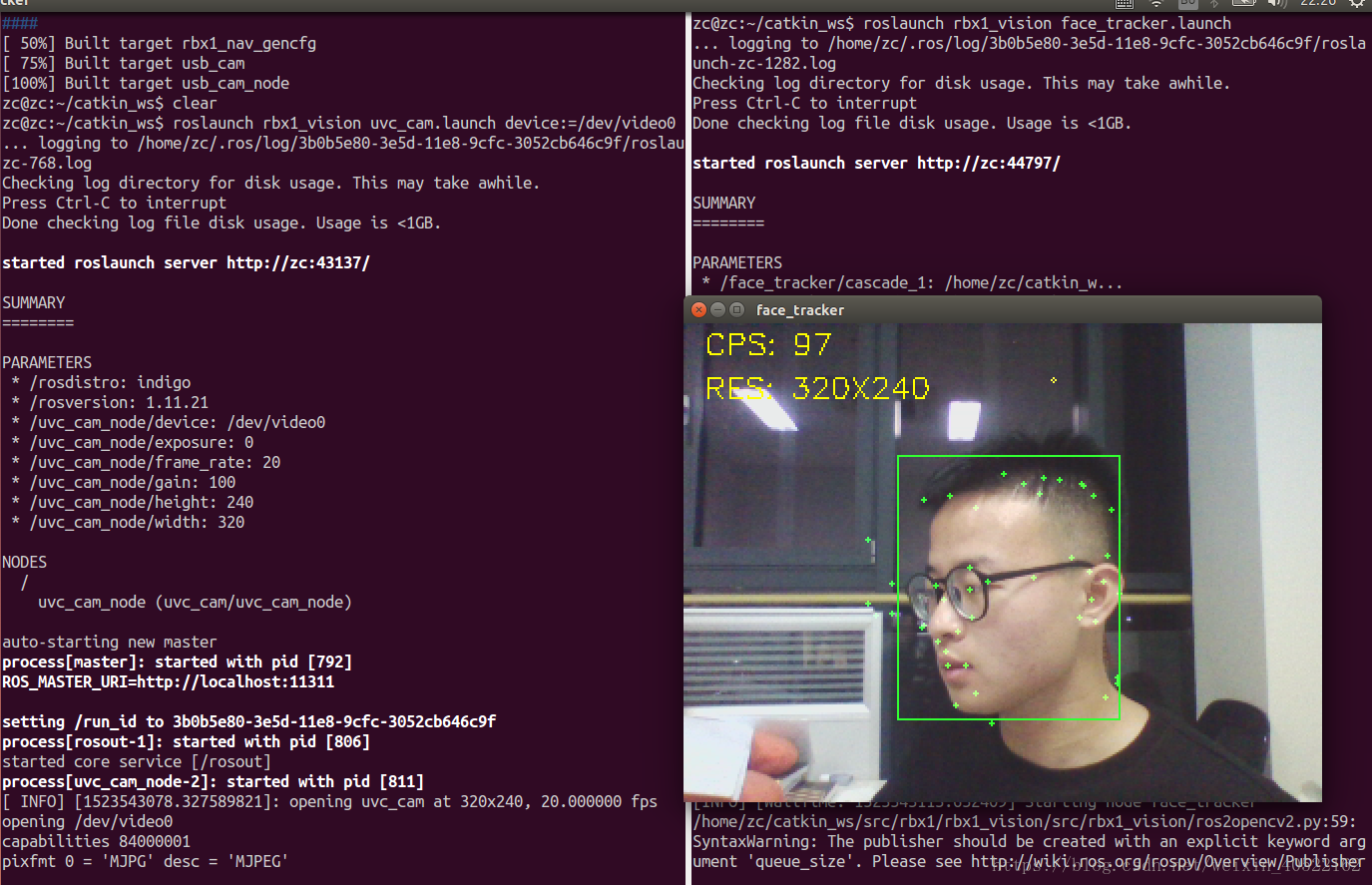

如图所示

测试1

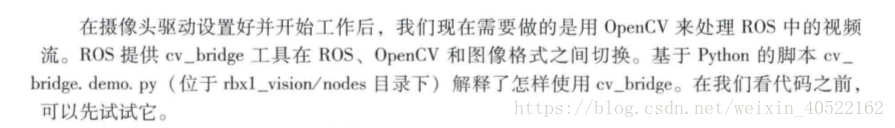

cv_bridge程序包

注意:这里要修改一下cv_bridge_demo.py里的某个语句,不然程序会报错

其中有

frame = self.bridge.imgmsg_to_cv(ros_image, "bgr8")改成

frame = self.bridge.imgmsg_to_cv2(ros_image, "bgr8") depth_image = self.bridge.imgmsg_to_cv(ros_image, "32FC1")改成

depth_image = self.bridge.imgmsg_to_cv2(ros_image, "32FC1")因为

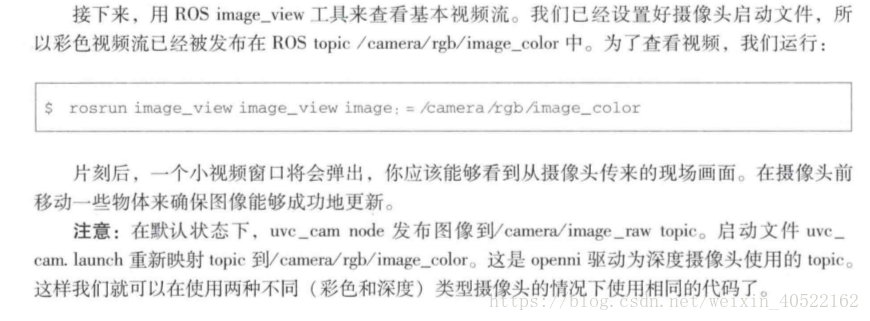

ROS与OpenCV之间的图像格式转换由 cv_bridge 包负责,我们看下这个包怎么运作:

$ roslaunch rbx1_vision usb_cam.launch video_device:=/dev/video0

$ $rosrun rbx1_vision cv_bridge_demo.py

Github的代码已经更新,这里面我们需要手动改一些这个python script的语句,注意,这个文件的路径在:catkin_ws/src/rbx1/rbx1_vision/nodes下。

将其中的 input_rgb_image,input_depth_image全部改为/camera/rgb/image_raw。以上两个是jade里的更新的主题名,但在indigo里,还是以/camera/rgb/image_raw为主题名。

这个python script里面几个关键的语句:

# 创建CvBridge对象

self.bridge = CvBridge()

# 将ros_image通过蓝绿红8位色空间转换为OpenCV图像,结果返回给frame

frame = self.bridge.imgmsg_to_cv2(ros_image,"bgr8")

# 最后将frame用numpy转换成numpy数列,OpenCV这样大部分的函数才能够处理

frame = np.array(frame,dtype = np.uint8)

OpenCV的开发可以基于ros2opencv2.py(catkin_ws/src/rbx1/rbx1_vision/src/rbx1_vision/ros2opencv2.py),改写其中的process_image()和process_depth_image()函数即可。在订阅主题的同时,这个节点也会发布信息到/roi(关注域,region of interest)主题下。

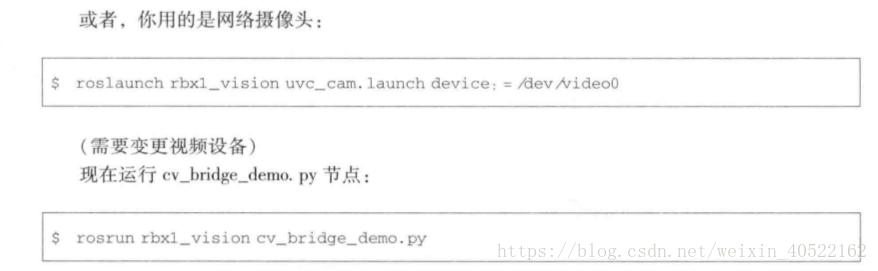

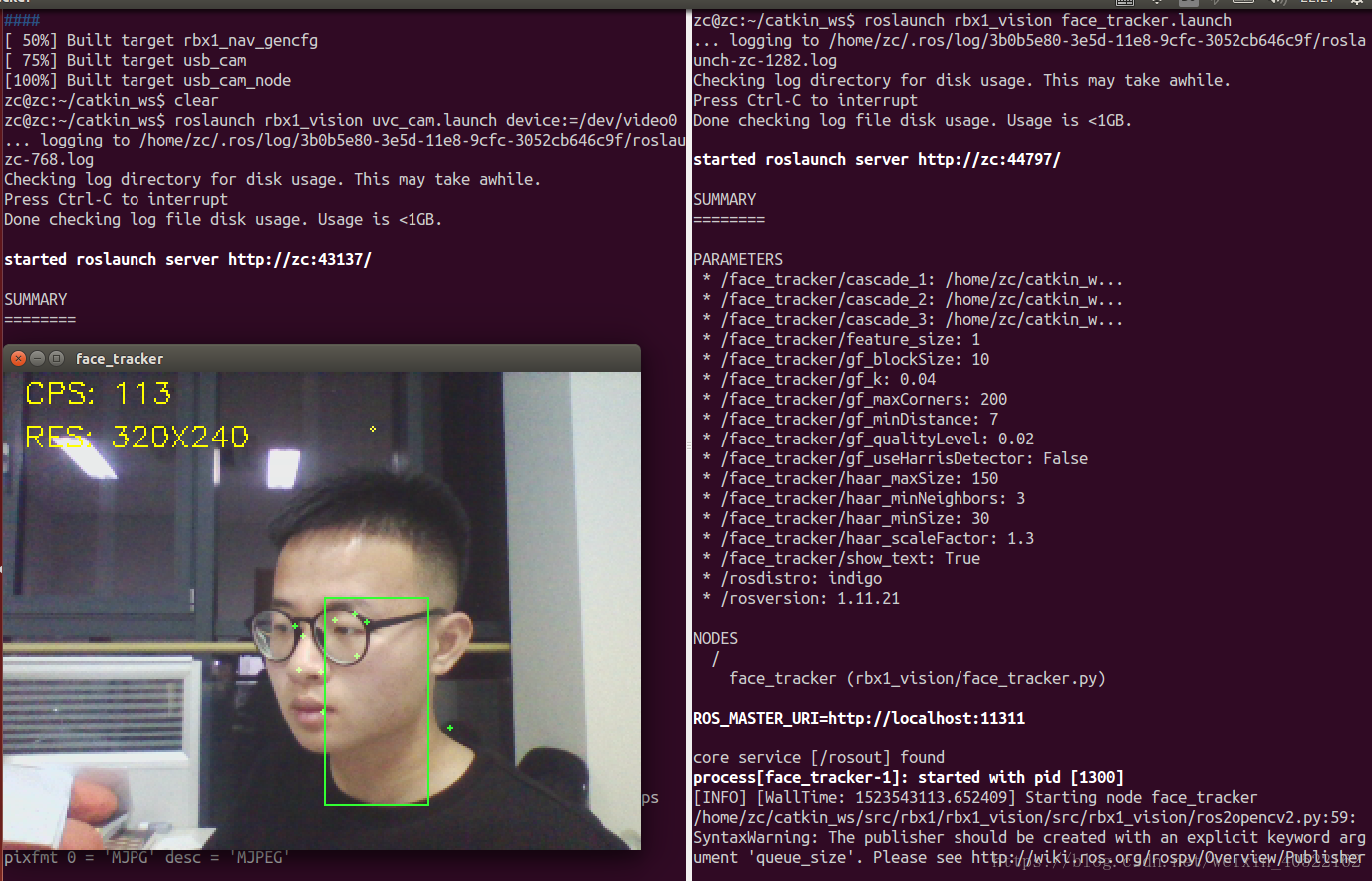

如图所示

测试2

图像流水线如下:

detect_face() → get_keypoints() → track_keypoints()

节点流水线如下:

face_detector.py() → good_features.py() → lk_tracker.py()

我们的节点face_tracker.py实现了以上过程。

同理先运行摄像头节点(测试1有,不赘述)

第二运行下面的launch文件

roslaunch rbx1_vision face_tracker.launch在视频窗口的最前端,在键盘上输入‘c’键。清除当前的关键点,强制重新检测检测面部。

移动后的追踪

好了,先到这里吧

2966

2966

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?